互联网未来方向:数据驱动产品运营创新

10月27、28日,由人人都是产品经理重磅打造的「2018中国运营增长大会 · 北京站」完美落幕。来自吆喝科技联合创始人&COO 张毅飞老师,他带来的分享是《数据驱动产品运营创新》的精彩内容,本文为现场总结。

分享嘉宾:吆喝科技联合创始人&COO @张毅飞老师

本文为现场分享总结整理内容,由人人都是产品经理媒体部@Hatter 整理,编辑有修改,以下为正文:

一、数据的价值:A/B测试验证

1. 数据带来的价值

贝利波斯沃斯说:

从现在开始的十年以内,当我们回顾大数据的时代是如何发展的时候,我们会震惊于以往做出决策时候信息的匮乏。

从两个层面来解读这句话:

第一,数据爆炸。实际上从2000年人类正式进入互联网时代以后,每一年产生的数据都是以前所有年份产生数据的总和,这是个数据爆炸的时代。

第二,无数据不决策。数据正在改变众多的行业。

1682年,一位天文学家观测到了一颗巨大的彗星。根据历史数据记载,在1531和1607年这棵树都有过类似的天文的现象。于是他分析数据做数据挖掘,发现并预言76年以后,这颗彗星还会出现。

这颗彗星就是哈雷彗星,一个用数据发现的特别的天体。

另一个行业是医疗产业——医疗产业最早使用临床AB测试来判定新药药效,而科学性是现代医学的基础(现代的医学,科学性和数据是基础,所以临床三期药检都是依靠A/B测试来验证和实现的)。

将100位患者分为A组B组(注意患者自己并不知道自己被分组),A组患者将会得到试验新药,B组患者将会得到长的和新药几乎一模一样的安慰剂,试验结果以患者康复状况的数据为形式和目标。通过对比试验的结论来看这个药品是不是真的能够帮助患者,是不是真的能对症状有效果;以决策数据的决定来看这个药品是不是真的能够上市,是不是真的能够通过药检。

所以现代医学的发展是绝对离不开数据,也绝对离不开AB测试。

2. 互联网流量发展趋势

数据是怎么样改变互联网行业的?

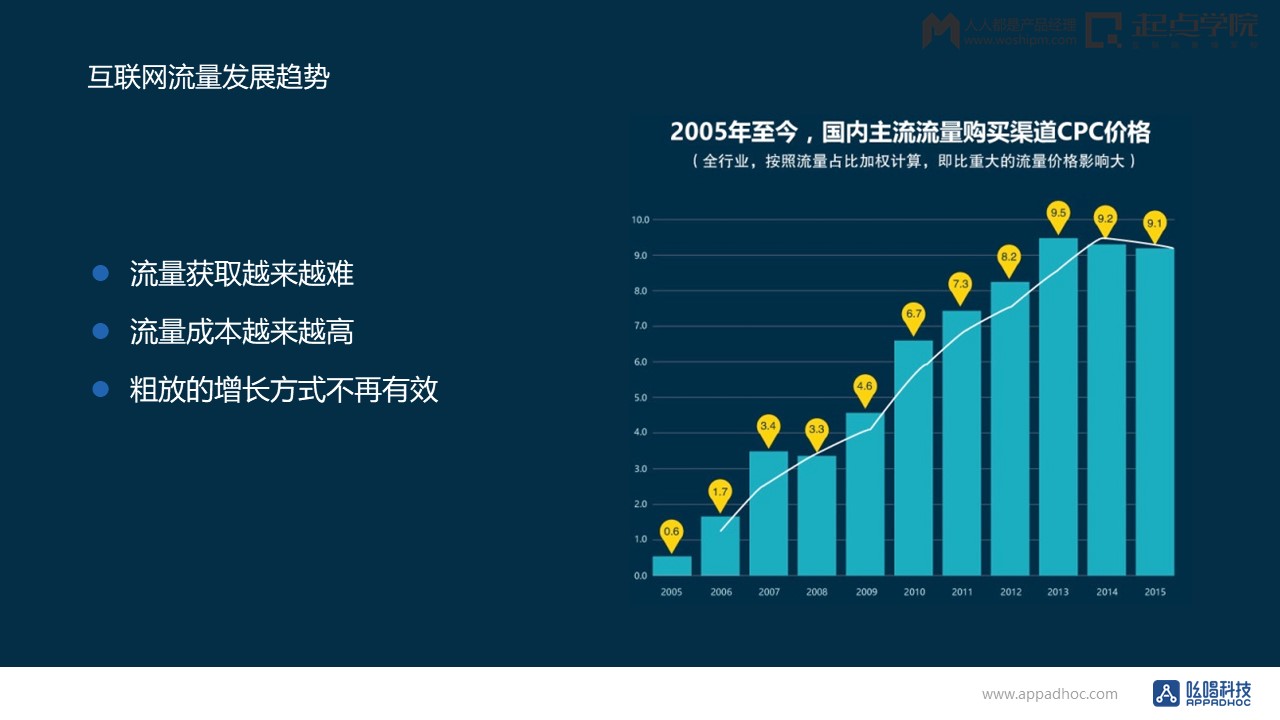

图一

2005至2015年这十年,流量成本变化的曲线涨幅跟房价差不多一致的:流量的获取越来越难,流量的成本也越来越高,而且这个趋势不可逆。

这还不是最痛苦的,最痛苦的是应用和分发的趋势。

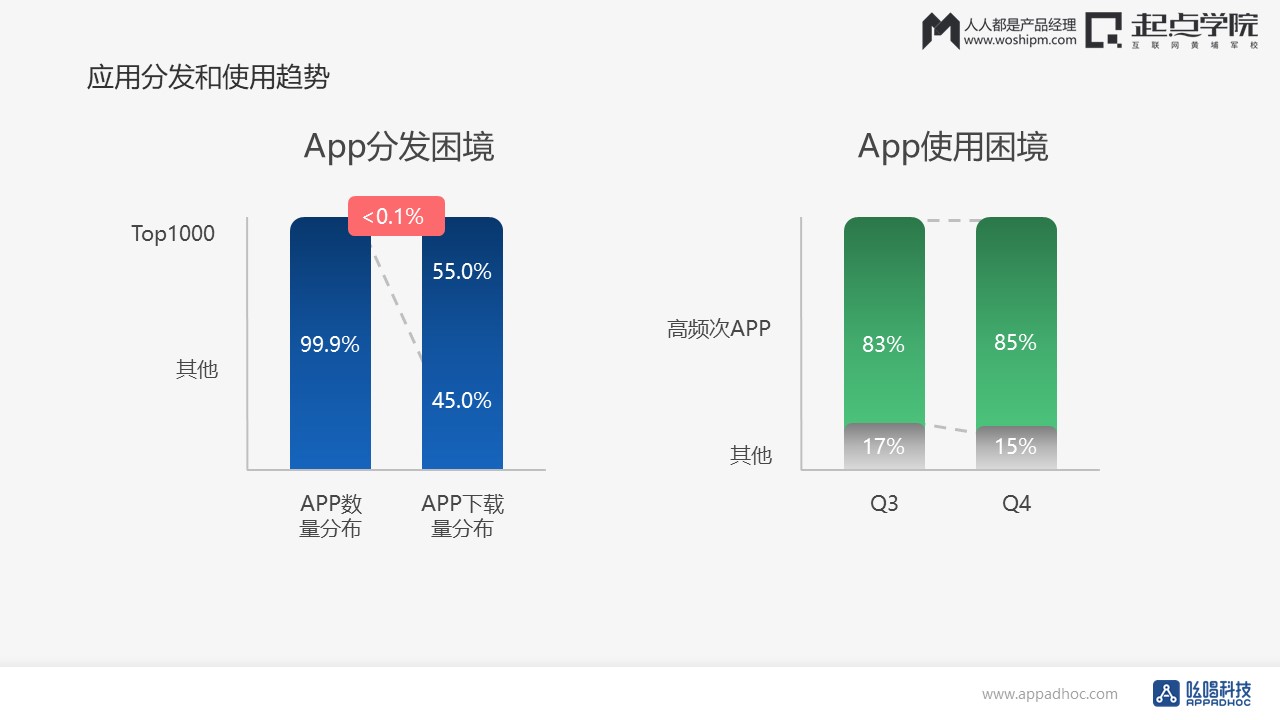

现在在M studio大概有超过100万款的应用,其中 Top 1000 只占大概0.1%,但已经占所有APP下载量的55%,其余的99.9%的应用,占剩下的45%。

——运营和产品也越来越难了,因为巨量的APP的时间黑洞,这个效应越来越强。

图二是16年的数据。一些高频次的巨型APP,比如微信、抖音、今日头条,它们大概占据了用户使用时长的80%以上,而且没有缓解的迹象。

图二

二、产品运营的方向:向数据驱动创新转型

当互联网红利消失以后,这个趋势是不可逆转的;也就是说我们从市场需求驱动,一定要向数据驱动创新转型。

1. A/B测试的驱动创新

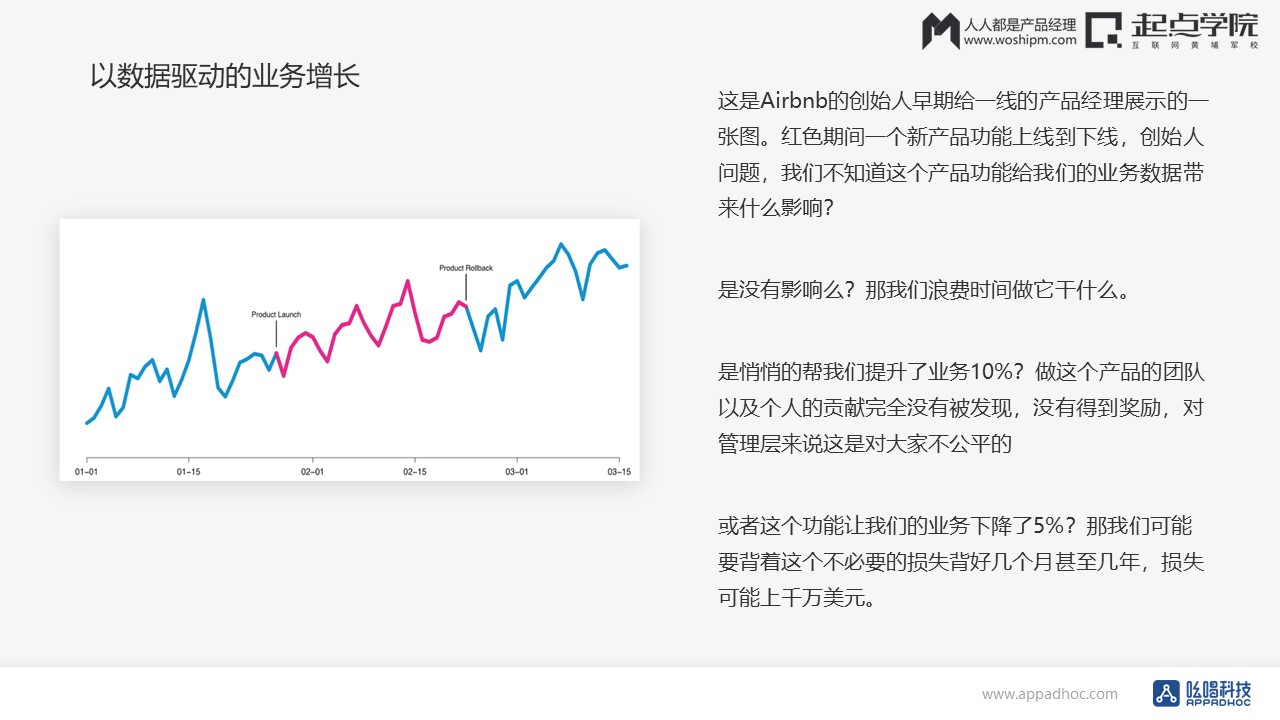

图三

图三是Airbnb的创始人早期给一线产品经理展示的一张图。红色的区域Airbnb是上线了一个新的产品功能后核心数据的变化。

当新功能上线,产品迭代做完之后,产品的数据是波动的,再加上运营活动的影响,上线的新功能是不是真的有效很难衡量。

Airbnb也有同样的问题,所以创始人问了产品团队三个问题:

第一个问题,这个功能是不是真的有用?如果没用,对于我们的核心数据没有正向的影响,我们浪费时间做它干什么?

第二个问题,如果功能上线之后帮我们增加了营收,提升了订房率和GMV,那么我们核心的产品团队是不是因此应该受到奖励?

第三个问题,如果新的功能上线之后,反倒让我们的订单下降了,我们难道要背着损失几千万美元的风险吗?

这三个问题怎么来解决的?通过A/B测试不断迭代优化来解决。

重要页面的修改和流程上的调优,通过灰度发布到1%或者5%的用户,看其实际对用户的数据造成了什么样的影响:是访问时间增加,还是留存提高?下单率提升还是降低?以此来决定新功能是被废弃或者是做修改——是要放给百分之百的用户,还是被回滚?

图四

图四中第一个界面就是其中一个例子。

所有的产品在下载之后的激活和注册界面流失率是最高的,一般来讲都会在50%以上——当然也有可能更高。当有加亮的时候,界面的优化非常重要,可以有效降低我们的C端用户获取成本。

第一个和第二个界面是拿第三方登录Facebook和Google账号来调整登录顺序,看转化率是否有提升。第三张图是他们在西班牙地区做了这样一个尝试:先展示用户房源,之后看是不是会提升用户注册率。比如说类似这样的测试项,“重视房间的照片”、“周末推荐的房间”等产品功能,都是通过这样的试验发现成功创新。

这是通过AB测试,由数据来驱动的产品运营的创新。

A/B测试本质上是个分离式组间试验,属于预测型结论,与“后验”的归纳性结论差别巨大。目的在于通过科学的试验设计、采样样本代表性、流量分割与小流量测试等方式来获得具有代表性的试验结论,并确信该结论在推广到全部流量可信。

——最后一句话最重要,就是必须确信这个结论,确信全部流量是可信的。

假如说Airbnb的实验的流量是5%,怎么知道5%的流量得到的实验结论在100%的时候依然是有效的?

利用以下三种方法:

- 第一种方法,比如说,这个星期上线一个版本的产品,下个星期上线另外一个产品或者说不上废弃,看一下这个星期和下个星期的数据的变化,由此来决定这个产品功能是不是真的有效?

- 第二个方法,比如说通过这样一个测试,投放上一个安卓的小渠道,然后看一下小渠道的数据转化是不是达到要求?

- 第三个方法就是开发能力比较强之后,比如说把用户分组打标签,0123456,把零的用户分一组,一的用户分一组,二的用户分一组,看一下数据的变化比较大小,看看哪一个用户组表现得更好从而得出决定。

这些方法都是按照AB测试的定义来看,都是伪AB测试,为什么?因为它的采样既不具有代表性,实验设计也不科学,流量分割和小流量的测试都不对。

这个结论推广到全部用户,有可能获得的结果是完全颠倒的。

2. 为什么A/B测试可以驱动创新?

- 小流量测试新版本,极大降低试错风险,降低迭代成本;

- 多方案同时在线试验,最快找出最好方案;

- 从试验中获得最优产品经验,极大促进产品升级。

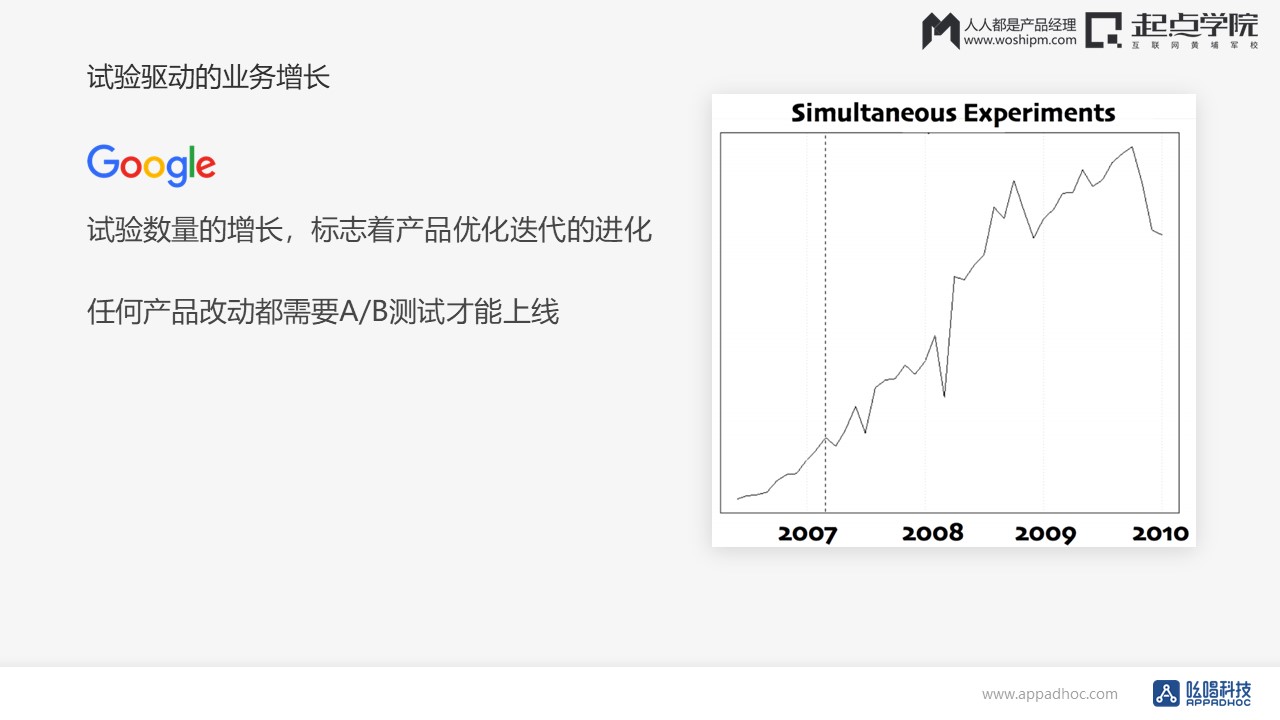

再来看一个海外的例子:Google。

Google是互联网企业中第一个把AB测试应用在实际的产品优化迭代中的,起源于2000年他们做过的一个项目。

那时Google团队内部有个争议:搜索结果首页应该展示几个结果?5个,10个,15个,还是20个?这样的单变量多版本实验最后失败了,原因是实验的数据不科学,没法说服决策人……

这个结论没有办法得到,也没办法上线。

Google因此花了很多年的时间,成立了专门的团队打磨自己的试验系统,优化了自己的产品迭代优化流程,就有了下面这样一个案例——“图片广告”试验项目。

Sales和PM发现Pinterest的图片广告特别受欢迎( Pinterest 是一个图片社交的一个软件),于是他们提出假设:“推出图片广告产品,会增加广告主投放预算,提升广告点击率和总营收”。如果搜索结果是图片广告,是不是可以增加广告主的投放?从而是不是可以提升广告点击率和总营收?

图五

经过一个季度的研发,试验版本上线,推销给部分广告主,最多触达10%的搜索流量。结果试验结果显示:广告营收会下降0.X%(“误差”0.0Y%)。最后上层开会决定,这个项目必须下线。

所以现在Google任何产品的改动都是要经过A/B测试才能上线——无数据,不决策。

图六

图六是2007年到2010年Google试验数量的增长曲线,与流量成本的增长曲线是一样的,这标志着Google产品优化迭代的进化。

3. 产品运营AARRR模型

- 获取用户(Acquisition):曝光数、点击数、打开率、下载量、安装量、用户获取成本;

- 活跃度(Activation):设备激活量、新注册用户数、订阅数、浏览数、日活跃数;

- 留存率(Retention):次日留存率、7日留存率、DAU / MAU;

- 收入(Revenue):付费率、付费频次、客单价、用户价值;

- 自传播(Referral):转发数、邀请数。

可以说是全部产品运营的工作,几乎都是在不断优化AARRR模型的细节。

- 拉新: 优化渠道、广告、内容、电子邮件;

- 激活: 优化第一次转化;

- 留存: 优化第二次、第三次、第四次……转化;

- 变现: 优化付费、下单、结账等一切关于钱的环节;

- 推荐: 优化现有客户如何向他的朋友来口碑推广你的产品。

从运营的角度出发,这也是先从理解用户本身,理解用户的心理,给用户做分级,然后最后提出运营设计的建议。

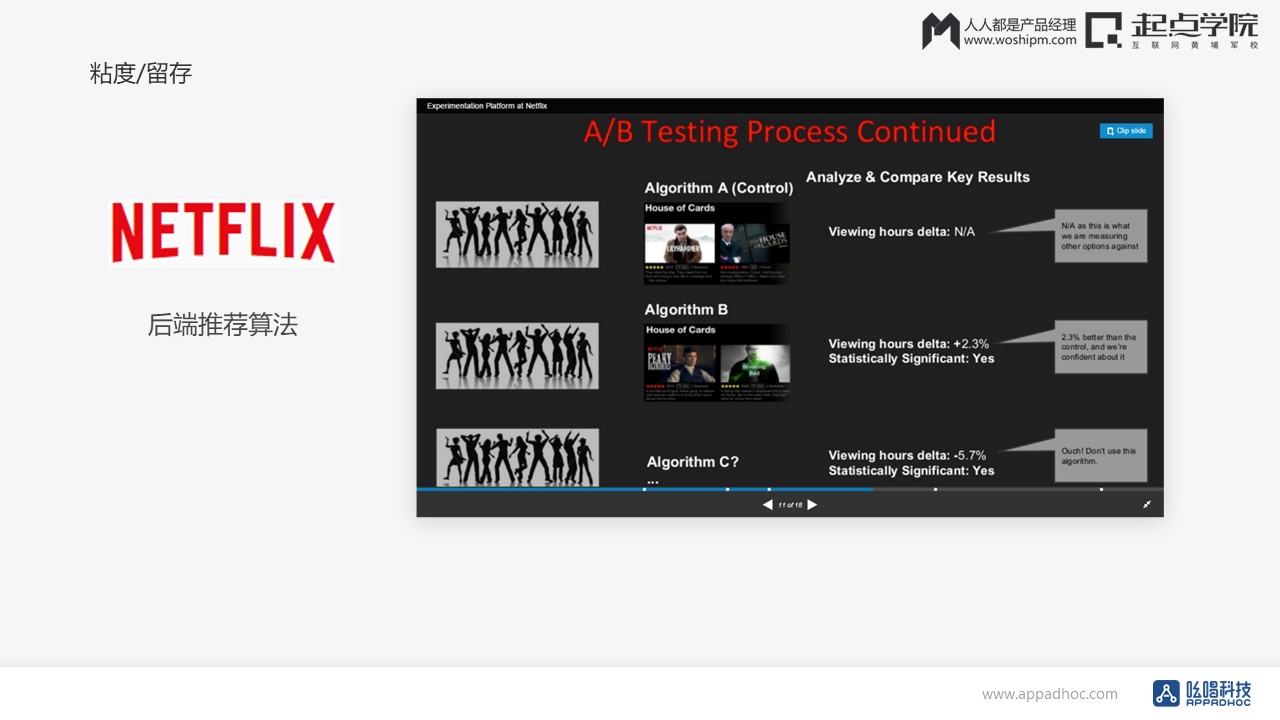

图九

图九是NETFLIX的一个提升留存的例子。NETFLIX是一个美剧的网站,非常受欢迎的纸牌屋就是他们的作品。这样的视频网站有一个非常重要的指标——每一个用户单次的观看时长。所以后端推荐算法对他们非常重要:如果你每次给用户推荐他很感兴趣的视频或者是节目的话,每次单次的浏览时长肯定会变长。

他们做了很多推荐算法的实验,后来发现:方案推算法二是最好的,就是方案Plan B最好地提升了大约2%的浏览时长。

图十

图十是一个电商的例子。仅仅更换折扣与价格的展示方式,会不会带来更高的转化?什么样的折扣区间内更容易获得用户欢心?可能有些人对价格敏感,有些人对折扣率敏感。

右边界面是当地展示价格区间的时候,就是用户对价格区间的反应是怎么样的?是当你从900打折到400,还是从500打到400,相同的价格,怎么样才可以让用户买得更多?GMV更高?这些经常遇到的例子,都是通过数据来驱动优化的。

4. 以AB测试为基础的产品迭代流程

以AB测试为基础的产品优优化的迭代流程是这样的:

首先要进行用户行为分析,提出不同的假设;然后做计划排期去上线,运行试验;再进行研究调查,进行数据分析,最后再决定是上线或者是不上线——这样大家的工作才有意义,才能真正实现产品核心数据的增长。

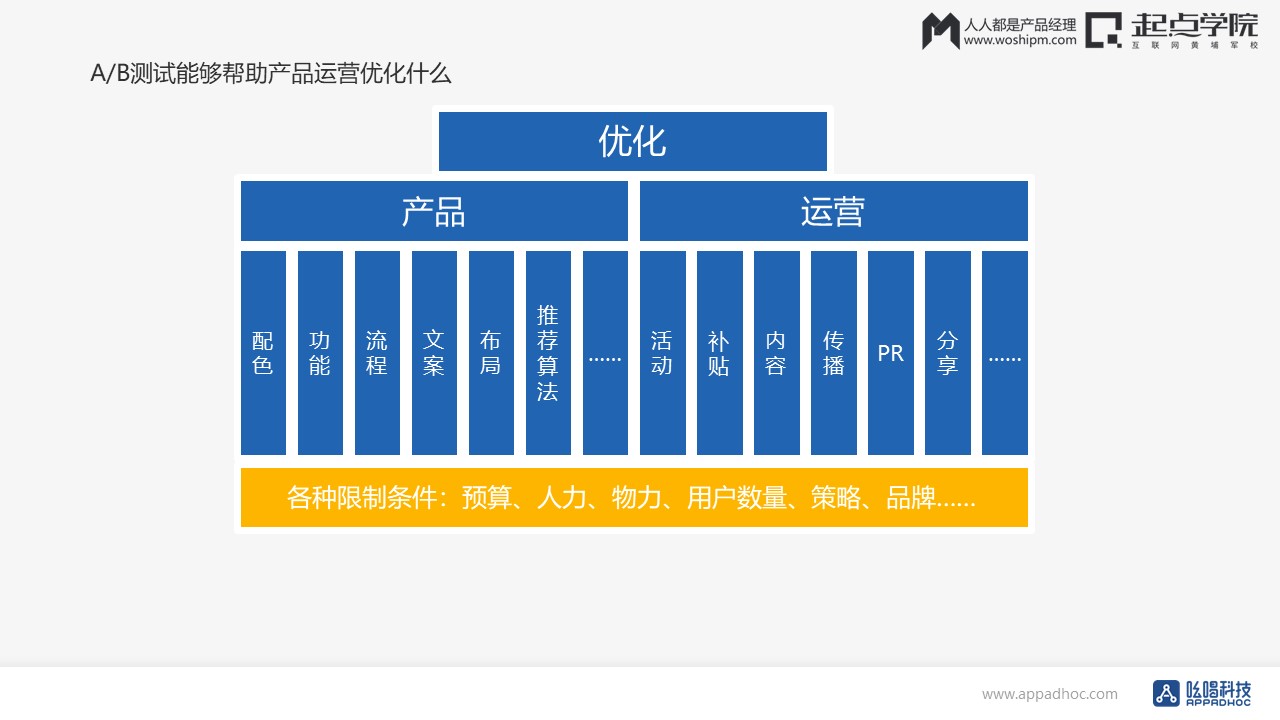

AB测试能够帮助产品优化什么呢?

以下这些UI功能的流程的文案的布局的推荐,算法的运用来讲,活动补贴的内容传播的PR的分享的Saas。几乎你能想到所有和数据和用户相关的地方,都可以通过X来优化。

图十一

5. 体现产品核心价值的数据指标

核心指标(Core Action)对于产品运营来说至关重要。它是你的产品提供给用户最本质和最为核心的操作,也是最能体现用户参与度的操作指标——Magic number,另外一个称呼叫北极星指标。

这个指标非常重要,因为它代表了产品迭代的方向。

可能有点抽象,举几个例子来说明:

- 对于Facebook来说这个数字是10:一周以内添加十个用户的人大概率成为活跃用户,把自己的社交关系链留在Facebook。

- 对Twitter来说这个数字是30:如果一个用户关注超过30个人,那么它就有很大的概率继续使用。

- 对于Slack来说这个数字是2000:如果一个用户通过Slack发送超过2000条消息,那么他就会养成使用习惯,从而持续使用下去。

- 知乎的核心指标是回答问题:如果一个用户回答三个以上的问题,他有大概率留下来成为活跃用户。

为什么这个指标特别重要?

因为根据核心指标确立了产品运营优化方向,产生各种各样的提升假设,持续进行A/B测试,从而才能提升指标,实现增长。

比如说当Facebook发现如果每个用户一周之内关注十个人,会让它的留存大幅提升,就做了一个功能people you may know——添加认识的人。通过上线这样一个功能从而提升核心的业务指标。

国内的一些相关产品抄袭过这个做法,但其实他们并不知道为什么要做这件事。

这里一个比较有趣的案例跟大家分享:

图十二

上图左边是Facebook最开始和现在的样子,右边这张图大概是在2013年至14年的时候,当时正在流行设计扁平化,所以Facebook内部有一个设计师主导的团队提出了这样一个想法:如果我们把Facebook的主页扁平化,有更多的图片大图,是不是可以提升我们核心业务指标?是不是能够提升用户留存?像Google一样提升广告的产品转化,营收增长?

然后Facebook在一个VP的带领下,建立了50人的team花了大概六个月的时间做了右边这个版本。最开始上线右边这个版本用了60%流量,结果发现所有的业务指标都在降,核心指标也在降。

他们觉得这可能是因为首因效应:

首因效应指的是当用户习惯一个操作界面的时候,突然把界面做了大幅的修改后改变了用户原有的操作习惯,这个时候反映出来产品的数据和实际用户习惯之后的产品数据是不一样的。

为了避免首因效应,Facebook做了这样一件事情:他们增加了流量,把流量调到12%,同时增加了测试时长,原来测两个月,现在测四个月。但结果他们发现业务指标还在降,于是又将流量调到24%,发现还在降……没办法,测试历经十个月,核心指标持续在下降,产品只好下线,最终这个团队被裁,VP离职。

这款产品的产品经理不知道是幸运还是不幸,刚好成为了24%流量其中的一员。

总结下来:做产品、做运营,如果没有数据,不用数据做决策,就像蒙着眼睛射箭,做了很久也不知道自己做的是对还是不对。

为什么呢?

因为一个用户群体的喜好,只能通过数据来衡量,没有产品经理能够做到可以衡量一个群体的喜好,特别是在数据爆炸的今天。如果不用数据做决策,就会产生像上一个例子一样的结果。

所以对于新时代的产品经理运营人员来说,数据是基本功,并且只会越来越重要。

《硅谷增长黑客》作者Sean Ellis(CEO and founder ,GrowthHacker.com)说过这样一句话:

“If you’re not running experiments, you’re probably not growing.”如果你不做任何的实验,你无法知道自己是不是在增长。

以下是来自硅谷的8条高效产品运营增长策略:

- 在没有达到 Product/Market Fit 前,不要贸然开始增长;

- 想搞大事情,但从小处开始;

- 如果你不做A/B测试,那就输定了;

- 用80%的时间对有效果的事加倍投入,用20%测试新方法;

- 以数据为驱动,而不仅仅是数据信息;

- 建立一个试验文化;

- 如果数据是增长的燃料,那么试验就是它的引擎;

- 你的第一个“hack”是你的产品,做出人们想要的东西。

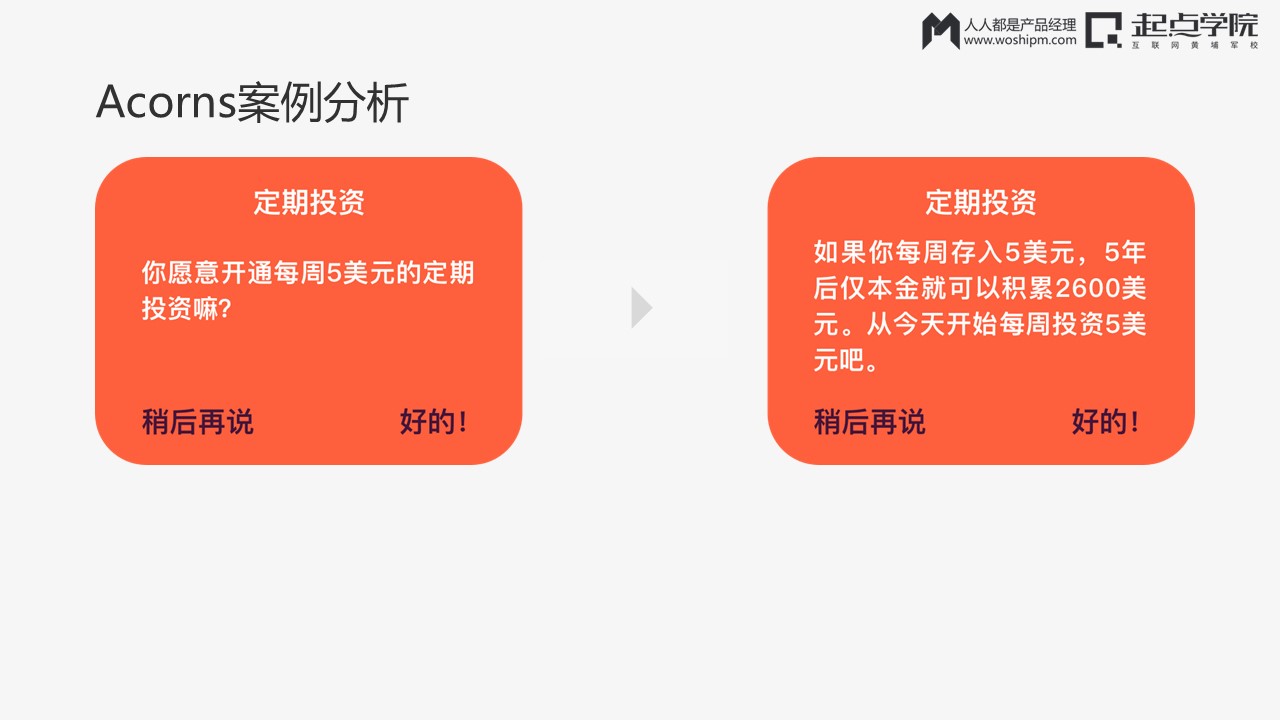

一个具体的互联网金融项目案例:Acorns案例分析

Acorns设定了一个目标——提升用户的留存。他们发现用户如果使用了定期投资功能,新用户开通定投比例会提升50%。因此他们产生了一些想法,比如说增加一个“定期投资”的确认框,如果有这个框了之后,用户回收到提醒,从而提升转化率变。

图十四

如上图,Acorns做了子设计,左边一个,右边一个。

最后得出的结论是:右边比左边提升转化率高58%,他们成功地达到自己之前设计的目标。

Acorns发现这个方法非常有用之后,做了第二个实验:

图十五

把定期投资对话框往前提到了首页,然后发现这样非常有效——转化率又提升了一倍。只花了一个月的时间做实验,耗费了工程师和产品人员差不多十个小时,结果“新用户的定投投资率”达到了原来的数倍之多。

小事情大成果,这是大家最愿意见到的情况;所以改版并不能解决问题,应该从数据和结论中找到答案。

通过这次试验,Acorns公司发现:把极少成多的结果展示给用户,能够说服他们开始定期投资。不光产品团队发现了这件事情,他们运营团队付费增长团队也发现了这件事情,对用户的理解提升了一个层次,依此发现Acorns去更改了自己应用商店的文案。改变用户来源就是Facebook的用户着陆页,同时增加了一个功能增长——定投的增长计算器,帮助用户计算投资回报,从而影响用户的实际的留存和转化。

新的机会是这么来的,通过不停的数据挖掘实验,更加理解用户的想法。

以上为本次大会分享内容。

相关阅读

小程序、内容、流量、商业模型……这场2天16小时的盛会,告诉我们什么是未来|「2018中国运营增长大会 · 北京站」现场报道

网易新闻运营总监韩叙:做用户增长时,如何做好新增用户的留存(附完整版PPT)

《引爆社群》作者唐兴通:这么多内容营销,为什么杜蕾斯只有一个?

见实科技CEO徐志斌:拆解小程序,你能从中看到多少与增长有关的东西?

本文为现场分享总结整理内容,由人人都是产品经理媒体部@Hatter 整理,编辑有修改

未经本站许可,禁止转载,谢谢合作

起点课堂会员权益

起点课堂会员权益

大哥,AB测试就AB测试,谈什么数据驱动啊,还举一堆别人的例子和理论组合,通篇废话,把我们骗进来不浪费时间的啊!