A/B 测试中 12 个常见的误区(上)

文章为大家梳理一些运用A/B 测试时12个常见的误区,本文为上篇,一起看看~

A/B 测试是一项很有趣的测试内容,使用者可以通过优质的工具去完成产品中的 A/B 测试。但其实,A/B 测试并不仅仅是建立一个测试,很多公司在使用 A/B 测试时都存在一定的误区,都在不经意间浪费着时间和金钱且不自知。

下面,本文将为大家梳理一些运用A/B 测试时常见的误区:

一、太早停止A/B 测试

如果样本量足够大,统计显著性是版本 A 优于版本 B 的最好证据,50% 的统计显著性代表一种随机的结果。如果你只要求有 50% 的统计显著性,那么你可能要考虑离职了,因为其实这个数字达到 75% 也不能说明什么。

任何一个经验丰富的测试人员都有过这样的经历,你通过 A/B 测试去检测你的产品功能,最终将一个置信度达到 80% 的产品推向各大市场,但最终发现,市场却并不买账。于是你想,那下次把数字达到90% 怎么样?这样就会很好了吧?其实比达到 90% 更重要的是,你要找到其中的真相。

真相>胜利

作为一个专业的职场人士,你的工作就是找出真相。你必须先把自我放在一边,执着于你的假设或设计是人之常情,如果当你的假设没有出现显著的差异性时,这可能会对你造成很严重的打击。真理高于一切,否则一切都失去了意义。

这里有一个常见的场景,即使对于经常进行 A/B 测试的公司也是如此,公司进行一个又一个的测试,持续了 12 个月,好不容易挑选出“获胜者”,然后将它们推出市场。结果一年后发现,他们网站的转化率和刚开始时一样……

为什么?基本是因为测试停止得太早或样本量太小。这里有一个关于何时停止 A/B 测试解释,简而言之需要满足这三个条件,才能说明测试已经完成:

- 足够的样本大小。实验要有足够的被试参与,你需要为你的 A/B 测试预先估算出足够的样本量。

- 要运行多个销售周期(通常为 2-4 周)。如果你只是在几天内就停止测试(或者在达到所需的样本量之后就停止),那么你获得的这个样本结果,并不具有代表性。

- 统计学的显著性至少要达到 95%(p≤0.05)。值得注意的是,p 值没有办法告诉我们 B 比 A 的方案好。

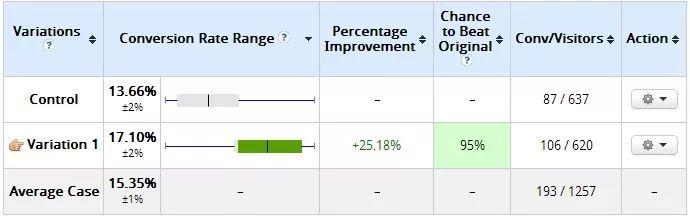

这里有一个经典的例子来说明我的观点,下表为开始测试两天后的结果:

图 1. 图片来源于网络

我构建的新版本损失惨重,我构建的版本并没有太大的优势,而我的客户也已经开始准备停用这个方案。但是,由于样本量太小(每次变化只有 100 多次访问),通过我的坚持不懈,这是 10 天后的结果:

图 2. 图片来源于网络

你没看错,我制造的版本现在以 95% 的置信率获胜。

有些A / B测试结束得过早,这就需要我们仔细检查各种数据。而最糟糕的事情就是,因为不准确的数据,让你损失了大量的时间与金钱。

需要多大的样本量?

通过上面的介绍,我们都不希望根据较小的样本量得出结论。理想的状态下,一个好的测试版本最好能发生至少 350-400 次转换数据。但是,这个数字不是定值。我们不要被一个号码困住,因为我们手中的是科学,而不是魔术。

所以,你一定要提前估算出测试所需要的样本量。那么即使这样做了,但置信度还是低于 95% 怎么办?那么可以从细分领域下手,但你仍需要为每个测试的细节提供足够的样本量。无论如何,你都需要不断修改你的假设并进行新的测试。

二、测试的单位不是“周”

假设你有一个高流量网站,你在三天内实现了 98% 的置信度,并且每次都发生了至少 350 次的转换数据。

这样能算完成了测试吗?不,我们需要排除周期性因素并测试整整一周。如果你从上周一开始测试,那么这个测试需要在下周一停止。

为什么?因为你的转化率可能会因“今天是星期几”而有很大差异。如果你一次不测试整整一周,那么你的结果就会出现偏差。所以,你需要以“周”为单位,在你的网站上运行“每日转化次数”的报告,观察到底能产生多少波动。

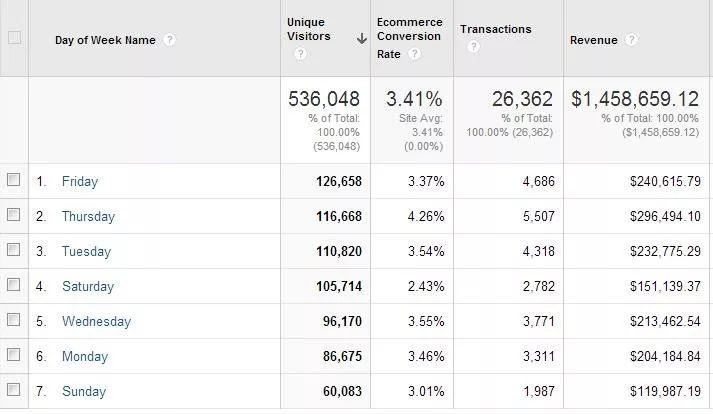

下面是一个例子:

图 3. 图片来源于网络

你看到上表中的内容了吗?

星期四的收入比星期六和星期日的总和还多出 2 倍,星期四的转换率几乎是星期六的 2 倍。如果我们没有以“周”为单位进行测试,那么结果将是不准确的,所以,必须开始一次运行七天的测试。如果在这七天内没有出现差异显著的结果,则再运行七天。如果 14 天都没有达到,那么就运行到第 21 天。

多数情况下,你需要至少运行两周的测试(我的个人最低时间是四周,因为两周通常是不准确的),然后,如果你需要延长测试时间,则应用七天规则逐步叠加。

注意外部因素

如果你在双十一等一些购物季获得了良好的测试结果,那么你一定要在购物季结束后再次进行重复的测试。另外,如果你的公司铺设了一些电视广告或者其他大型活动,都可能会影响你的测试结果。你必须要了解你的公司正在做什么,因为外部因素会影响到你的测试结果。

三、没有足够的流量也进行 A/B 测试

如果你每月只能完成一次或两次销售,然后进行测试,结果显示 B 方案比 A 方案的转化率高 15%,这样的结果准确吗?

当然不。许多人都喜欢用 A / B 测试来验证假设,但流量较小的情况下,即使版本 B 的效果再好,也可能需要数月才能达到统计显著性。

不基于假设就进行测试

我喜欢意大利面,但我对意大利面条柔韧度的测试却没多大兴趣,比如将它扔在墙上,看它是否粘住墙壁?

这其实是一种随意的测试想法,而测试这种随机想法需要付出巨大代价,它会浪费你宝贵的时间和流量,所以永远不要那样做。你需要有一个假设。假设的提出要根据有限的证据,这个证据可以通过实验去被证明,并且作为一个新的研究起点。

如果你在没有明确假设的情况下进行 A/B 测试,然后发现 B 方案的转化率高了 15%,可是你从中学到了什么?

什么没有。我们需要了解我们的受众,获得合理的假设,这将有助于我们更好地改进贴合实际的测试。

四、不利用大数据分析平台

测试的平均值往往包含着谎言。如果 A 方案比 B 方案的转化率高出 10%,但也并不能代表全部。你需要将其中的指标再次进行分割测试,去分析其中的各项细分指标。你可以使用一些优质的大数据分析工具,利用各种分析模型,对数据进行细致地分析和处理。

图 4. 图片来源于神策数据

五、为了不值得的问题进行测试

你测试过用户喜欢什么颜色,对吗?

请赶快停止吧。世界上哪里有最好的颜色,因为颜色始终与视觉层次结构有关。当然,你可以在网上找到有人通过测试颜色从而获得收益,但这些结果很多都是显而易见的,所以,不要把时间浪费在这些测试上。

余下的 6 个误区,未完待续,欢迎大家持续关注。

原文来源:https://conversionxl.com

原文作者:Peep Laja

翻译:研如玉,神策数据·用户行为洞察研究院 公众号(ID:SDResearch)

本文由 @研如玉 翻译发布于人人都是产品经理,未经许可,禁止转载

题图来自Unsplash,基于CC0协议

起点课堂会员权益

起点课堂会员权益

测试用例

前文描述的说会收到星期几的因素所影响数据,其实是不正确的,因为既然是做AB Test,他的对比因素是相同的

也就是说,实验组和对照组都是星期一 或 星期六等,判断一个AB平台是否准确,具有可参考意义,要看样本的分流是否平均

还要根据样本数,设定置信区间,当样本数小的情况下,数据波动的范围会较大,但如果是非常大的样本数,比如100万对比100万的数据,即使是1-2天,0.1%的数据也是显著置信的~

嗯嗯 是把可能出现的误区都提出来了呢 ~