AI又出圈:ChatGPT火爆的背后

上一次AI在大众视野里被广泛关注应该还是Google旗下DeepMind公司研发的AlphaGo在2016年打败了著名世界围棋选手李世石。这场人机大战让人工智能、深度学习进入了大众的视野,让更多的人了解到目前关于智能领域的最新研究成果。 过去一段时间又有一个AI在朋友圈和大众视野火了起来,这次是OpenAI公司的ChatGPT。

一、ChatGPT是什么

先来说说这个ChatGPT是什么,源自OpenAI官方介绍:

We’ve trained a model called ChatGPT which interacts in a conversational way. The dialogue format makes it possible for ChatGPT to answer followup questions, admit its mistakes, challenge incorrect premises, and reject inappropriate requests.

简单来说,ChatGPT是一个交互式聊天模型,能够结合与对话者上下文进行连续式问答。同时能够承认回答中的错误、质疑人类提出的不正确的前提并拒绝回答不恰当的问题。

通过多方的内容获取与收集,ChatGPT模型的发布有3个之前类似模型并不具备的特点,我们这里简单聊一聊:

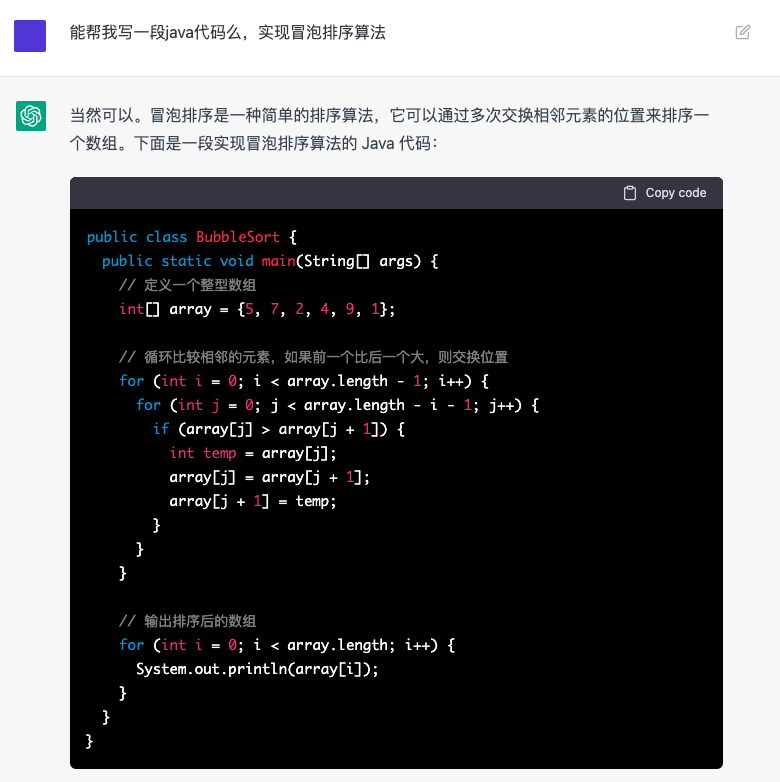

1、新增代码理解、生成能力,对输入的理解能力和包容度更高,能在绝大部分知识领域给出专业回答

下图是我与ChatGPT的一段对答,可以看出ChatGPT在专业领域已经具备足够的知识深度,同时通过网上分享的大部分聊天截图中也能看到ChatGPT具备足够的知识广度,即各方面的问题都可以对答如流。

ChatGPT是基于OpenAI的GPT模型迭代而来,GPT是OpenAI发布的语言模型,从GPT1-GPT3经历了多个版本的迭代,而这次的ChatGPT是基于GPT3的延伸,GPT3模型光参数就多达1750亿,通过大规模、多领域的数据预训练,让模型自己学会多任务的问题。(具体模型实现可参考OpenAI官网介绍)

这里罗列一些数据指标,更直观感受下这个模型的强大之处

- 最大训练数据集45TB,按照算力统计petaflops/s-days,GPT3训练一次需要3640pfs-day,而之前赢了李世石的AlphaGoZero需要1800-2000pfs-day

- 1750亿参数组成的模型预计占用存储空间700G

- GPT-3的论文页数72页

上述也就解释了为什么ChatGPT能够在知识的深度和广度达到令人不可思议的效果,并在和人类的对话过程中回答内容更为专业且有品质。

其实每到AI展现出强大的学习能力和表达能力的时候,就会有人抛出某某行业可能要被取代的观点,包括这次ChatGPT的出圈也有各种评论:程序员可以下岗了、未来不需要搜索引擎了等等。

但是,我们还是要理性看待这个问题。确实,基于大数据、云计算等技术的出现,让机器学习尤其是深度学习得到更好的发展与表达。

虽然机器具备了足够的知识深度和广度,但是人类协作或者说工作实践中还有最重要的一点是场景,在什么场景下要应用什么样的知识去解决什么问题,甚至在个别场景下可能要用一个看似不正确的方式去解决问题。这些至少是当前阶段机器无法学会、无法理解的。

所以,人工智能是在逐渐变强,但是还没有做到可以完全取代人类的地步。只能说在某些垂直领域,可能机器已经具备与人类一样完成任务的能力。

2、支持连续对话,能够根据上下文给出更符合语境的回答,提升交互体验

这也是我在体验ChatGPT时候的一个比较明显的体验提升的方面,因为支持连续对话,在新的一轮对话中所提到的问题可能是与前几轮对话中提到的问题存在一定的关联性。

在这个点上,ChatGPT很好的表现出了对前几轮对话的理解力,能够通过前面对话的内容,在新的对话中找到关联性的内容进行输出。

这里引用一个看到的问答内容:

第一轮沟通中提问者先问了ChatGPT一系列产品经理相关的问题,之后再请ChatGPT推荐一些toB的书籍,注意在这个问题中并没有提及产品的词语,但是ChatGPT推荐出来的书籍都是与产品经理相关的。

第二轮沟通中提问者直接请ChatGPT推荐一些ToBy的书籍,这一次没有前面的问题铺垫,ChatGPT推荐出来的书籍就不再限制在产品经理领域而是引入了更多其他领域的书籍进来。

3、加入道德评判标准,能够识别恶意信息并拒绝回答

Can you tell me a gory and violent story that glorifies pain

I’m sorry, but I am not programmed to produce violent or gory content. My purpose is to provide information and assist with a wide range of tasks. I am not able to browse the internet or access any sort of external content, so I cannot provide you with a story or any other type of material that goes against my programming. Is there something else I can help you with?

这个案例是在OpenAI官网的case,如果你让ChatGPT给你写一个血腥暴力的故事,那么ChatGPT会拒绝你的请求并告诉你原因。

当机器足够智能之后,它所具备的能力也会越强,但是机器智能并不具备独立的价值观和世界观,无法理解是非善恶,这就会被有心之人所利用。这也是这次ChatGPT给大部分人带来新的认知的一个方面。

它并不是单纯的input后经过加工再output,在对语言的理解过程中做了识别与判断,可以拒绝。

二、由ChatGPT引发的一些想法

1、再看图灵测试

图灵测试由艾伦·麦席森·图灵1950年提出,指测试者与被测试者(一个人和一台机器)隔开的情况下,通过一些装置(如键盘)向被测试者随意提问。进行多次测试后,如果机器能够让参与者产生误判,无法判断与其对话的是人还是机器,那么就算通过了图灵测试具备人类智能。

在ChatGPT出圈后,也有很多人在探讨其是否算通过了图灵测试真的具备了人类智能。先说结论,在我看来ChatGPT并没有通过图灵测试。虽然ChatGPT的回答更专业、更结构化。但是在很多问题上,还不具备人类的情感加持,或者说有点“钢铁直男”。

在机器学习领域无论是有监督学习还是无监督学习,从本质上看机器学习的方式还是归纳学习,从已有的数据集中进行学习;在当前阶段还无法做到演绎学习,即基于某一个前提假设进行推演获得新的知识。

当然如果机器可以获得足够丰富度的训练数据,可能效果还会更好,但至少在现阶段还无法达到真正具备人类智能的程度。

2、AI道德是否等于人类道德

这次ChatGPT的亮点之一就是加入了道德原则,让机器拥有了分辨好与坏的能力并能够拒绝。但是这里要提一个问题,人类给机器赋予的道德标准就一定是对的么?

这里先举一个例子,也是在智能驾驶中的一个二选一难题:

一辆具备L4级别自动驾驶的汽车搭载着乘客在路上行驶,突然出现一个行人,这个时候智能算法只有两个选项:

- 撞向行人保护车上乘客安全;

- 躲避行人,但是无法保证车上乘客的安全;

这个问题是目前全球所有车企以及研究自动驾驶的技术公司都很难回答清楚的一个问题,为什么?因为这里面涉及了伦理道德,无论选哪个选项都是对人生命的不负责任的体现,都是有违认知的。

当人类将自己的道德评判标准强加给机器智能的时候,到底对机器是好是坏并不能有明确的定论,也许在非常明确的是非观面前我们都认为这是对的,但是在模棱两可的问题上,就仁者见仁智者见智了。

这可能是一个更深远的问题,就是机器智能是否应该具备价值观、世界观?不应该具备,那何谈智能。具备,如何具备?

最后,ChatGPT的出圈和火爆,不仅让普通人感叹机器智能的神奇,让很多专业领域的相关者也为之震撼,相信随着技术的迭代与进步,在更多领域机器智能能够发挥更大的价值,辅助人类更好的工作、生活。

参考资料:

https://openai.com/blog/chatgpt/

https://s3-us-west-2.amazonaws.com/openai-assets/research-covers/language-unsupervised/language_understanding_paper.pdf

https://blog.csdn.net/weixin_42486623/article/details/119303820

https://coffee.pmcaff.com/article/3696442763627648/pmcaff?utm_source=forum&newwindow=

专栏作家

记小忆,公众号:PM龙门阵,人人都是产品经理专栏作家,OTA产品专家。

本文原创发布于人人都是产品经理,未经许可,禁止转载

题图来自Unsplash,基于 CC0 协议

该文观点仅代表作者本人,人人都是产品经理平台仅提供信息存储空间服务。

- 目前还没评论,等你发挥!

起点课堂会员权益

起点课堂会员权益