接到“女儿”求救电话,亲妈差点被AI仿声骗了

AI技术的进步让我们看到了大量可能,比如用户可以利用AI绘画软件生成“以假乱真”的作品,比如网店商家可以用AI生成虚拟模特,减少人力成本的投入。但现在,AI技术却被部分“有心人”利用了,比如国外就出现了AI仿声欺诈事件。看来,AI行业在飞速前进的同时,也需要将反诈这件事提上日程了。

听到电话里女儿的求救声,慌乱的母亲差点给“绑匪”打钱,但绑匪是假的,女儿的声音也是克隆的。借助最新的AI技术,骗子只要拿到他人3秒的语音,就能快速复制出一模一样的声音,甚至方言和语气也能模仿。

当人们还在惊讶AI绘画以假乱真的能力时,AI仿声技术已经被骗子应用。在加拿大,仅3天就有至少8名受害者被骗约100万元,骗子模仿亲人的声音“救急”,就算亲妈也听不出纰漏。

有了AI,“抠脚大汉”能秒变诱惑女郎,陌生人能轻松冒充成你的亲友,打钱你就输了。

从区块链到AI,每次新技术一出,诈骗者最先冲锋时代前沿。面对以假乱真的诈骗手段,普通人越来越难以防范,那些打开潘多拉魔盒的科技巨头们,也不能光忙着蒙头狂奔,得用魔法打败魔法。

一、AI仿声诈骗案出现,加拿大8人被骗100

“妈妈!救我!”电话的另一头传来了女儿的哭喊声,母亲一下子慌了。还没等缓过神儿来,就听到一个陌生的男人在电话里吼道“把头往后仰,躺下”。紧接着,陌生男子发话,“你女儿在我这里,你敢打电话报警或通知任何人,我便会迷晕她,把她带到墨西哥。”

电话这头,焦急的母亲隐隐约约能听到女儿的呼救声,“妈妈,拜托救救我,救我”。此时,“绑匪”谈起了条件,需要100万美元才能放人,得到没有那么多钱的回应后,“绑匪”改口称,“拿5万美元来换你的女儿。”

上述情景是近期发生在美国亚利桑那州的真实一幕。据美国全国广播公司(NBC)报道,这是一起AI仿声诈骗案。电话那头的女孩声音,其实是AI克隆的,幸好这名母亲镇静下来,联系了丈夫确认女儿无恙,才免于被骗。

事后回忆起通话细节时,这名母亲感到阵阵后怕,虽然已经明确了这是一宗电信诈骗,但她依然对女儿的声音没有丝毫怀疑。

在人工智能提速科技变革时,不法分子正在将AI当成魔法,用最先进的技术手段实施诈骗。这种技术发达到什么程度?亚利桑那州立大学AI领域的教授坎巴姆帕蒂称,只需获得某人3秒钟的原声,就能迅速复制出完全相同的声音。

不少人已经被骗。4月2日,央视网发布视频报道,加拿大犯罪分子利用AI合成亲人声音实施诈骗,3天时间内至少有8人上当,涉案金额约100万元。这些受害者多为老年人,他们的反馈也是,“电话里的声音简直和亲人一模一样”。

甚至,以往被认为安全的“声纹”系统也能被轻易破解。今年3月,《卫报》澳大利亚版记者尼克·伊夫赛德说,他用人工智能做出自己的声音,成功进入了他的Centrelink自助服务账户。而就在两年前,澳大利亚服务局在一份报告中还声称“声纹与指纹一样安全”。

AI进化的速度实在太快了。早在2019年,《华尔街日报》曾报道过一名诈骗犯用AI语音合成来冒充老板,让一家分公司的总经理给他打了22万欧元。但在当时,诈骗者还得准备被模仿者的语料加以训练打磨。而现在,AIGC让克隆声音几乎没什么门槛,连方言和语气的模仿都不在话下。

目前,国内暂时还没有大规模出现AI仿声诈骗的案例,不过,用AI生成假图片来骗钱的事已经频频发生。

今年2月,一则“在苏州金鸡湖将举办游艇女仆party”的消息在网络流传,宣传文档里附有多张女仆装打扮的女性照片,发布者明码标价,参与Party每人要交3000元。明目张胆举办“擦边”派对,很快引来了网警,根据后续网警披露,那些女仆照片基本都是AI生成的。

类似的事件还有不少,网友们逐渐养成了“有图也不一定有真相”的防范意识。如今,哪怕有声音、有视频也不可信了。

二、防伪造技术跟不上AI“高仿”,反诈待升级

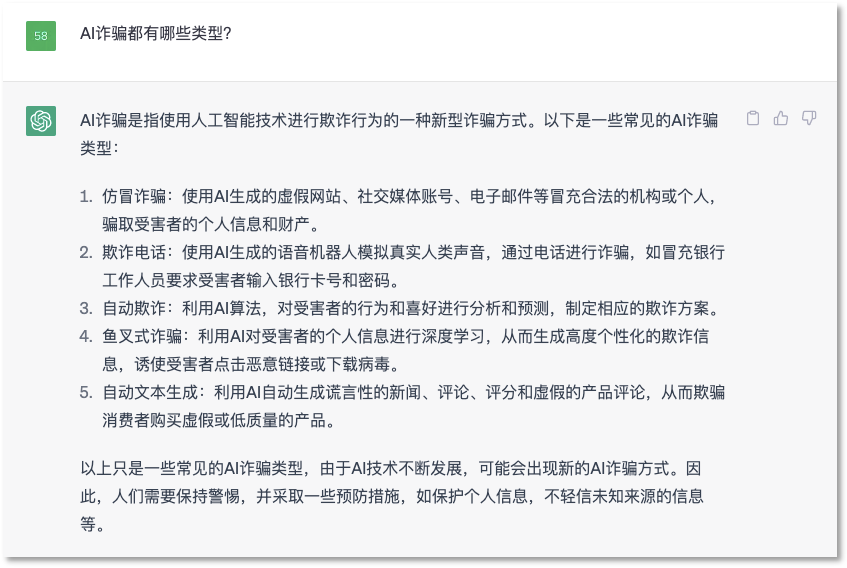

当询问ChatGPT“AI诈骗都有哪些类型”时,它给出了多项答案,包括用AI生成虚假网站和社媒账号,冒充合法机构和个人骗取信息和钱财;用AI生成仿真声音实施电诈;对受害者个人信息进行深度学习,生成个性化欺诈方案等等。

ChatGPT给出的AI诈骗类型

但ChatGPT还是低估了骗子的手段。对于精心设局的诈骗者来说,AI作为底层,甚至衍生出无穷无尽的诈骗方法。

在这方面,加入了AI技术的“杀猪盘”危害性不小。在各种交友和婚恋网站,充斥着许多“杀猪盘”骗局,不法分子伪造自己的身份和人设,接近受害者,在取得对方信任后骗取钱财。

以往,骗子会在网络上盗取照片伪装成自己,但只要有心人搜图对比也可能识破,但倘若骗子使用AI来绘图,这可就是“独一份”。不仅如此,通过AI作图,骗子甚至还能轻易根据受害者的要求比出相应的手势,更容易获取信任。

而在社交媒体上,“抠脚大汉”也更容易假扮成美女来骗钱了。一些AIGC应用能够生成诱惑、大尺度的照片和视频,来诱惑用户进行裸聊,或者让用户为更多私密照片付费。放在以前,这些视觉产品还需要花功夫制作,现在这些事直接交给AI,一旦有人踏进陷阱,就会被骗子拿捏。

更可怕的是,由于许多AI工具都已经开源,骗子实施诈骗的成本和门槛越来越低,直接在网络上就能得到教程,发布者的本意是供人们学习,但挡不住不法分子动歪心思。

随着AI的技术演进,人们所听所见将越来越不可信,想要避免被骗,不仅要了解诈骗手段,提升防范意识,同样也需要先进的技术,用魔法打败魔法。

面对深度伪造带来的危害,谷歌早在2019年就开始有意识地防御,先是招募了一群演员录制视频,然后利用网上的深度伪造技术进行换脸等操作,并对这些数据进行全面地分析,让开发者们研究深度伪造技术的算法和逻辑,在“知己知彼”的基础上,更准确地识别和防治深度伪造内容。

去年,微软推出了名为“Video Aunthenticator”的工具,它能够对画面中渲染边界和灰度等级进行逐帧的实时分析进而生成可靠指数,帮助用户鉴别内容真实性。

不久前,OpenAI也发布了AI生成内容识别器,但博客数据显示,检测成功率只有26%,对英文以外的语言,检测效果要差很多。相比ChatGPT的强大,这家AI公司在“打假”方面的研究还不够深入。

当AI技术呈现出硬币的两面,正邪的交锋就再也无法停止。发人深省的是,2018年,纽约州立大学曾开发出一款“反换脸”AI刑侦工具,通过预测眼睛是否眨动的状态来识别伪造人脸,准确率宣称能够达到99%,但这款工具很快就失效了,因为深度伪造技术进化了。

科技巨头们用技术打开了潘多拉的魔盒,世界也需要他们掌握锁住恶魔的锁链。AI诈骗流行的苗头隐隐出现,反诈技术也得跟上脚步。

作者:凯尔,编辑:文刀

来源公众号:元宇宙日爆(ID:yuanyuzhouribao),在这里,看见未来。

本文由人人都是产品经理合作媒体 @元宇宙日爆 授权发布,未经许可,禁止转载。

题图来自Unsplash,基于 CC0 协议

该文观点仅代表作者本人,人人都是产品经理平台仅提供信息存储空间服务。

起点课堂会员权益

起点课堂会员权益

产品经理的职业发展路径主要有四个方向:专业线、管理线、项目线和自主创业。管理线是指转向管理岗位,带一个团队..

产品经理的职业发展路径主要有四个方向:专业线、管理线、项目线和自主创业。管理线是指转向管理岗位,带一个团队..

猎罪图鉴里面有这个剧情