最新AI预判|新的语言模型技术栈全解

在这几个月内,ChatGPT借着大语言模型掀起了人工智能行业的新一轮浪潮,那么在未来,大语言模型及相关技术的发展又可能呈现哪些趋势?本文尝试进行了预判和解读,一起来看看,或许会对AI创业者们有所帮助。

今天看到红杉美国发表了一篇新文章:《The New Language Model Stack》,这篇文章内容是红杉美国在访谈了投资Portfolio里的33家小到种子轮,大到已经上市的公司后总结出来的。全文总共有8点分析,每一点都结合了当下的最新情况,并给出了对未来的判断。

这篇文章可以说是之前生成式AI开篇之作:《红杉观点|生成式AI:一个创造性的新世界》的最新版,干货非常多。很多内容对AI创业者应该会有不少帮助,笔者在此借助GPT-4快速翻译了这篇文章,希望能够给大家也带来最新的思考和启发。

导语

ChatGPT凭借大型语言模型(LLMs)引发了创新的巨浪,越来越多的公司将自然语言交互的能力引入到他们的产品中。语言模型API的采用正在逐渐形成新的技术栈。

为了更好地理解人们正在构建的应用以及他们使用的技术栈,我们采访了投资portfolio中的33家公司,范围从种子阶段的初创公司到大型上市企业。我们分别在两个月前和上周与他们交谈,来抓住变化的步伐。许多创始人正在努力解决他们自身的AI策略,尽管这个领域正在快速发展,我们仍希望分享我们的发现。

一、几乎所有公司都在产品中用到语言模型

我们看到了一些神奇的自动完成(auto-complete)功能,应用范围从编程(Sourcegraph, Warp, Github)到数据科学(Hex)。我们看到更好的聊天机器人,应用于从客户支持、员工支持到消费者娱乐的各个领域。其他一些公司正在用AI优先的视角重塑整个工作流程:视觉艺术(Midjourney)、营销(Hubspot, Attentive, Drift, Jasper, Copy, Writer)、销售(Gong)、接触中心(Cresta)、法律(Ironclad, Harvey)、会计(Pilot)、生产力(Notion)、数据工程(dbt)、搜索(Glean, Neeva)、购物(Instacart)、消费支付(Klarna)以及旅行计划(Airbnb)。这些只是几个例子,而且只是个开始。

二、这些应用主要基于API、检索和编排,但开源使用也在增长

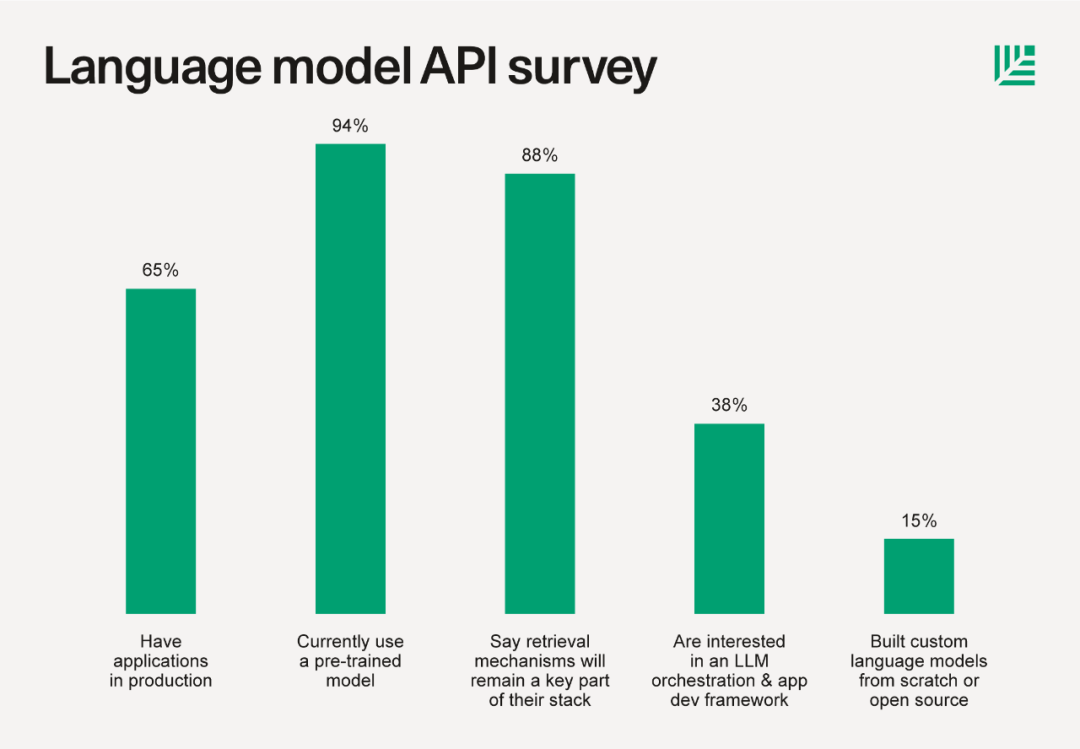

65%的公司已经将应用投入生产,比两个月前的50%有所提高,其余的公司仍在实验阶段。

94%的公司正在使用基础模型API,在我们的样本中,OpenAI的GPT是首选,占比达到了91%,但是,Anthropic在上个季度的关注度增长到了15%。(有些公司使用多个模型)。

88%的公司认为检索技术,如向量数据库,将继续是他们技术栈的关键部分。检索模型通过检索相关上下文来提高结果的质量,减少“幻觉”(不准确之处),并解决数据实时性的问题。一些公司使用专门构建的向量数据库(如Pinecone,Weaviate,Chroma,Qdrant,Milvus等),而其他公司则使用pgvector或AWS的产品。

38%的公司对像LangChain这样的LLM编排和应用开发框架感兴趣,一些公司用它进行原型设计,而其他公司则将其投入生产。在过去的几个月里,采用率有所提高。

不到10%的公司正在寻找用于监控LLM输出、成本或性能并进行A/B测试提示的工具。我们认为,随着越来越多的大公司和受监管的行业开始采用语言模型,这些一数字可能会增加。

少数公司正在研究补充性的生成技术,如将生成文本和语音结合。我们也认为这是一个令人兴奋的增长领域。

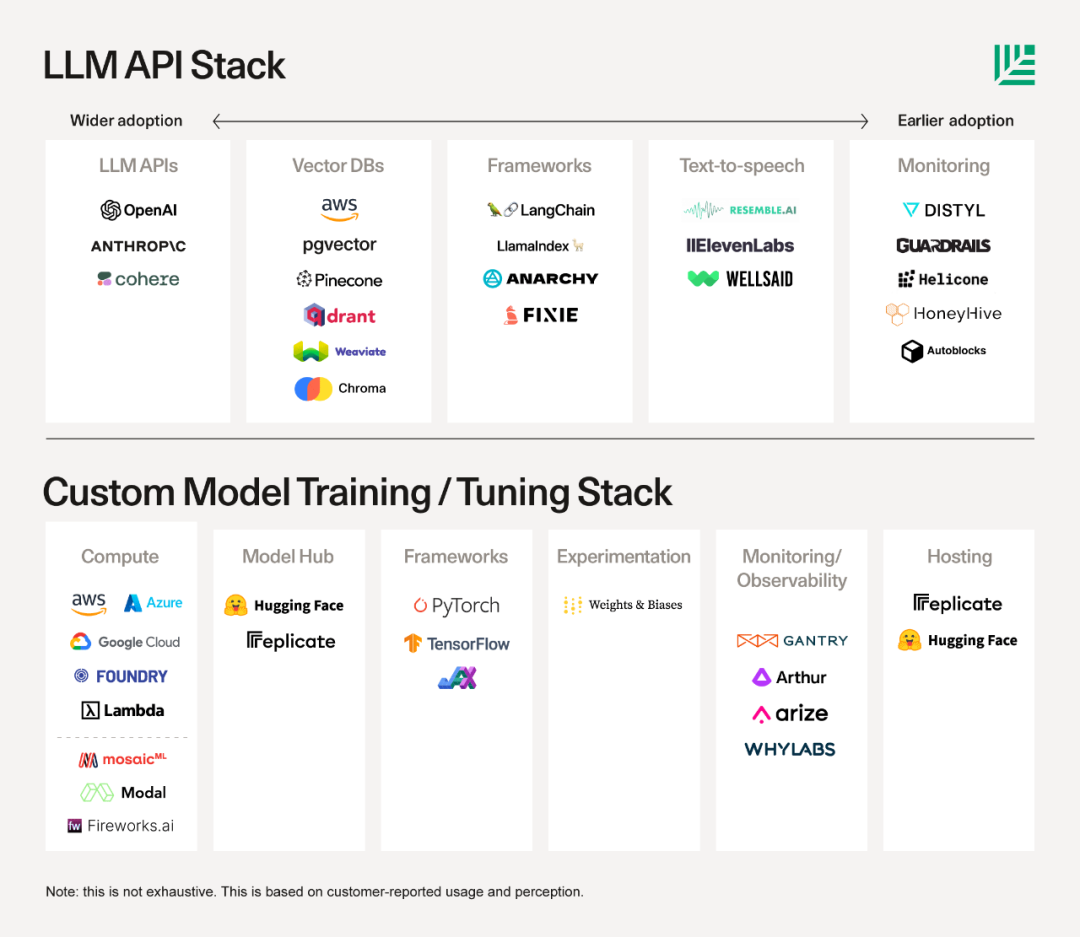

15%的公司从头开始或使用开源资源构建了自定义的语言模型,通常还会使用LLM API。从几个月前开始,自定义模型的训练意义增加了。这需要自己的计算堆栈、模型中心、托管、训练框架、实验跟踪等,来自Hugging Face,Replicate,Foundry,Tecton,Weights & Biases,PyTorch,Scale等受人喜爱的公司对此提供了支持。

我们与每一位实践者交谈的结果显示,AI的发展速度太快,以至于很难对最终的技术栈有高度的信心,但大家一致认为,LLM API将继续作为一个关键支柱,其次是检索机制和像LangChain这样的开发框架。开源和自定义模型的训练和调整似乎也在增长。语言模型技术栈的其他领域也很重要,但成熟度较低。

三、公司希望根据自己的上下文来定制语言模型

通用语言模型非常强大,但对于许多用例来说,它们并不能区分和满足需求。公司希望在他们的数据上启用自然语言交互——他们的开发文档、产品库存、人力资源或IT规则等。在某些情况下,公司也希望根据用户的数据定制他们的模型:你的个人笔记、设计布局、数据指标和代码库等。

目前,有三种主要的方式来定制语言模型:

从头开始训练自定义模型,难度最高。

这是解决此问题的最传统且最困难的方式,它通常需要高度熟练的机器学习科学家、大量相关的数据、训练基础设施和计算能力。

这也是历史上大部分自然语言处理创新发生在大型科技公司的主要原因之一,BloombergGPT是一个在大型科技公司之外进行自定义模型尝试的例子,他们使用了Hugging Face和其他开源工具的资源。随着开源工具的改进和更多公司使用LLM进行创新,我们预计会看到更多的自定义和预训练模型的使用。

微调基础模型,难度中等。

这是通过使用进一步的专有或领域特定数据对预训练模型的权重进行额外训练来进行微调,开源创新也使这种方法越来越可行,但它仍然通常需要一个成熟的团队。一些实践者私下承认,微调比听起来要难得多,可能会产生意想不到的后果,如模型漂移和无预警的“破坏”模型的其他技能。虽然这种方法有很大的可能性会变得更为常见,但目前对大多数公司来说仍然遥不可及。但再次强调,这种情况正在快速改变。

使用预训练模型并检索相关上下文,难度最低。

人们经常认为他们想要一个专门为他们微调的模型,但实际上他们只是希望模型在正确的时间推理他们的信息。有许多方法可以在正确的时间向模型提供正确的信息:向SQL数据库提出结构化查询,搜索整个产品目录,调用一些外部API或使用嵌入检索。

嵌入检索的优点是它使得使用自然语言轻松搜索非结构化数据成为可能。从技术上讲,这是通过获取数据,将其转换为嵌入(embedding),将这些嵌入存储在向量数据库中,当查询发生时,搜索这些嵌入以找到最相关的上下文,并将其提供给模型来实现的。这种方法可以帮助你解决模型有限的上下文窗口问题,成本更低,解决了数据实时性的问题(例如,ChatGPT不知道2021年9月以后的世界),而且它可以由没有正规机器学习培训的独立开发者完成。关于这块技术内容可以看深思圈之前的文章:零基础|搭建基于私域数据的ChatGPT

向量数据库很有用,因为在高规模下,它们使存储、搜索和更新嵌入变得更加简单。到目前为止,我们观察到大公司往往会遵守他们的企业云协议,并使用他们的云提供商的工具,而初创公司倾向于使用专为向量数据库设计的工具。然而,这个领域的变化非常快。上下文窗口正在扩大(最新消息,OpenAI刚刚扩展到16K,而Anthropic已经推出了一个100K token的上下文窗口)。基础模型和云数据库可能会直接将检索嵌入到他们的服务中,我们将密切关注这个市场的演变。

四、如今API调用和训练模型是相互独立的,但未来两者将慢慢融合在一起

有时候,我们可能会觉得我们面临着两种技术栈的选择:一种是利用LLM API的技术栈(更倾向于闭源,针对开发人员设计);另一种是训练自定义语言模型的技术栈(更倾向于开源,历史上针对更复杂的机器学习团队设计)。

有些人想知道,如果LLMs通过API轻松获取,那么公司是否会减少自己的自定义训练。

然而,我们目前看到的情况正好相反。

随着人工智能的关注度提高和开源开发的加速,越来越多的公司对训练和微调自己的模型产生了兴趣。我们认为,随着时间的推移,LLM API技术栈和自定义模型技术栈会越来越融合。例如,一家公司可能会从开源项目中训练自己的语言模型,但又通过向量数据库来进行检索以解决数据实时性的问题。为自定义模型堆栈构建工具的智能初创公司也正在努力扩展他们的产品,以适应LLM API革命的需求。

五、技术栈正在变得越来越易于开发者使用

语言模型API让普通开发者也能手握强大的现成模型,而不仅仅是机器学习团队。现在,与语言模型打交道的人群已经明显扩大到所有开发者,我们相信将会看到更多面向开发者的工具。例如,LangChain通过抽象化常见问题,帮助开发者构建LLM应用:将模型组合成更高级的系统,将多个模型调用链接在一起,将模型连接到工具和数据源,构建能够操作这些工具的代理,以及通过简化语言模型切换的过程,帮助避免对供应商的依赖。有些人使用LangChain进行原型设计,而其他人则继续在生产中使用它。

六、语言模型需要变得更可靠(输出质量、数据隐私和安全性)

在全面引入LLM到他们的应用之前,许多公司希望有更好的工具来处理数据隐私、隔离、安全、版权和监控模型输出。来自金融科技到医疗保健的受监管行业的公司特别关注这一点,并报告说他们在寻找软件解决方案来解决这个问题(对创始人来说这是一个成熟的领域)上遇到了困难。

理想的情况是:如果不能防止模型生成错误/幻觉、歧视性内容、危险内容或其他问题,软件可以及时给出警告信息。一些公司也关注与模型分享的数据如何被用于训练:例如,很少有人知道ChatGPT消费者数据默认用于训练,而ChatGPT商业版和API数据则不是。随着政策的明确和更多的安全措施到位,语言模型将得到更好的信任,这时候我们就会看到采用率的另一个阶段性改变。

七、语言模型应用将变得越来越多模态

有公司已经在寻找有趣的方式将多个生成模型结合起来产生巨大的效果:结合文本和语音生成的聊天机器人解锁了新的对话体验层次。文本和语音模型可以结合起来,帮助你快速修复视频录制错误,而不用重新录制整个视频。模型本身也正变得越来越多模态。我们可以想象未来丰富的消费者和企业AI应用,将文本、语音/音频和图像/视频生成结合起来,创造更吸引人的用户体验,并完成更复杂的任务。

八、目前还仅仅只是初期阶段

AI刚刚开始渗透到技术的每一个角落,只有65%的受访者今天已经开始尝试,而且其中很多都是相对简单的应用。随着更多的公司推出LLM应用,新的难题将会出现——为创业者创造更多的机会。基础设施层(我理解就是中间层的意思)将在未来几年内快速发展,如果我们看到的一半Demo演示都能真正落地投入生产,那么前方等待我们的将是一次令人激动的旅程。看到我们最早期的Arc孵化投资的公司到Zoom的创业者们都在专注于同一件事情:用AI让用户愉快,这是令人激动的。

If you’re founding a company that will become a key pillar of the language model stack or an AI-first application, Sequoia would love to meet you.

红杉美国正在寻找并投资那些将成为语言模型技术栈的关键支柱或AI优先应用的公司。

参考材料:

[1]https://www.sequoiacap.com/article/llm-stack-perspective/

结尾

在看完这篇文章后,又重新回顾了一下去年9月份在这波AI浪潮还未开始前的这篇红杉美国的预判和分析——《红杉观点|生成式AI:一个创造性的新世界》。不得不感叹老牌VC的分析和预判能力,成功预测了最近几个月的AI浪潮或者说正是这篇文章开启了这样一个新的浪潮。希望这篇文章也能给更多AI创业者一些新的启发与思考,另外关于更多Plugin和AI生态的分析,可以阅读我之前的文章——AGI要来了?AI Paradigm的新阶段和新趋势。

专栏作家

深思圈,公众号:深思圈,人人都是产品经理专栏作家。《十五个酷应用玩转树莓派》作者,连续创业者。做过教育、工具和SaaS等行业,关注出海、SaaS和AIGC领域,擅长产品、营销和增长。

本文翻译发布于人人都是产品经理,未经作者许可,禁止转载。

题图来自 Unsplash,基于 CC0 协议。

该文观点仅代表作者本人,人人都是产品经理平台仅提供信息存储空间服务。

- 目前还没评论,等你发挥!

起点课堂会员权益

起点课堂会员权益

产品经理在不同的职业阶段,需要侧重不同的方面,从基础技能、业务深度、专业领域到战略规划和管理能力。

产品经理在不同的职业阶段,需要侧重不同的方面,从基础技能、业务深度、专业领域到战略规划和管理能力。