什么是AI原生应用,百度讲清楚了吗?

AI大模型的浪潮还在汹涌着,有关AI技术发展的消息还在频频传出,比如最近,百度就在2023百度世界大会上宣布了文心一言大4.0,并介绍了“AI原生应用”。那么,“AI原生应用”是否已经找到相应的盈利点了?文心一言4.0,还有什么没有说清?

10月17日,百度召开了2023百度世界大会,并在会上宣布了文心一言4.0。

这一天,还有三家主流大模型创业公司发布了新消息:百川智能宣布完成A1轮3亿美元融资;智谱AI开源了与清华KEG合作的CogVLM-17B多模态大模型;面壁智能推出了与清华NLP合作的XAgent智能体。

ChatGPT转眼上线快一年了,国内经历了半年多的百模大战,AI战火越烧越旺。

百度的官方数据显示,文心大模型4.0在9月已开始小流量上线。8月31日文心一言面向全社会开放至今,用户规模已经达到4500万,开发者5.4万,场景4300个,应用825个,插件超过500个。

在AI大模型这波热潮中,百度几乎是走得最快的,从模型发布、迭代,到产业落地,再到如今发布的以“AI原生应用”为基础的多款C端产品。本次百度世界大会上,李彦宏喊出:“百度要做第一个把所有现有产品都进行重构、重做的公司。”

如此快速地要把过去的产品用AI全部重做,对于任何一家成熟科技公司都相当困难,对于百度的用户来说,最大的兴趣点,聚焦在新的“AI原生应用”到底能给我带来什么?我又要为这些新功能,付出什么?

一、AI原生应用找到盈利点了吗?

李彦宏在本次百度世界大会上的演讲题目是“手把手教你做AI原生应用”,虽然不知道听完演讲之后,有多少人学会了如何做AI原生应用。但百度的确是把AI能力全面加入到了已有的产品中。其中搜索、地图、文库、网盘等ToC产品,更是AI原生应用的主力。

百度本次发布的AI原生应用,包括提升搜索的交互、推荐激发能力,地图的智能辅助决策,网盘的多模态搜索,以及文库的内容检索与生成等。产品提升的核心是用户体验和AI助理功能,从而增加用户黏度,拓展新用户。

对于AI原生应用来说,一直以来主要考虑的问题有两个其一是安全合规,其二是盈利。目前,在安全合规方面,相关部门已经在立法和监管方面做了很多工作,国内大模型普遍已经可以“持证上岗”。但盈利问题仍比较困难。

AI大模型在ToC领域的商业模式,一直是个争议话题。

从OpenAI被曝出的营收情况来看,ChatGPT的付费订阅模式在海外市场还是比较受认可的。外媒The Information报道称,OpenAI CEO Sam Altman在近期的内部讨论中表示,目前OpenAI的年收入约为每年13亿美元,其中很大一部分来自订阅收入。2022年,OpenAI的年收入仅为2800万美元。

不过,国内厂商对生成式AI的C端应用普遍比较看好与现有产品结合,也就是百度正在力推的AI原生应用。

百度2023第二季度财报中曾经提到过,当季资本支出增加主要是由于购买硬件以支持其人工智能模型和应用程序的训练和运营。一些百度内部流出的非官方公布信息显示,文心一言4.0的推理成本比3.5高8到10倍。

庞大的训练、推理成本,摆在面前,对于AI原生应用来说,AI能收回成本吗?能赚钱吗?

一种声音认为,国内的C端产品其实已经做得很好了,AI大模型很难对用户的体验带来跨越式的提升,甚至没法给用户创造特别具体的价值。因此,很难有人直接为C端产品中的AI大模型买单。

从AI原生应用中的大模型功能来看,更多的还是集中在传统互联网消费领域,提供索引和消费决策支持。因此,能给AI最终付费的人,大概率仍会是传统互联网商业模式的主要收入来源——广告。

一直以来,百度营收的重点都是广告,目前主推AI的大厂,微软、谷歌、Meta也都公开提到过生成式AI对广告业务的促进将会是未来的重点。

不过,从百度地图、如流更新的打车、机酒、餐饮等功能来看,与生成式AI相结合的推荐、预订业务,应该也会以渠道的形式创造新的盈利点。

二、AI打开B端局面

国内AI在大模型落地方面,“产业先行”的呼声很高。

百度本次也着重强调了两款B端的AI原生应用GBI(Generative Business Intelligence)和如流。虽说GBI这个词算是“首创”,但这两款产品在国内市场上均不鲜见。多数专注B端的AI供应商都早有类似GBI的产品或功能推出,如流的AI助手,则也早在钉钉和飞书上,看到过相似的功能。

百度的GBI

相对C端来说,B端的盈利模式更好找,但B端用户更看重产品本身的核心能力。

在这方面,虽然百度一直在借AI大模型推动文心千帆平台和百度智能云在B端市场的影响力,但行业对百度的认知明显不够。

“我们最近调研过的国内制造业的大模型,华为和腾讯相对比较适合,我认为百度更偏消费。”某知名自动化技术供应商向虎嗅表示,虽然百度在国内AI大模型中一直走在前排,但是在垂类大模型方面能力并没有特别突出。除此之外,由于百度智能云业务在国内的应用基础不够,很多产业用户并不会优先考虑使用文心千帆或是百度智能云。

目前,文心千帆不支持叠加公有云部署,也就是说百度的AI大模型,只能用在百度的公有云上。

“如果要达到最好的效果,我们建议还是全套都用百度端到端的技术,如果觉得迁移成本比较高,我们也努力在其它云上做很好的适配和效能。不过,我们目前是不支持在其它公有云上去做部署。”百度智能云AI与大数据平台总经理忻舟告诉虎嗅,虽然不能叠加公有云,但客户如果要部署在私有云平台的话,是可以支持其它云或是客户的自研云平台的。

AI大模型的MaaS模式,其实是SaaS模式的一个延伸。对于用户来说,选择云厂商的重点是软件、服务,选择AI大模型也一样。虽然公有云的排他性或许在一定程度上限制了AI大模型的产业推广,但这也使AI大模型成了百度智能云在AI新时代的云市场中,成了百度的一张王牌。

三、文心4.0,还有什么没说清?

百度认为文心一言4.0已是可以直接对标GPT-4的大模型。但在发布会上,或许是受限于篇幅,或许是不想讲太多难懂的技术细节,关于文心4.0模型的技术细节百度并没有讲太多。

其中有两个与大模型落地直接相关的具体问题,也都是一笔带过。

首先是大模型的幻觉问题。

AI大模型落地应用的一个关键因素就是准确和稳定。AI的幻觉问题,直接影响到生成内容的安全合规性,以及能否满足用户使用AI的需求。与其它厂商的发布会不同,百度并没有给出量化的幻觉、错误下降比率。

关于文心大模型4.0的能力提升,在百度CTO王海峰博士的演讲中,只是给了一个很抽象的概念:一个月的时间提升了30%。

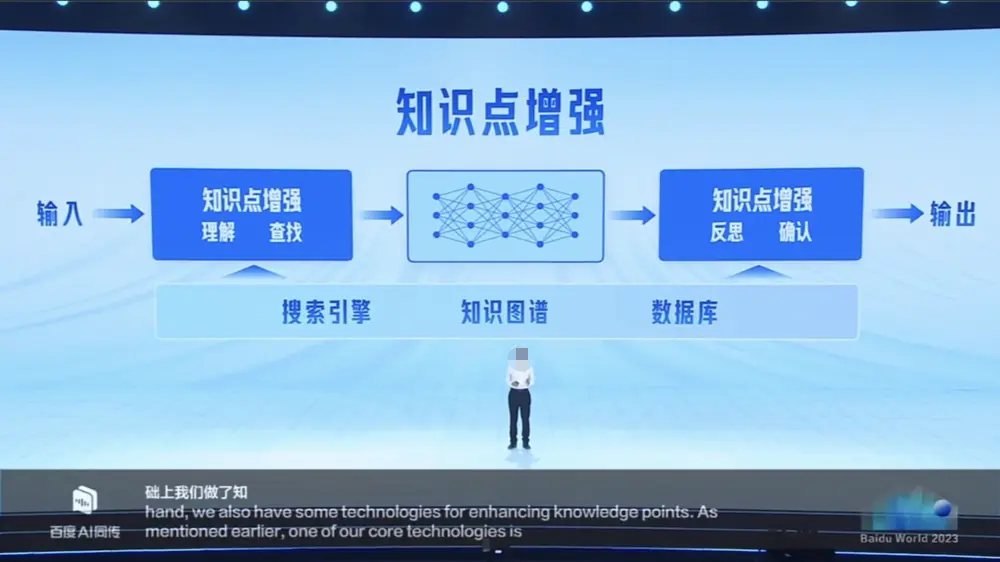

不过王海峰在大模型技术方面,具体讲解了一下,文心大模型正在通过知识点增强和智能体机制,提高回答的准确度和模型的可解释性。在技术上,这两个问题对大模型的应用非常重要。

通过知识点增强提升准确度

另外,就是业内最关心的AI大模型的成本问题。

其实关于大模型每次推理和调用的成本问题,多数厂商都没有给出过具体的数据。不过,在文心千帆的介绍中,百度集团执行副总裁、百度智能云事业群总裁沈抖简单地讲了一下文心千帆的调用价格。

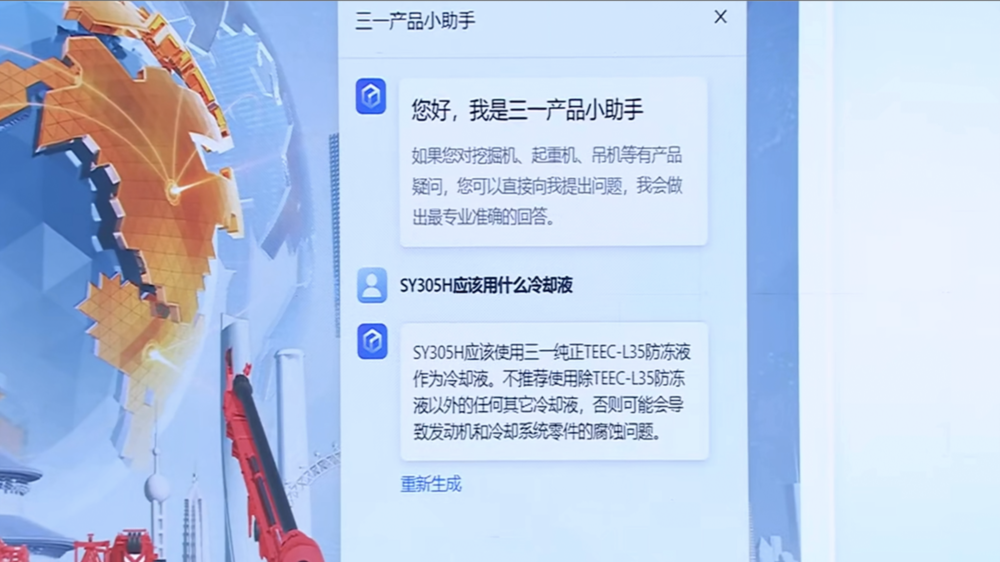

沈抖在演讲中提到,企业利用文心千帆平台基于RAG应用框架制作企业文档问答应用的功能,并介绍了百度与三一重工的探索性合作。

在这个案例中,利用AI大模型只需10来分钟,就可以把48页,20000余字的产品说明制作成问答助手,并生成代码,直接挂在三一重工的网站首页,解答关于三一重工机械产品的专业问题。

基于文心大模型的三一产品小助手

沈抖表示,制作这样一个问答助手的成本:只需要几百块钱,后续的每次问答只需要几分钱。

文心千帆平台的收费定价是公开可查的。

在文心千帆平台上,大模型的预置服务模块报价中,ERNIE-Bot大模型公有云在线调用服务的定价是0.012元/千tokens;Llama-2-70B-Chat的定价是0.044元/千tokens;最便宜的模型是Embedding-V1和bge-large模型,定价为0.002元/千tokens。

计费规则以ERNIE-Bot调优大模型调用服务为例:

输入:“请给我念一首诗”

输出:“春眠不觉晓,处处闻啼鸟。夜来风雨声,花落知多少。”

共中文字数为27,总计tokens为27

调用价格为0.012(单价) x 0.027千tokens=0.000324元

这些只是文心千帆报价的一部分,具体定价可以参阅文心千帆网站。这个定价对于B端用户有限的业务来说确实不贵。结合沈抖的演讲,几乎可以算出三一重工在这个问答助手上每月的开销。

沈抖提到的每次问答几分钱,我们取低,算3分钱一次问答。根据网站访问统计工具SimilarWeb的数据显示,2023年7-9月,三一重工官网的访问量是36.8万次。如果对三一重工的问答每个访问是3次,那平均算下来这3个月的调用成本也就3万块钱左右,确实不多。

虽说这个价格是对B端客户的不太适用C端,不过,我们可以按这个价格大胆估计一下,如果把这个问答助手放在百度官网流量级别的网站首页,可能花费的调用成本是多少。

同样参照SimilarWeb的数据,百度官网在过去3个月中的访问量是156.6亿次。如果每个访问提问1次,那这3个月的调用成本,也有4.6亿元了。

这个估算只是猜测,百度官方对大模型的C端成本控制其实非常乐观。

百度集团副总裁、百度移动生态事业群组(MEG)搜索平台负责人肖阳告诉虎嗅,单看搜索一项,基于文心一言实现“极致满足、推荐激发、多轮交互”的搜索成本没有那么可怕。相对于普通搜索,融合了生成式AI的搜索在成本方面只是“略高”。

不过,在搜索的成本一直很高。有百度内部资料显示,百度搜索本来处理的数据量在七八年前就已经达到千亿级别,目前每年纯设备成本超过50亿元,算上研发、运营和维护的人工成本,总开销每年接近100亿,且有逐年递增的趋势。

肖阳透露,目前百度在搜索方面的AI大模型调用量每天已超3亿次,“这个规模是很大的,如果成本上吃不住的话,早就叫停了。”

作者:齐健;编辑:廖影;出品:虎嗅科技组

来源公众号:虎嗅APP(ID:huxiu_com),从思考,到创造

本文由人人都是产品经理合作媒体 @虎嗅 授权发布,未经许可,禁止转载

题图来自 Unsplash,基于 CC0 协议

该文观点仅代表作者本人,人人都是产品经理平台仅提供信息存储空间服务。

起点课堂会员权益

起点课堂会员权益

咩咩……