优等生归来,谷歌最强大模型Gemini能否打败GPT-4?

在当地时间12月6日,谷歌发布了大模型Gemini,某种程度上,我们可以将Gemini看作是谷歌用来应对GPT-4的“杀手锏”。那么,Gemini的核心优势在于哪些方面?当我们将谷歌和OpenAI二者进行对比时?我们可以得出什么结论?

“沉寂”已久的谷歌终于放大招了。

美国当地时间12月6日,谷歌发布多模态大模型Gemini。谷歌DeepMind直接宣布,Gemini是“谷歌最大、最强的人工智能模型”。

Google Deepmind 的官方账号截图,来源:谷歌DeepMind

Gemini谷歌是从头开始构建的多模态模型,这也是更接近人类认识世界的方式。

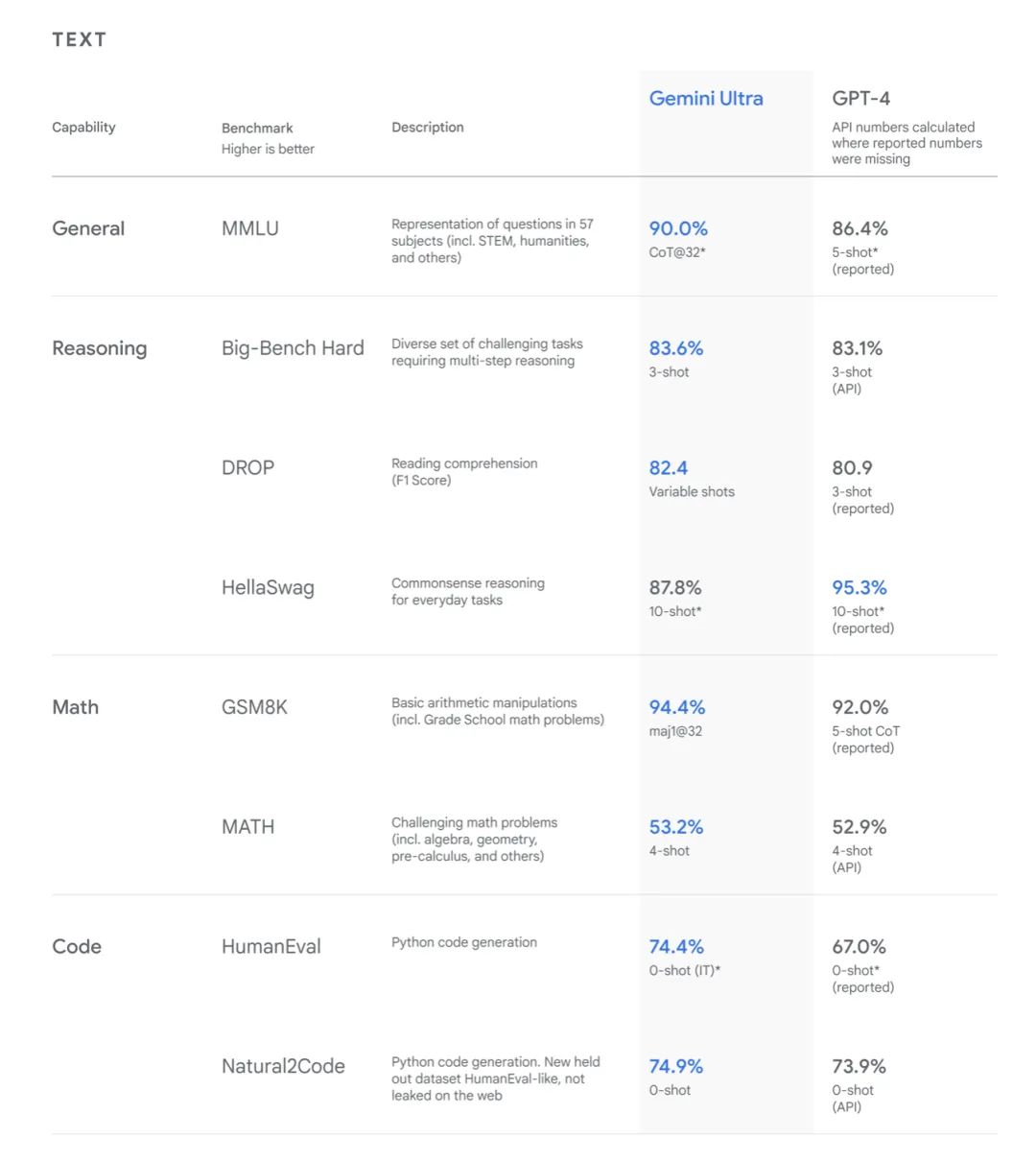

作为谷歌用来应对GPT-4的“杀手锏”。Gemini在32个多模态基准测试中取得了30个SOTA(State Of The Art,即当前最优效果)的记录,是第一个在MMLU(大规模多任务语言理解)测评上超过人类专家的模型。Gemini在此项取得的成绩是90.0%,作为对比,人类专家的成绩为89.8%,GPT-4为86.4%。

Gemini共有三个版本:

- Gemini Ultra:适用于高度复杂的任务;

- Gemini Pro:适用于扩展至各种任务的Gemini模型;

- Gemini Nano:体量较小,适用于特定任务和移动设备。

Gemini的三个版本,图片来源:谷歌

“Gemini的多样性让它能够在从移动设备到大型数据中心的所有设备上运行。”谷歌DeepMind产品副总裁Eli Collins说,“我们离新一代人工智能模型的愿景越来越近了。”

“有了人工智能,我们将有机会以更大规模做一些重要的事情。”谷歌CEO Sundar Pichai在谷歌成立25周年公开信中就特意提到了人工智能。面对强势的OpenAI,优等生谷歌需要一款现象级产品,证明自己在人工智能领域的实力。

Gemini就是谷歌交出的答卷。

一、“打的就是精锐”

谷歌的Gemini模型的核心优势在于其原生多模态(natively multimodal)的特性。

以往的多模态大模型往往是通过分别针对不同模态训练单独的组件,再将这些组件组合起来以模拟多模态功能的方法构建的。虽然在某些任务(比如图像描述)上表现良好,但在处理需要更深层次概念理解和复杂推理的任务时,它们的表现往往不尽人意。

而谷歌的Gemini模型从一开始就在不同模态上进行预训练,再通过使用额外的多模态数据进行微调,进一步提升了模型的有效性。这种原生的多模态训练方法使得Gemini在处理多种类型的数据和复杂任务时更为高效和精准,从而在多模态人工智能领域树立了新的标准。

并且,Gemini的推出主要是“瞄准OpenAI的GPT-4”而来。用《亮剑》里李云龙的话来说就是——“打的就是精锐”。

在运算效能方面,Gemini几乎“全面吊打”GPT-4。Gemini Ultra在大模型研发被广泛使用的32个学术基准测试集中,在其中30个测试集的性能超过此前SOTA结果。其中,在多选问题、数学问题、Python代码任务、阅读等方面,Gemini的性能都超过了此前最先进的水平。

谷歌称,他们对MMLU采用了新的基准方法,使Gemini能够利用推理能力在回答难题之前进行更仔细的思考,相比仅仅根据问题的第一印象作答,Gemini的表现有显著改进。

Gemini Ultra在多个编码基准测试中表现出色,包括HumanEval和Natural2Code。其中仅Gemini仅在HellaSWAG数据集上的测试逊色于GPT-4。

HellaSWAG数据集主要用于研究扎根的常识推理能力,但是一位NLP领域的研究专家向「甲子光年」表示:”这并不能说明GPT4的常识推理性能更好,因为不能排除ChatGPT的模型在HellaSWAG数据集上训练过。”

Gemini模型与GPT-4部分测试评分对比,图片来源:谷歌

此外,在多模态方面,Gemini Ultra在新的MMMU基准测试中取得了59.4%的最先进得分,突显了其多模态性和复杂推理能力。

在图像基准方面的测试中,Gemini Ultra不需要从图像中提取文本就能进行OCR处理,表现优于之前最先进的模型。

Gemini模型在多模态方面的与GPT-4V的测试对比,图片来源:谷歌

Gemini 1.0被训练用于同时识别和理解文本、图像、音频等,因此它能更好地理解具有细微差别的信息,回答与复杂主题相关的问题,尤其擅长解释数学和物理等复杂科目中的推理。

“推理缺陷”也是GPT系列存在的问题。著名语言模型批评者Gary Marcus博士曾锐评道:“大语言模型没法做一些有严格定义的工作:遵守国际象棋规则、五位数字相乘、在家谱中进行可靠的推理、比较不同物体的重量等等。”

Gemini解答物理题演示案例,图片来源:谷歌

尽管技术进步显著,但AI生成的虚假或捏造信息的问题依然存在。Eli Collins指出,这仍是一个未被完全解决的研究难题。

但他同时也强调,Gemini接受了谷歌迄今最为全面的安全评估,以确保其可靠性和安全性。谷歌对Gemini进行了一系列对抗性测试,模拟恶意用户使用模型,并输入各种提示词,以检测模型是否会产生仇恨言论或表现出政治偏见。这些测试包括了“真实毒性提示词”,由网络收集的超过10万个提示词组成,用以全面检验模型的反应。

值得注意的是,Gemini是在谷歌自研的云芯片Tensor Processing Units(TPU)上完成训练的。特别是TPU v5p版本,在性能上有了显著提升,使得模型训练速度相比前一代提高了2.8倍。据悉,TPU v5p芯片是专为数据中心训练及大型模型运行而设计。

从12月13日起,开发人员和企业客户可以通过Google AI Studio或Google Cloud Vertex AI来访问Gemini Pro模型。Google AI Studio是一个基于网络的免费开发工具,为开发人员提供API密钥,从而快速创建原型并启动应用程序。Vertex AI提供了定制化的Gemini以提供更为全面和管理的人工智能平台,并具有完整的数据控制功能,能利用谷歌云的额外功能,包括企业级的安全性、隐私保护以及数据治理和合规性。

此外,从Pixel 8 Pro设备开始,Android开发人员还可以通过Android 14中的新系统功能AICore来使用Gemini Nano。Gemini Nano是专为设备端任务设计的高效模型,通过注册AICore的早期预览版,开发人员可以深入探索其潜力,更便捷地利用Gemini的先进技术,并在Android生态系统的应用开发中迸发更多可能性。

到2024年,谷歌计划推出Bard Advanced,它与AI agent的初级形态十分相似。Bard Advanced将借助Gemini Ultra提供支持,可以迅速理解多模态输入,包括文本、图像、音频和视频,并作出相应的响应。

二、谷歌 VS OpenAI

在OpenAI的GPTs大放异彩时,谷歌似乎过于沉寂了。

今年2月,谷歌在巴黎举行活动时,因其聊天机器人Bard的一处失误,市值蒸发了1000亿美元,也引发了外界对于Bard准确性的担忧。

随着OpenAI推出了ChatGPT,尤其是在必应搜索中整合了GPT技术,并首次在应用程序下载量上超越了谷歌后,人们开始思考谷歌是否在已人工智能领域落后于竞争对手。

事实上,谷歌才是在2017年提出的Transformer模型、为今天这场游戏制定规则的先行者。

谷歌对大模型”高地”的竞争意识并不比OpenAI晚。2021年,谷歌便推出了1.6万亿参数的Switch Transformer,强调稀疏多模态结构的潜力。同时,谷歌还提出了Flan-T5模型,通过更多监督数据降低了模型规模,比GPT-3模型参数更少但性能更佳。

对于技术上的评估,《经济学人》在今年1月曾进行了一项比较测试,向ChatGPT和谷歌基于Lamda的机器人Bard提出了数学、阅读和约会建议等问题。

测试结果显示,谷歌AI在数学问题上表现更佳,但ChatGPT在常识问题上更准确。几天后OpenAI升级了ChatGPT,再次测试中在数学问题上与谷歌AI持平。尽管ChatGPT作为一个大型语言模型训练成本高、迭代难,但也显示了它持续进化的巨大潜力。值得注意的是,谷歌的语言模型与ChatGPT在性能上是旗鼓相当的。

在这场对决中,谷歌和微软都需要成本效益更高的解决方案。谷歌在AI领域取得了不少研究进展,但尚未将这些成果部署和变现,类似于微软在过去的某些时期。这可能是因为谷歌低估了微软和OpenAI的竞争实力,或者过于自信于自己在搜索引擎领域的主导地位。

「甲子光年」综合多方观点分析得出,谷歌在技术前瞻性上领先,OpenAI更专注于产品的打磨。

在Sam Altman领导下的OpenAI专注于产品为导向的工作,致力于扩展和优化模型,主要关注细节精调方法。

谷歌则在技术发展的方向上始终保持着积极和前瞻的态度,不过在整体战略规划上却屡次调整。

谷歌在稀疏模型架构上进行了深入探索。只是两年后的,万亿级别的Switch Transformer几乎没产生任何水花,而千亿参数级别的GPTs系列却风生水起。同样,被反复改进的Flan-T5模型虽然在性能上超越了GPT-3,但其优化进展相对缓慢。

在谷歌“选择困难症”期间,OpenAI已经完成了对ChatGPT的训练。

在2022年9月,谷歌旗下的DeepMind推出了麻雀(Sparrow)模型,和ChatGPT一样,采取了基于人类反馈的强化学习(RL)框架。该模型采用了小型参数设置,与谷歌看重的LaMDA和PaLM模型的思路有明显不同。只是谷歌并未能迅速确定麻雀模型是否是最优选择,这也导致了麻雀模型的产品化滞缓,最终未能“飞上枝头变凤凰”。

“犹豫不决”似乎一直是谷歌的宿疾。“但迟到总比不做好!终于有了OpenAI王座的有力竞争者。”在Google公布消息后,英伟达AI科学家Jim Fan评论道。

今年4月,谷歌将Google Brain和DeepMind团队合并,成立 Google DeepMind。有人将这一团队戏称为“AI复仇者联盟”。原Google AI产品负责人Eli Collins被委以重任,担任新团队的产品副总裁。

目前,Gemini Pro和Gemini Nano已在聊天机器人Bard和智能手机Pixel 8 Pro上集成,实现了更为高级的推理、规划、理解等能力。而更为强大的Gemini Ultra将在明年发布。

不知OpenAI会如何“应战”呢?或许我们很快便可以等到GPT-5的发布了。

不过,优等生谷歌并不完全在意这一时之战,而是在着眼未来。

“我们对答案的探索将在未来25年推动非凡的技术进步。到2048年时,如果有一位青少年在世界上的某个地方,看着我们用人工智能建造的一切耸耸肩,我们就知道我们成功了。然后,我们就回去工作。”

谷歌CEO Sundar Pichai在谷歌成立25周年公开信中如是说。

*参考资料:

《Introducing Gemini: our largest and most capable AI model》,谷歌

《ChatGPT大热,谷歌为何在自己的地盘输给OpenAI?》,界面新闻

作者:苏霍伊;编辑:王博

原文标题:优等生归来,谷歌最强大模型Gemini能否打败GPT4?|甲子光年

来源公众号:甲子光年(ID:jazzyear),立足中国科技创新前沿阵地,动态跟踪头部科技企业发展和传统产业技术升级案例。

本文由人人都是产品经理合作媒体 @甲子光年 授权发布,未经许可,禁止转载。

题图来自Unsplash,基于CC0协议

该文观点仅代表作者本人,人人都是产品经理平台仅提供信息存储空间服务。

- 目前还没评论,等你发挥!

起点课堂会员权益

起点课堂会员权益