原点上的失败:十倍执行力提升可以换来一个成功的AI产品么

如果我们工作时更努力10倍,我们的成绩(比如薪资)能增加10倍么?结果是不可能。一个地儿2米没出水,你挖八百口井该没有水还是没有水。这和互联网匹配的“干就完了”的情绪非常值得警惕。

前几天写了篇文章《为什么说这些倒腾AI的方式会把自己搞死》,陆续收到一些反馈,从反馈中最直观的感受是大家快速把AI导入产品或项目的迫切心情。这种心情加上某些推波助澜的文章可能是坏事的前奏。因此这里再做一点提炼和总结。

一、原点上的失败

干事都会失败,但根因不同,求解的方式也就不同。

AI里面的很多失败是原点上的失败。

原点上的失败是说,除非天下掉奇迹,否则打开始那天就不可能成功,和努力没关系。

前两天琢磨事发起了一个AI碰撞局,当时我提了个问题:如果执行力提高10倍,那改变智能音箱所需要面对的局面么?

大家想了想基本都认为,完全不影响,还是现在这样。

确实,执行力提高10倍,天气这类技能的数目可能膨胀10倍,但根本不可能改变产品自身的用户价值和市场空间,也就不可能改善使用深度。

这很像一条无限接近限定值(比如6分)的曲线,可以无限提升,但永远不可能及格。

为什么会这样呢?

因为约束了语音交互新价值空间的关键因素早早就在那里了。

反倒是当事人没那么愿意看、懒得看或者就上头了。

这些要素在原点上确实是可以列出来并且做判断的。

比如使用情景、物理空间、智能程度、市场空间、后端变现可能性、投入回报周期等确实预先定义了一个可能边界。

除非AI突变,否则在一个限定周期,投入越多,执行力越强,死的越快。

池子就那么大,投喂,然后缺氧,鱼就死很大一批。

不是智能音箱没用,而是过渡的预期后就会变成原点上的失败,比如期望它迅速成为普遍入口。(池子小,少几条鱼一样活挺好)

产品要基于成熟技术,毕竟苹果都基于成熟技术。

当年做智能音箱拔高预期相当于预期AI会迅速无限提高,这种用未来的预期做产品规划的方式,就会导致产品总是快一步。

这一步往往就是生死界限。

如果单是智能音箱,这事已经过去了,再提起来意义不大,但问题是不单过去,现在我们很多时候仍然可能在重复这种原点上的失败,比如具身机器人、垂域大模型等。

为什么在AI领域原点上的失败变得普遍?

一个可能的原因是互联网对我们影响过深,而AI与互联网迥异,要求我们重塑认知价值的思维模式。

过去30年的是互联网的30年。

企业家、KOL、媒体共同构建了一套互联网的价值认知体系,这深刻的影响了每一个人。

现在主导的驱动力及其特征变了(从互联网到AI),但思维惯性之下就很容易沿用过去的判断方法。

比如米国和日本就是很不一样两种环境,用同一种行为模式可能就危险,我把这种差异概括为:

这是跑马探地和打呆仗的区别。

试错成本不同衍生的方法论就不同。

一种需要快速试错,另一种就必须深掘场景才能见水。

单点、极致、口碑、快、一针捅破天等在AI这儿似乎完全颠倒了,看起来要调过来。

而如果追究为什么这样的底层逻辑,那需要回到新技术的基本特征。

互联网关键的是链接,是网络效应,所以就容易迅速铺开,每个点上并不带来特别大的改变。这就催生对快的追求。

人工智能关键的是智能,是理解概念和自主判断的能力。这种能力显然对场景的改变越多价值越大。

新技术领域必然是技术自身的特征决定了匹配它的方法论,而非相反。

从这个视角再回看智能音箱大战就会更理解这为什么是原点上的失败。

在你本来应该创造价值的点上,没有深挖(深挖也有其它问题,但是两回事),而是迅速谋求不存在的网络效应或者后端价值,那钱可不就打了水漂。

一个地儿2米没出水,你挖八百口井该没有水还是没有水。

再延伸一点就是和互联网匹配的干就完了的情绪非常值得警惕。

试错成本低的时候确实谋定后动的重要度会被淡化,勇猛点快跑没准就碰上了。

但打井这事,有水没水是不可能碰出来的。

如果说互联网可以只用20%的精神头思考,然后一路狂奔即可,没准也能干成社交网络。

那人工智能则至少需要百分之五十,否则大概率十死无生,大概率沙漠打井。

二、混沌状态下的底层逻辑

混沌状态下没有手册性的方法论的。

挖铜矿手册很关键,因为大致被研究明白了。按手册干好就是专业。

AI应用的魅力就在于没人明白,这时候宣称有手册性方法论的大概率是骗子。

正因为没人明白,所以才有机会。

很多人现在可能比2000年的马云还懂互联网,但你绝不可能再做出大的互联网产品了。

这时候必须探求底层逻辑,它们可能不严密但自洽,能勾画出一个轮廓,辅助避免原点上的错误。

很巧的是琢磨事的AI碰撞局上正好有这么个例子(周伟明同学提供的)。

假如你想做一个法律的大模型,那为了看看这地儿能不能挖出水,预先的判断是什么呢?

1. 场景上是你预想完整覆盖什么样的场景,这个场景本身的价值是什么样?

- 是能完整取代一个初级律师,还是初级律师的辅助工具

- 如果变成信息提供的辅助工具,那和现有产品有多大差分,是不是就提高个10%~20%

2. 技术上是模型到底能干到什么程度?什么样的人能干到什么程度?你的人能干到什么程度?你有多少资源(数据资金等)做这事?(图灵测试2.0)

3. 出错的概率是多少?出错的效果是否能承担?

4. … …

不列全了,核心是AI用在这个场景下会弄死你的并且短期不可能改变的点有么?这是要预先列的,也是可以预先列出来的。

这种分解是产品定义之前要琢磨的,每个都比较生死攸关。

列出来后反倒是寻找答案不难。很多时候一手体验和公开信息也能有个大致的答案。

尤其是现在的智能在你设定场景的新体验的程度是很容易测试出来的。

这时候需要注意的是:AI使用成本极低,不能被某些新词绕进去比如RAG这类,要整一手的体验。

大家可以仔细想想,RAG其实更大可能是提高的你效率,而不是具体某个场景的体验。

形象讲是如果你自己一次构建足够全的prompt,然后大模型的智能程度不够,加了RAG一样不够。

三、从外往里看,和模型与参数保持距离

做产品其实很忌讳把技术的希望当成可以构建产品特征的现实。

写售前方案倒是可以,至少可以看着比较高大上。

产品方要关注技术(大模型等)的智能高度,但要关注的不是细节。

在智用研究院的公开课上,我打了一个比方:

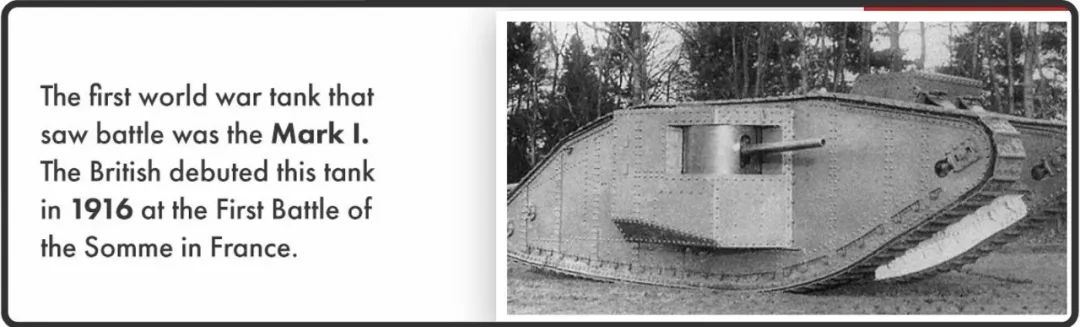

英国人发明了坦克,实际上则是德国人在闪电战里把坦克威力发挥到极致,用的最好。(陈春花老师聊天的时候提到的,特别适合这个情景)

构想闪电战的人是要了解坦克的,但肯定不能和坦克的工程师学习怎么设计闪电战。

坦克的工程师是看不见闪电战的。

这是两个完全不同的维度。

媒体可以把新技术名词、新模型谁大谁参数多作为一种噱头来制造热点。

做产品的时候就是回到一手体验,回到场景,整清楚它现在可以干什么,不可以干什么。

概念性技术不适合用来构建产品,除非你特别特别有钱。

但考虑智能的拔高还是会有个过程,所以机会敞口会有个次序。

大致是先从纯粹数字、幻觉破坏作用小的领域扩展到具身的、幻觉作用大的领域。

这里尺度的判断非常关键,不要忘了Google Glass、自动驾驶干多少年了!

打深井的模式下,原点已经是决胜点。

四、小结

一个完整可供参考的也还算自洽的底层逻辑框架在:AI的脉络:非共识时刻的认知价值,这里不重复了。最后想说的是这类框架对于混沌状态下做应用是有帮助的,但作用也有限的。可以帮助避免原点上的错误,也可以在挖井的时候,对最初十米有点帮助。但既然是挖井,后面90米必然需要在现场的泥土里摸爬滚打,和现场的持续反复。给个手册照着做,产品就成功了,人就发财了,在这个时间点这么宣称的真的是骗子。

后续会在智用研究院开课,不期望纯手册,也认同上面观点的同学可以看看:

AI原生得应用怎么做?

参照文章:

从1到10:AI产品和互联网产品的核心差异

第九生命:从文明限度的角度看AI

AI上国内团队好像被甩开了?差钱?差人?

AI的进化:从间断平衡到终极复制

专栏作家

琢磨事,微信公众号:琢磨事,人人都是产品经理专栏作家。声智科技副总裁。著有《终极复制:人工智能将如何推动社会巨变》、《完美软件开发:方法与逻辑》、《互联网+时代的7个引爆点》等书。

本文原创发布于人人都是产品经理。未经许可,禁止转载。

题图来自 Unsplash,基于 CC0 协议

该文观点仅代表作者本人,人人都是产品经理平台仅提供信息存储空间服务。

- 目前还没评论,等你发挥!

起点课堂会员权益

起点课堂会员权益