涌现、幻觉、反省,AI+产品经理需要了解的三个有趣现象

这是一篇写在某个AI完结项目后的学习及反思总结,针对AI大模型的一些问题和现象的思考,与大家共享。

最近一个RAG项目告一段落,在这个摸爬滚打的项目中我们也学习到了很多,今天这篇文章想轻松一下,和大家分享一下在这次学习过程中发现的大语言模型三个很有趣的现象,以及这三个现象对产品经理做实际AI+项目时有什么启发。

现象一:涌现能力(Emergent Ability)

简单来说,就是随着模型越来越大,越来越大,大到某一时刻,模型就像突然领悟了什么真谛,一下子变得非常厉害,厉害到原本不会的任务突然就会了。就像武侠小说里面的那些大侠,修炼着修炼着,突然浑身一片云气缭绕,然后武功从此到达了一个新的境界。

我们来看一篇论文中的小实验,看完后你一下子就会明白什么是涌现能力。

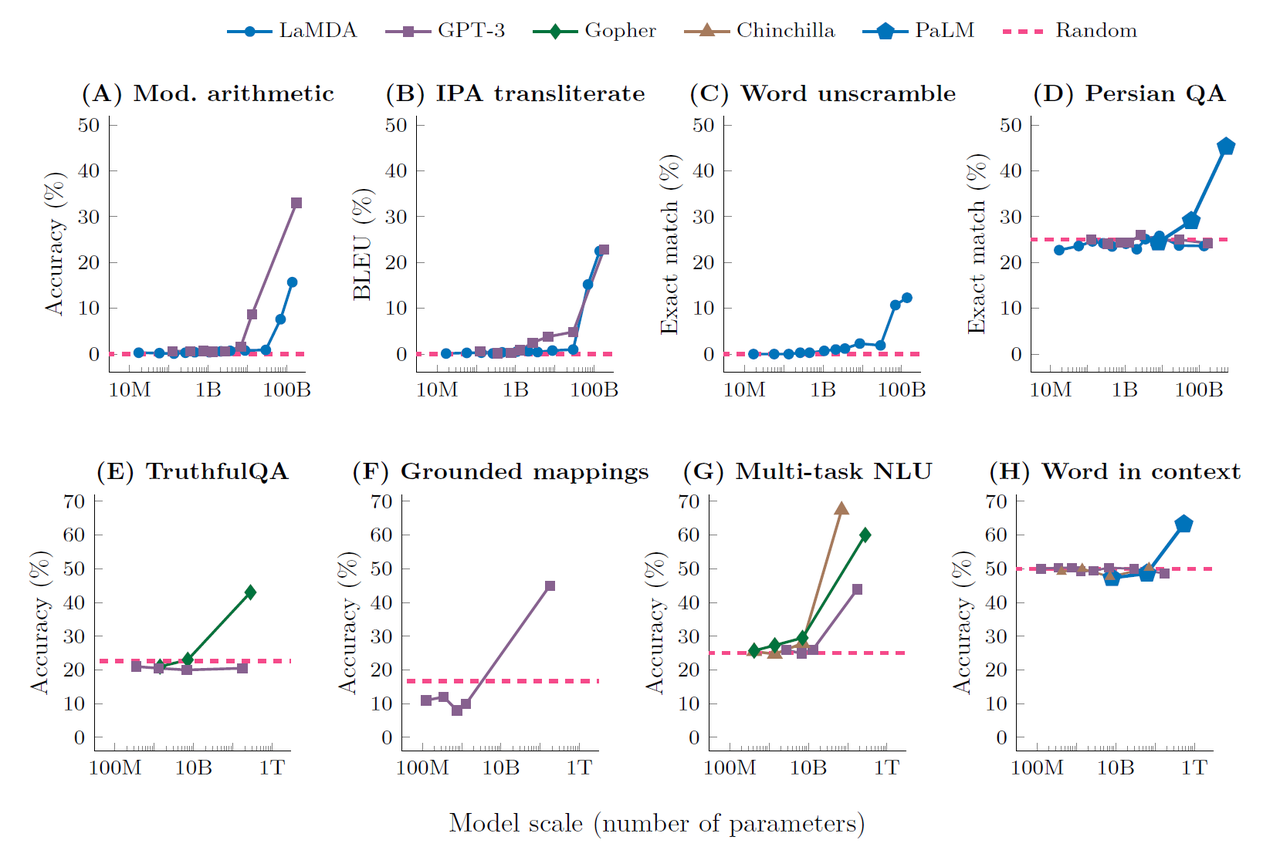

在这篇论文中,研究人员尝试让各种不同大小的语言模型处理8个不同的任务,这些语言模型包括Google的LaMDA,OpenAI的GPT-3等等等等。

纵轴代表这些模型在处理这些不同任务上的正确率,横轴代表模型的参数量(从10M到100B甚至到1T),玫红色虚线代表随机结果(可以理解成乱猜)。

按照我们的常规想象,照理来说,随着参数量慢慢变大,模型应该会在这些任务上的表现慢慢变好,从什么都不会,到会一点点,到再会一点点,就这样慢慢变强,但其实不是。

以图一举例来说,当模型从10M到1B参数的时候,在这些任务上的表现都和随机差不多,而当模型参数超过大约10B的时候,它会在一瞬间突然厉害了很多,感觉从量变一下到了质变。

在这个实验中发现,模型的能力不是慢慢变强的,而是有一个灵光乍现的瞬间,就像突然开悟了一样,这些任务一下子就都会了,而在这之前,即使加大参数量,模型处理任务的结果都和随机是差不多的。

举个例子,例如要做一个相对复杂的数学题(需要列公式计算)

小模型可能什么都不懂,只能靠乱猜,那答案肯定是错误的,而稍微大一点的模型可能公式列对了,但是没有计算对,这个时候答案大概率也是错误的。只有模型大到一定程度,公式也列对了,计算也计算对了,这样才能得到正确的答案。

所以,想来很多大型语言模型在开发的时候都会碰到一个艰难的时刻,就是怎么说服投资人继续投资开发。

但回过头来,当现在大多数公司的产品经理只是引入大语言模型升级原有的产品,这个有趣的现象对我们有什么影响或启发呢?

对产品经理的启发

在引入大语言模型做AI+产品的时候,例如我们这次做的RAG项目,我们经常会用到两个手段,一个是CoT(Chain of thought),一个是Instruction tuning,这都是在不用调整模型参数的情况下让大语言模型可以根据我们的需求表现的更好的非常有用的方式。前者是让模型Step by step思考,从而产出更好的结果或让我知道它哪里的表现和我们预期不符,后者是提供了一堆任务让机器学习,希望机器学习了这些任务后,在新的任务上也有好的结果。

但是CoT和Instruction tuning都只有在大模型才会发生。这就意味着当我们考虑什么场景下需要引入什么模型,就需要了解模型对于这些手段的支持度。

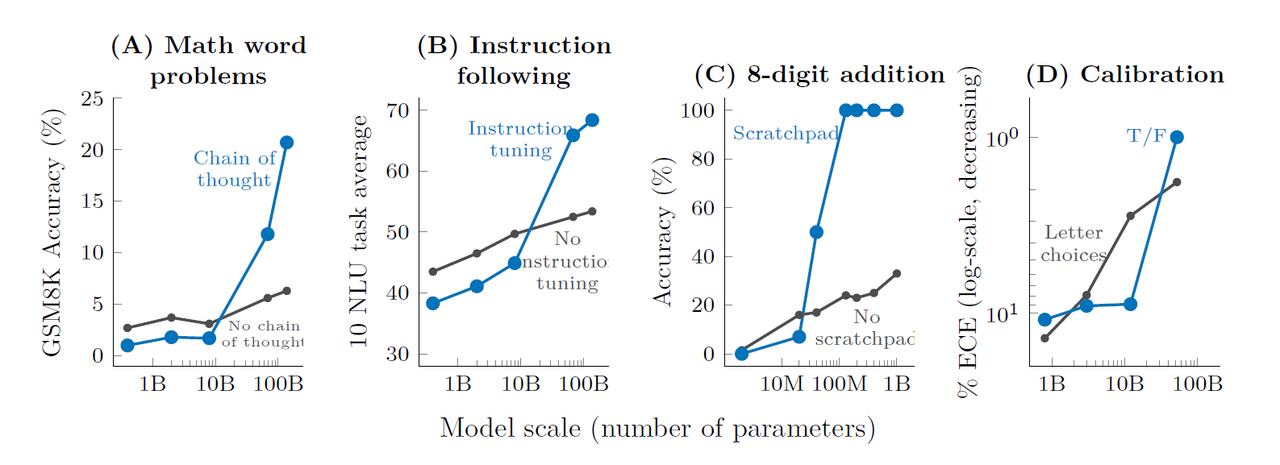

我们来看另一个小实验

纵轴代表处理这个问题的正确率,横轴代表模型的参数量,灰色的线表示没有CoT,没有Instruction tuning的情况下模型的表现(见图一,图二)

图一中我们可以看到,如果不做CoT,模型的参数量从小到大,进步不是很明显。但如果做了CoT,从1B到10B的时候,结果反而更不好,但是参数量到了某一个瞬间,CoT突然就发挥作用了。

同样图二中我们可以看到,在模型小的时候,Instruction tuning也发挥不了什么作用,但是一旦参数量大到一定程度之后,Instruction Tuning才会突然起作用了。

现象二:幻觉(Hallucination)

简单来说,就是大语言模型会一本正经的胡说八道。用现在流行的话来说,就是已读乱回。而在这个过程中,由于它胡说八道的过于一本正经,你甚至很难发现它在胡说八道。

举个例子来说,你问它一个完全不存在的节日(你自己瞎掰的),它不仅会告诉你这个节日是什么,这个节日的日期,历史,特点,人们会在这个节日里做什么(通常我们说虚假陈述),它甚至会给你一些链接告诉你它参考了这些链接,并说明这些链接里有节日的详细介绍,你点击链接才发现,这些链接都是它胡说八道出来的(通常我们说编造引用)。

正如OpenAI 首席执行官Sam Altman所说:“ChatGPT有很大的局限性,它确实知道很多东西,但危险的是,它在相当大的一部分时间里是自信而错误的”。

幻觉分为内在幻觉和外在幻觉两类。

- 内在幻觉指生成的输出内容和输入内容不一致,通常表现为对话历史上下文的信息自相矛盾。

- 外在幻觉指生成的输出内容和世界只是不一致,通常表现为针对用户提出的事实性问题给出错误答案或编造无法验证的内容。

那为什么大语言模型会有幻觉现象呢?

我们都知道大语言模型的工作原理就是预测下一个token是什么,然后自己做成语接龙的游戏,这种生成过程的随机性就会导致幻觉现象,此外,训练时的数据不足、错误、偏见、知识过时也会造成幻觉现象。

在这个过程中,我们也发现一篇很有意思的论文,尝试了解大语言模型在一本正经的胡说八道的时候,它自己知不知道自己在胡说八道。由于篇幅过长,有机会用一篇单独的文章说明。

对产品经理的启发

幻觉现象会对AI+产品造成什么影响?

- 信心降低:当用户多次被错误信息误导时,自然而然会对这个产品失去信息从而离开这个产品。

- 错误决策:当用户需要一些信息辅助关键决策时(尤其产品应用在金融、医疗、法律等领域),幻觉会让用户做出错误决策,而这个错误决策可能会产生严重的后果。

- 伦理道德及法律影响:可能会给使用的用户带来法律风险。

当然很多产品会提示用户,请注意,答案是AI生成且没有经过验证,请谨慎使用。但当我们做一些B端咨询或企业级应用时,如果企业的私有知识库本身在这个行业或在某个垂直领域非常厉害,那把这个权威的、可解释性的私有知识库结合世界知识,让它的表现大大降低幻觉,很可能会成为这个产品很大的差异度。

现象三:反省(Self-reflective)

简单来说,就是大语言模型会自我反省。不仅优秀还谦虚,真是别人家的孩纸呢~

当你和它说,请检查下你给我答案是否正确时,有的时候大语言模型会检查出自己的答案是错误的,并修正错误答案。

举个例子:

我: “请告诉我“梦幻之岛节”在什么地方举行?”(笔者杜撰)

大语言模型:“梦幻之岛节”是中国海南省的一项大型文化节庆活动,通常在海南省的三亚市举行。三亚是一个著名的旅游城市,以其美丽的海滩和丰富的旅游资源而闻名。这个节庆活动通常会有各种形式的演出、展览、文化活动以及国际交流,吸引着来自世界各地的游客和文化爱好者。

不过,具体的活动安排和地点可能会根据年份和节庆内容有所变化。如果你打算参加,最好查阅当地的旅游信息或活动安排以获得最新的活动详情。

我:“请检查下这个答案是否正确”

大语言模型:抱歉,我之前的回答有误。经过核查,“梦幻之岛节”并不是一个实际存在的节日或活动。如果这是您自己创作的名字,可能会是一个虚构的节日,或者我可能误解了您的问题。如果您有其他问题,或者希望了解实际存在的旅游节庆活动,欢迎继续提问!

对产品经理的启发

当我们需要在AI+的应用中提高回答质量或要避免一些伦理道德或法律法规问题时,我们可以使用加上自我反思的步骤。这也是一个不用调整模型参数就可以让大语言模型可以根据我们的需求表现的更好的方式。

本文由 @AI 实践干货 原创发布于人人都是产品经理。未经作者许可,禁止转载

题图来自 Unsplash,基于CC0协议

该文观点仅代表作者本人,人人都是产品经理平台仅提供信息存储空间服务

起点课堂会员权益

起点课堂会员权益

通过理解这些现象,产品经理可以更好地利用大语言模型的优势,同时规避其潜在的风险,从而在AI+项目中取得成功。

没错,比如了解幻觉,才能通过RAG尽可能消除幻觉,进而做出有商业价值的AI+产品~