一次性搞懂MCP是啥,如何安装以及与Function call 的区别

MCP作为AI大模型的标准化工具箱,类似于“通用语言”或“万能插座”,能够帮助大模型访问和操作外部工具,完成具体任务。本文将详细介绍MCP(Model Context Protocol)的概念、技术原理、安装方法以及与Function call的区别。

一、MCP的概念

MCP 的全称是Model Context Protocol,也就是模型上下文协议,是由Claude的母公司Anthropic于24年低开源发布的,MCP就是AI大模型的标准化工具箱,可以把它想象成 AI 大模型和外部数据、工具之间沟通的 “通用语言” 或者 “万能插座”,大模型可以利用这些工具与外界互动,获取信息并且完成具体任务。

MCP可以代替人类访问并且操作外部工具,每个mcp服务或者叫做MCP Server都专精于一类的工作:比如有的负责读写浏览器、有的负责读写本地文件、有的操作git仓库等等,MCP Server 通常就是运行在本地的一段 nodejs 或者 python 程序。

二、技术原理

大模型通过操作系统的stdio,也就是标准输入通道调用某个MCP Server,他的消息格式是这种的

MCP Server 接到这些请求以后,通过自己的代码功能,或者使用API请求,访问外部工具,完成任务,MCP协议与Function call 非常相似:MCP 的最大优点在于整合了之前各家大模型不同的Function call 的标准,整合成了一个统一的标准协议。而且不仅是Claude,市面上几乎所有的大模型都可以接入MCP

1、支持MCP协议的客户端

目前可以使用MCP功能的客户端不算多,主要有AI编程工具Cursor、Cline还有Claude的官方的客户端(windsurf claude app)

2、MCP的本质

MCP的本质就是客户端用命令行调用了电脑上的nodejs程序,然后程序执行了某些操作,在把结果返回回来,当然也不仅限于nodejs程序,也有可能是python的。还有一种不太常见的情况,就是这个node或者python程序运行在服务器上面,我们则是通过网络进行调用。

三、案例 – MCP+Cursor

下面给大家展示一下,如何在Cursor上配置MCP

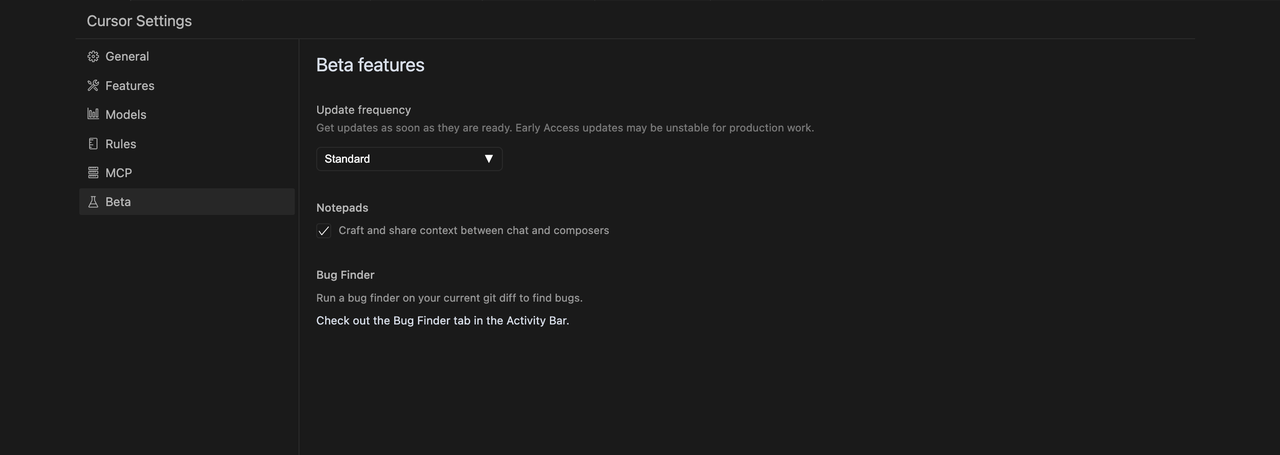

1、首先我们点击Cursor的设置按钮,在Beta features中先把Cursor升级为最新版本

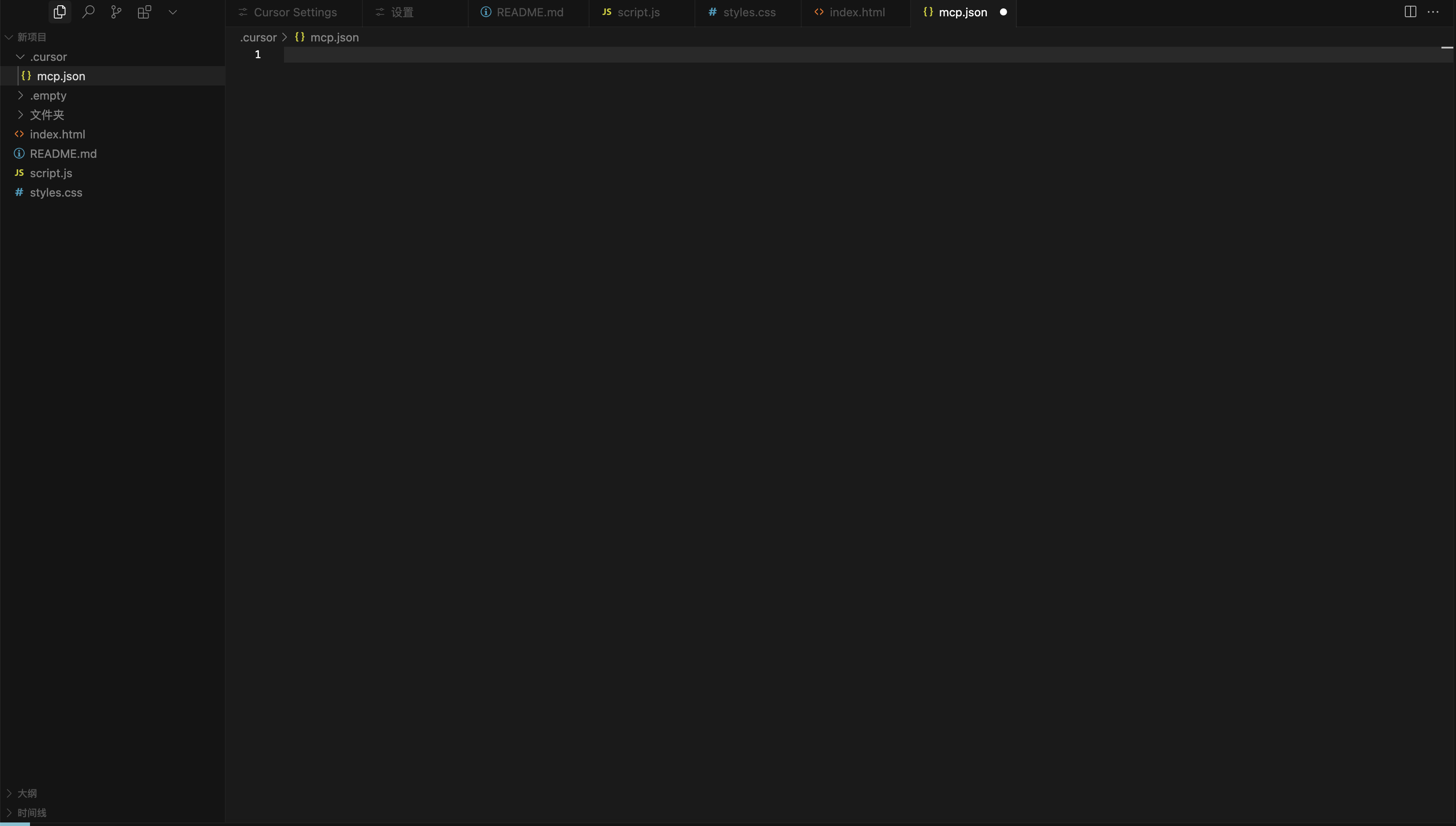

2、点击MCP配置,现在的MCP是通过文件的方式配置的。

我们需要在根目录创建一个文件夹 .cursor,文件夹里 在创建一个文件 .json

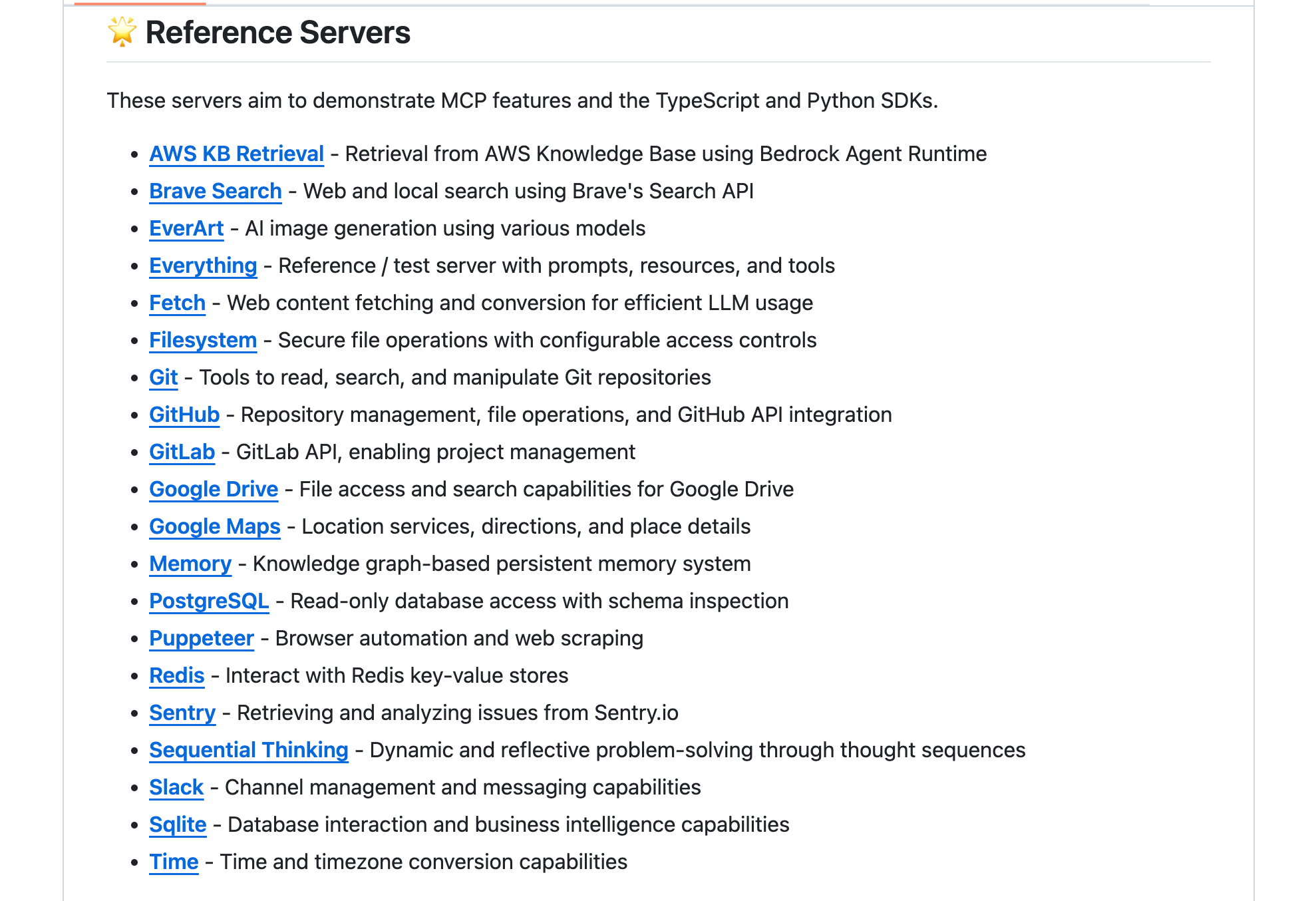

3、打开GitHub,注册并找到MCP(Model Context Protocol Servers)页面,以配置GitHub为例

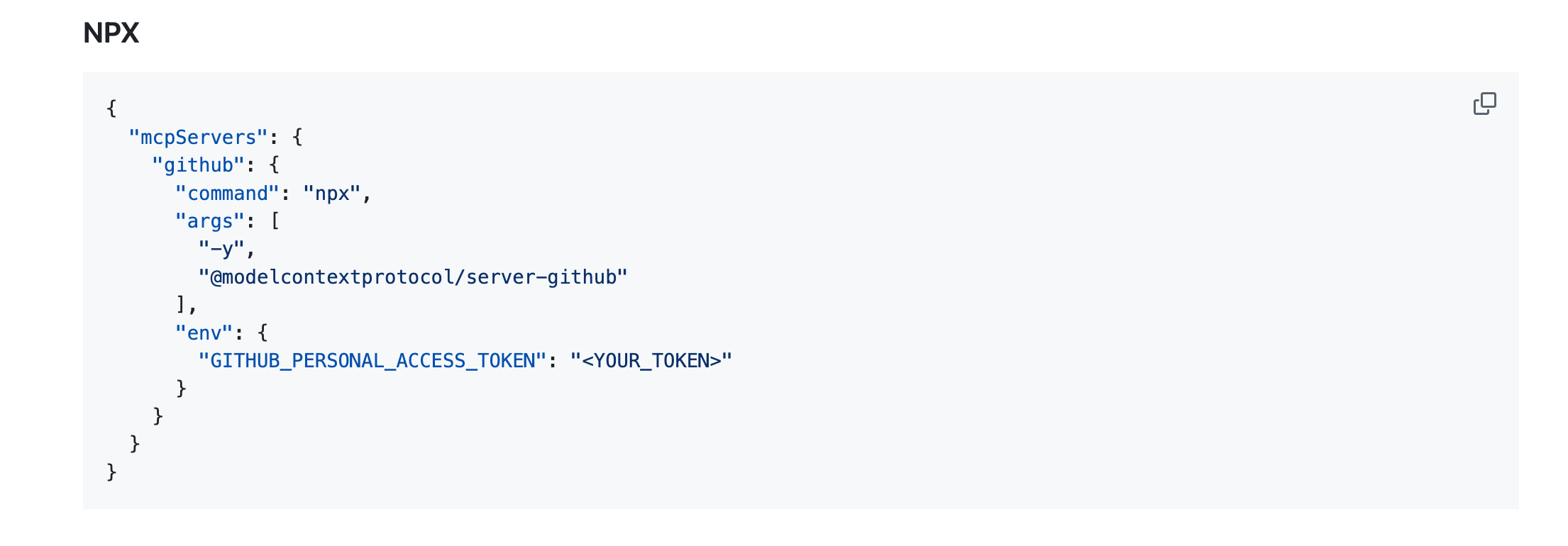

4、点击GitHub向下划动找到NPX,复制下面这段代码,并粘贴到我们刚才在Cursor中新建的 .json文件中

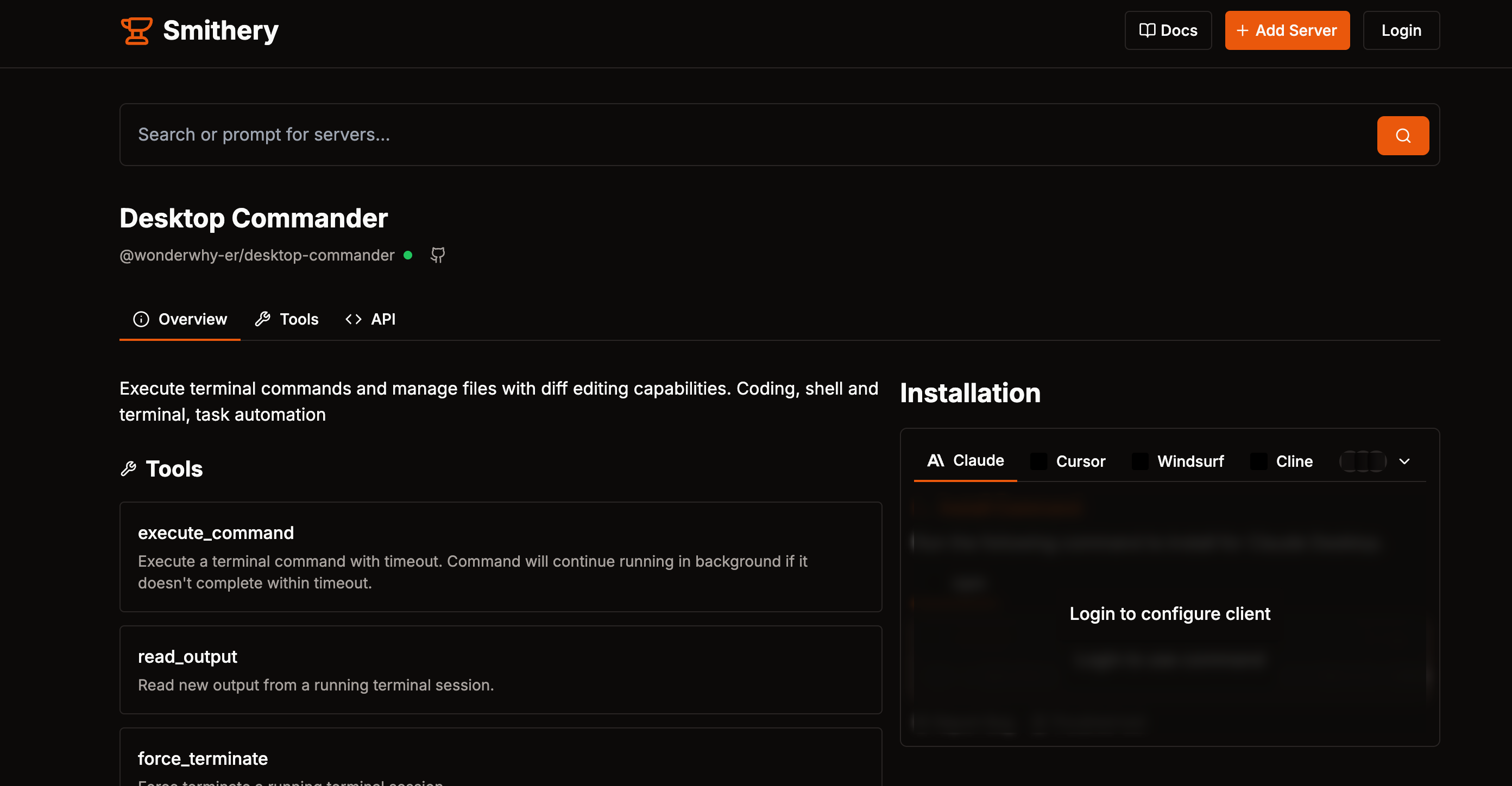

四、MCP工具网站分享

smithery.ai 这是一个MCP工具的聚合网站,这里收录了 2,681 种MCP Server ,我们可以根据自己的需求,在这里找到最适合自己的MCP 服务。

安装方式还是更我们上述的案例一样,点击你想要配置的MCP

点击绿色小点后面的GitHub图标,就进入到了GitHub页面,后面安装的流程就和上述案例一样了,把NPX所展示的代码复制到.json文件中就可以了

五、MCP与function call的区别

MCP与function call只是功能相似,他们之间是相互独立的,没有依赖关系,function call简单来说就是AI调用外部工具的能力,是某些大模型(如 GPT-4)提供的专有接口特性。它允许模型直接生成结构化的函数调用请求(如查询天气、计算数值),由宿主应用执行并返回结果。本质是模型内部的功能扩展,依赖于特定厂商的实现,无强制标准协议。

MCP的最大优点是集合了之前各家大模型不同的function call的标准,整合成了一个统一的标准协议,而且不仅仅是claude,市面上几乎所有的大模型,都可以接入MCP,类似于 AI 领域的 “USB-C 接口”。它通过统一的通信规范(如 JSON-RPC 2.0),解决大模型与外部工具、数据源之间的兼容性问题。核心目标是让不同模型和工具能高效互操作,开发者只需按 MCP 标准开发一次接口,即可被多个模型调用。

简而言之,MCP 解决 “如何让 AI 连接万物” 的通用性问题,Function Calling 解决 “如何让 AI 快速执行特定操作” 的效率问题,二者互补协作,共同支撑 AI 从对话走向自动化任务执行。

本文由 @贝琳_belin 原创发布于人人都是产品经理。未经作者许可,禁止转载

题图来自Unsplash,基于CC0协议

该文观点仅代表作者本人,人人都是产品经理平台仅提供信息存储空间服务

- 目前还没评论,等你发挥!

起点课堂会员权益

起点课堂会员权益