有“情商”能表达情绪的AI!从Hume AI看语音助手的变革

语音助手正在变得更加智能,变得越来越有能力解释人类语言中的情感、语境,甚至语音的细微差别。这篇文章里,作者就从Hume AI出发,来探索语音助手的变革与未来,一起来看。

可能是新奇,也可能是接地气,在现如今市面上卷生卷死的无数聊天机器人中,人们天然对那些表现出类人情绪的 AI 有着更多好感。

无论是去年 12 月新浪微博推出的“阴阳怪气、已读乱回”评论机器人“评论罗伯特”,还是 Inflection AI 旗下“聪明又善良”的聊天机器人“Pi”,都凭借着或贱或暖的人设,在社交媒体频频出圈。

但要说到情感的抓取与表达,没有什么比得过语音,一个轻微的音调变化、简短的语气词,就能让人脑补出思绪万千。

不久前,Hume AI 推出了能够识别情绪的同理心语音界面(EVI),就像 Suno 彻底改变音乐制作模式,Sora 重塑视频制作流程一样,EVI 将大语言模型(LLMs)与表达测量完全集成为移情大语言模型(eLLM),重新定义了我们对于此前冰冷的生成式 AI 的认知。

图源:Hume AI

AI正在试着理解用户的感受,开始变得察言观色起来。

一、AI 不仅知道你在说什么,也知道你在想什么

经过不断的训练,AI 已经能够做到对人们输入的指令做出反馈,当给出提示时,经过训练的模型会预测最可能的下一个单词或字符来生成文本,通过持续迭代这一过程直至生成所需长度的文本。

这很难说是 AI 知道自己在说什么,在很多人看来,AI 似乎只是在玩词语接龙游戏,不知道自己生成的长篇大论的最终含义,这也意味着 AI 对于输入的上下文的理解也存在着局限性,对于 AI 系统来说,理解人类交流的微妙语言、讽刺、歧义和其他复杂性仍然具有挑战性。

那如果我们为 AI 模型加上一个情绪输入接口,AI 是否就能理解人类的情绪和感受了呢?

图源:Hume AI

在 AI 领域,就有一家名为 Hume AI 的纽约初创公司正在进行这种突破性的研究。该公司由 Google DeepMind 前研究员 Alan Cowen 领导,其使命是通过引入称为移情语音接口 (EVI) 的先进语音人工智能,彻底改变人机交互。

EVI 被誉为世界上第一个具有“情商”的人工智能。当我们实际体验下来,的确能感受和其他语音 AI 不一样的人文关怀。

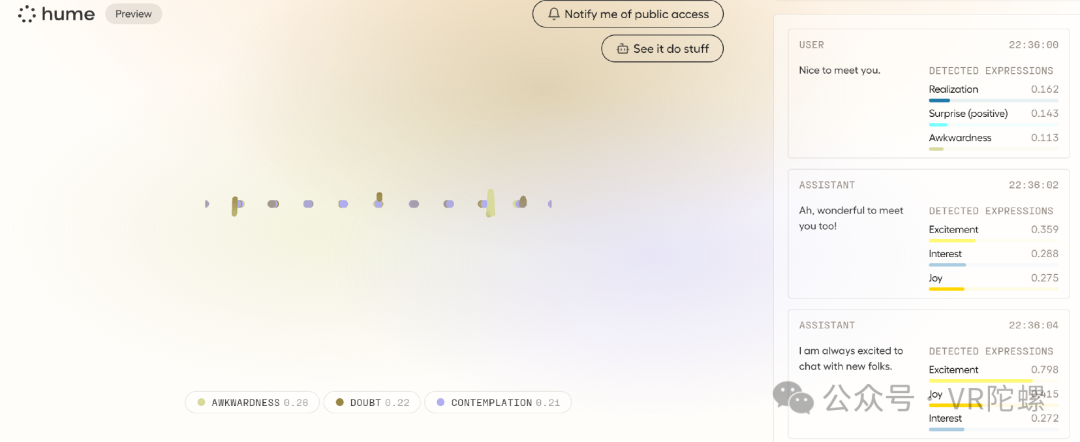

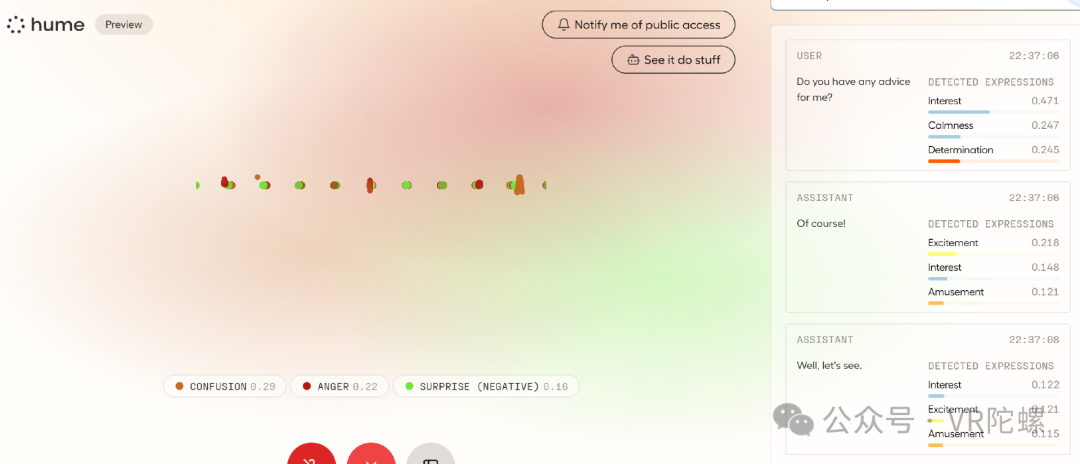

EVI 的入门很容易,只需要允许站点访问设备麦克风,就可以与聊天机器人畅所欲言,无论你正在经历什么情绪,都会在 EVI 面前得到即时反馈。

当你兴奋地向 EVI 打招呼时,它同样也会情绪激动地对你进行回应。

而当你向 EVI 提问时,它会体会你的情绪,并给出深思熟虑的回答(由于上下文原因,EVI 只给出了简短的回复)。

体验下来,EVI 有很多亮点。一是语音识别准确清晰,即使是在存在轻微噪音的环境下,EVI 还是能准确识别出连贯的语句,并转化为文字和提现语音情绪的条状图。

二是聊天过程轻松愉快。除了感受语音输入方的微妙语气之外,EVI 还能主动接下话茬,不会把天聊死。

但还处在持续开发阶段的 EVI 也还能挑出一些不足。或许是因为 EVI“情商”过高了,用户语句衔接速度不能过快,需要留出一些反应时间给 EVI“思考”,否则 EVI 很容易表现得畏畏缩缩、前言不搭后语,出现像远程新闻记者连线延迟那样的尴尬情况。

其次是情绪识别,从聊天界面可以看到,除了十分明显的情绪(兴奋、悲伤、愤怒等)外,EVI 对其他的情绪识别分类过于精细,这是普通人难以察觉的,我们无法正确判断 EVI 情绪识别的准确性。

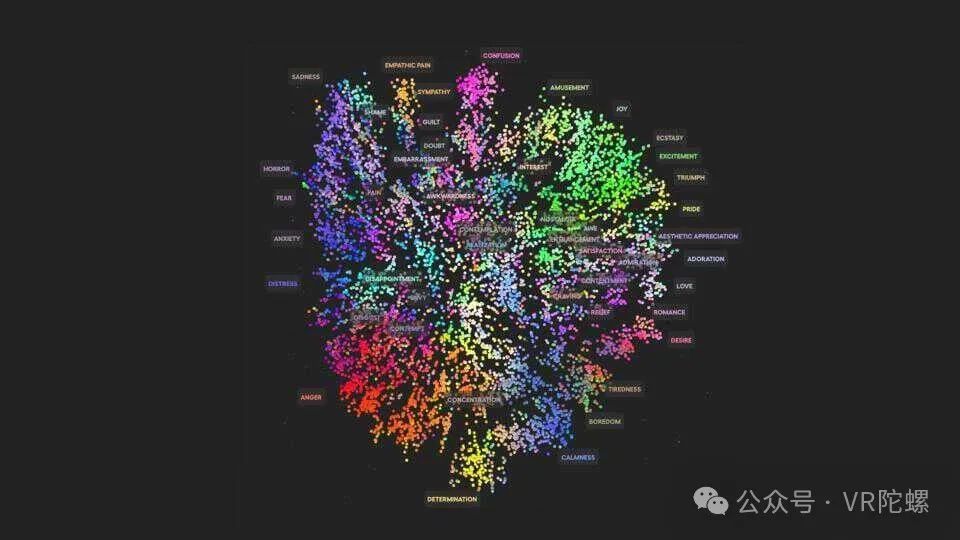

从 Hume AI 官网展示的信息,EVI 能够识别和响应 53 种不同情绪。这一从声音中辨别情绪的能力来源于包括全球数十万人的受控实验数据在内的全面研究,EVI 正是基于对不同文化来源声音和面部表情的复杂分析,才构成了 AI 情绪识别能力的基础。

图源:Hume AI

根据 Hume AI 的说法,EVI 的情绪感知能力都要归功于移情大语言模型(eLLM),这使得 EVI 能够根据上下文和用户的情绪表达来调整所使用的词语和语气。

通过在丰富的情感表达数据集上训练深度神经网络,Hume AI 打造了一个在理解和传达情感细微差别方面表现出色的 AI 模型,远远超出了当前 AI 技术所能达到的上限。

除此之外,Hume AI 还在 EVI 的研究中融入了一种被广泛应用在心理语言统计、分析领域的技术——语义空间理论(SST)。通过广泛的数据收集和先进的统计模型,SST可以精准绘制人类情感的全谱图,揭示人类情感状态之间的连续性,使得EVI具备很多拟人化的特色功能。

具有“情商”的 EVI 影响是巨大的,理解和响应人类情感的能力代表着 AI 技术的重大飞跃。

EVI 代表了人工智能技术的重大飞跃,因为它具有理解和响应人类情感的能力。与仅依赖口头命令、冰冷输出正确回答的传统语音助手不同,EVI 能够辨别人类语音的细微差别并相应地调整其响应,这一点在医疗保健、教育等客户服务领域差别更深。

图源:网络

想象一下,在学习压力过大,学生心理问题日渐增多的情况下,EVI 能够化身虚拟导师,感知学生情绪并为其提供个性化帮助,提供同理心支持;在零售行业,EVI 同样也能充当一把虚拟客服,能够根据客户语音变化及时调整语气,而不是只会回复“在呢亲~”。

在这些更需要人文关怀的领域,EVI的应用潜力几乎是无限的。

正因为此,Hume AI 不久前就就从 EQT Ventures、Union Square Ventures 和 LG Technology Ventures 等知名投资者那里筹集了 5000 万美元的 B 轮融资。这家初创公司的吸金能力表明了业界对这种 AI 情感解决方案的信心。

此外,Hume AI 还能够与 GPT 和 Claude 等大型语言模型无缝集成,公司准备为其平台 API 推出 beta 模式,允许开发人员将这一技术集成到各种应用程序中,这无疑将为跨时代的语音助手问世铺平道路。

从 Siri 到 EVI,语音助手的智商水平终于快要回归正常。

二、语音助手的演变

Hume AI 目前只在其官网开放访问,但可以预见的是,以语音情绪识别为特色的聊天机器人最终的归宿还是要融入智能硬件,成为贴身又贴心的智能助理。

搭载硬件设备后,语音助手已成为智能化时代中的重要工具,彻底改变了我们与设备交互的方式。从毁誉参半的 Siri 到 AI 驱动的个人助理,语音助手的发展简直令人惊叹。

语音助手的发展可以追溯到 20 世纪 50 年代,当时开发的语音识别系统如 IBM 的 Shoebox 和贝尔实验室的 Audrey,只能识别少量单词或短语。

而后的 90 年代,计算能力的提高和互联网的出现带来了更先进的语音识别系统,包括 Dragon NaturallySpeaking 和早期的语音激活虚拟助手凭借强大的语音识别和转录功能处于领先地位。

随后,以 Siri 为代表的的对话式语音助手在与智能手机的碰撞中走入现代,苹果 Siri、谷歌 Now、微软 Cortana 以及亚马逊 Alexa 等都是里程碑式的应用。

如今,以 OpenAI 和 Hume AI 为代表的科技公司通过提高语音 AI 系统的理解相应能力,为语音助理创建更加个性化和自然的交互,“真正的语音助手”诞生于 AI 之下。

图源:Amazon

这些聪明的助理已成为我们日常生活的重要组成部分,以前所未有的方式简化流程并增加便利性。

几年前,语音助手还只能做简单的问答、生硬的信息推荐、以及讲冷笑话,现在,理解口语、分析上下文并使用自然语言处理 (NLP) 和机器学习技术提供相关信息并执行请求已经成为语音助手的基本功能。

这种复杂程度意味着语音助手不再只是被动的工具,而是主动的帮助者,能够提供建议、记住偏好并适应个人用户模式,人们可以通过语音命令实现对硬件产品应用的召之即来。

在 AR 眼镜上,类似的应用已经有很多,语音助手已成为产品的标配功能。

星纪魅族全新 XR 品牌“MYVU”就搭载了“FlymeAR”交互系统,并采用全新的 Aicy 语音助手。

雷鸟 X2 Lite AR 眼镜加入大模型语音助手 Rayneo AI,主打对多模态信息交互能力和场景的探索。

OPPO 则在巴塞罗那 MWC 大会期间展示了其最新的智能眼镜产品原型 OPPO Air Glass 3,搭载了基于 OPPO AndesGPT 大语言模型的语音助手,可以执行语音提问、搜索等基本工作。

图源:OPPO

而从这几款产品已经推出的功能来看,AR 眼镜语音助手的发力领域基本集中在信息检索、任务管理、媒体娱乐、路线导航以及语言翻译上。

特别是任务管理功能,用户可以使用语音助手来帮助他们管理任务和日程安排,使用语音助手发送通知、发出提醒、安排约会、建立待办事项列表和设置提醒,可以帮助用户梳理必要事项。

这基本也是 AI 模型在 AR 眼镜上的应用方向,语音助手的智能化体现在与眼镜的交互以及应用程序的调用上,就像影视剧中的配角,不是最重要却处处需要,还要靠它带出主角。

再加上类似于前面提到的 EVI 移情大语言模型,语音助手对于情绪的理解加深,对于语言理解的能力加倍。随着不断的研究和开发,这些助手将变得更加直观、具有情境感知能力并融入我们的生活。

根据 Salesforce Research 的一项数据,27%的消费者每天都会在电子产品中使用 AI 语音助手,随着 AI 能力的增强,这一数字预计还会增长。

三、未来的 AI 语音助手

更加人性化的 AI 有助于 AR 眼镜打造更加智能的语音助手,这使得类似于 EVI 的情感聊天模型在 AR 领域能够发挥更大的作用。

Hume AI 首席执行官兼首席科学家艾伦·考恩 (Alan Cowen) 就表示,如果我们想以更加自然的方式使用 AI,那么 AI 同理心的展示就至关重要。

“当前 AI 系统的主要局限性在于,它们受到肤浅的人类评级和指令的指导,这很容易出错,并且无法挖掘其巨大潜力,无法找到让人们快乐的新方法。”

而 Hume AI 也并不是唯一一家尝试将情感融入 AI 技术的公司。

英国公司制造的人形机器人 Ameca 就能够观察周围环境并与人交流,其面部表情逼真,能够展示出表现不同情感的面部表情。

图源:网络

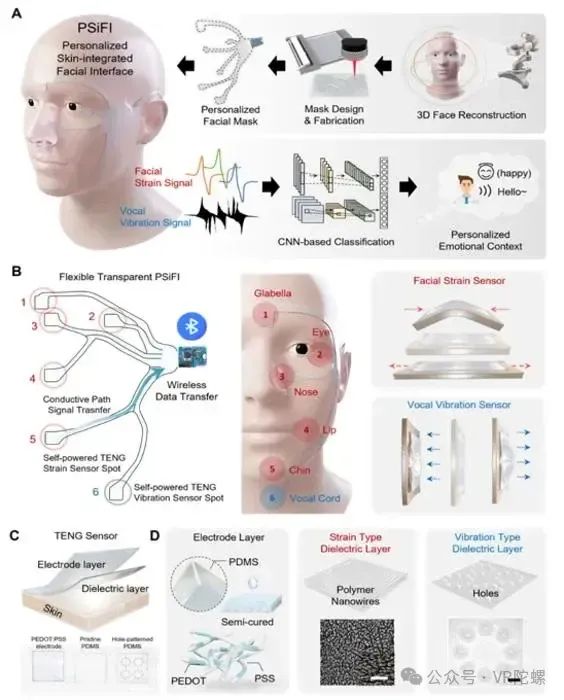

不久前,韩国蔚山国立科学技术研究院(UNIST)的科学家们还研制出了一种类似于“面膜”的可穿戴设备,能够通过传感器捕捉捕捉微小的动作和发声,并利用个性化皮肤集成面部接口(PSiFI)系统执行无线数据传输,实现实时情绪识别。

其开发者 Jiyun Kim 认为,这款可穿戴设备可用于 VR 数字人服务等应用,根据用户的情感提供定制服务。

图源:UNIST

但 AI 对人类情感的窥探带来的除了人性化之外还有隐私担忧。

此前,一些面部情绪识别 AI 技术就因为难以解决的数据安全技术而被科技公司们无奈关停。

2022 年,微软宣布停止销售根据面部图像猜测人类情绪的技术,并将不再提供不受限制的面部识别技术。

而在更早之前也有消息传出谷歌从其用于解读情绪的工具中屏蔽了 13 种计划中的情绪,并对四种现有的情绪进行了审查。在隐私泄露的可能性之下,谷歌正在权衡一种可以直接描述表情动作的新系统,而不试图将表情动作与情绪联系起来。

人类的语音中也包含了许多的隐私信息,很难说在注重数据安全的时代,未来的 AI 语音情绪识别技术不会受到同样的限制。

但可以确定的是,对于隐私的担忧并不会影响未来 AI 改变语音助手形态的趋势。

随着苹果全球开发者大会(WWDC)的召开在即,科技界对 Siri 的重大演变充满期待。许多人认为 Siri 2.0 的新阶段有望将生成式 AI 的进步带到语音助手领域的最前沿。

传闻中 Siri 2.0 的升级自然也包括了更多个性化和自然对话功能,大家都希望能看到更加亲切的 Siri。

而除此之外,有更多消息表明,Siri 在接入大模型后,将不再只是单纯的语音助理,而将升级为多模态智能助手,承担更多的生成式 AI 功能。

不久前,苹果推出了 ReALM 模型,其类似于谷歌 Gemini,能同时处理文本和视觉效果。

与 GPT-3.5 不同的是,ReALM 注重于破译对话和视觉上下文,可以将屏幕的视觉内容转换为文本、注释及空间细节,这使得 ReALM 能够以文本方式解释屏幕内容,从而有助于更精确地识别和理解屏幕上的信息。

ReALM 将被用于专门破译对话中模棱两可的引用和指代,将大大提高 Siri 理解上下文相关查询的能力。这直接带来的是 Siri 个性化定制能力的提高。

通过 ReALM 学习用户的交互行为,Siri 可能更准确地预测用户的需求和偏好,根据过去的行为和对上下文的理解来建议或启动操作。Siri 有望成为最懂你的“人”。

借助机器学习技术,语音助手可以不断提高其性能。AI 从用户交互中一边学习,一边调整反应和理解,语音助手可以在识别语音模式的过程中提高语言理解能力,甚至可以使用机器学习根据先前的数据定制其响应。

这意味着未来语音助手不仅仅只是信息获取和应用操作的入口,而是将作为学习与模仿者,在一次次的对话中记录用户的喜好,更深入理解用户需求,提供更加个性化和预测性的支持。

可以看到,在与人类的友好互动中逐步理解人类、适应人类已经成为语音助手未来的主要主题之一。

语音助手越来越有能力解释人类语言中的情感、语境,甚至语音的细微差别。这种接近人类的情商水平可以为更加个性化和富有同情心的互动开辟道路,将虚拟助手转变为真正的合作伙伴。

同时,语音助手与其他技术的结合有望释放它们的潜能。通过与 AR/VR 相结合,语音助手可以提供身临其境的交互式体验。不仅带来了技术进步,还为 AI 注入新的可能性:理解并尊重人类情感的复杂性。这将改变我们与机器互动的方式,进而改变我们与彼此互动的方式。

作者:VR陀螺

来源公众号:VR陀螺(ID:vrtuoluo),XR行业垂直媒体,关注VR/AR的头部产业服务平台。

本文由人人都是产品经理合作媒体 @VR陀螺 授权发布,未经许可,禁止转载。

题图来自 Unsplash,基于 CC0 协议

该文观点仅代表作者本人,人人都是产品经理平台仅提供信息存储空间服务。

- 目前还没评论,等你发挥!

起点课堂会员权益

起点课堂会员权益