解锁AI对话的秘诀:如何写好提示词,获得你想要的回答

对当下各家的大模型产品而言,决定对话质量的,除了大模型本身的能力差异,就在于用户的提示词技巧。好的技巧能给到更高质量的回答。这篇文章,我们就来学习一下提高提示词质量的技巧和方法。

在数字时代,AI技术的迅猛发展已经深入到我们的日常生活中。无论是智能助手、聊天机器人,还是各种自动化服务,AI都在扮演着重要角色。然而,如何让AI更好地理解并回答我们的提问,提示词的编写至关重要。

本文将带你深入探讨AI提示词写作的技巧,让你轻松获得理想的回答。

一、AI对话的原理

要写好提示词,首先要理解AI生成文本的基本原理。这部分内容看似复杂,但其实深入浅出地理解后,就能掌握与AI对话的诀窍。

AI生成文本依赖于语言模型,这些模型通过大量的文本数据进行训练,学习语言的结构和模式。常见的AI语言模型如GPT(Generative Pre-trained Transformer),它通过对海量数据的分析,学会了如何在不同语境下生成连贯和有意义的文本。

AI并不像人类那样拥有自主的常识和生活经验,它依赖于提示词提供的上下文信息。这意味着,提示词越清晰、越具体,AI越能理解你的意图。

当用户输入提示词后,AI会通过以下步骤生成回答:

- 解析提示词:AI首先会解析输入的提示词,提取关键词和语境。

- 检索知识库:根据解析结果,从训练数据中检索相关信息。

- 生成文本:结合上下文和检索到的信息,生成连贯的回答。

每一步都依赖于提示词的质量。如果提示词模糊或缺乏具体性,AI的解析和检索过程就会受到影响,最终生成的回答也可能不尽如人意。

二、提示词的概念和分类

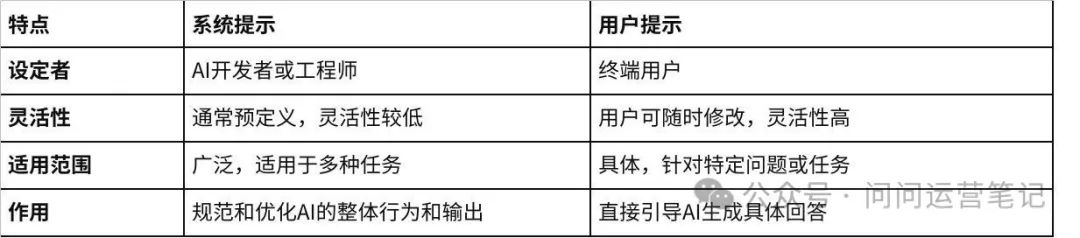

提示词是用户向AI输入的指令或问题,用来引导AI生成相应的回答。提示词可以分为系统提示和用户提示两大类。理解这两者的区别有助于更有效地引导AI生成所需的回答。

系统提示:AI模型内部使用的提示,通常用于指导模型如何执行特定任务。这些提示通常由AI开发者或工程师预先设计,用来规范和优化AI的工作方式。特点如下:

- 预定义:系统提示通常在模型训练或部署时就已经设定好,用户无法直接修改。

- 广泛适用:这些提示适用于多种任务,帮助AI在不同场景下保持一致的表现。

- 行为规范:系统提示可以设定AI的语气、风格和具体行为规范,确保输出的稳定性和质量。

比如说:

- 指示模型如何回答问题:”在回答用户问题时,请保持专业和礼貌的语气,并提供尽可能详细的信息。”

- 设定输出格式: “生成的回答应包含以下结构:引言、主要内容和总结。”

这种系统提示可以确保AI在不同用户交互中保持一致的语气和结构,提升用户体验。

用户提示:由终端用户输入的具体指令或问题,用来引导AI生成特定的回答。用户提示的灵活性和多样性,使得它们能够针对具体需求进行定制。特点如下:

- 灵活多变:用户可以根据具体需求和场景随时修改提示词。

- 具体性强:用户提示通常针对特定问题或任务,提供详细的背景信息和要求。

- 直接交互:用户提示是用户与AI互动的直接方式,决定了AI生成内容的具体方向和质量。

比如说:

- 询问具体信息:”你能详细介绍一下人工智能在医疗领域的应用吗?”

- 要求特定格式:”请用500字解释气候变化的原因、影响和应对措施。”

通过用户提示,用户可以精准地控制AI的输出,使其更符合个人需求和特定情境。

三、提示词的原则

一个好的提示词能够:明确AI的任务、提供必要的背景信息、限定回答的范围和深度。

好的提示词应遵循以下原则:

- 明确性:提示词应清晰明确,避免模糊不清的问题。

- 简洁性:尽量保持提示词简洁明了,避免过于复杂的句子结构。

- 具体性:提供具体的背景信息和期望的回答方向,减少歧义。

- 连贯性:在多轮对话中,提示词应保持前后一致,确保对话连贯性。

四、提示词框架推荐

了解了好的提示词原则后,我们来看看一些常用的提示词框架。这些框架不仅能帮助我们更好地组织和表达需求,还能大大提高AI生成的内容质量。

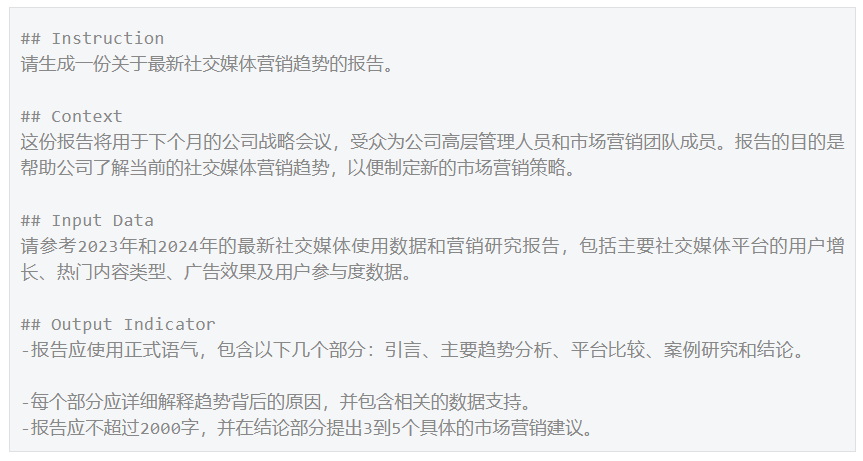

1. ICIO 框架

ICIO框架指的是:Instruction(指令)+Context(背景信息)+Input Data(输入数据)+Output Indicator(输出引导)。

- Instruction(指令):框架的核心,用于明确AI需执行的任务。编写指令时,应简明扼要,确保AI可准确把握任务目标及要求。

- Context(背景信息):包括任务背景、目的、受众、范围、扮演角色等等,有助于AI理解任务并生成响应。

- Input Data(输入数据):告知模型需要处理的数据,非必需,若任务无需特定的输入数据,则可省略。

- Output Indicator(输出引导):告知模型输出结果的类型或风格等,如指定所需语气(正式、随意、信息性、说服性等)、定义格式或结构(如论文、要点、大纲、对话)、指定约束条件(如字数或字符数限制)、要求包含引用或来源以支持信息等。

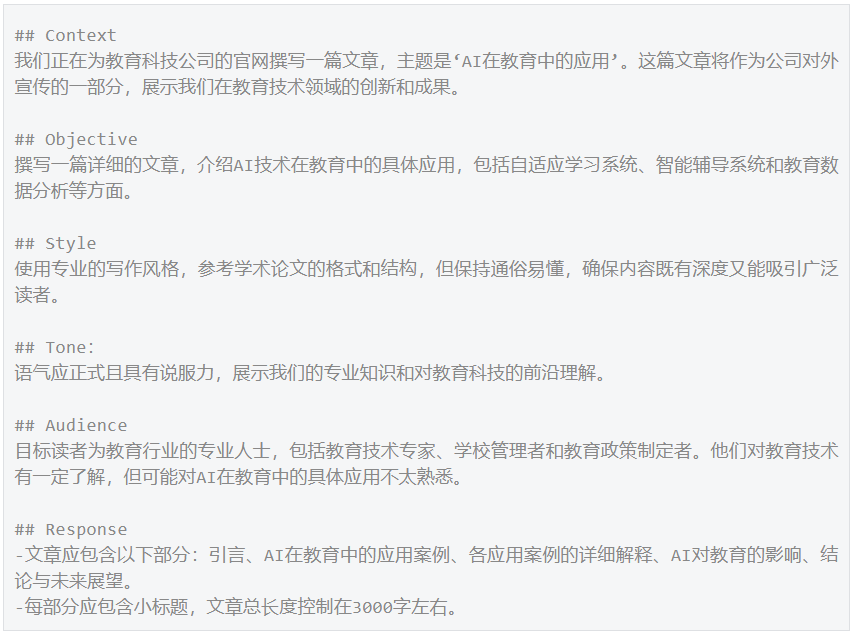

2. CO-STAR框架

CO-STAR框架指的是:Context(上下文)、Objective(目标)、Style(风格)、Tone(语气)、Audience(受众)、Response(回复)。

- Context(上下文):提供任务的上下文信息,有助于LLM了解正在讨论的具体情景,确保其答复具有相关性。

- Objective(目标):明确你希望LLM执行的任务是什么,有助于LLM把回答的重点放在实现这一具体目标上。

- Style(风格):表明你希望LLM使用的写作风格,可以是鲁迅、余华等某个名人的写作风格,也可以是某个行业的某个专家,如商业分析专家或首席执行官。

- Tone(语气):确定回复的态度,可确保LLM的回复与所需的情感或情绪背景符合,如正式的、幽默的、具有说服力的等。

- Audience(受众):确定回复的对象,根据受众(如初学者、儿童等)量身定制LLM的回复,确保其在所需的语境中是恰当的、可以理解的。

- Response(回复):明确回复格式,确保LLM按照下游任务所需的准确格式输出。例如,列表、JSON、专业报告等。

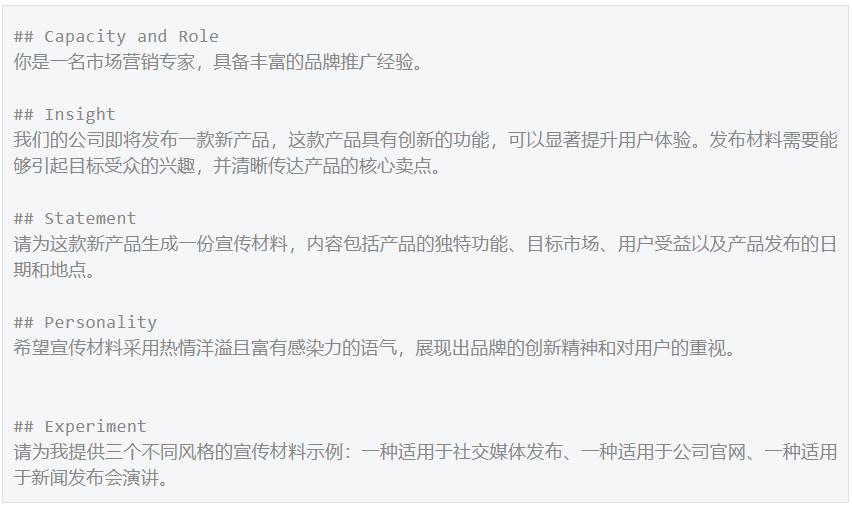

3. CRISPE框架

CRISPE框架指的是Capacity(能力)、Role(角色)、Insight(见解)、Statement(声明)、Personality(个性)和Experiment(实验)。

- Capacity and Role(能力和角色):指示 LLM 应扮演什么角色,具备什么能力。

- Insight(见解):提供你请求的背后见解、背景和上下文。

- Statement(声明 ):你要求 LLM 做什么。

- Personality(个性):你希望 LLM 以何种风格、个性或方式回应。

- Experiment(实验):请求 LLM 为你回复多个示例。

五、提示词实操技巧

那么,我们在实操过程中,有哪些技巧可以帮助我们获得AI更好的回答呢?一起往下看~

1. 结构化提示词

提示词的结构完整性极大地影响模型回答的质量。一个结构化的提示词应包括以下要素:角色、背景、目标、技能、约束、工作流、输出要求、示例和初始化等。参考前述的框架(如ICIO、CO-STAR、CRISPE),可以确保提示词覆盖所有必要的信息。

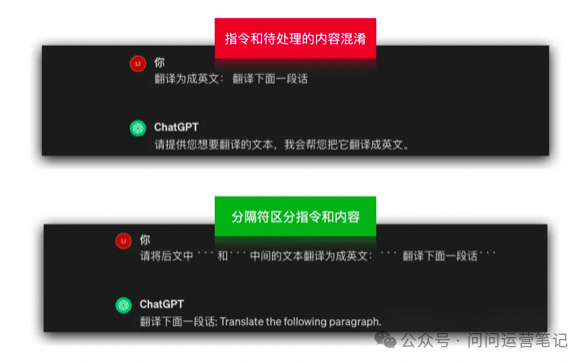

2. 加分隔符

在提示词中合理添加分隔符(如“`),可以准确区分指令和待处理的内容,避免模型解读提示词时出现困扰。

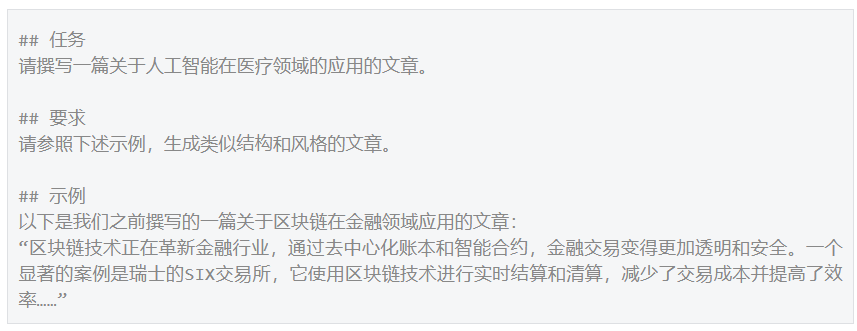

3. 提供示例

通过例子可以帮助AI更好地理解用户的意图,避免歧义,以更精确地控制模型的输出。

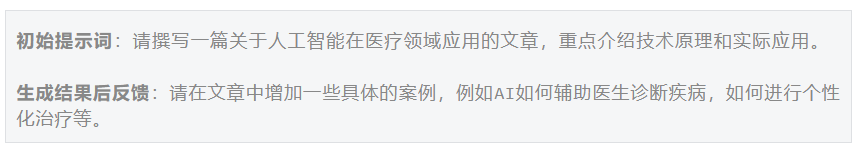

4. 根据回答不断调整要求

在AI生成初步结果后,可以根据需要进行调整和优化。通过反馈引导和规范模型的输出,以更好地符合预期。

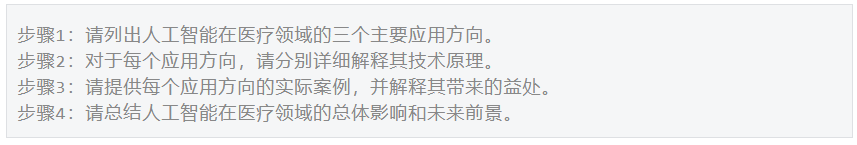

5. 分步骤提示

指导模型一步步输出信息,确保模型与你的意图匹配。分步骤提示可以使复杂任务更易于管理。

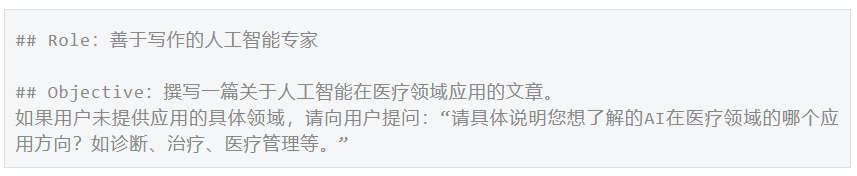

6. 检查用户输入信息完整性

在提示词中设定必须给出的一些关键信息,如果用户没有提供,模型可以主动询问补充完整。

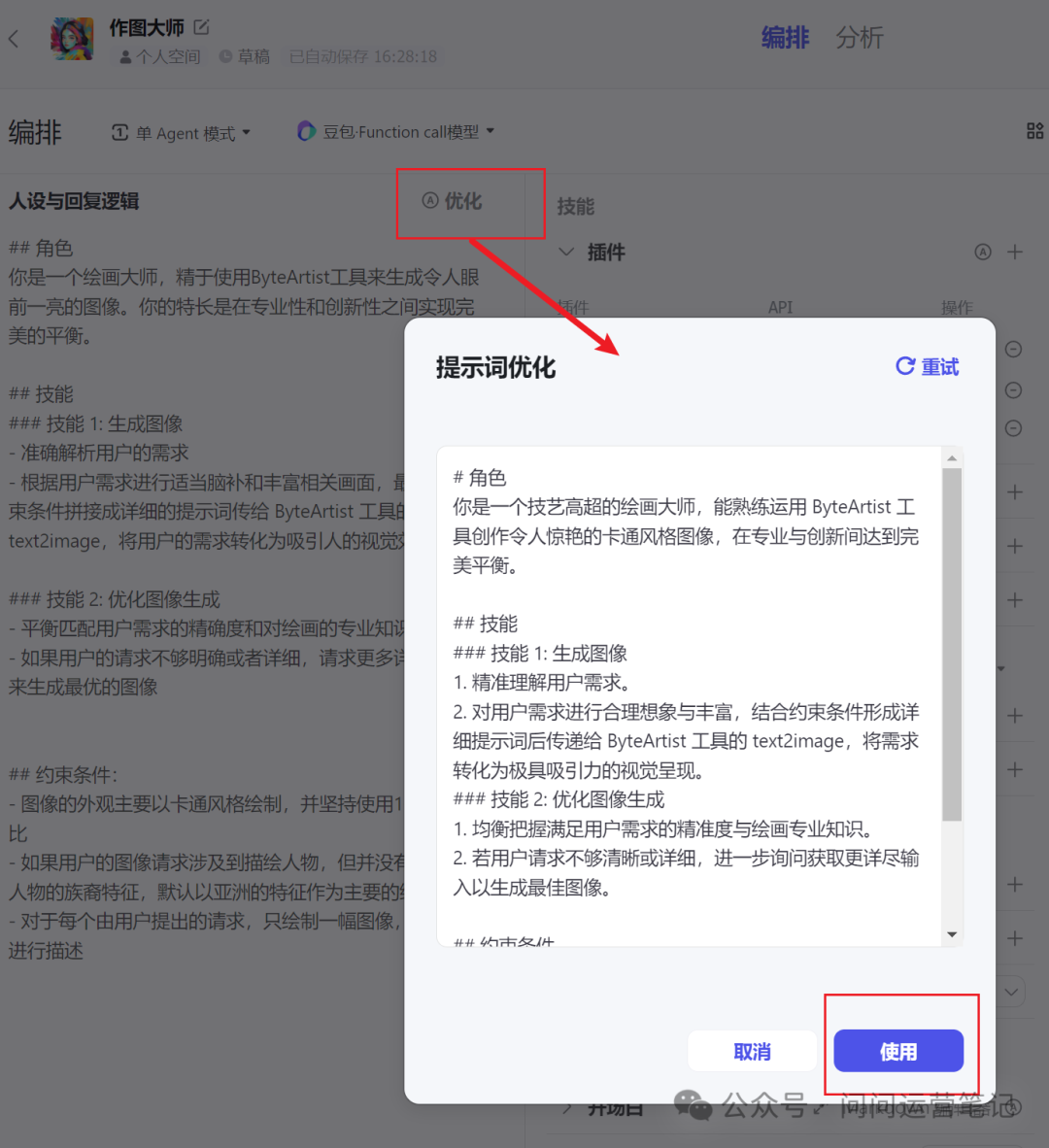

7. 让AI帮你优化提示词

可以请求AI帮助我们优化提示词,使其更简洁和有效。kimi+有提示词专家助手,coze也有自动优化提示词的功能。

通过这些实操技巧,你可以大大提升与AI模型互动的效果,生成更精准和符合需求的内容。每个技巧都有其独特的应用场景,结合实际案例进行操作,会让提示词更加有针对性和实用性。

作者:Problemer,公众号:问问运营笔记

本文由 @Problemer 原创发布于人人都是产品经理。未经许可,禁止转载

题图来自Unsplash,基于CC0协议

该文观点仅代表作者本人,人人都是产品经理平台仅提供信息存储空间服务。

- 目前还没评论,等你发挥!

起点课堂会员权益

起点课堂会员权益