在企业内部落地大模型效果好吗?——我们该怎么做

大模型赛道现在发展如火如荼,但大家都是在卷价格,卷应用,关于场景的讨论较少。这篇文章,我们来看看大模型在行业内、企业内,正在发生的变化。

每一次新技术的到来,都引得各家蜂拥而上。大模型的热浪,烧到了全球每个角落。在底层大模型、及应用架构探索方面,美国遥遥领先。在应用层面上,中国会像互联网、移动互联网一样,取得百家争鸣甚至赶超欧美的盛况吗,大概率会,但尚需多少时日,暂不得而知。但有一点是明确的,敢于尝鲜的猎人,已经出发……下面就让我们来看看,在行业内、企业内,正在发生的变化。

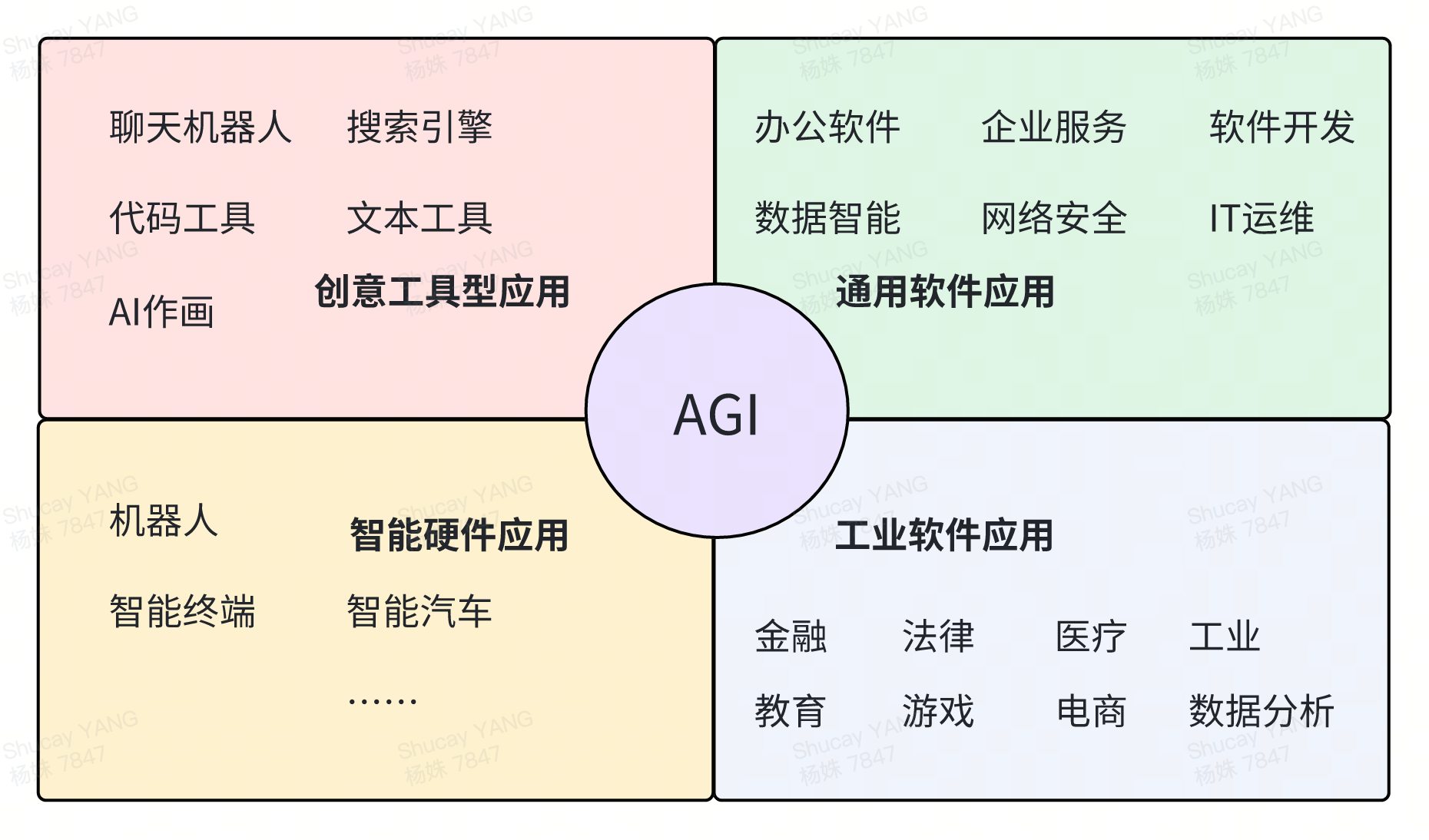

一、生成式AI应用方向

生成式AI应用可以分为四大类,每个领域都在思考,这次变革对当下的工作、生活会带来什么样的变化,要怎么做才能登上“甲板”~

二、引入大模型,我们的工作会发生什么变化?

下面,用一张图推演下,当有了AI的协助,我们的工作状态会发生怎样的变化……

Copilot跟Agent的区别,笔者认为,copilot更多的依赖人类的大脑。Agent相比之下,有更高的自主性。所以,在“教-学”的环节,笔者用了Copilot这个词。

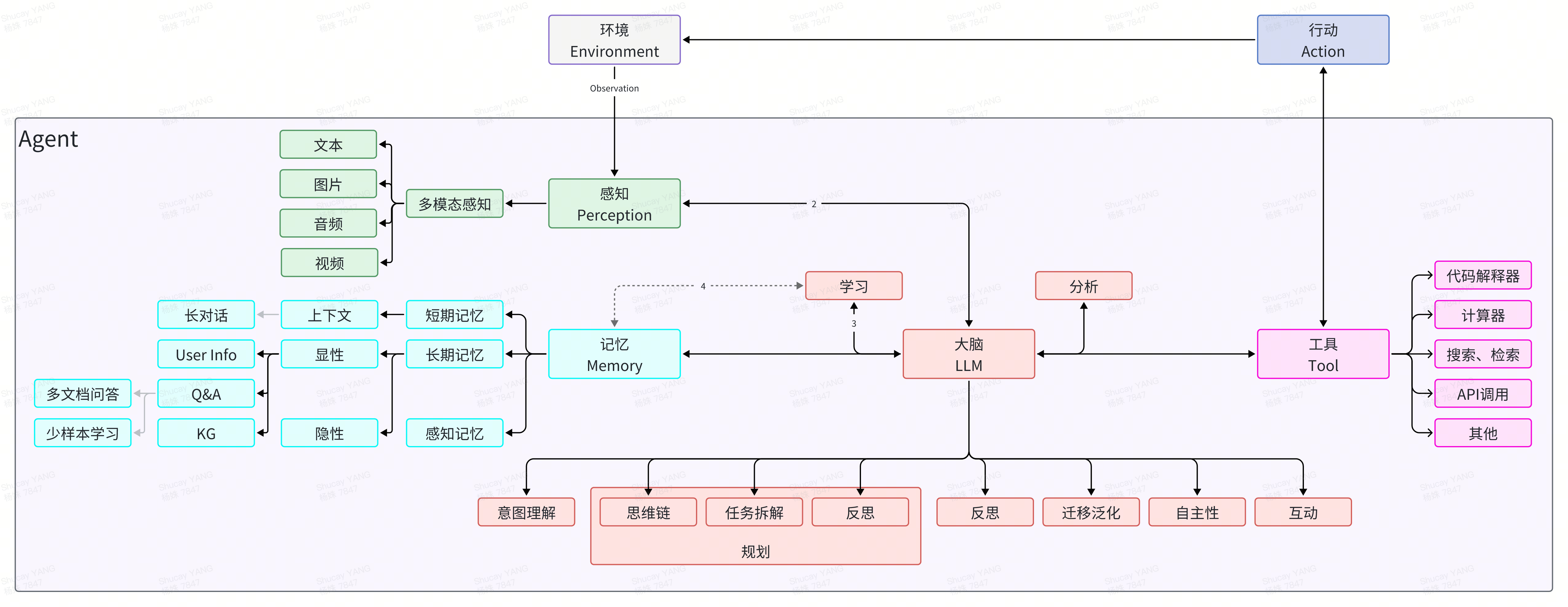

三、Agent架构为大模型加配了四件套

Agent(智能体)是一种能够感知环境、进行决策和执行动作的智能实体(感知、记忆、工具、行动)。不同于传统的人工智能,Agent具备通过独立思考、调用工具去逐步完成给定目标的能力。在有LLM作为其大脑之后,Agent更是具备了对通用问题的自动化处理能力。

Agent架构赋予大型语言模型(如 LLM)一种解决问题的“策略性思维结构”。该框架模拟了人类处理问题的过程,实现群体智能的模拟与构建,即“规划、执行及反馈的智能决策循环”。该架构可以用来搭建,第一章节中提及的生成式AI的四个演进方向,根据领域or场景的差异,有些做到copilot即可,有些需要达成agent,多agent,甚至是AIGC。自23年6月首次提出以来,已经有海量的资讯专门探讨、介绍AI Agent,在此不多着墨。

在该资料基础上扩充https://zhuanlan.zhihu.com/p/666913254

四、让大模型发挥作用,“模型”本身的能力、实现Agent的“架构”、“人”三者都很重要

LLM是集合了人类的智慧,通过自然语言交互可以给你答案,但是要想让这个“智脑”切实的帮助你,需要跟他交互的“人”的智慧,也需要“让大脑联合手脚(Agent)”的工程框架的能力。

4.1 如何高效、低成本的搭建Agent?

AI Agent是高度可训练的,像新员工入职时一样需要培训。需要从业务场景->Agent能力->平台功能->技术支持的一连串的推导,只有把SOP提炼、总结的足够精准和细致化,才更有利于one by one的去搭建、调优。

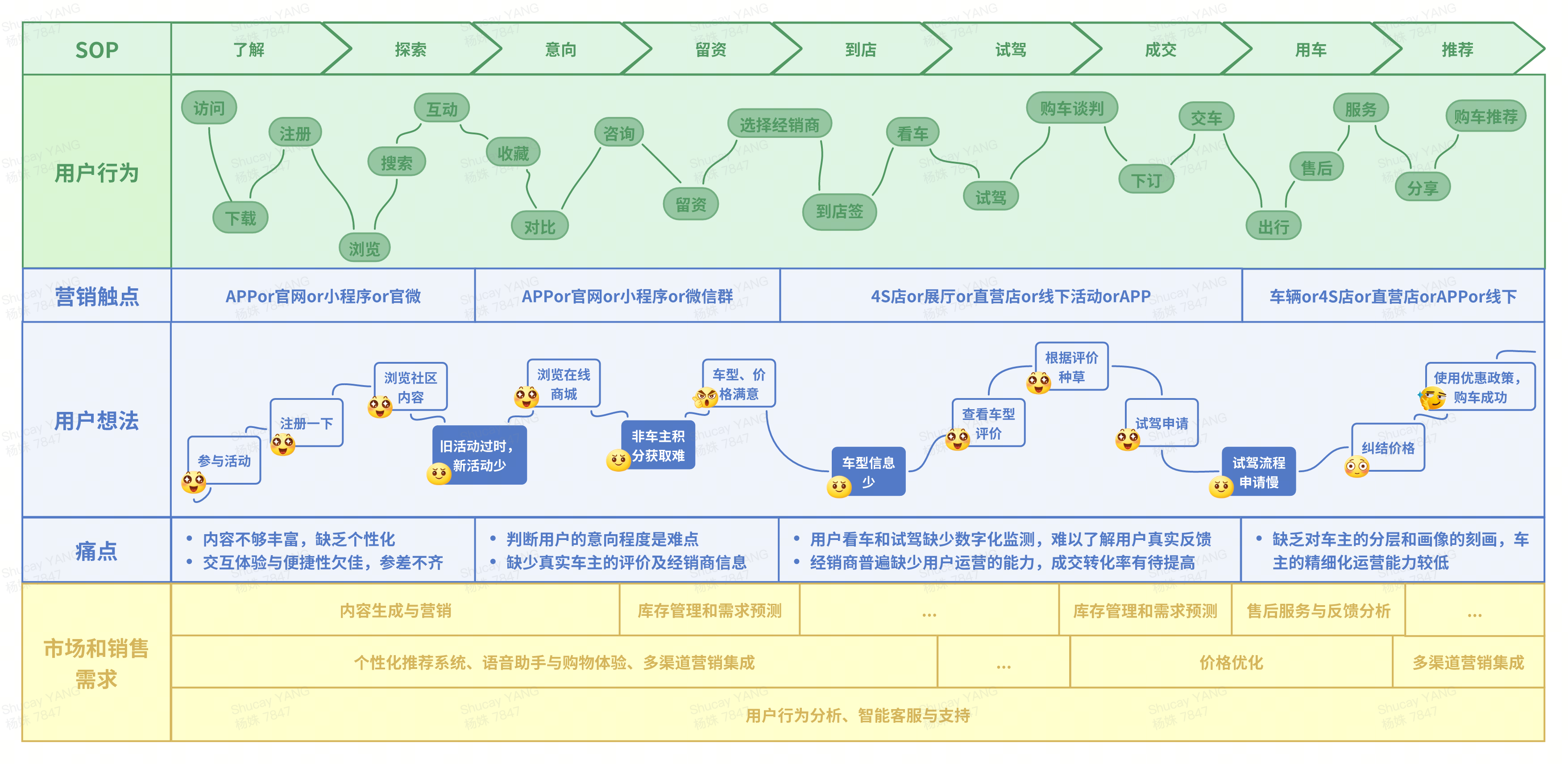

4.2 分析业务场景SOP定位需求为搭建Agent做好准备

以汽车销售场景为例,从最开始的了解到推荐,历经9个步骤。每个步骤中,都有关键用户行为合计22项。对各个营销触点,用户有各自的感受,有评价,有诉求(痛点)。对应的,企业内部对应的在这些环节上,形成了具体的需求,希望借助大模型的能力,可以为整体链路提效、提升用户体验和满意度。

引用自:神策数据出品的“汽车行业CJO解决方案”

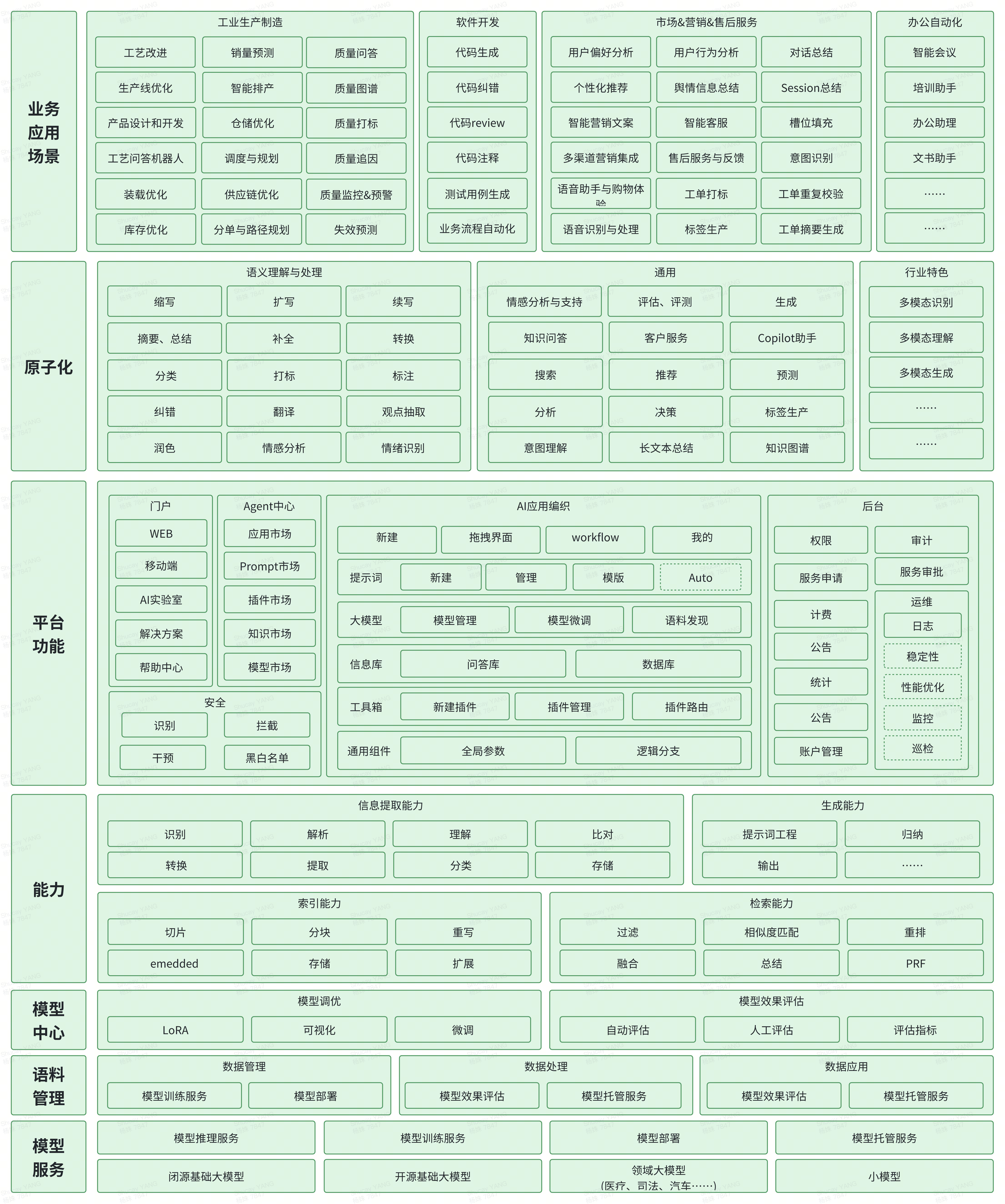

4.3 应用场景->原子化->产品->技术能力->模型->服务

其一,抽象通用原子化能力,以复用,可以是agent,可以是插件,可以是信息库~。这些原子化的组件可以快速组装到业务所需要的大Agent中,类似N多个原子化的agent组成了MultiAgent。

其二,抽象特异性能力,以满足特殊业务场景需要

五、如何搭建Agent?

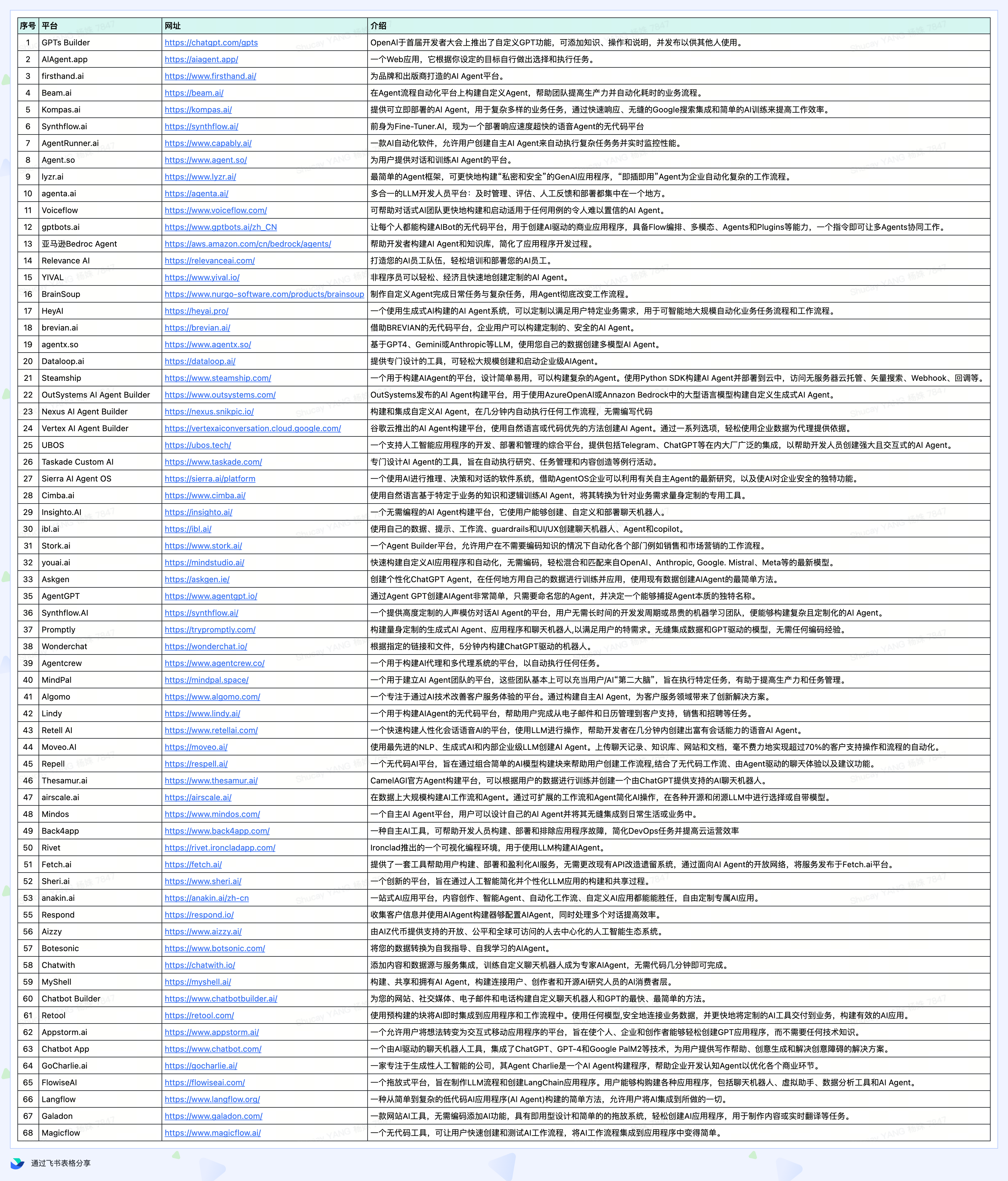

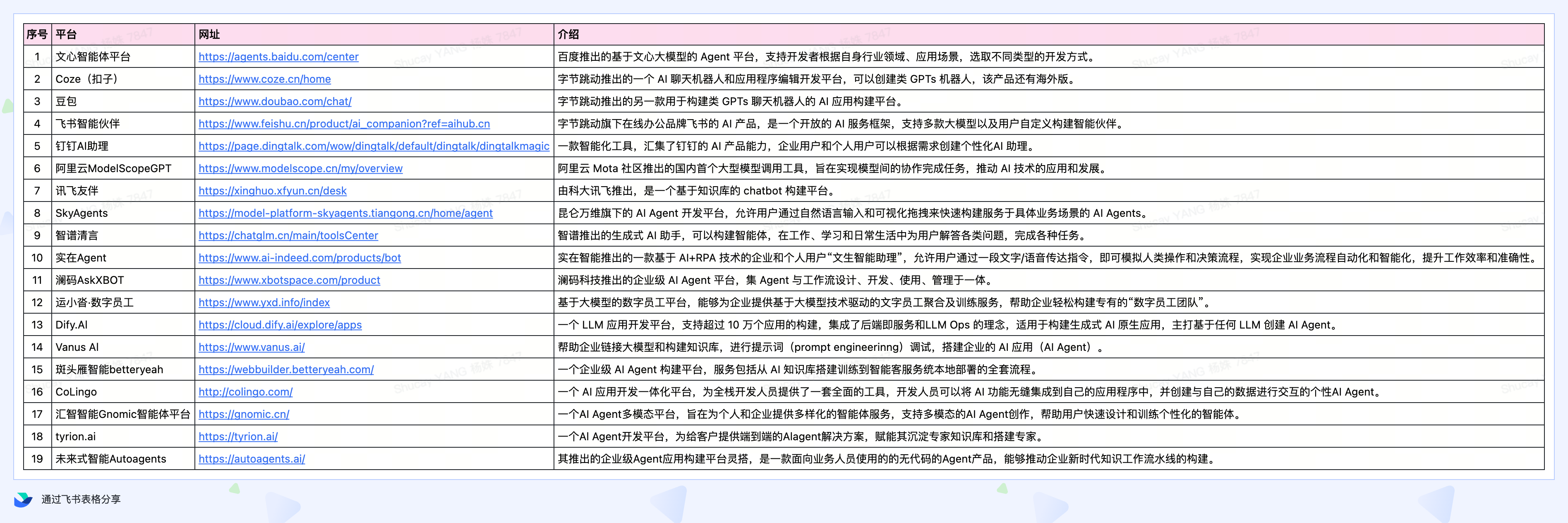

目前,比较敏捷的方式,是通过“智能体搭建平台”来实现。我们调研行业相关平台工具,整理如下:

5.1、海外AI Agent构建平台

5.2 国内AI Agent搭建平台

六、想落地效果好,还有很长的路要走

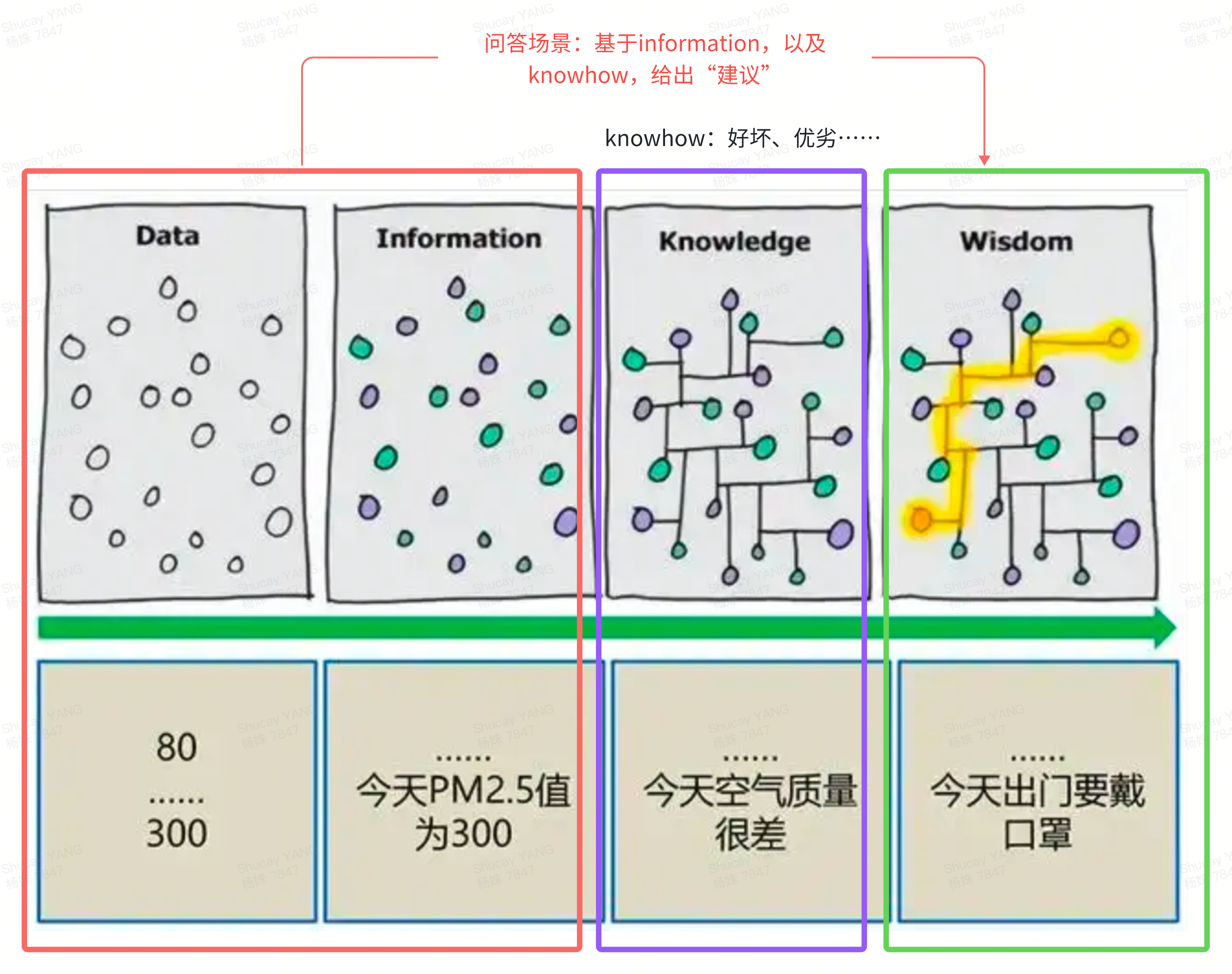

6.1、跟大模型的交互,给大模型投喂的“信息”很重要

大模型被认为可以达到本科毕业生同等的认知能力,因此,当大模型具备领域知识时,可以不依赖knowledge,可以从information到wisdom。大模型的推理能力很强,但推理的效果,要依赖“信息”。这好比大模型是土地,长出什么庄稼,要看喂给它的“种子”,“准确的、结构化的”信息or知识,便于让大模型懂。

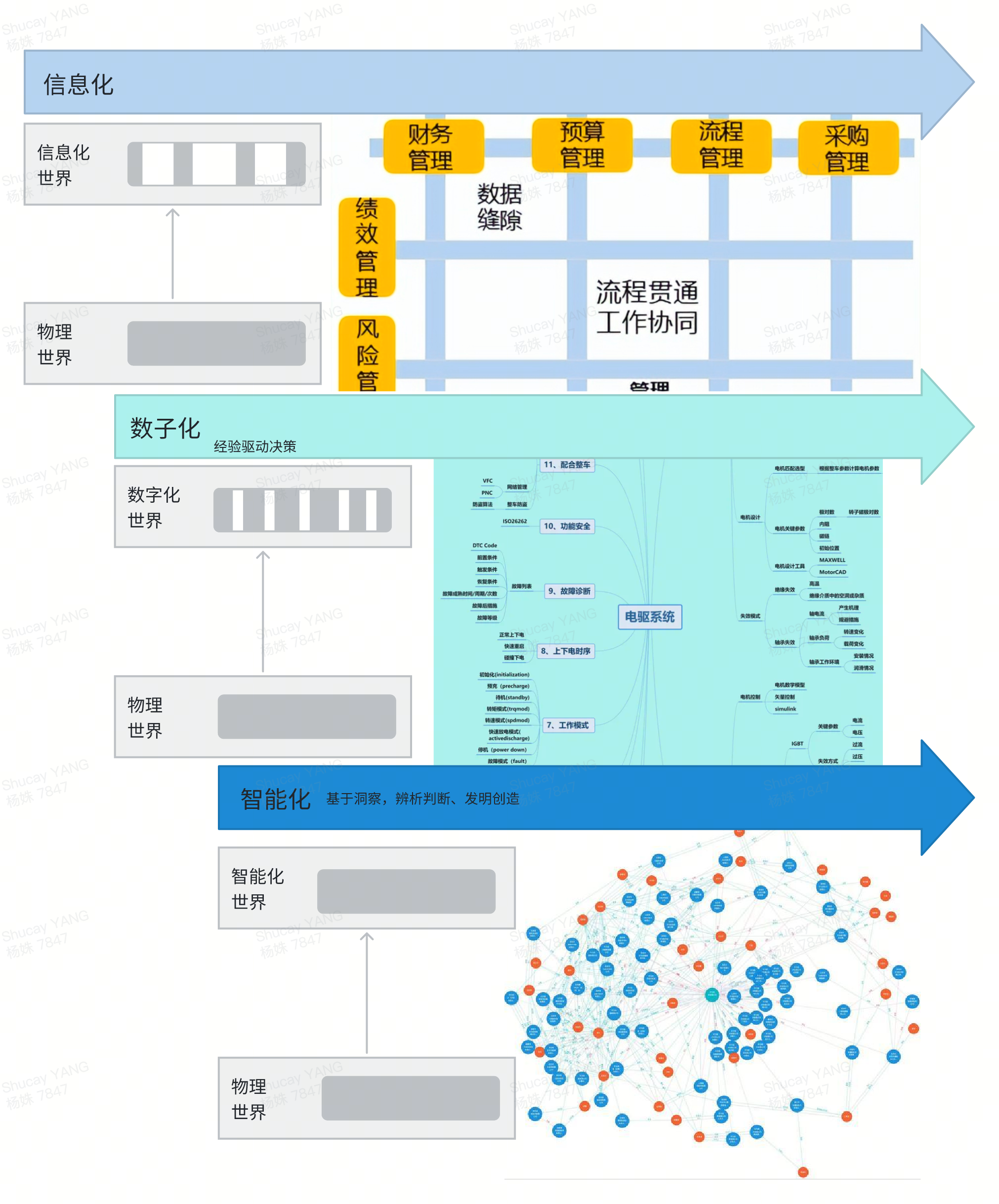

- 数据加工成信息的途径:数据+定义和格式+时间范围和相关性=>信息

- 信息提炼成知识的途径:信息+假设+关系+模式和趋势=>知识

- 知识变成智慧的途径:知识+管理(收集、加工、应用、传播)+深刻认识(洞察、判断)+远见(预测)=>wisdom,越接近智能化 ,对物理世界的还原越接近“真相”

6.2 在安全的范围内使用、触碰“信息or知识”

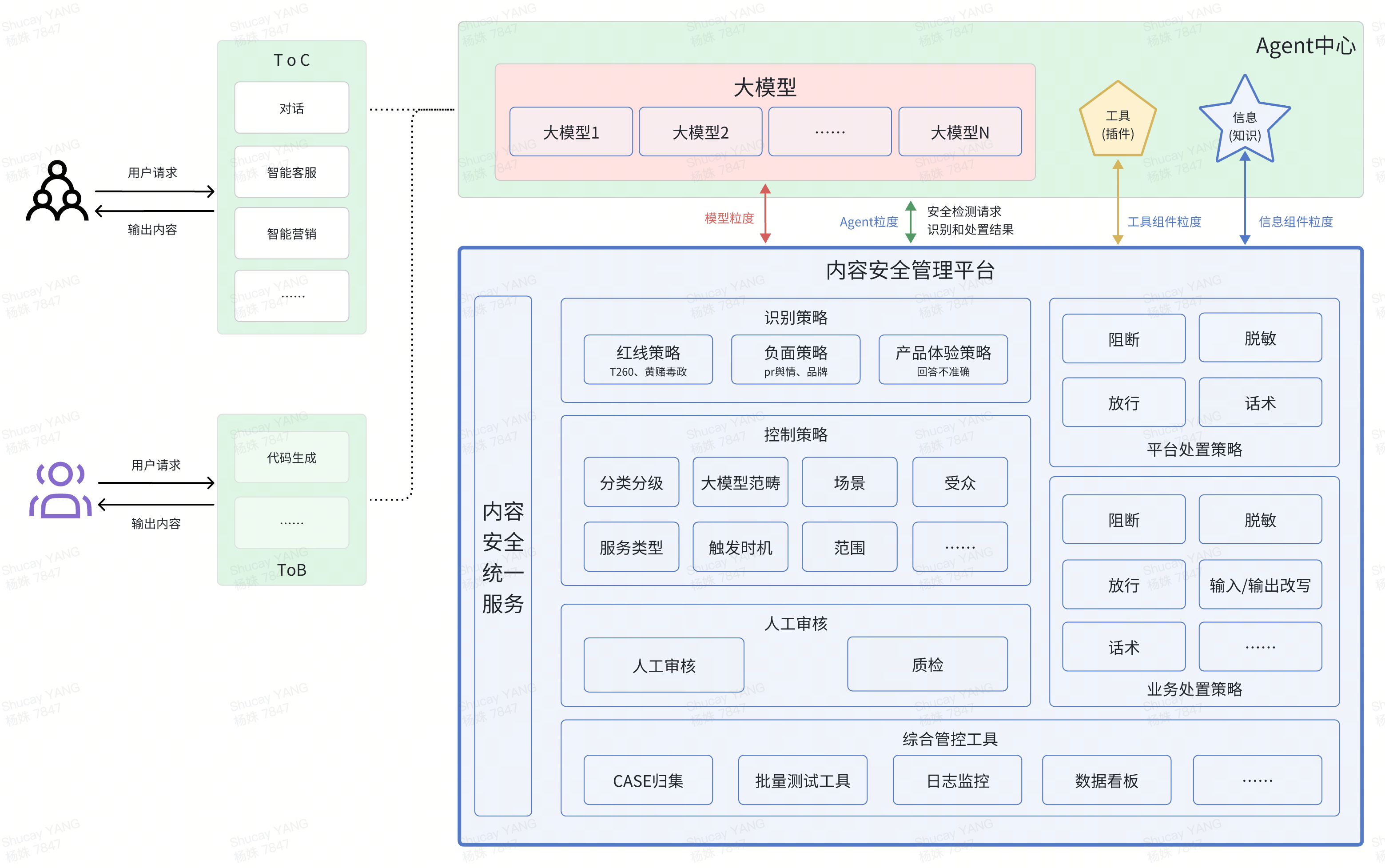

大模型的能力,对信息的安全使用、合法“生成”、合规“触碰”提出了更高的要求。识别和拦截的维度可以有多种,可是模型粒度的、Agent粒度的,也可以是基础元素粒度的(插件、信息),具体根据业务需要去设置。

6.3 怎么提问,有门道?

跟大模型的交互,一般是通过prompt工程来实现的,如何问,是非常重要的。行业内已经有很多关于如何写prompt工程的文章(角色扮演、零样本提示、 少样本提示),不再赘述。

这里,提醒应该充分发挥大模型的优势能力——COT(Chain of Thought)能力。即大模型在解决问题时能够展示其思考过程的能力。这种能力使得模型能够像人类一样,通过一系列逻辑推理步骤来解决复杂问题,而不仅仅是简单地输出一个答案。COT能够帮助人们理解模型是如何得出某个结论的,从而提高模型的透明度和可信度。

例如,假设我们要求大模型解决一个数学问题:

问题:一个直角三角形的两条直角边分别为3和4,求斜边的长度。

具有COT能力的大模型可能会这样展示其思考过程:

理解问题:首先,我需要理解这是一个关于直角三角形的问题,且已知两条直角边的长度。

应用知识:我知道根据勾股定理,直角三角形的斜边(c)的长度可以通过公式 𝑐=𝑎2+𝑏2c=a2+b2 来计算,其中a和b是两条直角边的长度。

代入数值:在这个例子中,a=3,b=4。所以我将这些数值代入公式中:𝑐=32+42c=32+42。

计算:计算各项的平方,得到 𝑐=9+16c=9+16。

求和:将平方相加,得到 𝑐=25c=25。

开方:计算平方根,得到 𝑐=5c=5。

得出结论:所以,这个直角三角形的斜边长度是5。

通过这种逐步展示思考过程的方式,COT能力不仅帮助用户理解模型是如何得出答案的,还可以在教育、解释复杂概念或决策过程时提供帮助。

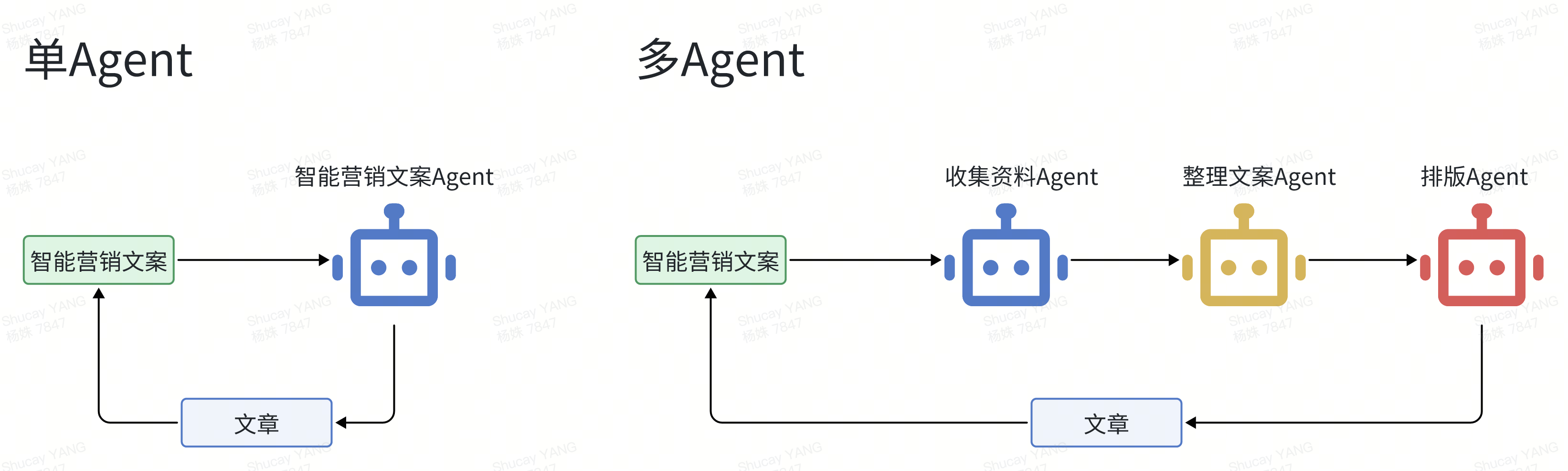

6.4 将任务拆细以多Agent协作模式推进,比单Agent集合任务效果好

在面对复杂的任务挑战时,开发者可以通过细分任务并构建多个Agent来完成。这一多Agent架构赋予开发者集中精力打造具备单一而强大功能的AI应用程序的能力,而不是劳神费力地开发少数几个功能繁杂的GPT模型。

这种转向不仅极大地提升了AI应用的专业性与工作效率,而且为开发者开辟了更广阔的创新领域,加速了AI应用开发的多元化和个性化进程。

多Agent系统的出现还激发了对AI未来发展的新设想,比如实现不同Agent间的自主互动和层次化协作,从而逐渐减少对人工干预的依赖,向AGI更进一步。

6.5 其他可以提升Agent效果的途径?

在分析清楚、理清业务逻辑的基础上,在搭建Agent时,工程链路的设计和开发也至关重要。当业务场景需要跨出组织内部,联动外部生态时,生态系统的API开放能力和程度(即工具的完备度),也将影响Agent的效果。

底层大模型无时无刻的高速进化着,跟大模型对接的Agent,也会因这种变化而发生波动,在这场空中加油的竞赛中,需要找准路子,方向如果错了,越努力越遥远……,贴着行业动向打,或许是一条更“实际”的路线,让我们拭目以待!

关键词:Agent、GPT、生成式AI、AIGC、LLM、AGI、Prompt、插件、MultiAgent、Agentbuilder

受作者领域认知深度所限,且技术无时无刻不在更新迭代,无法在一篇中尽现全貌,能为大家带去一点点新的启发,以深感欣慰。文中难免有纰漏或不准确的地方,欢迎大家批评指正。若有任何建议或意见,欢迎联系作者探讨。

作者:shucay,佳琪,王丽、富玺、新远

本文由@shucay 授权发布于人人都是产品经理,未经许可,禁止转载

该文观点仅代表作者本人,人人都是产品经理平台仅提供信息存储空间服务。

- 目前还没评论,等你发挥!

起点课堂会员权益

起点课堂会员权益