数据是如何“骗”你的?聊聊数据分析可能遇到的坑

马克吐温:“世界上有三种谎言,分别是谎言、该死的谎言、和统计数字。”

数据是不是最客观?最真实?

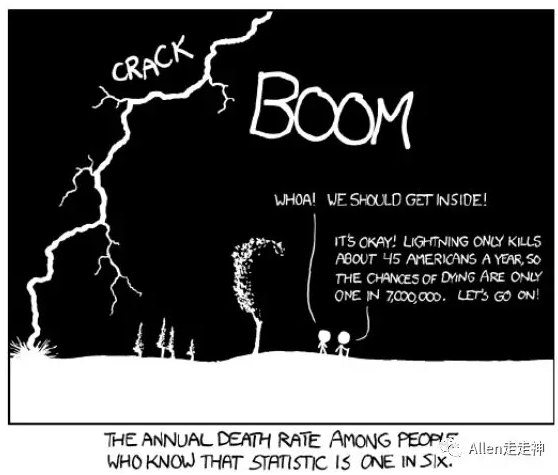

其实挺多人都有点迷信数据,因为数字不会说谎,考了100分就是比考了99分高。但现实生活远比考试复杂,我们每天主动或被动接触大量数据,可能是行业报告、媒体报道,也可能是产品广告,做决策的时候也往往要看到数据才安心。其实,数据很多时候并不那么“单纯”,用数据的人也有意无意会犯错,所以很多时候太过迷信数据,反而容易出问题。

所以今天从数据来源偏差、数据解读陷阱、人为操控误导这三方面来聊聊数据的“坑”,希望你看完后能了解些套路,再看报告或数据时多个心眼,带着怀疑的精神看数据。不要掉入陷阱,

一、数据来源偏差

1. 样本量和代表性

你可能听说过“黑巧克力能减肥”这个说法。2015年约翰波哈诺博士在一篇期刊上登出了这项研究成果,媒体记者们一看,呦,可以搞个新闻啊,把传统观念批判一下,纷纷转载。

但其实这个事件都是波哈诺杜撰出来的,他随便找了16个人做样本基数,然后就推导出这么个结论,目的就是想看看谣言怎么变成权威媒体的头条。研究发表后没有一个记者来联系他问他这个实验的样本量是多少、代表性怎么样、过程是否合理,直接就发表和引用了“研究成果”。直到现在,还有些自媒体或者微商们在拿这条假消息当论据。

我们为什么要关注样本量和样本代表性?

比如你要想知道年轻人对流量明星的态度,但是年轻人有好几亿,也不可能挨个问对吧。所以要抽样,抽出几百一千个人,用他们的态度去代表整体人群的态度。但是你找了800个小哥哥的粉丝,200个纯路人,得出来的结果肯定是好好好,棒棒棒啊。

所以,样本量和代表性是决定数据结果靠不靠谱的前提条件。

大厂们虽然看起来有“大”数据,但是由于数据孤岛的存在,其实数据也是有偏向的。比如阿里固然有淘宝几亿用户的消费数据,但是也拿不到这几亿用户的微信数据。而且大数据基本都是行为数据,和真实态度、心理预期等等态度数据还有有差别,再有就是用相关性推测因果也有不少坑。

第三方机构发布的数据报告,有些也号称是大数据,数据库里有几百几千万样本,但其实不是全集数据,多多少少也会有些偏向性。特别是在互联网行为、消费行为上,我个人感觉很多数据都是偏高的。

还有就是朋友圈问卷,最近有些同学在写论文收数据,在同学群和朋友圈发问卷当然会是比较省时省力的。但是因为答题的人背景都比较接近,所以回收回来的数据不做处理也会有些偏差,比如你想测一下某个产品定价,这个产品面向普通大众、中低产消费者,但是填问卷的都是你的研究生同学,大家收入和消费能力可能是比普通大众高一些的,收回来的定价结果可能就偏高了。所以在处理和解读时都得注意,万一最后影响论文答辩,还请去翟博士微博底下留言发泄。

针对这些问题,正规的调查是比较看重数据源的,会通过设置配额、分层抽样、分散抽样点位、小群体加权等等方式来尽可能消除偏差,让一两千样本能代表广泛人群。但是很多时候也办法尽善尽美,还是会有很多问题。其实统计数据的抽样误差是个很大的话题,感兴趣的话可以看看《简单统计学》《赤裸裸的统计学》,里面有挺多案例,而且门槛不高,不太需要数学功底。

作为非专业人士的我们,其实看报告或者看数据时主要还是留个心眼。看看有没有提到数据源,数据源可能带来哪种偏差,带着思考去看报告。如果看到一些数据结论和你的认知有差别、甚至是相反的,不用立刻相信结论,扭转认知,而是先想一想这数据来源靠谱嘛,发数据的机构有目的吗。另外,也不用太纠结于具体数字(因为大概率都是不准的),而是去看数字背后的趋势、比较、差异。

2. 问题缺陷

刚才我们也提到大数据更多是行为数据,有时要拿到态度数据,还是要靠用问卷问问题的方式。在用问卷收集数据时,如何问对问题就很有讲究了。

特别是有些机构或商家,为了得到自己想要的数据“证据”,会故意问有偏向的问题。也有些时候是写问题的人没有好好站在被访者的角度去思考和设计问题,结果费了半天力,拿到的数据其实是无效的。比如这几种情况:

(1)正面诱导

曾经有个某饮料品牌打算推出新口味的饮品,推出前心里没底,就做调查。他们问了一个问题“我们要推出一款口味更柔和的新产品,你会喜欢吗?”

数据收集回来以后,发现喜欢的比例高达90%,品牌商看到这么乐观的结果,立刻就投入开发和推广,结果新品上市以后,消费者恶评如潮。现实和数据体现了如此大的反差,原因就在于问题中有一个很明显的正面诱导词“更柔和”。

(2)社会期许

还有一种情况,虽然问题中没有明显的正面诱导词,但是人人都是有点虚荣心的。人们更倾向于向他人展现正面形象,所以在回答问题时,更倾向于申报“良好行为”来符合社会的期望。即使在匿名的环境下,人们也倾向于把答案往正面靠。

比如“你在公共场合抽烟的频率如何?”这样的问题很多人填的就比实际低。“你帮助别人的意愿有多强?”这样的问题很多人填的就比实际高。

(3)选项设限

这种情况就是设置问题的人可能站在自己的角度编制选项,但是被访者看了选项后就没办法回答。比如调查是问“你平时锻炼的频率是怎么样的”,然后能选项有“A 从不”,“B 每周不到30分钟”,“C 每天30分钟”,如果你每周锻炼30分钟要选哪个,另外每个人对锻炼定义也也不同(遛狗算不算锻炼?)。这样的问题可能会让被访者被迫选一个不准确的答案,最后得到的结果自然也有偏差。

其实问错问题和设错选项并不少见,也不只有这三种情况。所以无论是看别人的数据报告,还是自己做问卷,都得注意问的问题是不是客观无偏向,选项是不是合理。选项一般来说要尽可能符合MECE原则(Mutually Exclusive Collectively Exhaustive,互相独立,完全穷尽)。

二、数据解读陷阱

数据解读可以说是遍地是坑,这里我选了比较常见和有意思的几种。

1. 相关不等于因果

相关和因果是解读数据绕不开的话题。特别是我们要用数据去预测趋势,解决问题,用一件事的情况去推测和判断另一件事,搞混相关和因果,就容易闹笑话。

比如你可能听过这个段子:

国内某航母级互联网影业的发言人说:“通过大数据挖掘,我们完全可以发现不同观众的相关卖品偏好。比如电影《芳华》的观众比《战狼2》的观众消费了更多的热饮,这都是我们以前从来不知道的东西!”

或者,每年冰淇淋销量一升高,游泳溺亡人数就开始增长。所以禁止销售冰淇淋,有助于挽救生命。

其实,事件A和事件B有相关关系,有可能有好几种原因:

- 事件A引起了事件B;

- 事件B引起了事件A;

- 事件A、B其实八竿子打不着,但是事件C会引起A,也会引起B;

- 事件A、B真的没什么关系,只是刚好凑巧数据有相关性。

你看,基本把话说全了,可能有因果关系也可能没有因果关系。这个道理说起来简单,好像人人也都知道,但是很多时候,甚至经验丰富的分析人员也会在这上面犯错。

其实很多时候我们都是带着期待,带着目的在看数据,我们希望数据能告诉我们真相,给我们解答,告诉我们为什么,好让我们做出决策。所以看到两条曲线趋势有规律,看到两组数据有相关,就会开始兴奋,感觉自己好像抓到了答案,但这时候就往往容易过渡解读。

数据只是数据而已,所谓答案其实不是数据告诉你的,而是你自己推出来的。越是这时候就越应该冷静一下,多思考,不要轻易下判断。

2. 幸存者偏差

还有一个特别有名的误读,你可能也听说过,就是大名鼎鼎的幸存者偏差。就算没听过这个理论,可能也听过诸如“我好几个朋友小学没毕业最后都当大老板了。所以你上了大学也没什么用,也是给我兄弟们打工。”之类的言论。

幸存者偏差是怎么来的呢?

二战期间,美军计划在飞机上安装厚钢板来抵抗攻击,提升飞行员生存率。但是因为重量限制,只能给最关键的部位安装。他们仔细检查了所有返航回来的飞机机身上的弹孔分布,发现大部分都位于机翼和飞机尾部。于是大家就热火朝天准备给机翼加钢板。

但是这时候,数学家瓦尔德(Abraham Wald)就站出来反对,他说要加强那些没弹孔的位置,比如发动机和驾驶舱。你猜为什么?反正最后的事实证明,是瓦尔德拯救了无数飞行员。

当你看到数据给了你一个结论的时候,其实可以先想一想,这个数据的基数代表了什么,和你预期的是不是一样。

是“飞机大多会在机翼中弹而发动机没中弹”,还是“能活下来的飞机大多会在机翼中弹而发动机没中弹”?

3. 自选择偏差

耶鲁大学教授加里史密斯说:“人类在漫长的进化岁月中,产生了寻找模式并对其做出解释的内在倾向。”

这句话我也是看了会才看明白想说啥。

简单来说,就是有时我们自以为找到了支持自己想法的客观数据,但其实我们是先有了想法,再找数据来支持自己的想法,那些不符合我们所想的数据有意无意被忽视或者回避掉了。最后得到的一切看似逻辑完美、无懈可击,但自己早就掉进自己的挖的坑里。这就是“选择偏差”。

克里斯坦森也提到过一种数据确认谬误。

数据有一个讨厌的特质,就是能帮我们自圆其说,支持我们想要的观点。公司里每个团队都有自己小心构建的数据结果,通过其功能职责、绩效指标,构建出一个现实的模型,但其实这里面的数据都是精挑细选能自圆其说的。大家一起自欺欺人,相信自己有多客观。领导者似乎通过拿A或B做比较才做出决策,但是实际上,在通向A的过程中,数据也越来越偏向A。领导者以为自己是根据明确数据做的决策,其实内心早就心有所属了。

还有一个描述投资人心态偏差的BSV模型,其中一条是选择性偏差(representative bias),也是在讲投资人被市场短期表现和数据扭曲认知,结果对总体趋势形成误判。

这方面的研究还挺多的,总而言之,就是自我反思。你是根据数据有的想法,还是根据想法选的数据。说起来简单,做起来还是很难的。

4. 辛普森悖论

这个就比较神奇了,我们还是先看个故事:

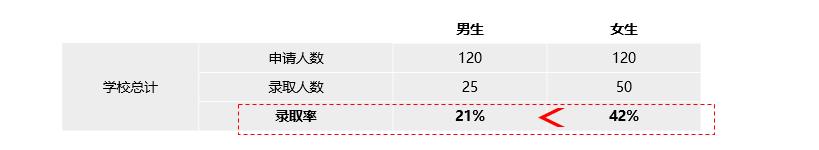

话说有个综合大学招生,结果招生数据一公布,男拳师们纷纷表示炸了,“怎么女生录取率这么高,看了数据的我气得浑身发抖,大热天的全身冷汗,手脚冰凉,这个世界怎么了,到处充斥着对男性的压迫……”

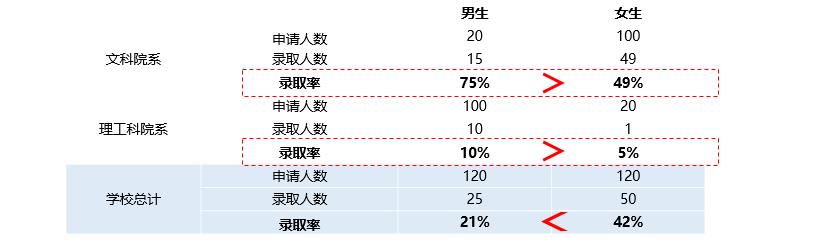

校长也害怕拳师们打拳啊,赶紧招来秘书,“你怎么搞的,不是说了要照顾下多招男生嘛”,秘书也是一脸懵,没错啊,文科院和理工科院都是男生录取率高啊。

你看,明明两类院系都是男生录取率高,但是一加起来,就变成女生录取率高了。其实是文科院的女生录取率拉高了女生整体录取率,而理工科的男生录取率拉低了男生整体录取率。

这就是辛普森悖论,两组数据分别看时都满足某种结果/趋势,但加起来就呈现相反结果/趋势。

所以如何对待整体数据?分组数据是不是应该简单相加就可以得到整体数据?

我个人感觉对待整体数据还是要谨慎,有时整体数据过于浓缩,会将各组的差异在合并过程中消除掉。所以很多时候即使有了整体数据,也还是要再细分细看。

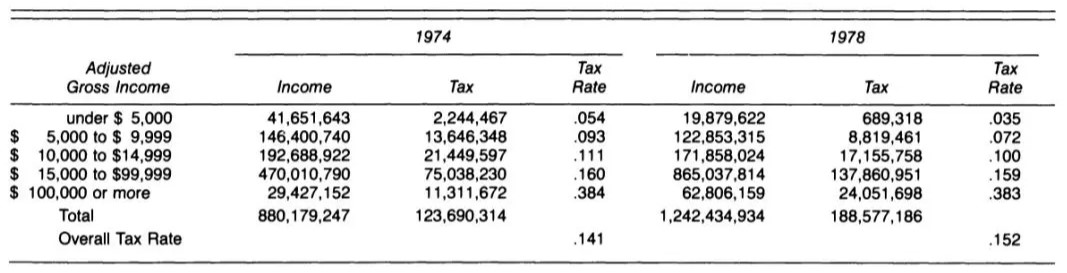

辛普森悖论还有一些妙用,比如收税。1974年美国总统福特宣布给各个群体都降降税,大家一起搞发展嘛,结果一通神奇的操作之后,总税收率反而增加了……妙啊。

万恶的资本主义,那届群众真不行。

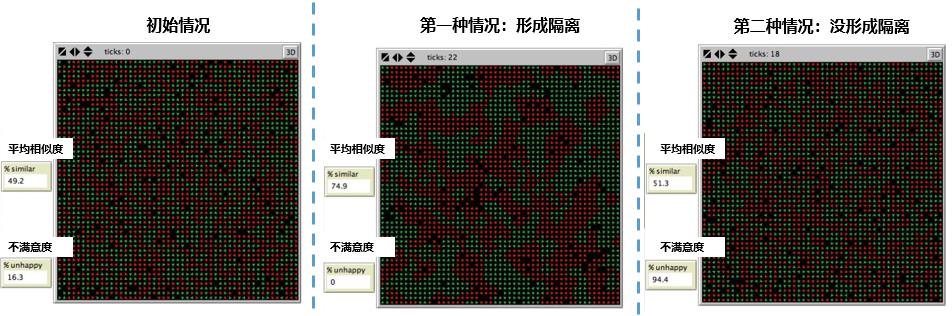

类似的还有谢林(Thomas Schelling)的隔离模型:首先在模型里设定一个有2500人口的区域,人们随机分布位置,每个人一开始有49.2%和自己收入相当的邻居,只有16.3%的人不满意自己邻居收入。

然后谢林分别模拟了两种情况,观察模型里人群的流动(是否搬家):

- 第一种:每个人只希望身边30%的邻居和自己收入差不多,就能留在原地不搬家(微观态度上人们都很宽容,不希望形成收入隔离)。

- 第二种:每个人希望身边80%的邻居和自己收入差不多,不然就会搬家(微观态度上人们都很严格,希望形成收入隔离)。

结果第一种情况,不满意的人开始搬家,导致更多人搬家。经过一段时间后,模型最终稳定下来。结果,人们平均拥有74.9%的邻居和自己的收入水平相当,人人都满意了,并且形成了宏观上收入水平的隔离。

而第二种情况,大部分人都不满意,不停地搬家,人人都不满意,始终无法稳定,反而没有形成隔离。

这样证明了微观个体的行动和态度不一定导致同样宏观结果。

三、人为操作误导

前面讲的那些坑很多时候都是无意的。这部分就不太一样了,很多数据其实稍加修饰,就成了一个个陷阱。这里简单介绍几种小伎俩,常见于淘宝详情页,微商小广告,和忽悠傻领导。多学少上当,但是最好不要用在别人身上。

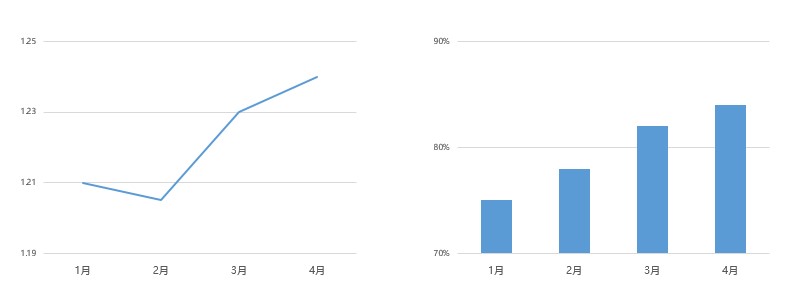

1. 放大尺度

比如你看下面这张图,是不是增长势头非常猛?要是当成业绩汇报给老板岂不是分分钟要升职加薪走上巅峰。

但其实注意Y轴,这种差异只是被人为的放大了,一旦回归正常尺度……

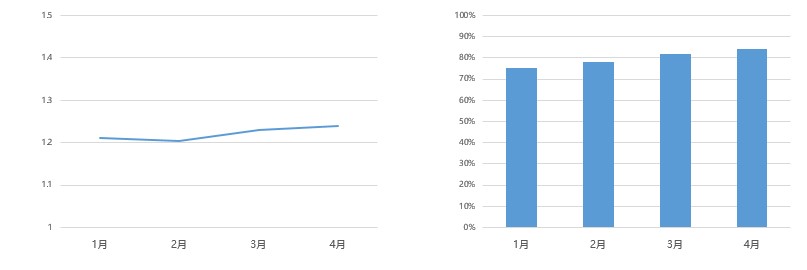

2. 提自己,不做对比。

这个在各类广告里就更常见了。

“我们面膜有效修复90%肌肤问题”,“友商都是95%。”

“我们的车百米加速时间只有7秒”,“同级别都是6秒。”

其实商业分析中也有类似的场景,比如购买A类产品的用户中80%都是甲类用户,是不是就应该给甲类用户推荐更多A类产品?这个结论乍一看没有问题,但是如果B类产品的用户中90%都是甲类用户呢?如果B类产品只有20%是甲类用户,但是B类产品基数远大于A类呢?

很多时候,数据还是要对比才有意义

3. 自定标准

只要你敢加的标签足够多,你就永远是名列前茅。虽然小明考试考了班里的40名,但是他在第四列所有身高1.7以上的学生中排第2,希望小明的爸爸听完能放过他。

所以再看到有广告声称自己产品排名怎么怎么样,可以想一想这排名是怎么排出来的。

4. 片面释放

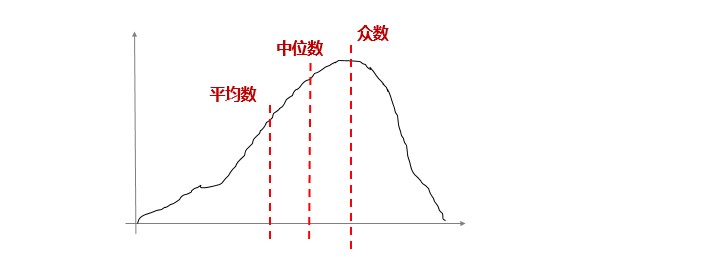

为什么每次平均收入一公布,大家都觉得自己拖后腿了?

其实数据分布情况不一样,平均数有时并不能描述“平均情况”。还有中位数、众数呢。

总而言之,数据也只是数据,它来帮助我们理解复杂世界中的庞大信息,但是不是万能的,是来帮我们解释,而不是替我们思考的,所以“尽信数据,还不如无数据”。

本文由 @Allen 原创发布于人人都是产品经理。未经许可,禁止转载

题图来自Unsplash,基于CC0协议

起点课堂会员权益

起点课堂会员权益

辛普森悖论和谢林隔离模型都很有意思,长知识了