如何使用A/A测试,让数据更准确?

什么比没数据可用更糟糕?虚假数据。

没有什么能像A/B测试一样给你信心并让你阔步向前;同样地,没什么能比虚假数据更快终结你的大步向前。为了进行正确的测试,你需要了解A/B测试的统计学;否则,你会花费很多时间试图获得答案而不是得到答案。最终,你会混淆你以为你有的答案,实际上你却什么都没有。A/A测试,将确保你得到的数据能用来自信地作出决定。

我们会给你介绍一种测试,如果成功它不会教你关于访客的情况,相反,它带来的要比原始数据更有价值,它会给你信心。

什么是A / A测试

在你对标题、副标题、配色、 CTA 、视频脚本、设计等进行测试之前,先测试软件本身。这很简单,通过测试网页自身就能实现。有人会认为这是毫无意义的,因为一个页面的相同页面将会有同样的结果,对吗?

并非如此。

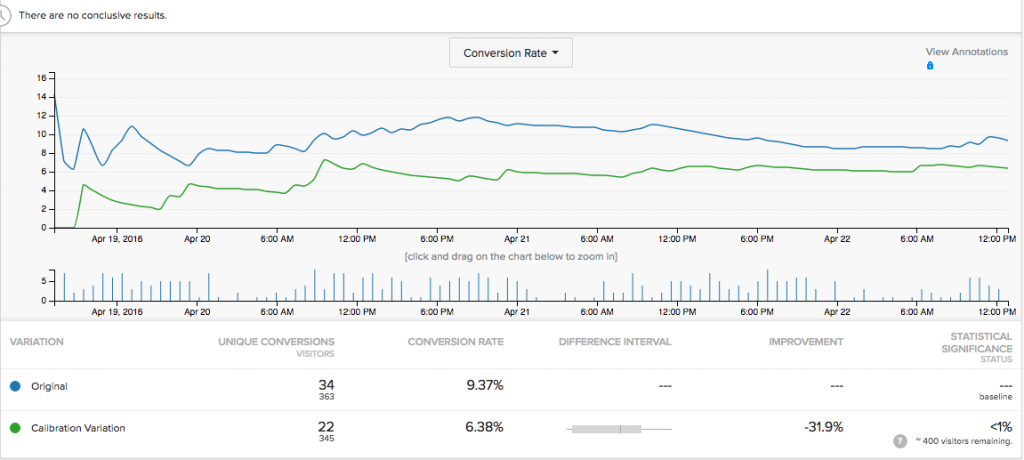

测试3天后,A/A测试表明,同样的变化校验版本与原始版本相比,少了35.7%的收入,这会是对增长的绞杀。

这个运行了3天的A/A测试没能带来任何信心的增长。

造成这一结果的原因可能有:

- 你正在使用的A/B测试工具出了故障;

- 通过你的网站所报告的数据是错误或重复的;

- A/A测试需要运行更长时间。

对这个问题的第一个线索是样本规模较小,虽然每个页面有超过345的访问量,但只有22/34笔交易。对一个大的因素来说,这个交易量太小。在A/B测试统计中,交易量比流量在建立统计信心上显得更重要。少于200笔的交易量通常带来无意义的结果。

显然,这种测试需要运行更长的时间。

你的第一直觉可能是通过快速A/A测试,这样你就能开展真正有趣的事情-A/B测试。但这是错的,上面告诉了你为什么。

用A/A测试来校准你的A/B测试工具

随着时间的推移,两个相同页面之间的差异若一直存在,我们会取消A/B测试计划直到我们找出这种差异的源头,到底是A/B测试工具还是网站本身的问题。我们也应重新测试来预先发现A/A测试存在的异常。

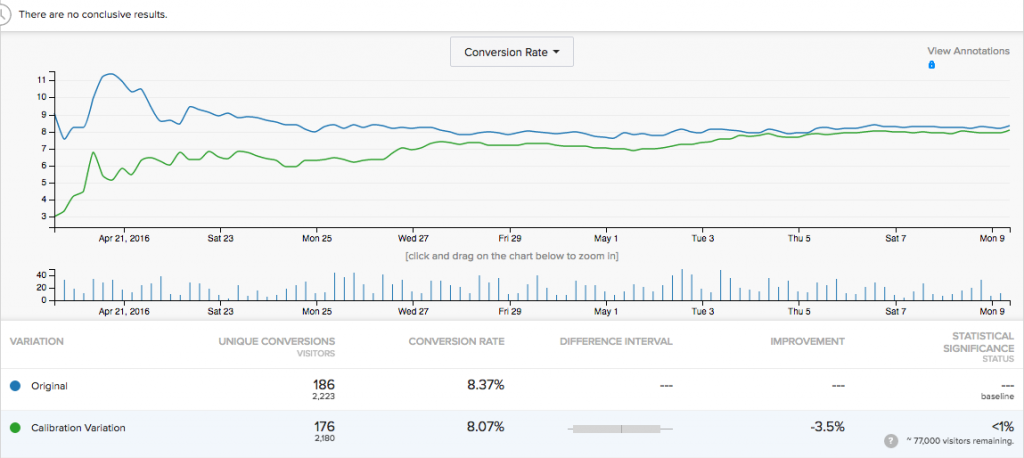

在这种情况下,较长时间的A/A测试能弥补样本数量的不足。在一次A/A试验中,3.5%的误差是可接受的,并且最小样本量需要保证有接近200的交易量,才可以开始评估结果。

这是统计显著和样本大小建立或摧毁信心的一个很好的教训。

一个A / A测试将告诉你,你的最小样本数量

A/A测试最终有效取决于足够的试验时间,合适的流量。不只是大量的流量,还需要合适的样本大小。

- 周一早上的顾客从统计上来看是跟周六晚上的顾客完全不同的两类人;

- 节假日的顾客与非节假日的顾客统计差异显著;

- 桌面顾客和移动端顾客统计差异显著;

- 工作中的顾客与居家的顾客不同;

- 付费广告渠道顾客与口碑推荐顾客不同。

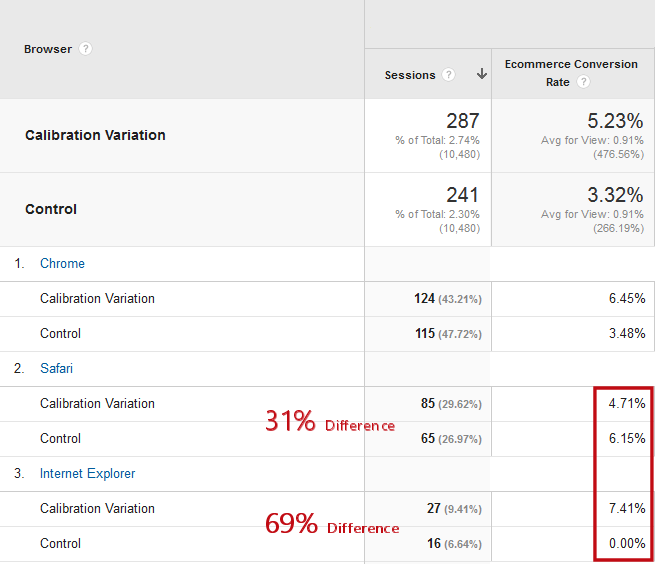

如果你深入挖掘你的数据结果诸如设备类型和浏览器版本,你会发现惊人的不同。当然,小样本下的结果是不可信的。这是因为小样本从总体上意味着可能存在分配不均的数据段。

下面是来自同一个A/A测试的数据样本。在这点上,对每个变量少于300次的会话进行了测试,你可以看到, 使用 Safari 浏览器的 Mac 访客存在分配不均,校验版本发生85次访问,控制版本发生了65次。记住,这两个版本是一样的,此外,在 IE 浏览器上甚至存在更大的差异,分别是27和16。

这种不均衡是平均的规律,考虑这种不均不是没有道理的,但是,我们期望能有更大的样本量。

不同的浏览器有不同的转化率

据统计,一个分配不均会导致不同的结果,即使所有的变化都是平等的。如果访问分配不均,那么那些准备转换的访客客也会分配不均,这将导致转化率的不同。

在上面的图中,我们看到。对于 Internet Explorer 浏览器的访客,全部的16个访客是没有转换的,然而校验组的访客却有7.41%的转化率。

在 Safari 下,相同数量的访客被分配到控制组和变量校验组,但到达控制组的只有65名访客,到达校验组的有85名访客,看起来控制组有更高的转化率。

但原因肯定不是因为有两个相同的页面。

随着时间的推移,我们预计大多数不一致会被拉平。那时,这些叠加起来就造成参差不齐的结果。

当你在A/B测试中测试不同的页面时,这些外力因素将会产生影响。如果样本量太小,你知道为什么你的A/B测试工具建议你继续错误的版本吗?

计算测试持续时间

在从不同的细分受众中收到足够大的样本量来确定你的那个版本的网页在受众面前表现更好前,你必须进行测试。A/A测试能证明其达到统计显著的时间。

A/B测试持续时间是两个因素的函数:

- 达到一个可接受的样本大小所需的时间;

- 变量之间的不同表现差异大小。

如果一个变量引起了50%的变化,测试就不必运行很长时间。大比分胜利,也被成为“战胜的机会”或“信心”,即使是在小样本下,也能战胜误差。

因此,一个A/A测试表现的最坏场景,其中变量几乎没办法战胜控制组,因为它是相同的,事实上,A/A测试可能永远达不到统计显著。

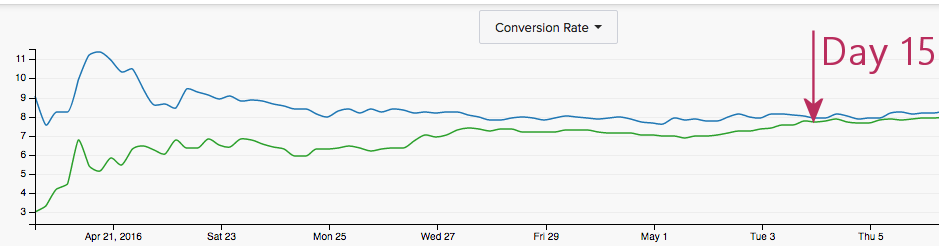

在上面的例子中,测试还没有达到统计显著,而且不可能达到。然而,我们看到了校准变量版本和控制版本在15天后转化率曲线重合。

在这个A/A测试中,相同的页面花了15天转化率逐步接近。

这告诉我们,测试至少要运行15天,以确保我们有一个很好的样本集。不论如何,测试不应该运行少于一个星期,两个星期是可取的。

设置一个A/A测试

A/A测试好在不必做任何创造性的或研发上的工作。当设置A/B测试时,你需要在A/B测试软件上编程来改变、隐藏或删除页面的某些部分;但根据定义,对A/A测试来说这些都是不需要的。

对A/A测试来说,面临的挑战是正确的选择运行测试的页面,你的A/A测试页面都应该有两个特点:

- 相对较高的流量。网页流量越多,越早看到变量的对比;

- 访客可以从页面购买或注册。我们希望根据最终目标来校验我们的A/B测试工具。

出于这些原因,通常我们在网站主页上运行A/A测试。

你也想给你的A/B测试工具集成数据分析工具,你的A/B测试工具可能被设置错误,导致两个变量变现类似。通过数据分析工具对A/A测试数据的钻取和分析,可以与A/B测试工具数据报告的转化和收入做比较,它们具有关联性。

我可以在同一时间运行A/B测试和A/A测试吗?

统计意义上,你可以在运行A/B测试的网站上运行A/A测试。如果工具运行良好,A/A测试不会对访客造成明显影响。但这会为A/B测试引入更多的错误,只有通过更长的测试时间来达到统计显著。

而如果A/A测试一段时间没有被“拉平”,你必须抛弃你的A/B测试结果。

在等待A/A测试自生自灭的时间里你也可以运行A/B测试来达到统计学意义。你不想在A/A测试期间做任何改变。

运行A/A测试的成本

运行A/A测试的成本:机会成本。A/A测试上投入的时间和流量用来进行A/B测试,你能学到关于访客的有价值的信息。

应该考虑运行A/A测试的唯一种情况:

- 你刚安装了一个新的测试工具或更改了测试工具设置;

- 你发现了测试工具报告的数据与分析报告之间存在差异。

运行A/A测试不是一种非常常见的情况。

有两种类型的A/A测试:

- 一个“纯”的双变量测试

- “校验变量”的A/B测试

单纯的双变量A/A测试

通过这种方法,你选择了一个高流量页面并用A/B测试工具建立了测试,这时候就会有控制变量和没有改变的第二个变量。

- 优点:此测试将在最短的时间内完成,因为所有的流量都用来进行测试

- 缺点:不能了解你的访客

校验变量A/A测试

这种方法包括增加“校验变量”到A/B测试的设计中,之后将会有控制变量,一个或多个“B”变量用于测试,其他变量与控制组无差异。当测试完成后,你会从“B”变量中得到一些结果,也能够通过A/A测试校验A/B测试工具。

- 优点:你可以做一个A/A测试无需停止你的AB测试程序。

- 缺点:这种方法在统计学上非常棘手。测试中有越多变量,期望误差越大。它也会消耗A//B测试的流量,要求测试运行更长时间来达到统计显著。

在A/B测试中进行A/A测试校验。

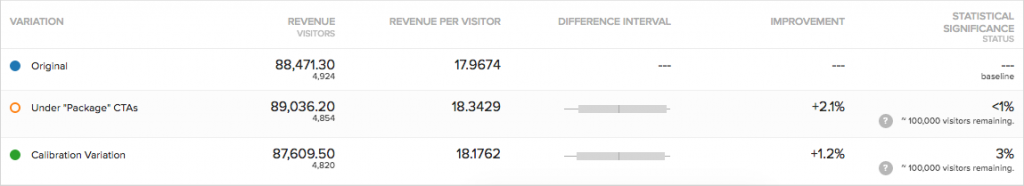

不幸的是,在上面的测试”中,A/B测试变量“Under ‘Package’ CTAs” 没有很明显的跑赢A/A测试的校验变量。

你可以从A / A测试中学到更多的东西

A/B测试工具更强大的一项功能是跨网站跟踪访客行为的能力,常见的A/B测试工具能跟踪一系列用户行为来告诉你一些访客行为。

- 注册或购买的哪些步骤导致访客离开网站;

- 有多少访客开始填写表格;

- 访客点击哪些图片;

- 哪些导航栏经常被点击。

通过定义这些访客规则,能在运行A/B测试期间更好的理解访客行为。

翻译:由吆喝科技(微信:appadhoc)编译自:How an A/A Test Gives You Confidence

本文由 @吆喝科技 原创发布于人人都是产品经理。未经许可,禁止转载。

起点课堂会员权益

起点课堂会员权益

你用的百度翻译么 吐了

你确定这翻译顺畅?