Sora,实现Vision Pro“空间视频”自由?

就在最近,OpenAI宣布推出首个文生视频大模型——Sora,围绕Sora的话题讨论有很多,更有网友将OpenAI的案例视频转化成了适用Vision Pro的空间视频。有关空间视频的未来想象,也再一次被拓宽了边界。

Sora 的问世,将接近尾声的春节假期推向高潮,让互联网的帕鲁们提前进入“工作状态”。

当地时间 2 月 16 日,OpenAI 宣布推出首个文生视频大模型——Sora,该模型可以“根据文本指令创建逼真且富有想象力的场景”,并且最长可达一分钟。

Prompt:一位时尚女性走在充满温暖霓虹灯和动画城市标牌的东京街道上。她穿着黑色皮夹克、红色长裙和黑色靴子,拎着黑色钱包。她戴着太阳镜,涂着红色口红,她走路自信又随意。街道潮湿且反光,在彩色灯光的照射下形成镜面效果,许多行人走来走去。

图源:网络

在官方展示的宣传视频中,很难想象这是 AI 大模型生成的效果,如此极具时尚风格的人物、光影交错的街道背景,熙熙攘攘的行人,仿佛从大制作的电影中走出来一般。

围绕 Sora 的话题讨论不绝,在其生成内容的基础上,有 github 网友@AndrewMayne 将 OpenAI 案例视频转化成了适用 Vision Pro 的空间视频。github 视频下载地址:https://github.com/AndrewMayneProjects/Spatial

一、通过双目视差转换,用Sora弥补空间视频空白

AndrewMayne 创建了两个视频轨道,一个用于左眼,一个用于右眼,并根据视频移动的方向稍微改变了轨道的时间。这会创建模拟立体 3D 效果,并且仅适用于存在横向运动的视频。

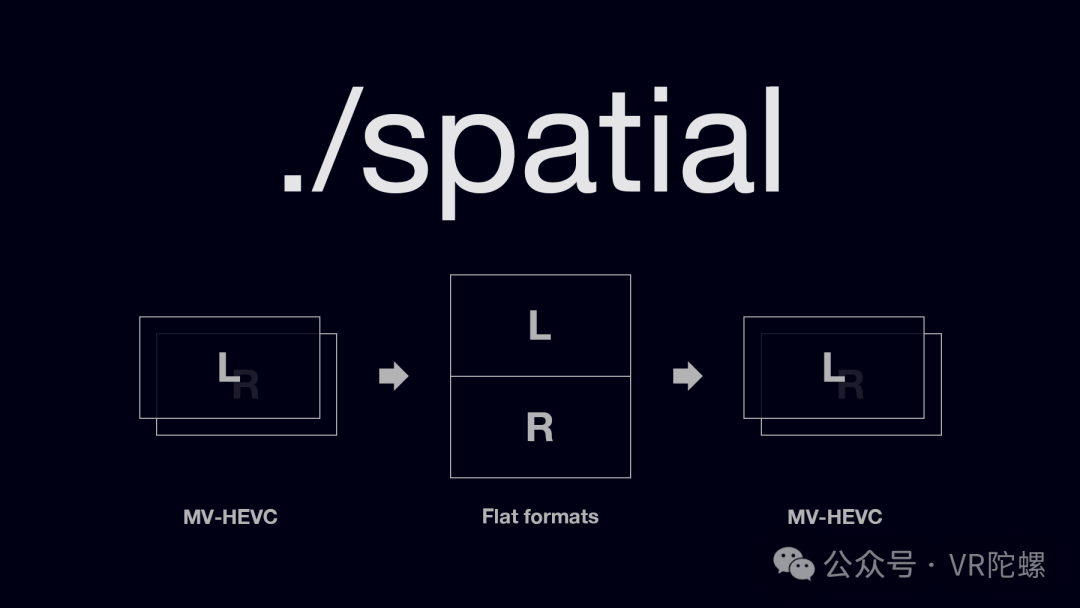

为了将视频转换为适用于 Vision Pro 的 Apple Spatial 视频格式,其使用了 Mike Swansons 的空间视频转换工具( https: //blog.mikeswanson.com/spatial)。

据介绍,Spatial 是一款免费的 macOS 命令行工具,用于处理 MV-HEVC 视频文件(目前由 iPhone 15 Pro 和 Apple Vision Pro 拍摄形成)。它将 MV-HEVC 文件导出为常见立体格式(例如上/下、左右以及单独的左眼和右眼视频),可与标准立体/3D 播放器和视频编辑器一起使用。它还可以制作相同立体格式的 MV-HEVC 视频,以便在 Apple Vision Pro 和 Meta Quest 等 XR 硬件设备上播放。

图源:网络

在 Apple Vision Pro 上的实际体验也相当不错,双目视差带来的立体感,在海浪的冲击中带来更加身临其境的体验。在不追求非常细致的视觉效果下,凭借批量化、高效率的 Sora 生成的 AI 视频可以有效填补空间视频的空白市场。

目前,在大多数体验 Apple Vision Pro 的用户中,公认的最热门,甚至说是杀手级应用,其实是附带 3D 深度效果的“空间视频”。比如:苹果一方应用:《遇见恐龙》(Encounter Dinosaurs) ,3D 深度内容+混合现实的场景,带来了一声声“哇哦”。这种区别于传统文字、图片、视频的新内容形式,正在得到大家喜爱。

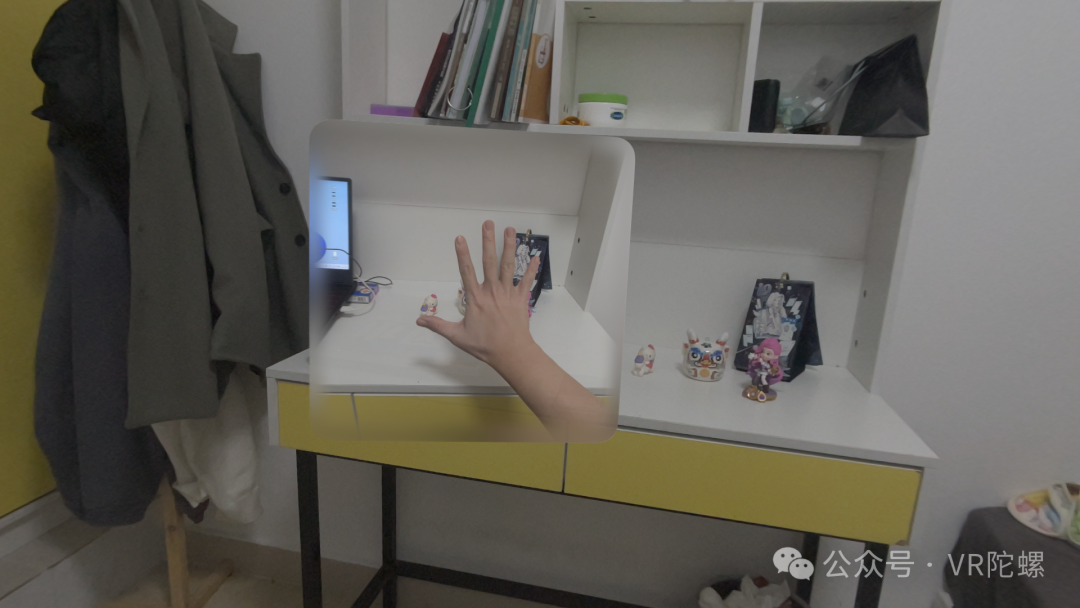

空间视频体验截图(图源:VR陀螺)

目前,Sora 的 AI 生成视频还处于较为早期的阶段。OpenAI 也承认当前模型存在弱点,例如混淆左右或因果等空间细节。例如,一个人可能咬了一口饼干,但之后饼干可能没有咬痕。在扩展普通左右视差的空间视频方面,理论上仅仅只是时间问题。

对于三维信息的视频内容,OpenAI 在官网的 Sora 中也有相关的介绍:

我们发现,视频模型在大规模训练时表现出许多有趣的新兴功能。这些功能使 Sora 能够模拟现实世界中人、动物和环境的某些方面。这些属性的出现对 3D、物体等没有任何明确的归纳偏差——它们纯粹是尺度现象。

其中包括:3D 一致性。Sora 可以生成带有动态摄像机运动的视频。随着摄像机的移动和旋转,人和场景元素在三维空间中一致移动。

事实上,这种类似于第一人称的拍摄手法,可以带来更深层次的“空间感”,即使在转换空间视频之前的 2D 视频,依旧拥有一定沉浸感。

二、iPhone、Vision Pro、AIGC,谁是空间视频最佳工具?

虽然 Sora 生成的 AI 视频通过转换后可适用于 Vision Pro,不过仔细对比之下,可以发现其于苹果官方支持的拍摄工具之间,还是存在些许差异。

分辨率方面:Vision Pro 与 iPhone 15 Pro 拍摄的空间视频为特定分辨率,分别为 2200×2200(方屏)、1920×1080(宽屏),而 Sora 可以采样宽屏 1920x1080p 视频、垂直 1080×1920 视频以及介于两者之间的所有视频。

帧率方面:可以发现苹果官方拍摄的两种工具的空间视频皆为动态帧率(VFR),即拥有最低帧率与最高帧率。用 iPhone 拍摄的普通 HDR 视频,以及 Sora 转换后的空间视频都是恒定帧率(CFR)。

相关资料显示:静态帧率是指固定的帧率,即每秒显示的图像帧数。这意味着在每一帧之间的时间间隔是固定的,并且不会随着画面的复杂度和性能的变化而变化。动态帧率则相反,它是可变的。它根据画面的复杂度和当前的硬件配置进行调整,以确保每秒显示的帧数始终保持在一个可接受的范围内。动态帧率可以提高视频的流畅度,减少视频的文件大小和传输带宽要求。

当然,即使空间视频采用动态帧率,因为深度信息等原因,内存占用方面依旧对比普通视频多两倍左右。

图源:VR陀螺

视差体验方面:参考 reddit 部分用户,以及陀螺君的实际体验来看,Vision Pro 拍摄的空间视频似乎更具“空间感”。

除上述图片对比中的基础信息外,有观点认为这还与拍摄设备的两颗镜头距离相关。

iPhone 15 Pro 的镜头间距约为 20 毫米,仅为成人瞳距的三分之一左右。因此,理论上使用 iPhone 15 Pro 拍摄的空间视频,只能获得与小狗类似的视差和深度感知。(不排除苹果通过算法改善,以形成更大视差的空间视频)

而 Vision Pro 的摄像头间距更接近成人 IPD,可能约为 60-65 毫米,因此事物将具有与成人现实生活相似的深度和视角。再加之头戴式“第一人称”拍摄视角,在实际观看中,也就更加身临其境了。

图源:网络

单从空间视频相关参数、以及实际观影 3D 深度、清晰度效果来看,作为原生工具的 Vision Pro 显然更胜一筹。虽是方形,但是其视觉深度效果好于 iPhone 15 Pro 拍摄与 Sora 等普通视频转换后的空间视频,似乎相比之下,层次感更多一些(仅肉眼感知)。

而 iPhone 15 Pro 的优势则主要体现在其便携性上,随时随地可以拍摄空间视频。实际在 Vision Pro 上观看的沉浸感效果与清晰度也相当不错,远远大于在手机上直接观看的形式,层次感也比较分明。并且通过 AirDrop 还能一键投送到 Vision Pro 上,传输方式暴力简单。

Sora 等 AI 大模型生成的视频、普通视频通过转换后,虽然也有一定层次与深度感,但在实际观看时,总有一种说不出的违和感,就像是你在看 3D 电影那样,有一定沉浸感,但放大后并不是很特别清晰与沉浸。当然,这可能取决于不同的视频内容,它们会产生不同的观感。正如前面说到的第一人称视角那样,也许更适合做空间视频。AI 大模型生成视频,是一个大趋势,特别是在市场空白的空间视频上,AI 使之能够具备量产化、定制化、低门槛的赋能。

P.s.:由于空间视频在 2D 平面上较难展示三维信息,所以下方图片仅供参考,用于展示三种形式拍摄的视频在 Vision Pro 上的播放:

Vision Pro拍摄的空间视频截图(图源:VR陀螺)

iPhone 15 Pro拍摄的空间视频截图(图源:VR陀螺)

Sora 生成视频空间版(图源:VR陀螺)

三、结语

时代变革的钟声,似乎已经敲响。

Apple Vision Pro 带来了空间计算革命的全新愿景,将人们的现实体验提升到了一个全新的层次。通过结合 3D 空间场景与混合现实的内容展示形式,它不断地挑战和刷新人们对于视觉认知的界限。

从生成式人工智能文字对话工具 ChatGPT、图像生成器 DALL-E,到视频生成的王炸 Sora,OpenAI 正在重塑互联网内容生产形式。

硬件+内容之间变革,正在加速走向交融的十字路口。

参考来源:

https://zhuanlan.zhihu.com/p/648353681

作者:VR陀螺

来源公众号:VR陀螺(ID:vrtuoluo),XR行业垂直媒体,关注VR/AR的头部产业服务平台。

本文由人人都是产品经理合作媒体 @VR陀螺 授权发布,未经许可,禁止转载。

题图来自 Unsplash,基于 CC0 协议

该文观点仅代表作者本人,人人都是产品经理平台仅提供信息存储空间服务。

起点课堂会员权益

起点课堂会员权益

B端产品经理需要进行售前演示、方案定制、合同签订等,而C端产品经理需要进行活动策划、内容运营、用户激励等

B端产品经理需要进行售前演示、方案定制、合同签订等,而C端产品经理需要进行活动策划、内容运营、用户激励等

这个东西很厉害啊