从技术之战开始,信息流大战的赛点发生轻微的变化

算法推荐直观上造成了用户层面的“信息茧房”现象,更深层次看,则引发了内容生产者的“创作茧房”问题。

半个月前还沉浸在“抖音”高速增长的喜悦中的今日头条,最近却有点焦头烂额。央视、人民日报、第一财经周刊等央媒和核心财经媒体,在上周对今日头条及旗下的抖音产品进行了一轮违规发布广告的曝光以及价值观的批判。

在相关的许多报道中,媒体都或明或暗的强调了一点:信息流推荐技术本身早已被国内外论证了是一个成功的移动互联网产品,但之所以出现劣币驱逐良币的问题还是因为使用这个技术的企业出了问题。

也正因此,不少媒体在引述相关报道的时候都会强调,去年初,今日头条创始人张一鸣在接受《财经》杂志专访时提出的,不认为今日头条应该有价值观这一论调。

这在一定程度道出了今日头条的核心问题,但事实上更为关键的是,如今这个阶段的基于人工智能算法的内容之战,已不仅仅是打破“信息茧房”这么简单。从技术之战开始,这场信息流大战的赛点,已发生了轻微的变化。

一、推荐准确性的PK,仍将决定于数据而非算法的技巧

对信息流来说,算法准确性是竞争重点,但真正的决胜点,却是数据。

1、数据热启动是百度实现奇袭的根源

首先需要明确一个理论,推荐算法的准确性并不是被计算出来的,而是被统计出来的(这一点在后文底层技术分析会详细说明),这意味着数据量越大、越相关,越能得出准确的推荐效果。

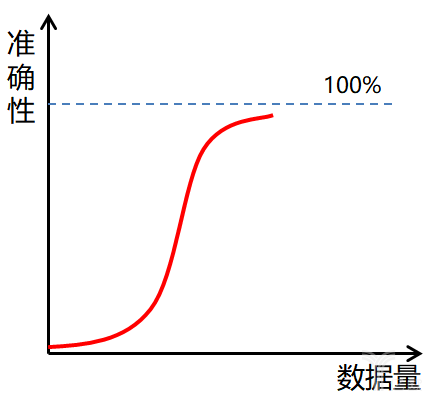

而且,由于复杂网络向量关系的存在,一个向量特征的准确性影响是呈几何扩散的,数据对推荐准确性的影响是非线性增长的关系。在足够多的数据量情况下,会快速提升,直到准确率接近100%开始变缓(毕竟100%准确十分困难,越接近越难)如图:

也就是说,在算法准确性这里,数据热启动的价值将变得更为重要,足够丰富的数据,一旦介入信息流推荐算法,就可以马上实现高的准确率,追赶间距很窄。

以百度为例,其老本行搜索业务与内容直接相关,在内容大数据方面有直接优势,官方对外宣称整合了千亿特征、百亿样本的数据体系,构建了囊括大到科文史哲,小到一个冷僻的小游戏的特征数据。这为其数据热启动做好了充分的准备,而且,主动搜索表达出的用户向量特征,比通过被动点击总结的向量特征可能更为准确有效。从这样的技术角度看,百度信息流可以只用一年时间完成其他公司三五年才达成的目标,在较短的时间内“杠住”今日头条并不意外。

2、只有足够大的试验平台才能让准确率“朝上走”

另一个算法准确性的问题是推荐试算的问题,即通过推荐的实践来反馈当前算法的准确性,从而实现所谓的模型迭代。

例如,平台通过各种方式得出某类用户可能喜欢李娜,但推送李娜比赛新闻后效果很差(点击、停留等指标低),就证明这个推断可能是不准确的,需要返回调整。这样的反复试验能够让推荐逐渐接近真相。

而这些,说来说去都是硬实力的比拼,比的是谁的平台大、空间足够广阔,这会让UC这样早期没跟上的信息流平台越来越落后(如果试验环境不够充分,下一次迭代的准确性未必比这次好,准确率呈现反复波动而非一致提升),而百度这样本来就凭借搜索页面占据用户眼球的平台“庙大好念经”。

也即,算法准确性可能不是什么奇巧淫技,比来比去还是看谁的膀子粗。

二、技术下一程,要从冰冷的统计学走向有温度的内容尊重

上文准确性所行之事,从宏观层面都是统计学的“花招”。而信息流的下半场竞争,则将更具有尊重内容本身的人文色彩。也即从“量”的上半场进入“质”的下半场。

1、算法不带价值观,但产品要有温度

张一鸣“算法不带价值观”被广为诟病,但从上文的技术推导本身而言,算法可能真的没有价值观,这些冰冷的统计学数据不关注也不可能关注到内容本身。

但同样是推荐系统,网易云音乐在QQ音乐、虾米音乐等一众软件中独树一帜,被广为赞誉。好听的冷门歌曲、年少时听过的磁带、收音机播过的音乐,在恰当的时机跳上来给予用户惊喜。“有温度”的产品收获用户粘性是一种必然,有温度的产品也一定是企业长久发展的必要。

同样是内容产业,信息流莫不如是。

2、“人人平等”要变成“生而不平等”

这里的转化有双重含义,首先是推荐机制不再只局限于“博眼球”的统计学需求指标,从而丢掉了优质内容。其次是打击套路写作,让上百万的内容创作者们实现真正的创作丰富化,而不是束缚于推荐机制的茧房中。

想要实现这种转化,完全寄希望于人工不太现实(虽然百度这些平台都在强调自己的人工投入),最终还是要通过技术本身去甄别内容,打入内容的“内部”,自主判断什么是好文章、什么是好图片、什么是好视频、什么是好音乐、甚至什么是好人(内容源)。

今日头条在公开算法末尾就如何判断内容好坏做了一个章节,但该章节并没有太多骄傲的“技术”宣扬,说明它仍在发力被社会期许的“好内容”。因此,如果说百度或者其他信息流平台下一阶段要彻底超越今日头条,“好内容”将是最合适、最必要的角力点。

百度发力“人工智能皇冠上的明珠”NLP(自然语言处理)或许就是在走这条路。虽然同时强调自己的AI技术,但百度作为综合性科技公司相对头条,在AI的宽度、深度上公认更有优势,在利用自然语言处理技术,对内容的质量、新颖度、情感倾向等进行深度理解和挖掘方面,较今日头条可能更有先机。

百度先于今日头条搞出的“创作大脑”,表面上是为了更好地留住作者,而深层次可能更在于百度想在理解、区分内容好坏方面更先一步。毕竟,AI辅助写作首先需要的就是对知识、对图像的理解,将是锤炼内容识别技术的恰当机会。

无论如何,信息流的技术竞争一定要回到尊重作者、尊重内容的“供给侧竞争”(相对于只关心用户需求的需求侧竞争,它本质上文提及的统计指标集合)上来,让每一个内容个体“生而不平等”,由他评走向自我价值认同。

如果”澳网出线局势深度分析”与“李娜3岁时干的事你绝对不知道”这样的文章不再被同等对待,最终所谓“信息茧房”等表面问题也将迎刃而解。

而这方面,虽然百度已经占得先机,但头条、天天快报甚至手握公认优质内容的微信入局,必将引致一场新的技术恶战。

三、算法流派众多,但一切归于贝叶斯

基于前文,我们能发现,在信息流推荐中,数据仍然是决胜点,而信息流也必然要更加尊重内容。而从底层技术角度,当我们回到算法的起源,也同样可以印证这些。

以目前主流的算法为例归类分析:基于内容的推荐、协同过滤推荐、基于关联规则的推荐、基于社会化网络分析的推荐等,用通俗的语言即可解释。

1、基于内容的推荐算法

即用户喜欢什么东西,推荐一些相似的东西。该推荐算法简单有效,推荐结果符合人们的认知;无须用户的历史评分信息。但是,该算法必须知道内容的特征,界定“什么才是相似”,比如体育里的篮球、NBA、耐克……如果不能得到足够的信息,则推荐效果较差、结果较单一。

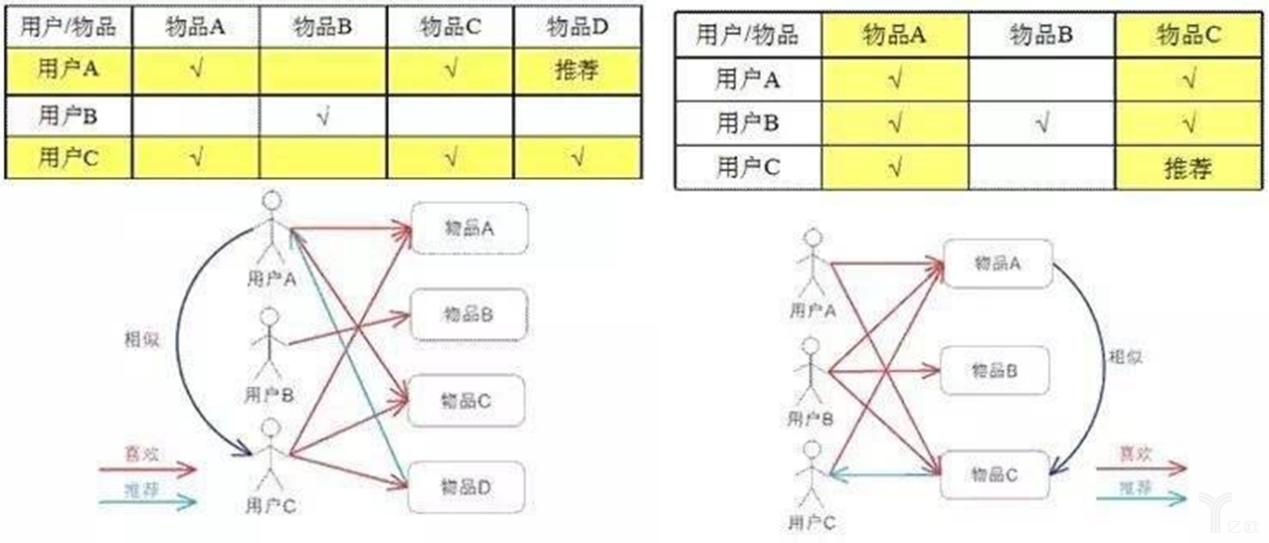

2、协同过滤技术

即把兴趣差不多的用户群体归类,然后给他们推荐相同偏好的内容。它通过协作的方式分析用户之间的喜好,避免特征提取不完全的情况。但存在冷启动问题,无法准确对新用户进行推荐,存在数据稀疏性问题。有从用户出发和从内容出发两种协同,如图所示:

图:从用户出发和从内容出发的协同过滤推荐(来源:CSDN“数据挖掘工人”博客)

3、关联规则推荐

即通过某些技术挖掘大数据,建立内容之间的关联规则,起初用在实体零售,比如经典案例尿不湿与啤酒的搭售。在信息流领域中,主要是用统计学的方式发掘那些表面上看不出关联的内容与内容之间的某些相关性,及相关程度。

4、社会化网络分析

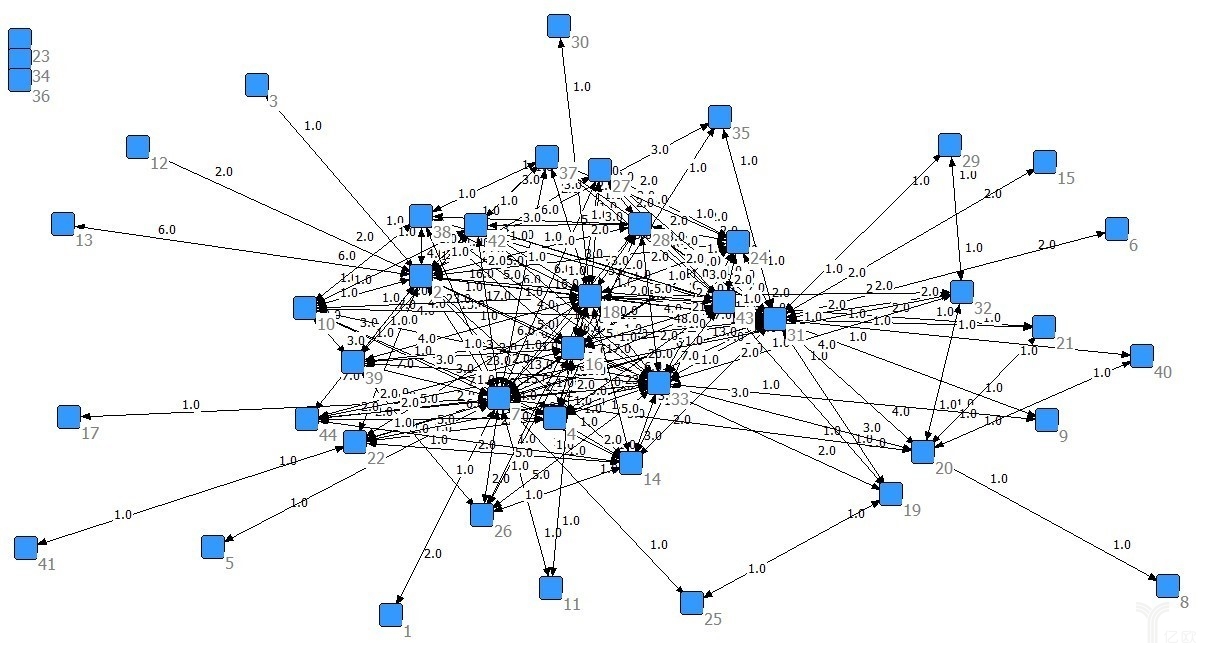

即身边的人喜欢什么,就给该用户推荐类似的内容。例如亲戚、朋友、同学等双边关系,微博关注、微信公众号订阅等单边关系,织就一个由用户组成的节点网络,探索与分析各节点、边的重要程度,利用这些重要关系来进行推荐。

图:社会化网络分析(来源:知乎“社会网络分析”专栏)

上述这些主要的推荐算法,都源于贝叶斯理论。其主要解决的就是根据已发生的事实推断关联事件发生的概率。

而信息流算法核心推荐系统正是通过利用用户的历史行为数据,分析用户的兴趣爱好并构建相应的用户模型,从待推荐的项目中选择与其兴趣偏好相符的项目进行推荐。例如,在一个极简化的模型中,已知一个喜欢李娜的用户喜欢网球的概率为x,那么就可以得出喜欢网球的用户喜欢李娜的概率y,藉此推荐内容。这

种推断的准确性,就是信息流算法能够达到的准确性,其基础框架就是贝叶斯理论。可以看出,不管是基于何种类型的推荐,在算法前的机器学习层面都是由贝叶斯推断一层层、一步步堆积、衍生而来。不管最终构筑成多么庞大的体系,但它们开始的基点却是一样的,这也使得算法推荐容易陷于“信息茧房”的怪圈。

“人人平等”造就信息流“创作茧房”

在业务层面,贝叶斯的特性也不可避免地造就了“创造茧房”现象。而打破“创造茧房”,就唯有跳出当下的贝叶斯框架,靠的就是上文所言的内容尊重,从“人人平等”变成“生而不平等”,最终也给出信息流算法技术演化的应有方向。

1、概率统计基础上的算法,都是“他评体系”

主流算法,就是通过推断个体与个体之间的关系(方式可以有上文提到的多种),参考热度等评价指标,从而有目的进行推荐。例如,对一个喜欢李娜的用户推荐澳网的资讯,在推荐时就已经根据复杂的计算(基础是贝叶斯)。由一个预期的点击率、停留时间、点赞、评论情况计算,计算不达标的,就不会推荐出去。

在今日头条算法发布会上,曹欢欢在讲到今日头条的数据量时,称其有几十亿“向量特征”。所谓向量,指的是带方向,例如喜欢李娜和喜欢网球是两个“原始特征”,而“喜欢李娜→喜欢网球”才构成一个向量特征(带概率数据)。

但事实上,向量不过就是从一个点到另一个点,是点与点之间的数据关系,每一个内容个体(一篇文章、一个短视频等)都被当作一个点存在。是否被推荐,是由各种外围向量关系决定,是典型的“他评体系”(数学上,点已经不可再分割)。

2、“人人平等”后,“创作茧房”成信息流顽疾根源

这意味着,内容和内容,在算法这里是“人人平等”的,一篇精心编撰的图文与一个拼凑热文会被一视同仁,都依据向量特征进行推荐。但这也造成了内容质量的“参差不齐”。

可以说,在当下的算法体系下,内容个体真正缺乏的是“自我认可”,高质量内容源不被重视;算法更多地是“世俗评价”,算法为上,人人都在追求曝光量。

于是,在当前算法模式下,创作导向被冰冷的统计学规则限制,越来越收敛到某些高推荐、高曝光、高点击的范围内(褥羊毛有意为之,或者被环境胁迫),最终形成“创作茧房”。

算法推荐直观上造成了用户层面的“信息茧房”现象,更深层次看,则引发了内容生产者的“创作茧房”问题。

诚然,他评体系确实对增强推荐内容与用户的匹配有重要意义,提升准确性仍然是算法的重要任务,但解决“创作茧房”问题,不再把内容个体当做一个不能分割的点,而把算法扩展到内容的内部,尊重每一个内容,会是下一阶段信息流技术突破的重点。

本文由 @智能相对论(微信公众号:智能相对论) 原创发布于人人都是产品经理。未经许可,禁止转载

题图来自 Pexels,基于 CC0 协议

起点课堂会员权益

起点课堂会员权益

写的真好,谢谢分享