日常运营中,如何做好 A/B test?

本文来和大家聊聊,在日常的运营中,如何才能运用好AB测试,通过数据反馈,AB测试,测试结果分析,运营策略优化等过程,最终将产品转化的每一个环节做好,从而更好地提升在AARRR环节的某一项数据指标。

我相信运营对于AB测试一定不陌生。当我们从数据中发现了一定的问题,但是也不敢确定想出来的办法一定能解这个问题的时候,领导便会说:小范围测试一下吧。

这时候说的测试就是AB实验,简单来说,AB测试是为产品的界面或流程制作两个(A/B)或多个(A/B/n)版本,在同一时间维度,分别让组成成分相同(相似)的访客群组(目标人群)随机的访问这些版本,收集各群组的用户体验数据和业务数据,最后分析、评估出最好版本,正式采用。

进行AB实验能够有利于优化用户体验,提升漏斗或者单个节点的转化率,从而使得产品的最终效果变得越来越好。

那么该怎么去进行测试呢?如何才能保证测试的数据有效性,在最短的时间内测试出来结果,以便后期能够更好地进行调整。小步快跑,关键是步子要小,结果要快,后期才能更好地运用在运营过程中。

今天就来和大家聊聊,在日常的运营中,如何才能运用好AB测试,通过数据反馈,AB测试,测试结果分析,运营策略优化等过程,最终将产品转化的每一个环节做好,从而更好地提升在AARRR环节的某一项数据指标。

一、从数据中发现问题

前面,我写过一遍文章:运营人如何进行数据分析?从日常的数据中发现问题,找到出现异常的那些数据。

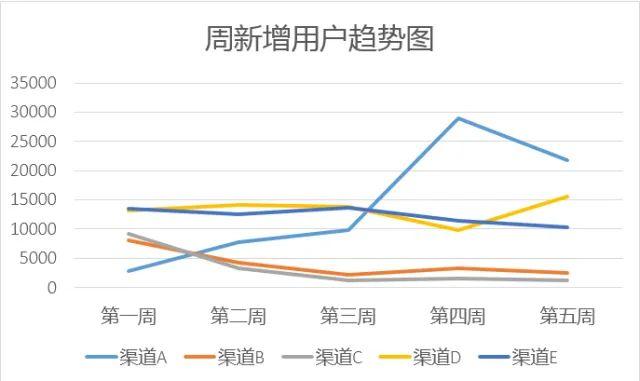

最终,从数据中发现问题,也需要回到数据中去解决问题。一般来说,在数据折线图中,数据出现下降拐点的很在程度上为异常数据。在进行数据分析的时候,可以着重关注这些数据。

如下图的各个渠道周新增用户趋势图,就可以重点分析,为什么第四周之后,新增用户的增长幅度降低,是因为预算减少了吗?还是说,在用户注册的过程中遇到了什么问题,导致新增用户下降。

在日常的运营中,数据分析运用的比较多的便是漏斗模型,不一定是AARRR模型,而是用户路径中每一个关键步骤都会出现流失,转化率下降的问题,只是说这个流失是否在合理范围内,和业内的平均数据相比,这个数据是否还存在可优化的空间。

从关键用户路径出发,从数据中能够快速找到,用户在哪个环节可能出现了一定的问题,用户在哪个环节停留的时间比较长,用户在某个环节转化率急剧下降,这些可能就是AB实验的关键点。

做好其中一个环节的优化,便能够带来明显数据的提升,从而更好地提升转化率。

如,用户在淘宝上搜索一个产品的路径可能是:直接输入关键词——点击某个产品——查看产品信息(包括详情页和评论等)——询问客服——选择产品规则——下单购买。

而这些步骤,每个环节都会出现用户流失的情况。如果每天的曝光很高,但是却没有点击,那么说明在首图中还需要去进行优化,了解用户为什么没有点击的原因:是因为人群不精准,还是因为和竞品的首图更吸引人,还是其他什么原因。这些都可以去通过AB实验去进行测试,不断优化用户路径中的关键步骤。

接下来就进入重点了,如何去进行AB实验,在这过程中,需要注意什么,什么样的实验才真正算一个好的实验。

二、如何进行AB实验?

进行AB实验,我主要会在以下4个方面进行说明。

1)确定实验的核心目标

2)确定测试的样本量

3)确定实验的周期

4)AB实验遵从的原则

以上这4个关键点,是我认为进行AB实验最关键的核心,将这些东西弄明白,基本上就能进行一个完整的AB实验了。接下来,我将举例说明。

1. 确定AB实验的核心目标

这个应该不用多说,运营是目标导向的,做实验的时候也不例外。只有确定了做AB实验的核心目的,才能更好地进行后续的AB实验。

在核心目标这里,需要延伸出来,其他两个和核心目标相关的两个指标,第一个是辅助指标,第二个是反向指标。有这两个指标之后,我们才能更好地确定核心目标,后期也才能更好地检测这是否是一次成功的实验。如果核心指标提升了很多,但是同时反向指标也上升了很多,那么可能相当于是亡羊补牢,拆了东墙补西墙,最终也很难将核心指标提升上去。

接上边的那个列子,在用户搜索产品的时候,我们发现用户的点击率很低,远远低于行业平均水平,假设行业平均水平是5%,而目前你的产品的点击率才2%。

假设核心目标是将商品点击率从2%提高到5%,而同时辅助指标是购买转化率在一定程度上会有所提升,毕竟要保证进来的流量不是虚假流量,最终能够形成一定的转化。而反向指标是,页面的跳失率在一定程度上不会收到太大的影响。

2. 确定测试的样本量

确定了实验目标之后,紧接着我们就应该来测算出需要测试的样本量。很大的样本量虽然更能体现实验的准确性,但是可能在数据收集上也需要耗费更多的时间。很小的样本量,很难说明数据的准确性。

所以我们需要在有限的时间内收集好足够的数据量做实验。

按照实验的准确性原则来说,一般是统计显著≥95%确定的样本量,是有效样本量,能够保证实验结果的准确性,确定操作的统计显著差异不是由于偶然因素造成的,而是系统设定的测试实验的结果。

如何根据统计显著,确定所需的最小的样本量?直接用AB测试样本数量计算器(https://www.eyeofcloud.com/124.html) 计算出每个版本需要的最小样本量。

也就是说,做这个实验,至少需要640个样本数量。并且需要保证分流的均匀性,人群是随机分类的。

3. 确定实验周期

是不是上边的样本量保证了之后,就一定能保证实验的准确性呢?答案是否定的,还有一个很重要的因素是需要保证实验周期,能够刚好覆盖产品的一般使用周期。也就是说,能够覆盖产品的高频用户和低频用户,保证不会因为用户群体之间的差距而产生一定的数据的差异。

举个例子,如果一个产品的使用周期是7天,那么实验周期需要大于等于7。如果一个产品的使用周期是30天(如工具类的产品,比较低频),实验周期就需要大于等于30天,才能更好地保证实验的准确性。

4. AB实验遵从的原则

接下来,简单地和大家聊下AB实验需要遵从的原则,以便我们更好地进行实验,在保证实验结果的前提下,能够快速推动实验的进行。

1)小步快跑原则

遵循效率优先、简单优化的原则,一点点优化,一步步优化。

能不开发就不开发,能从UI层面解决的就一定不要麻烦开发小哥哥。

即使要开发,也要了解竞品的情况,给产品和技术一定的数据支撑,否则很难实现需求落地,毕竟开发小哥哥的时间都是很宝贵的,他们需要确认自己做的都是能够产生一定影响的事情。

2)案例借鉴原则

AB实验,一定要从数据入手,找到出现异常的数据。而最终进行的优化实验,也需要找到一定的案例来进行支撑(实在没有,也要找到一个相近的案例。毕竟我们的产品很多,不愁找不到相似的产品来支撑自己的实验。)

有其他案例作为支撑,也就是这个实验,是从某个成熟的产品中借鉴而来的,这样成功的几率也就更大。同时,如果有开发需求的话,产品和技术对于这个需求也更加认可。(但是请看第一条,设计开发就一定需要排期,需要排期就一定需要一定的时间。)

3)预期管理原则

做好预期管理,这里不仅包含对于实验的预期,也包含对于领导预期的管理,不要给领导以及其他协作者太高的预期。最终结果,要让结果高于预期,未来才能更好地推动资源,才能让大家更信任你。

三、测试结果分析

接下来来到最关键的一步,那就是测试结果的数据分析。

在保证核心指标明显提升的基础上,辅助指标也有一定量的提升。

同时,反向指标变化不明显。一旦反向指标差异变化明显,可能是一次不成功的实验,毕竟牺牲了其他的指标来让核心指标变得更好,不是长久的运营策略。

如果统计显著性,≥95%,那么则证明核心指标有了一定量的提升。同时,再来计算辅助指标是否也有了一定量的提升,同样也是用上方的AB测试工具计算器来计算出统计显著性。

而有了一定的小范围数据支撑之后,如果再来提开发需求,将实验结果产品化或者继续优化迭代,那么需求也更加可靠。

四、将实验结果进行整理归类

将AB实验结果记录在实验表中,方便后期更好地调用实验想法,为新的实验想法提供可参考的依据。

一般实验记录可以分为以下几个关键点:

- 实验的目标:如提升单点转化率或者漏斗转化率

- 实验类型:是针对页面上实验,还是文案修改上的实验,还是在用户路径上做了一定量的优化,简单描述就好。

- 实验的过程:简单描述下实验的过程,用了多少样本量,在多少时间内完成内进行了什么样的实验。

- 实验结果:最终的实验结果什么样。

将已经做好的实验结果进行整理归类,方便自己或者后来人调取实验库,这样在一定程度上能够提高做事的效率。

以上就是我关于AB实验的一些分享。

在AB实验中,遵从最重要的原则就是:控制单一变量,小步快跑,得出结果,不断优化总结。用实验的思维去升级迭代,不断进行优化,最终将操作系统变得越来越灵活。

本文由 @运营汪日记 原创发布于人人都是产品经理。未经许可,禁止转载

题图来自Unsplash,基于CC0协议

起点课堂会员权益

起点课堂会员权益

看过

提一个问题大家交流:各位做AB实验时候,是不是必须置信区间达到95%及以上,才会采纳新版本的呢?日常操作时候,发现达到这个标准的实验太少了,该如何去把握这个标准?希望听取一下其他公司AB增长小伙伴的看法

请问这个显著率是怎么计算的呢,我看那个计算器显著率是不动的啊

样本计算器不错 收~