关于增长AB测试,这5件事你应该知道

编辑导读:AB测试是产品、运营同学经常用到的工具,它能够比较新版本与当前版本用户体验的变化,收集数据并分析。根据数据分析结果衡量更改对业务的影响,可以确保每个更改都产生正向结果,从而消除创新和迭代风险,让业务快速增长。本文作者将围绕增长AB测试,分享要注意的五件事情。

增长工作中,AB测试可以说是被奉为圭臬的方法,也是产品/运营同学们信手拈来的工具。工作对AB测试接触使用较多,但也有了更多的经验教训以及学习思考。

这次分享5个实际使用AB测试中的关键事项,一起来交流避坑。

一、样本规模预估

AB测试中,对照组和实验组的样本量越大,实验时间越长,实验结果就更加准确。

这可以说是常识性的判断,但是实际上这是由统计显著性决定的:

统计显著性是指对照组和实验组的数据差异有多大可能是真实存在的,而不是随机误差导致的。

所以周期更久、样本量更多的AB测试更有说服力,但是实际工作中,产品或活动的迭代速度快,这就要求AB测试的实验周期不能过长,所以在AB测试前对样本规模进行预估至关重要。

计算样本量的方法有些复杂,对于丢弃高数、概率论多年的打工人来说,还是建议求助于数据分析同学。

在这个样本数量计算器中,输入原始版本转化率(已知),再输入优化版本的转化率(预期),同时设置统计显著性水平,一般达到95%以上即是显著差异。这样就可以快速得到一个样本数量结果。

如上图,如果原始版转化率是10%,优化的新版本转化率预期是12%,在进行AB测试时,每组用户样本数据达到2900以上时,才能说明这个新版本转化率的是显著差异,是可信的。

在计算完预估的样本数量之后,还有一个重要工作就是预估实验周期。

如果可信的AB测试每组实验需要2900个样本量,但是我们的产品每天只有200的日活用户,分成两组后每组只有100用户,则2900/100=29天,意味着AB测试实验需要29天后才可达到需要的样本量。

这个时候就要评估这个周期是否是可接受的,如果周期过长,则说明这个AB测试在现阶段进行是不合适的。

二、测试结果分析

样本规模预估是在AB测试前进行,因为优化版本的转化数据是预估的,所以样本量和实验周期都是预估数据,帮助我们在AB测试前对测试样本和周期有个初步判断。

在实际的AB测试实验结束后,我们还需要对实际的结果数据进行统计显著性检验,保证对照组和实验组的数据差异是显著可信的。

在这个工具中,我们输入AB两组的实际数据,就可以清楚看到两者转化率的差异,以及试验结果的统计显著性结果。

以上图为例,虽然B组的转化率比A组高,但是因为样本量较小,试验结果没有达到显著的统计学差异,所以我们不能得出B组优化比A组更好的结论。

这个时候有两种选择,一是继续实验,积累更多的实验数据后进行分析,二是放弃实验,得出此次优化没有明显提升的结论。

也不是说继续实验一定会得出显著性差异,如果样本量继续增大,但是转化率差异减小,就意味着需要更多的样本量,这种情况往往说明两个版本的差异确实不大,但是也需要根据实际情况判断是否需要停止AB测试。

三、反向相关指标

在进行AB测试时,一般情况下会有一个核心指标来判断实验结果,同时会有一些支持或辅助指标来更好地监测实验和分析结果。但是不能忽略的是一些反向指标。

什么是反向指标?反向指标就是AB测试实验中可能会负面影响的指标。

举一个简单的例子:

AB实验为了提升新用户注册率,于是在新版本中过度包装了新人权益,虽然提升了新用户注册率,但是因为用户预期管理不足,新用户注册后发现实际的新人权益大打折扣,对产品产生不满的情绪,导致新用户首单转化率降低。

新用户首单转化率在这个实验中就是一个值得关注的反向指标。

AB测试为了实验的速度和效果,往往会关注少部分关键流程节点和核心指标,但是忽略反向指标,却有得不偿失的风险。

四、辛普森悖论

辛普森悖论是指:某些条件下的两组数据,分别讨论时都会满足某种性质,可是一旦合并考虑,却可能导致相反的结论。这个理论由英国统计学家辛普森提出。

还是举一个简单的例子,在对新用户首购流程的AB测试实验中:

首日,A组转化率是10%(10/100),B组转化率是12%(120/1000);

次日,A组转化率是15%(150/1000),B组转化率是16%(160/1000);

两日分别看,B组的转化率都高于A组。

但是合计起来看,A组转化率是14.5%(160/1100),B组转化率14%(280/2000);

这样合计数据A组的转化率却高于B组。所以在分析时就无法直接判断实验结果。

辛普森悖论的存在,对AB测试提出了更多的要求,用户样本的合理选择、样本量的监控调整、全面的数据分析等。

例子中导致分日和合计数据结论相反的原因就是首日A组和B组样本量差别较大。

五、分层实验

对于大体量的产品和完善的增长团队,会存在多个AB测试同时进行的情况,这就需要考虑分层实验。

分层实验是指,将多个实验建立起分层结构,每一层实验使用过的流量,下一层的实验可以继续用。有些不是很好理解,继续举个例子:

以电商产品的新人流程为例,新用户下载打开APP后,首页有新人礼包的入口,点击进入后可以查看新人权益和优惠商品,新用户查看新人商品后完成下单,这就是新用户转化的基本路径。

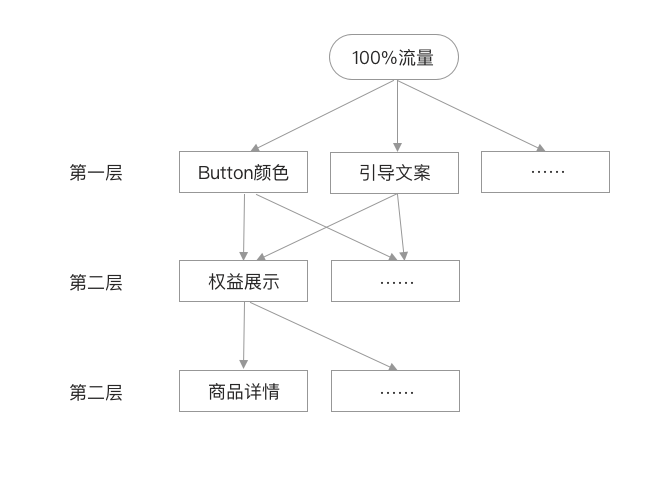

为了优化现有的新人转化流程,从新人礼包的首页展示、落地页展示、新人商品详情页同时进行了多个AB实验。

在首页展示上,同时进行了按钮颜色和引导文案的AB实验,为了保证变量的唯一性,按钮颜色实验中,包括文案等其他内容完全是一致的,文案实验中,包括按钮颜色等其他内容也是完全一致的。这就需要把100%的流量分成2部分,假设为各50%,即50%用户进行按钮颜色实验(25%看到红色按钮,25%看到黄色按钮,两组文案一致),其余50%用户进行文案实验(25%看到“领取权益”文案,25%看到“1元下单”文案,两组按钮颜色一致)。

进入到新人页面之后,对权益展示的方式又进行了AB实验,从第一层(首页)来的流量(100%)都进行权益展示的AB实验,来自第一层100%的流量刚进行了按钮颜色和文案的实验,为了避免上层实验对权益展示实验的影响,从上层来的流量要随机分配到权益展示实验的AB两组,这就是分层实验中的流量正交,均匀分配上层流量。

分层实验在实际工作中不多见,但是成熟的产品必须要考虑这种情况的存在,才能更高效地更科学的同时进行多个AB实验。各团队间也要保持沟通,避免单打独斗进行实验,却不知被对方的实验影响了结果,得出不恰当的结论。

以上,就是关于AB测试的5个阶段性分享,后面的工作中,AB测试还会继续做,新的问题还会出现。

本文由 @吴依旧 原创发布于人人都是产品经理,未经作者许可,禁止转载。

题图来自Unsplash,基于CC0协议。

起点课堂会员权益

起点课堂会员权益

有收获,已关注,谢谢。AB测试还会继续做,新的问题还会出现,期待作者后续的分享~

请问文中提到的AB测试工具(样本量计算等)在哪可以找到?

本来放文章中了,审核时给删掉了。

样本预估工具:https://www.eyeofcloud.com/124.html

结果验证工具:https://www.eyeofcloud.com/126.html

谢谢