只需7步,轻松搭建AB测试闭环!

编辑导语:随着企业对数据越来越重视,A/B测试已被广泛应用于各类场景、各类职能中寻找突破口寻找增长机会,降低投入风险。那究竟什么是A/B测试?本文对此展开分析。

A/B测试是一种通过一些客观指标,对比不同方案来衡量哪种效果更佳路径的评估方式,其优势在真实环境,通过部分用户产生的用户行为数据和业务数据,验证不同的设计方案,最后分析、评估出最优方案再加以正式应用。

A/B测试的场景不胜枚举,那么如何进行科学的A/B测试?原味提供两个关键点:分群和评估,接下来用7步法来锁定A/B测试评估策略:

一、A/B测试策略制定

A/B测试永远是基于策略出发的,在有明确的策略后,才能够找到验证策略是否有效的用户群,并且用合理的指标去做评估分析。

在这个步骤,通常会经历策略提出、策略打分、策略确定三个步骤。

不管是哪种应用场景,在A/B测试策略制定这一步每个人都会有自己的想法,这就导致会产生许多策略,但不必将每个策略都作为实验组上线测试,否则在前期的物料准备、方案实现等环节会花费巨大的成本。

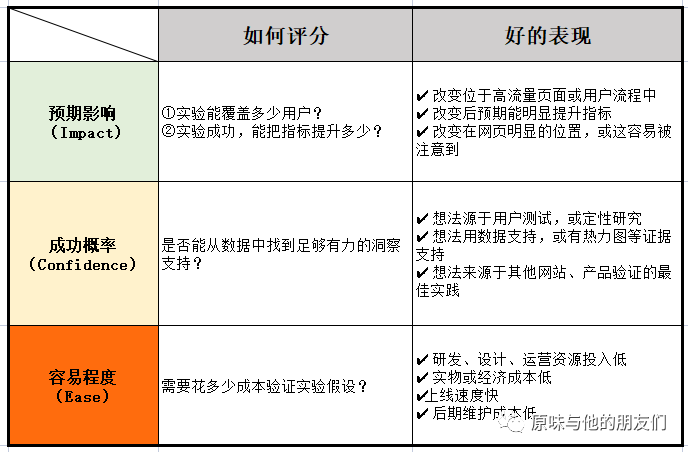

团队内部做决策时可以使用ICE模型对各项指标进行打分,然后通过每个策略的三个因子的分数加总,找到得分最高的几个策略进行A/B测试。

二、测试目标(评估指标)选择

在策略评估中,评估指标是非常重要,那如何选择指标,这里需要以OSM模型为基础,从大目标(O)出发,找到能够达到该目标的策略(S),用合理的指标(M)去追踪策略是否能够达成业务目标。

在测试过程中预估实验样本量也需要控制好。

- 若样本数量太少,产生的结果容易受到异常样本的干扰,导致结果不具备通用性。

- 若样本数量太大,测试流量过多,就会造成试错成本的增加,会影响后期的判断。

在测试过程中预估实验周期性也需要控制好。

- 若测试时间太短,没有足够的样本进入实验组,难以得出有效结论。

- 若测试时间太长,就会产生维护线上多个版本的成本,难控制局面。

这里推荐个测试AB测试工具-A/B测试样本计算器,输入相关参数即可预估测试实验转化后的数据,这里有根据自身节奏调整样本数:

影响实验所需样本数的因素:

原版本的转化率:

原版本的转化率较低,意味着信号更弱,需要样本数越多。

新版本的转化率:

预期和原版本的转化率差别越小,要求检测的敏感度就越高,因此需要的样本数越多。

统计显著性要求:

一般建议至少要求95%的统计显著,统计显著性要求越高,意味着对结果需要更确定,因此需要的样本数越多。

(统计显著性:告诉实验者优化版本转化率与原始版本转化率相比,两者不同的概率有多大,也就是说,它能回答优化版本上的改变是否真的对转化率产生影响。)

三、科学分流

A/B测试的分流是否均匀是影响实验结果的重要因素,一般分流的方式是基于用户ID或者设备ID等能够标识用户的唯一编码,通过算法将用户随机分到不同的“桶”里

例如,有60个用户,获取这60个用户的ID,根据用户ID进行分流,将这60个用户随机均匀分散到6个“桶”中。

完成“桶”分流后,需要做的就是根据实验要求从这些“桶”中选取对应的流量进入测实验组。

A/B测试的基本原理是控制变量,在分流中需要确保样本平衡分布,即不同“桶”的人群特征是均匀分布的,不能实验分组时,实验A全是老人或实验B都是女生,这样测出的结论数据都会影响营销决策,无意义分流。

四、A/A测试

为了确保样本的均匀分布,排除由于样本自身差异带来的影响,一般会在A/B测试前进行A/A测试,也可以在A/B测试中划出一部分流量同时进行A/A测试。

A/A测试,顾名思义就是实验中下发的策略都是一致的。

在此前提下,对比每组是否有显著差异,如果存在显著差异,那么在实验的分流、埋点或者数据统计中至少有一项必定存在问题,所以,A/A测试运营的意义就是增加A/B测试的实验结论可信度。

- 一方面,发现用户识别问题及用户分流问题,及时修复,确保数据的准确性。

- 另一方面,排除样本用户的属性干扰,保证用户特征分布一致,确保实验差异仅由变量造成。

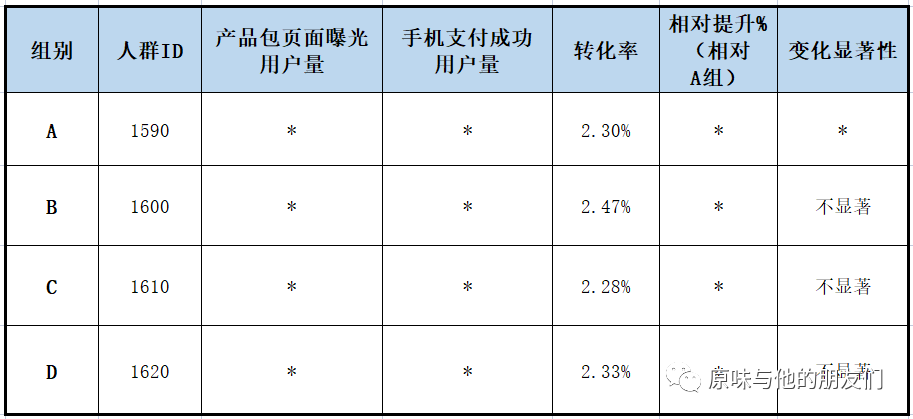

用影视会员产品转化率的例子来解释A/A测试,下图是影视会员产品付费页的付费转化率项目的A/A测试结果。

排查时发现是对用户的唯一识别出现了问题,修正后接着进行A/A测试,最后各组用户的差异不显著,可以认为用户特征分布基本一致。

五、策略投放

在企业真实环境中,会有很多A/B Test实验,所以策略投放需要先判断不同实验之间的关系。

①正交实验:实验之间相互不影响。

例如,实验组1是测试不同按钮颜色的实验,实验组2是测试不同广告算法的实验,实验组1的按钮颜色是不会影响到实验组2广告算法的效果,所以实验组1和实验组2之间是正交实验。

②互斥实验:实验之间存在相互影响。

例如,实验1是测试温控限频策略对温度的影响,实验2是测试温控降亮度对温度的影响,实验1和实验2都会影响温度,所以实验1和实验2之间互斥。

全局流量基本是固定的大小,不可能说划分的每个流量群体在同一时刻只开展一个实验,不然容易发生流量饥饿。

所以在策略投放中需要合理的控制变量,选择好一个固定的北极星指标,随后将目标进行合理拆解细分目标,进行投放测试,选择最优路径策略来作为A/B测试的最终方案。

六、数据监控

这块不细说了,因为每家公司的数据监控的工具都不同,有自己研发的数据测试看板或者第三方服务商提供的数据监控。

AB测试的数据看板不必过于复杂,目的是快速展现各组的关键指标变化趋势及是否满足统计显著性。

七、策略结果分析与执行

A/B测试结束后,通过数据看板可以确定本次测试是否具备显著性,也就是策略是否有影响。

影响不一定都是正向影响,一般对于实验结果:显著大幅正向>显著小幅正向>显著负向>没有统计显著性,对于负向显著的结果不要害怕,起码这个结果告诉我们不应该做哪些东西。

完成一次A/B测试后,业务方需要将显著有效的策略放量,将其应用到更多人群中,并且找到该策略的优化点,进行迭代的A/B测试。

对于显著无效的策略,需要分析无效的原因并进行策略迭代、调优。

这样不断在原有结论的基础上持续进行A/B测试,每次测试都是“上台阶”的过程,随着测试的次数增长,带来的收益会持续增加,对团队的自信心也会逐渐上升,减少投入成本,实现迭代式增长。

本文由 @原味的运营笔记 原创发布于人人都是产品经理,未经许可,禁止转载。

题图来自Unsplash,基于 CC0 协议

起点课堂会员权益

起点课堂会员权益

AB测试的数据看板不必过于复杂,目的是快速展现各组的关键指标变化趋势及是否满足统计显著性。

为同一个优化目标制定两个方案,让同一部分用户中的一部分用户命中 A 方案,同时另一部分用户命中 B 方案