超强Siri即将到来!苹果10篇重磅AI研究全总结,iOS 18关键一瞥

一直以来,苹果在大模型、语音助手上的研究不断推陈出新,或许我们能够从中获得iOS 18所具备AI能力的关键一瞥。

「Siri太笨,根本无法与ChatGPT竞争」,前苹果工程师John Burkey曾对Siri的评价如此不堪。

不过,诞生于11年的Siri,终于要迎来翻身的机会。

ChatGPT横空出世之后,微软、谷歌等科技巨头,甚至OpenAI、Anthorpic AI等初创,都在你追我赶激烈地角逐。

在AI竞赛上,苹果却一直姗姗来迟。

其实,早有传言和报道称,在过去几个月中,苹果实际上一直再等待一个时机,做出反击。

先是与谷歌谈判被爆出,后是与OpenAI开展合作,预计将AI模型能力整合进下一代iOS 18系统中。

除此以外,苹果研究团队也在一直开发自己的模型——Ajax。

而且,最近几个月,苹果在大模型等研究上的成果频出,意味着这些AI能力可能会成为现实。

距6月开发者大会WWDC,也就不过一个月左右的时间,或许我们可以从这些研究中,一瞥苹果的AI能力。

一、更小、更高效LLM装进iPhone

相信所有人的期望都是一样的——想要一个更好的Siri。

而现在看起来,换新的Siri即将到来,完成超强进化!

ChatGPT之后,大模型诞生的数量也是数不胜数,然而许多科技公司都希望LLM能够赋能虚拟助手,让其变得更优秀,更智能。

对于苹果来说,想要让Siri不再被人,说笨就需要尽快构建这些模型,让其能装进手机。

彭博最近报道,在iOS 18中,苹果计划让所有AI功能,都运行在设备上,而且可以完全离线使用。

而现在的困难是,即便你有一个数据中心和数千个GPU组成的网络,要建立一个良好的多用途的模型,并装进手机,是非常困难的。

因此,苹果不得不发挥创意。

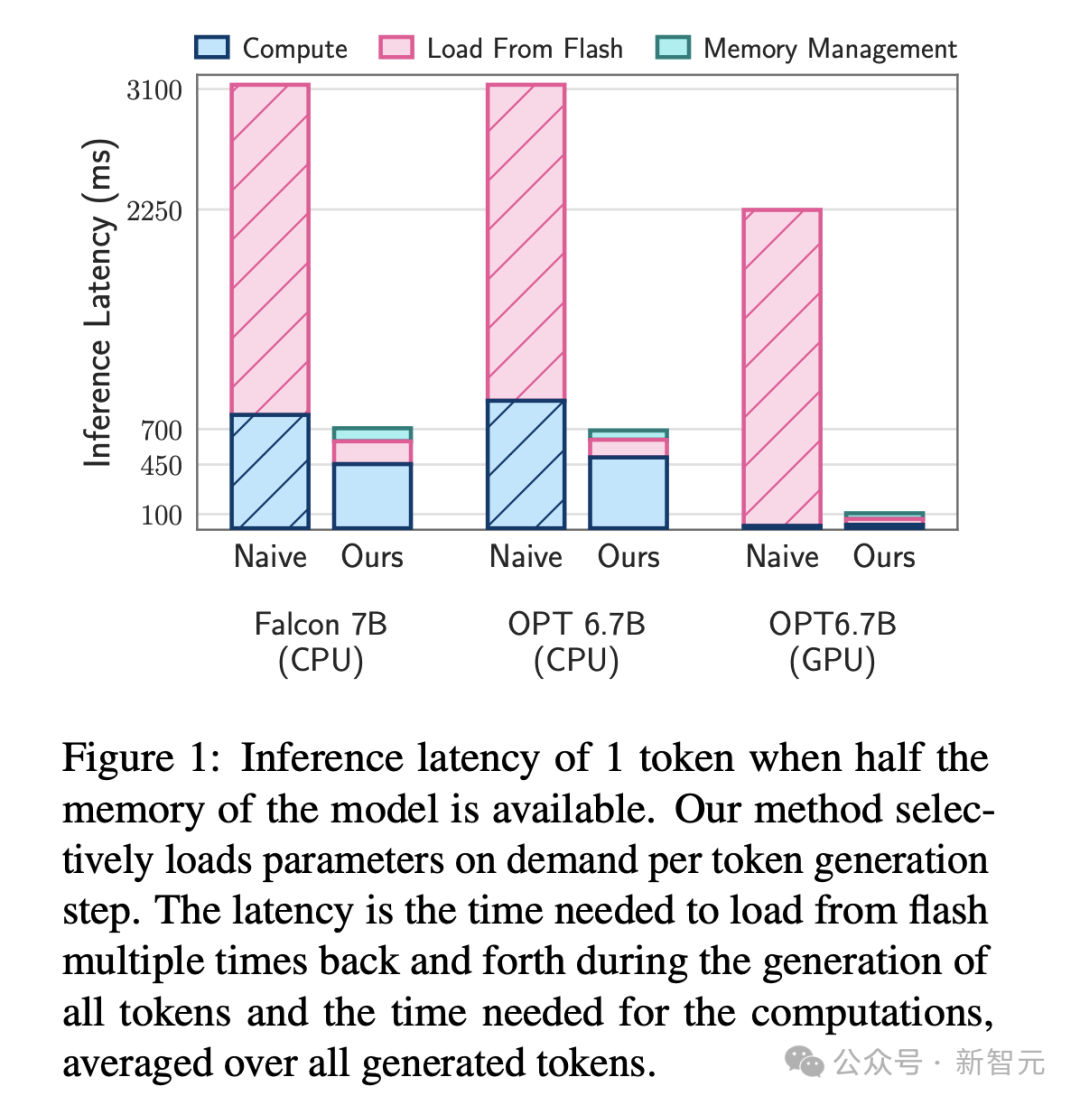

在一篇名为LLM in a flash: Efficient Large Language Model Inference with Limited Memory的论文中,研究人员设计了一个系统,可以将通常存储在设备RAM中的模型数据,存储到固态硬盘(SSD)上。

论文地址:https://arxiv.org/pdf/2312.11514

具体来说,研究证明了,在SSD上运行的LLM的大小,可以达到可用DRAM的2倍。

与传统的CPU加载方法相比,推理速度提高了4-5倍,而GPU提高了20-25倍。

他们发现 ,通过利用设备上最廉价的可用存储模型,模型可以运行得更快、更高效。

此外,苹果的研究人员还创建了,一个名为EELBERT的系统,可以将大模型压缩到更小的规模,同时不影响其性能。

通过对谷歌Bert模型进行压缩后,体积缩小了15倍,只有1.2兆字节,质量只降低了4%。

不过,这也带来了一些延迟问题。

论文地址:https://arxiv.org/pdf/2310.20144

总而言之,苹果正努力解决模型领域的一个核心矛盾:模型越大越好用,但在终端上耗电快运行慢。

与其他科技公司一样,苹果正在这一点上找到平衡。

二、Siri完成超进化!

苹果研究AI终归解决一个至关重要的问题,如何让Siri变得更加出色。

在内部,苹果团队设想开发一种,无需唤醒词Hey Siri或Siri,就能使用AI助手的方法。

没有声音提示,那该如何让设备通过「直觉」判断一个人在讲话?

这一难题,比语音触发检测更具挑战性。

苹果研究团队不得不承认,这是因为可能没有一个主要的触发语,来标志语音命令的开始。

论文地址:https://arxiv.org/pdf/2403.14438

这也许就是,为什么另一组研究人员,开发出了一个系统可以更准确地检测唤醒词。

论文地址:https://arxiv.org/pdf/2309.16036

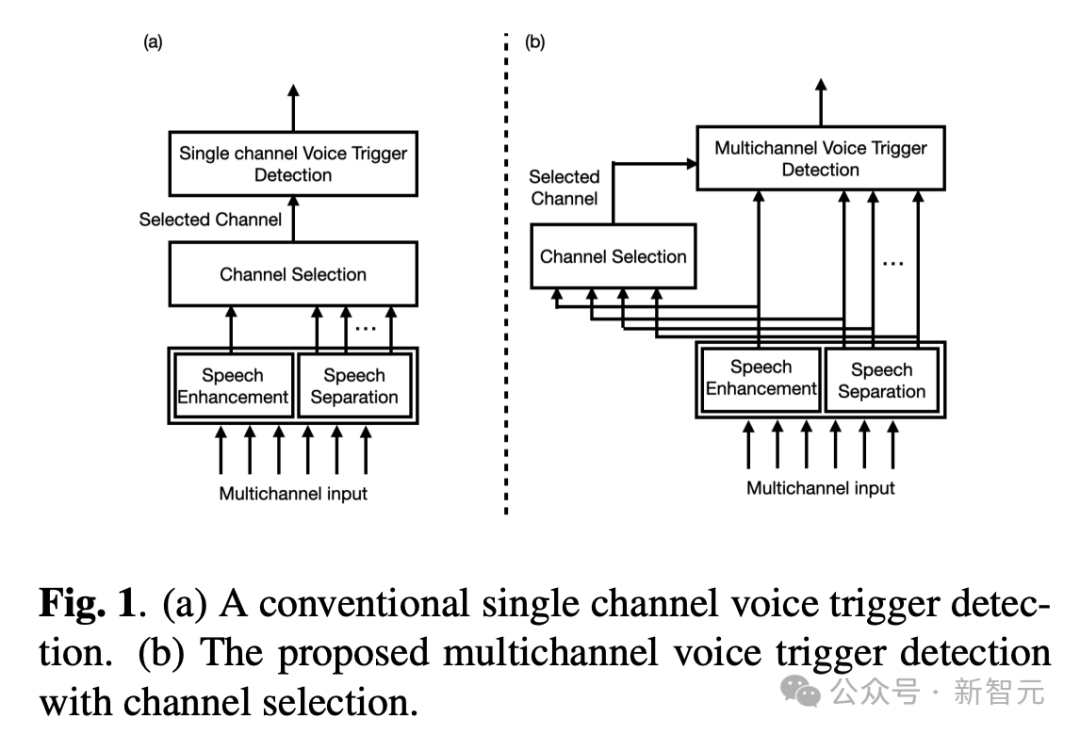

具体来说,作者提出了语音触发(VT)的多通道声学模型,将前端的多通道输出直接输入VT模型。

他们采用了TAC(Transform-Average-Conatenate)模块,并通过合并来自传统通道选择的通道,对TAC模块进行了修改,让模型能够在存在多个说话人的情况下关注目标说话人。

与基线通道选择方法相比,该方法的误拒率降低了30%。

而在另一篇论文中,研究人员训练了一个模型,以更好地理解不太容易被AI助手理解的罕见词。

论文地址:https://arxiv.org/pdf/2310.07062

在这两种情况中,LLM的魅力在于,理论上它可以更快地处理更多信息。

例如,在关于唤醒词的研究中,研究人员发现,如果不试图摒弃所有不必要的声音,而是把所有声音都输入模型,让它来处理哪些是重要的,哪些是不重要的,那么唤醒词的效果就会可靠得多。

一旦Siri听到你的声音,苹果就会做很多工作,以确保它能更好地理解和沟通。

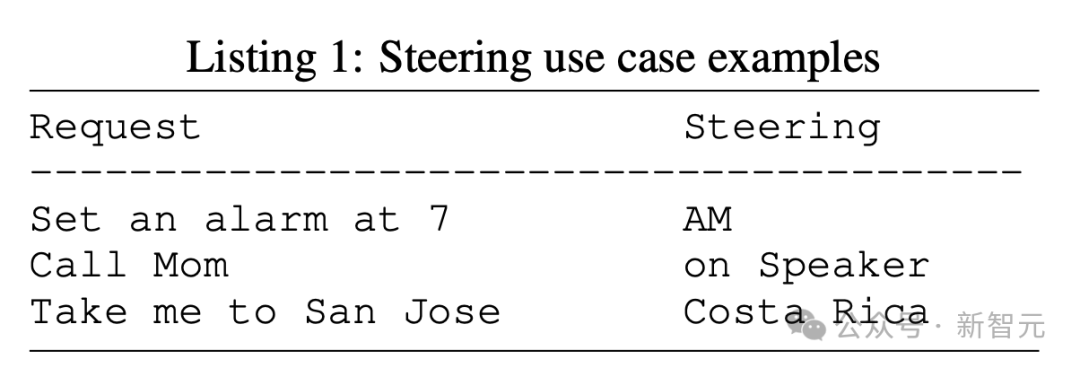

在另一篇论文中,苹果还开发了一个名为STEER系统,旨在改善用户与助手之间的交流。

论文地址:https://arxiv.org/pdf/2310.16990

在另一个例子中,它使用LLM来更好地理解「模棱两可的问题」,无论你怎么说,它都能弄清楚你的意思。

在不确定的情况下,智能对话智能体可能需要主动提出好的问题,从而更有效地解决问题,从而减少不确定性。

在另一篇论文也旨在帮助解决这个问题,研究人员利用大模型使助手在生成答案时不再冗长,更容易理解。

三、苹果每个应用,将被AI重构

除了关注原始的技术发展,苹果也非常关注人工智能的日常应用。

对于苹果来说,一个重点领域就是健康:

LLM可以帮助分析处理各种设备收集到的大量生物识别数据,并帮助理解这些数据。

苹果可以通过研究收集和整理你的所有运动数据,利用步态识别和耳机来识别你的身份,以及如何跟踪和理解你的心率数据,来监测你的身体状况,为你提供合适的安全建议

苹果还把人工智能想象成一种创造性工具。

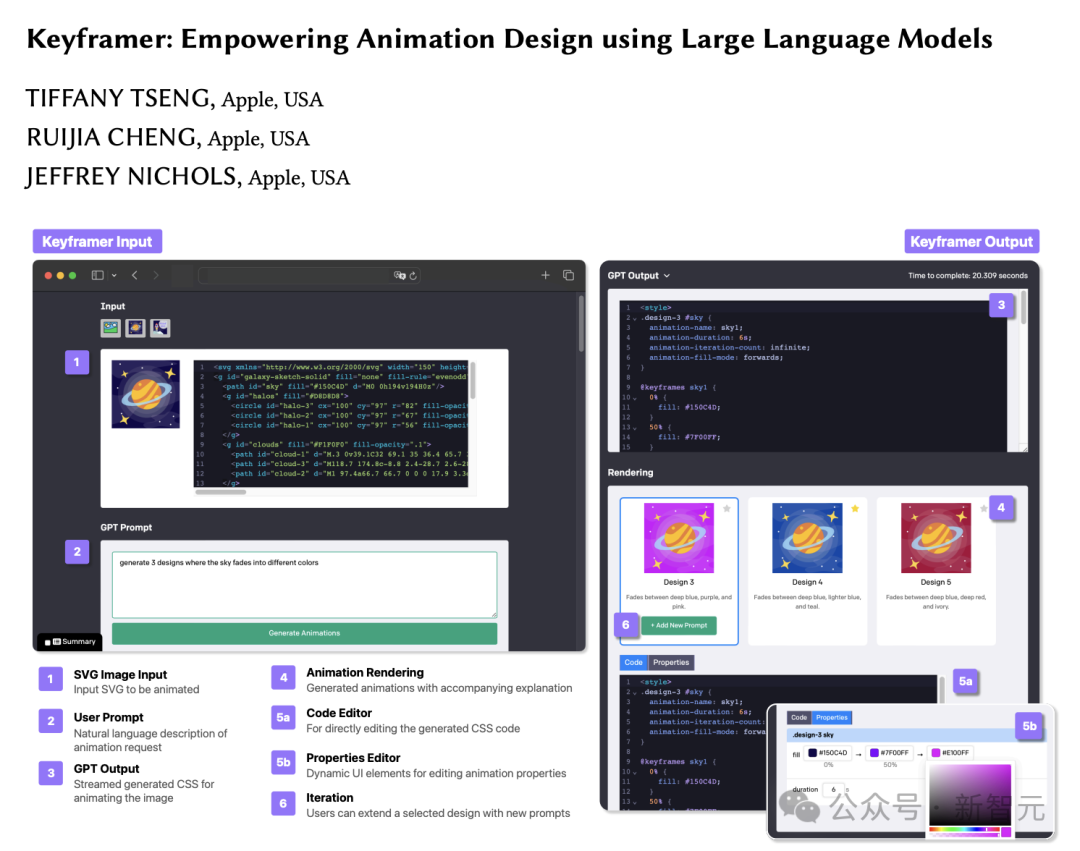

在2月发表的一篇论文中,苹果团队采访了一批动画师、设计师和工程师,并构建了一个KeyFramer系统。

这一系统,可以让用户迭代地构建和改进生成的设计。

用户只需要先输入一个提示,然后得到一个工具包,可以根据自己的喜好调整和完善图片的某些部分。

论文地址:https://arxiv.org/pdf/2402.06071

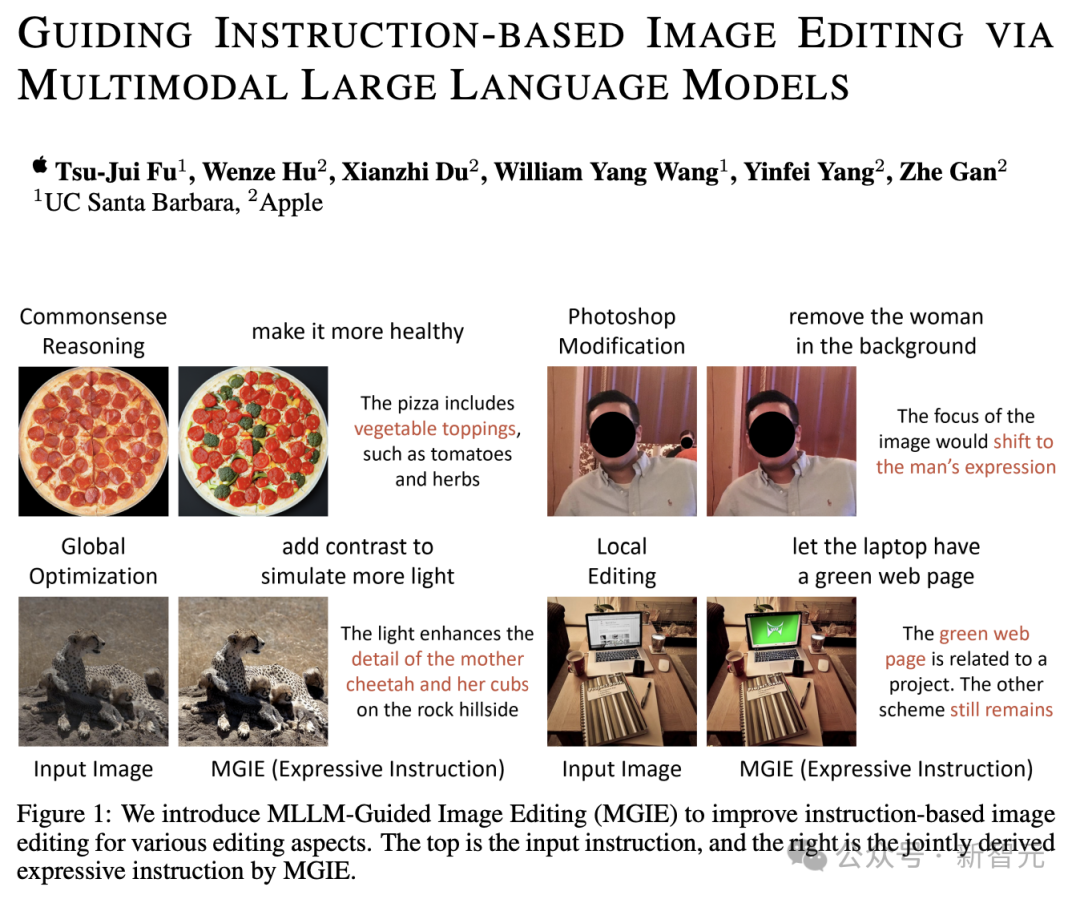

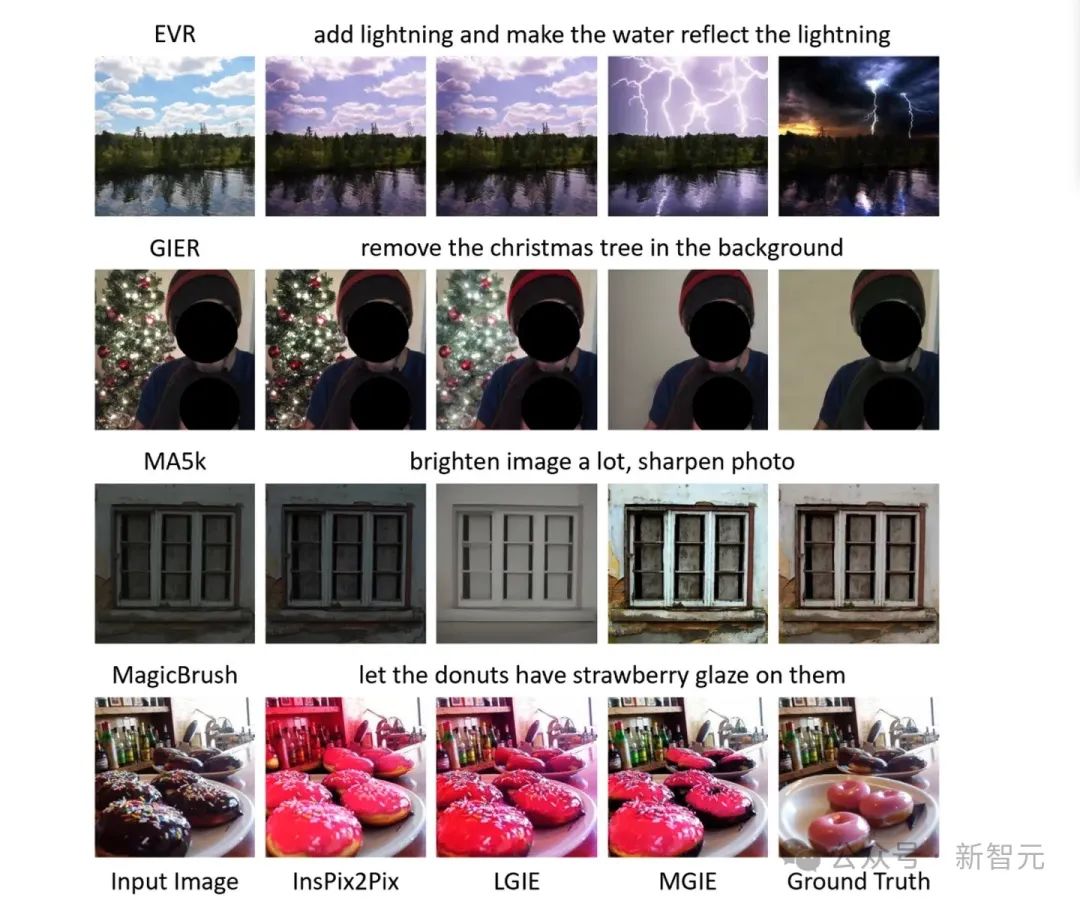

此外,苹果还有开发了一款名为MGIE的工具,可以让你通过描述内容来编辑图片(比如「让天空更蓝」、「让我的脸不那么怪异」、「添加一些石头」等等)。

论文地址:https://arxiv.org/pdf/2309.17102

论文中,研究人员表示,MGIE不需要简短但含糊的提示,便可以明确地推导出视觉感知的意图,从而实现合理的图像编辑。

「最初的实验并不完美,但令人印象深刻」。

未来,苹果还有可能将AI用在音乐中。

在一篇名为Resource-constrained Stereo Singing Voice Cancellation的论文中,研究人员探索了将歌曲中的声音与乐器分离的方法。

论文地址:https://arxiv.org/pdf/2401.12068

比如,像在TikTok或Instagram上那样混音歌曲,这个AI可能会派上用场。

随着时间的推移,苹果会在iOS 上,在自身的生态系统中内置一些功能,也会以API的形式提供给第三方开发者。

之前苹果一直在大肆宣传自己的硬件能力,尤其是与普通的安卓设备相比。

将所有这些功率与设备上注重隐私的人工智能相结合,可能会成为苹果一个很大的差异化优势。

这次iOS 18强势来袭,网友一如既往地对苹果期待感满满。

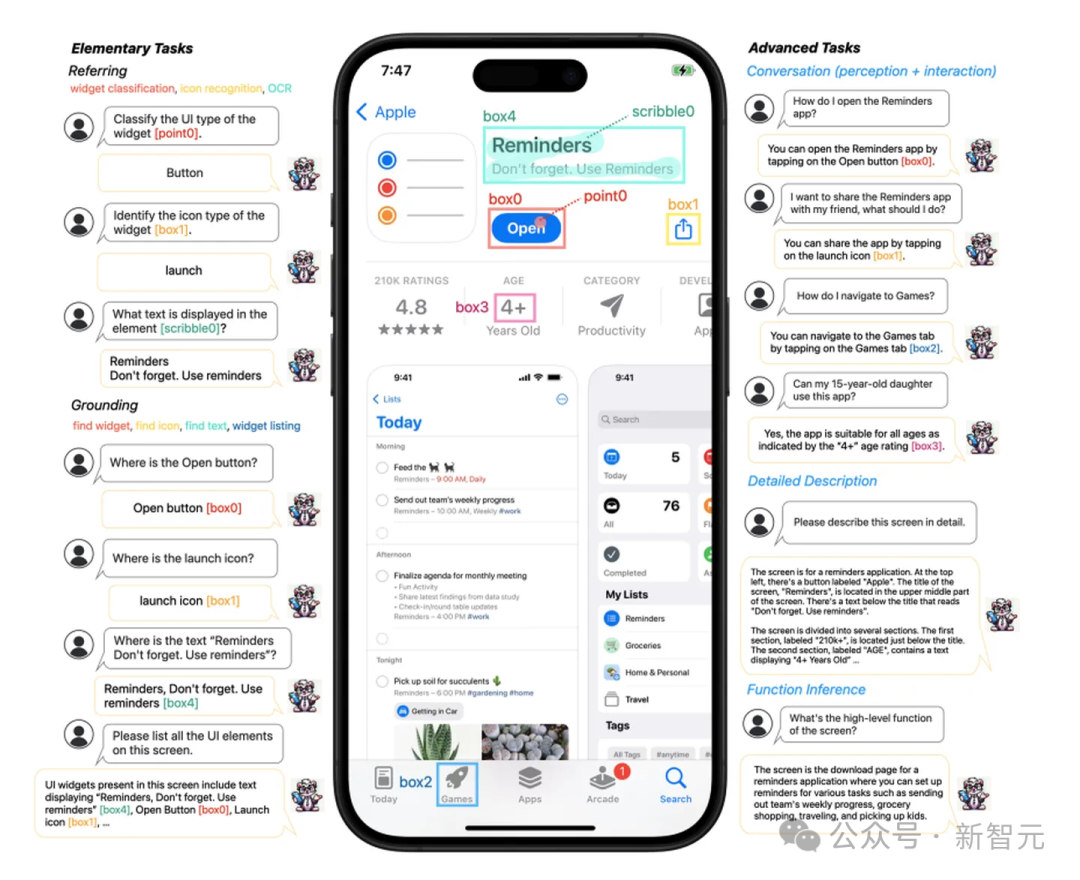

值得一提的是,苹果在多模态大模型方面研究,也引来众多的关注。

Ferret堪称苹果最大型、最雄心勃勃的人工智能项目。输入提示之后,它可以关注你选择的特定事物,并理解周围的世界。

论文地址:https://arxiv.org/pdf/2404.05719

甚至,Ferret还可以帮助你导航应用程序、回答有关App Store评级的问题、描述你正在看的内容等等。

一旦这种技术得以应用,可能彻底改变每个人使用手机的方式,以及Vision Pro和智能眼镜的使用方。

虽然目前这些都只是研究成果,但是如果能在今年春天开始顺利运行,那将是一项闻所未闻的技术成就。

WWDC大会即将发布的大型人工智能模型,必然会把技术狂欢推向新一轮的高潮。

苹果或会全面改版iPhone产品,也就意味着你的下一台iPhone不必是iPhone。

这一切都在库克的预料之中,接下来就等着瞧好吧。

参考资料:

https://www.theverge.com/2024/5/5/24147995/apple-siri-ai-research-chatbot-creativity

本文由人人都是产品经理作者【新智元】,微信公众号:【新智元】,原创/授权 发布于人人都是产品经理,未经许可,禁止转载。

题图来自Unsplash,基于 CC0 协议。

- 目前还没评论,等你发挥!

起点课堂会员权益

起点课堂会员权益