机器学习之线性回归算法

线性回归算法是机器学习中一种基于假设自变量和因变量之间存在线性关系的统计学习方法。本文分享了线性回归算法的基本原理、实现步骤和应用场景,供大家参考。

一、什么是线性回归算法?

线性回归算法是一种基于假设自变量和因变量之间存在线性关系的统计学习方法。

也就是说,我们认为因变量y可以表示为自变量x的线性组合加上一个随机误差项。例如,如果我们有一个自变量x和一个因变量y,那么我们可以假设它们之间的关系为:

y = wx + b + e

其中w是线性系数,b是截距项,e是误差项。我们的目标是根据已知的x和y的数据,找到最合适的w和b,使得误差项e的平方和最小。这就是最小二乘法的思想。

如果我们有多个自变量x1,x2,…,xn和一个因变量y,那么我们可以假设它们之间的关系为:

y = w1x1 + w2x2 + … + wnxn + b + e

其中w1,w2,…,wn是线性系数,b是截距项,e是误差项。我们同样要找到最合适的w1,w2,…,wn和b,使得误差项e的平方和最小。

二、线性回归算法的基本原理是什么?

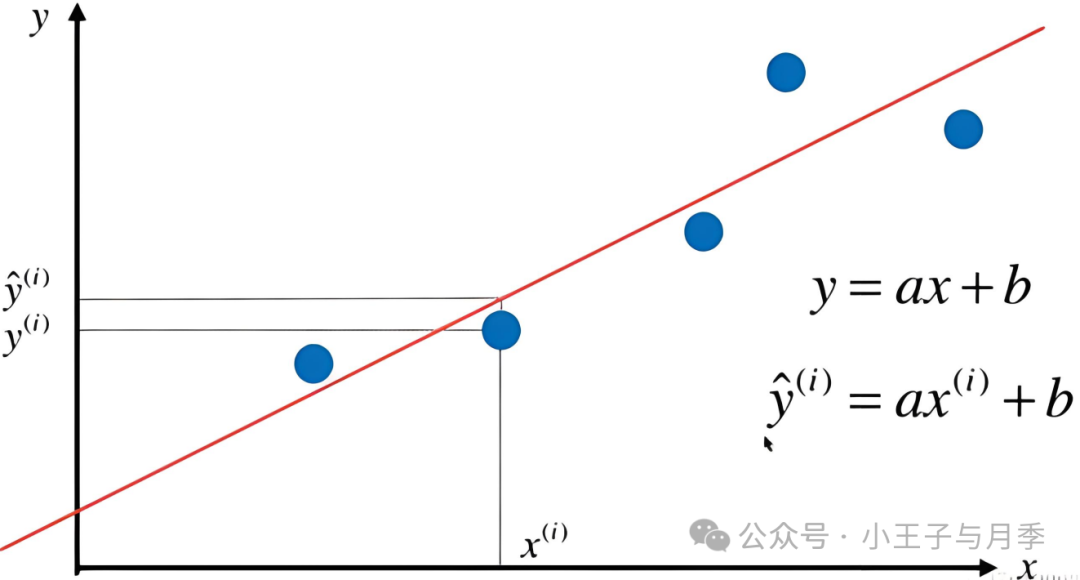

所以线性回归算法的思路就是:根据已有的数据去寻找一条“直线”,让它尽可能的接近这些数据,再根据这条直线去预测新数据的结果。

那么具体要怎么找这条“直线”呢?初中数学里描述一条直线时,用的是一元一次方程:y=ax+b,这里的a表示直线的斜率,b表示截距,如下图所示:

以排队为例,我们已知x是人的顺序,y是排的位置,将已有的x和y数据代入到公式中,可以得到一组合适a和b的值来描述这条直线,也就是我们找到了这条直线的分布。

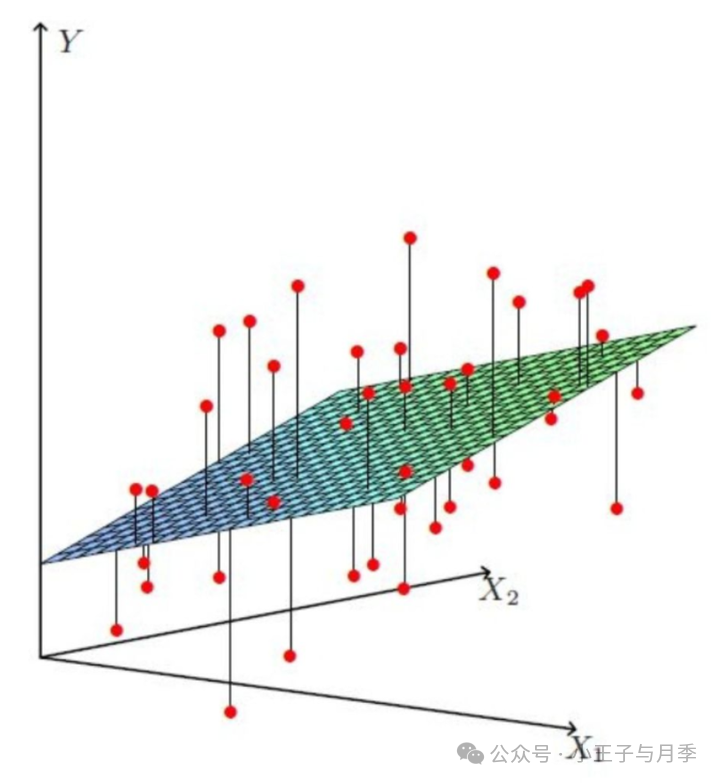

上面比较简单,只有一个x变量,在实际的应用中,会有很多个影响结果的变量,比如预测贷款额度时,会有工资、是否有房等变量,用线性回归的思路解决类似的问题,就要构建多元回归方程了,公式也就变成了 y = a1x1 + a2x2 + … + b。

当有两个变量时,线性回归的分布也就不是一条简单的直线了,而是一个平面,如下图所示:

如果有更多的变量,分布就是一个超平面,找到它的分布也会变得更复杂。

如何计算最优解?

机器学习中,评价模型的预测值和实际值差异的公式叫做损失函数,损失函数值越小,模型性能越好。对于线性回归模型,我们通常使用平方残差和(SSE)或均方误差(MSE)作为损失函数。

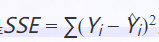

平方残差和的公式为:

Yi代表实际观测值,而 代表模型预测。通过计算每个观测值与对应预测值之间的差异(即残差),并求其平方和,可以得到残差平方和。这个值越大,说明实际观测值与模型预测值之间的差异越大,即模型的拟合效果越差;反之,则说明模型拟合得较好。

代表模型预测。通过计算每个观测值与对应预测值之间的差异(即残差),并求其平方和,可以得到残差平方和。这个值越大,说明实际观测值与模型预测值之间的差异越大,即模型的拟合效果越差;反之,则说明模型拟合得较好。

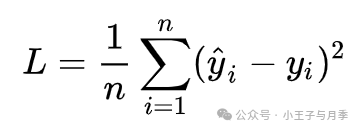

均方误差公式为:

对于线性回归模型,我们通常使用梯度下降法(GD)(也可用最小二乘法)求得线性回归方程参数。梯度下降法是一种迭代式的算法,每次沿着损失函数的负梯度方向更新参数,直到收敛到最小值。

三、线性回归算法的实现步骤是什么?

- 数据预处理:将原始数据进行归一化、缺失值处理、异常值处理等预处理操作,得到训练集和测试集。

- 特征提取:从原始数据中提取出自变量和因变量的特征,通常采用的是最小均方误差(MSE)作为特征提取的度量标准。

- 模型建立:根据特征提取的结果,建立线性回归模型。线性回归模型的一般形式为:y = w1 * x1 + w2 * x2 + …+ wn * xn + ε。其中,w1,w2,…,wn是线性系数,ε是随机误差项。

- 参数求解:使用梯度下降法求解模型的参数。根据步骤3,计算得到模型的参数w1,w2,…,wn和b。

- 模型训练:使用训练集对模型进行训练,得到最优的模型参数和训练集。

- 模型评估:使用测试集对模型进行评估,计算模型的预测结果与真实结果之间的均方误差(MSE),作为模型的评估指标。

四、优缺点

- 线性回归算法的优点:

- 可解释性强:可以提供每个特征对目标变量的影响程度,有助于理解变量之间的关系。

- 运算效率高:计算速度较快,适用于大规模数据集。

- 简单而直观:易于理解和解释,适用于初学者入门。

- 可扩展性强:它可以轻松应用到多元线性回归,也可以应用于非线性回归。

线性回归算法的缺点:

- 仅适用于线性关系:线性回归假设自变量与因变量之间存在线性关系,对于非线性关系的数据拟合效果较差。

- 对异常值敏感:线性回归对异常值较为敏感,异常值的存在可能会对模型的拟合产生较大影响。

- 数据较小时容易出现过拟合现象。

- 对多重共线性敏感:线性回归无法捕捉到特征之间的非线性、交互作用等复杂关系。当自变量之间存在高度相关性时,线性回归模型的稳定性和可靠性可能会受到影响。

五、应用场景

线性回归的应用场景非常广泛,只要数据是符合线性分布的,理论上都可以用线性回归来进行预测与分析,如风险评估预测、疾病预测、员工绩效预测、销售预测、交通流量预测等。

- 金融和保险:线性回归算法可以用来进行保费计算、风险评估等金融和保险领域的应用。

- 运动和健康:线性回归算法可以用来进行运动员的表现预测和评估,例如预测运动员的速度、步幅等。

- 预测员工绩效:通过分析员工的教育背景、工作经验、培训等因素与绩效之间的关系。

- 营销分析:分析市场调研数据,预测产品销售量,并确定哪些因素对销售量有显著影响。

- 交通规划:预测交通流量,通过分析道路特征、人口密度等因素与交通流量之间的关系。

- 环境科学:分析环境数据,如气候变化、污染物排放等因素与生态系统的影响。

参考:

了解线性回归的算法

线性回归算法:用“线性外推”的思路做预测-人人都是产品经理-AI小当家

作者:厚谦,公众号:小王子与月季

本文由@厚谦 原创发布于人人都是产品经理,未经作者许可,禁止转载。

题图来自Unsplash,基于CC0协议。

该文观点仅代表作者本人,人人都是产品经理平台仅提供信息存储空间服务。

- 目前还没评论,等你发挥!

起点课堂会员权益

起点课堂会员权益