从0到1玩转AB测试评估体系搭建

本文以一个拥有数千万用户的头部物流APP为例,详细介绍如何基于Google的多层实验框架建立AB测试评估体系,从而精确度量和改进产品的多种交互场景。

一、应用场景

某头部互联网APP目前拥有数千万级别的用户量,每天有数百万用户在app上使用寄快递、查快递、网点查询、运费查询等相关服务。

在日常用户精细化运营中,需要准确评估大量交互场景,以辅助业务决策。

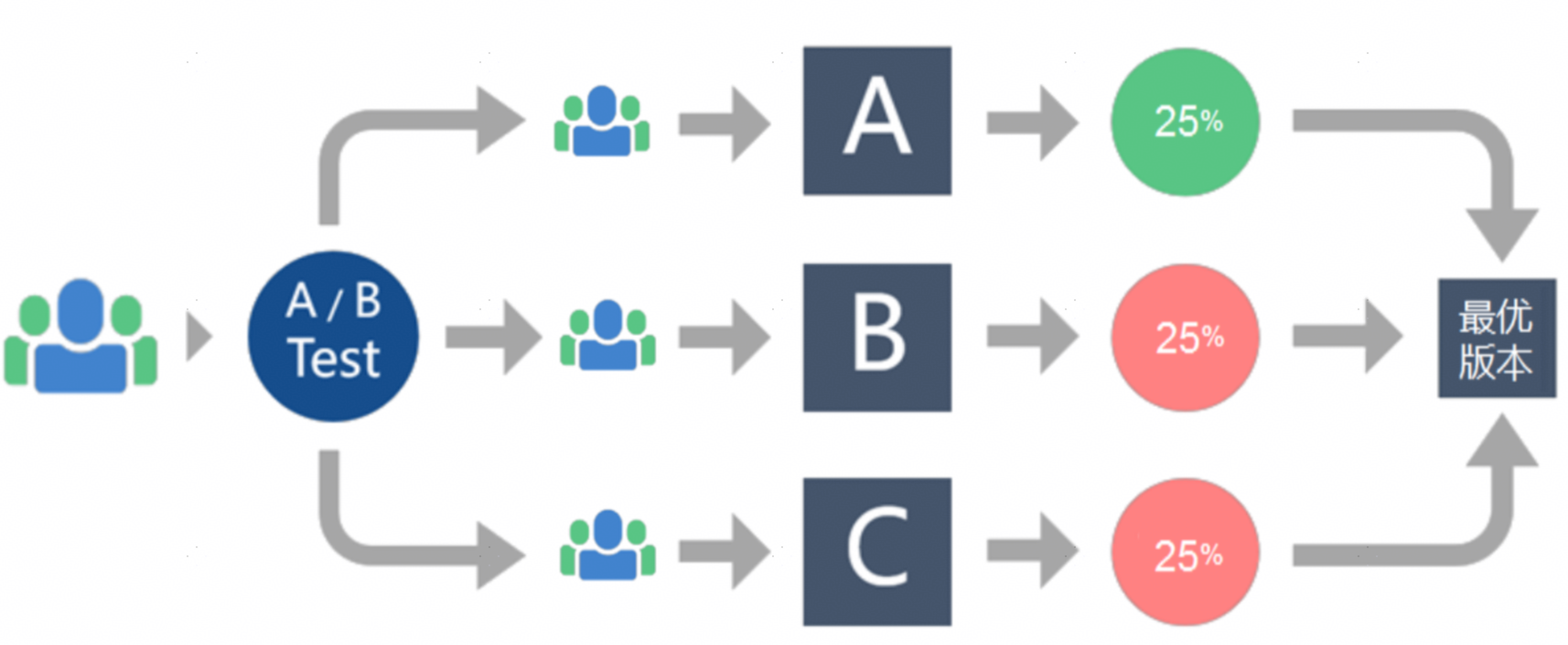

AB测试是一种常用的数据驱动方法,用于评估不同版本的用户界面、功能或设计。

它旨在帮助决策者了解哪个版本能够更好地满足用户需求,优化产品并改善用户体验。

本文将基于Google多层实验框架原理,来进行AB测试评估体系搭建的探索研究。

二、解决方案

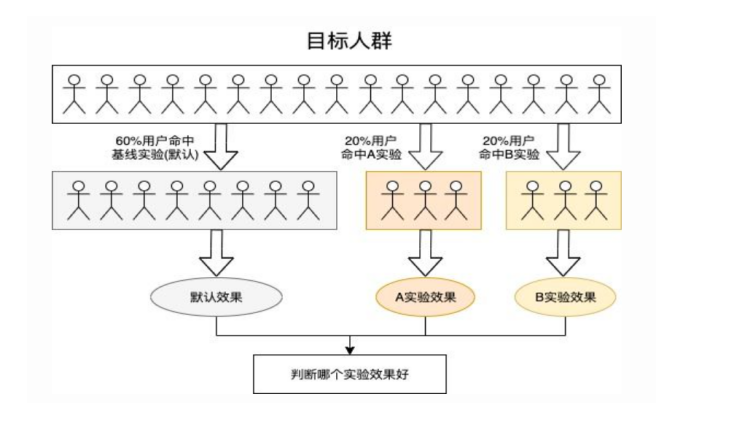

AB测试通过为同一个迭代目标制定两个或多个策略方案,并在同一时间维度内让具有相同(或相似)组成成分的A/B群组分别采用这些策略,收集各群组的体验数据和业务数据,最后分析评估出最佳策略,使迭代朝着更好的方向演进。

1. 关键步骤

AB测试评估体系构建通常包括以下3个关键步骤:

(1)样本量测算;

(2)样本分流;

(3)评估机制(显著性检测)

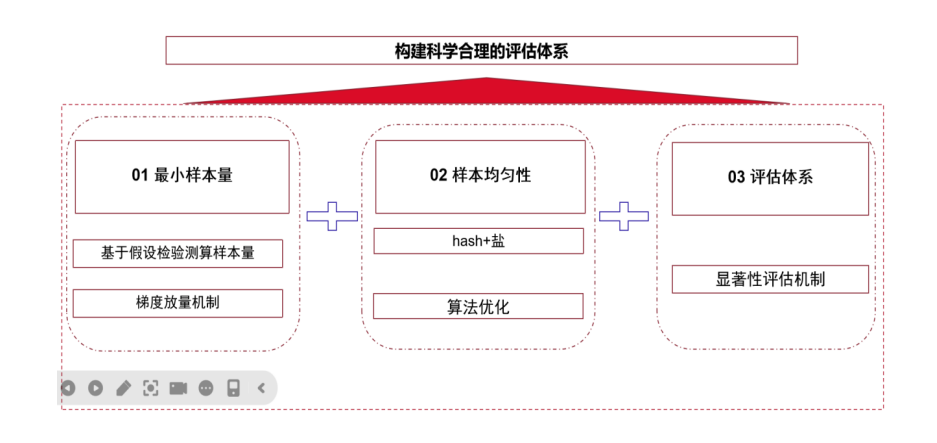

2. 样本量测算

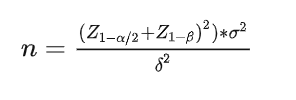

在AB测试中,样本量的测算至关重要。样本量大小会影响实验结果的可靠性和统计显著性。以下是常见的样本量测算公式:

其中:

n为总样本量;

α和β分别为第一类错误概率和第二类错误概率,一般取0.05和0.2;

Z为正态分布的分位数函数, Z1−α/2=1.96,Z1−β=0.84;

δ代表预期实验组和对照组两组数据的差值。

在AB测试中还会涉及到样本随机化和多重检验校正等。建议根据具体情况综合考虑这些因素,以确保获得合适且有效的样本量。

3. 样本分流

在Google多层实验框架中,样本hash分流是一种常见方法。

基于分流算法,将样本均匀地分配至不同实验中。在实际操作过程中使用参与者的唯一标识符(如会员号或Cookie)作为输入,并将其通过哈希函数转换为一个固定范围内的哈希值。该哈希值可用于确定参与者被分配到哪个实验组。

通过使用hash分流方法,可以确保每个参与者在样本中都具有相同概率被随机地分配到不同实验组,并减少偏差,在评估不同变体之间的差异时保证可靠性。

4. 显著性评估

构建AB测试显著性评估机制非常关键,它有助于确定实验结果是否具有统计上的显著性。步骤如下:

Step 1:确定希望使用的显著性水平(即第一类错误指拒绝了正确假设),通常情况下表示为α。

Step 2:确定所需样本量:为确保实验结果达到所需统计显著性水平,在目标效应大小、所选显著性水平和统计功效之间进行计算。

Step 3:选择适当的统计检验方法:根据实际设计和指标类型选择适当的统计检验方法(如t检验或卡方检验)。

Step 4:在实验结束后收集实验组和对照组数据,并使用所选统计检验方法进行假设检验,并基于观察到差异计算P值。

Step 5:P值代表观察到结果或更极端结果出现概率。如果P值小于预先设定的显著性水平,则可以拒绝原始假设并得出结论认为结果具有统计上显著性。

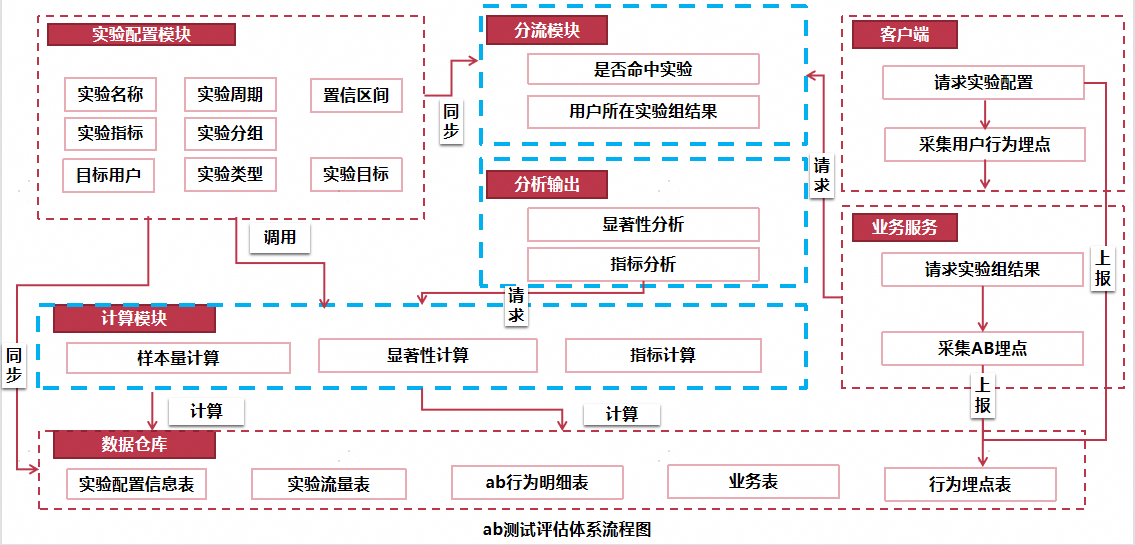

5. ab测试评估体系流程图

基于上述最小样本量测算、hash分流以及显著性评估等步骤,在构建AB测试系统时可以考虑以下模块:实验配置、分流、计算、分析输出等模块。

重要模块功能说明

(a)实验模块:由业务方完成相关配置,例如定义实际评估指标、设置实际评估周期以及确定实施方式;

(b)计算模块:基于历史数据值来完成当前所需最小样本量测算;

(c)分流模块:根据最小样本量以及配置好的分组信息利用hash打散方式 进行均匀分流(推荐采用二次hash方式来规避碰撞问题),以保证样本共享且被随机地划入不同试验证明理义;

(d)分析输出模块:采用所选统计检验证法进行假设检义,并通过比较观察到结果与初期设定阈值来判断是否存在显着差异。

完整ab测试系统数据流程图如下图所示。

三、应用案例

基于Google多层实验框架进行线增ab测试评估体系的搭建,1年里累计支撑业务评估实验1000+项。

本文由 @佑佑和博博~ 原创发布于人人都是产品经理,未经许可,禁止转载

题图来自Unsplash,基于 CC0 协议

该文观点仅代表作者本人,人人都是产品经理平台仅提供信息存储空间服务。

- 目前还没评论,等你发挥!

起点课堂会员权益

起点课堂会员权益