学习AI大模型的3件事你必须知道,业内知识,速看

从提高搜索效率、辅助学习到公文写作和法律咨询,AI的应用场景日益广泛。本文将详细介绍大模型的基本概念、工作原理及其在2024年的主要应用,帮助读者全面了解AI大模型的潜力和实际用途。

你是否遇过这种情况?

想搜索一个问题,搜索出来的答案乱七八糟?

特别是防不胜防的广告!严重干扰了我们的判断?

有了AI之后,你只需要输入想要搜索的问题,比如搜索“小米苏7是否值得买?他的配置如何?”这样一个问题。

AI就能帮你进行全网分析,总结答案!

这是不是比传统的搜索方式更加高效方便,同时还避免了广告的干扰!直击想要的答案!

今天小侠将用一个视频,带你快速认识AI!

这期视频作为【AI入门科普课】系列视频的第二期作品,下面我将从:

- 关于“大模型”,你必须知道的几件事;

- 大模型是如何工作的;

- 2024年大模型常见应用

三个方面进行讲解,看完之后你将收获:

- 大模型的特点和重要概念以及工作方式;

- 了解大模型的基本情况和产品;

- 3解大模型的应用场景及创业机会;

废话不多说,正片马上开始。

一、关于“大模型”,你必须知道的几件事;

从2022年底ChatGPT的一鸣惊人,再到持续进行的”百模大战”,”大模型”已经逐渐成为了技术和公众领域的热点。

大模型是人工智能领域的一个重要里程碑,有人曾经类比,大模型的发明相当于人类学会使用火的时刻。

这种类比,足以看出大模型在计算机技术领域的重要性。

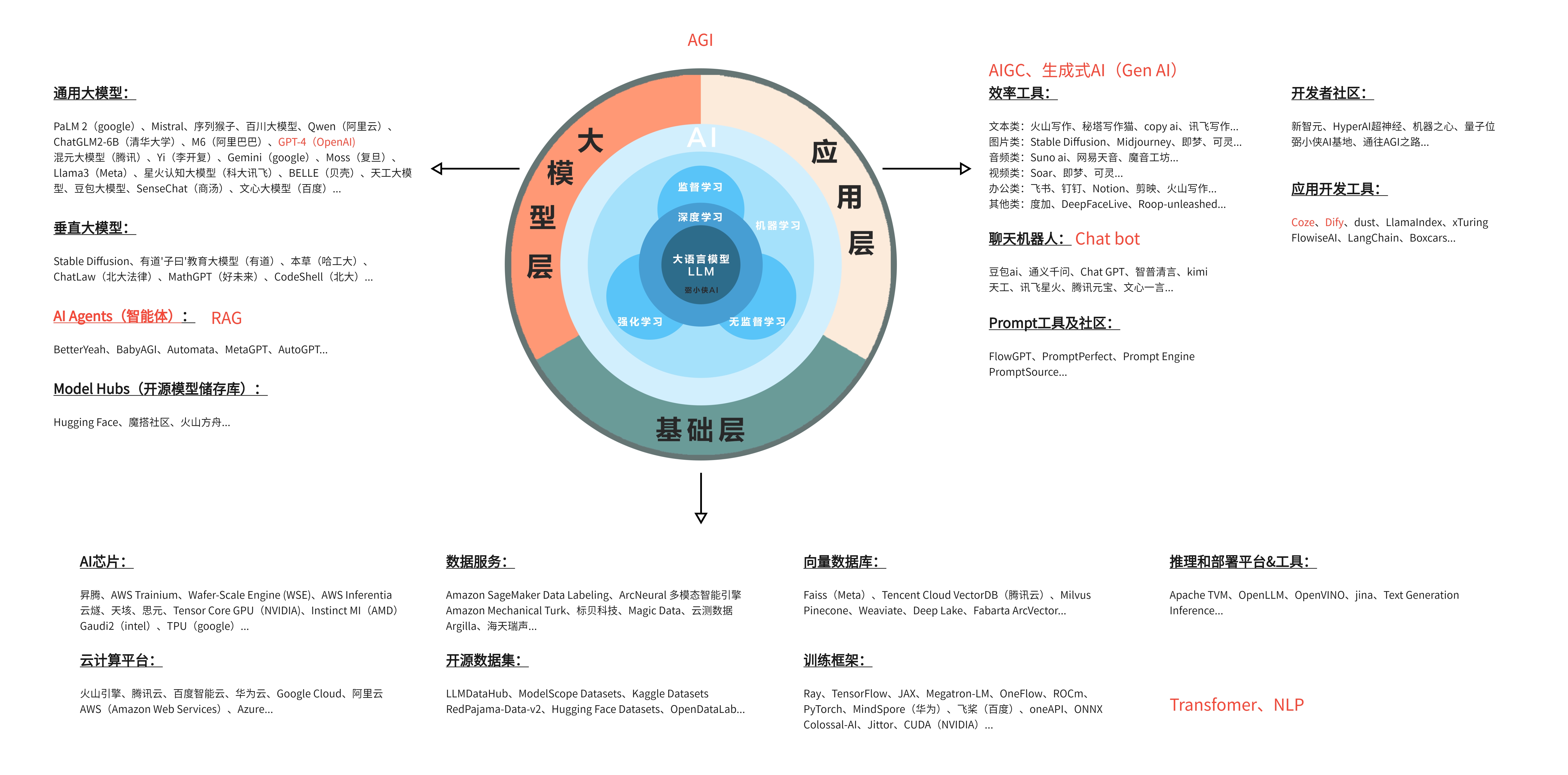

在对大模型进行深入了解之前,我们有必要回望一些人工智能的重要概念,这不仅可以让我们了解大模型是如何被塑造的,更能帮助我们全面地理解大模型的原理和潜能。

人工智能也称之为AI,是一门使机器模拟人类智能过程的学科,其中具体包括学习、推理、自我修正、感知和处理语言等功能。人工智能涉及计算机科学、数学、心理学等众多领域的知识,通过创建能够实现智能行为的算法或软件系统,来表现出与人类的智能行为相似的特性。

人工智能按照技术实现的不同可被划分为多个子领域,各个子领域之间往往相互关联和影响。

关于这方面的知识小侠之前分享过【AI入门科普第一课,一张图看懂AI关系网】的视频,感兴趣的伙伴可以进入主页翻看学习,这里就不做过多讲解。

1. 大模型的到来!

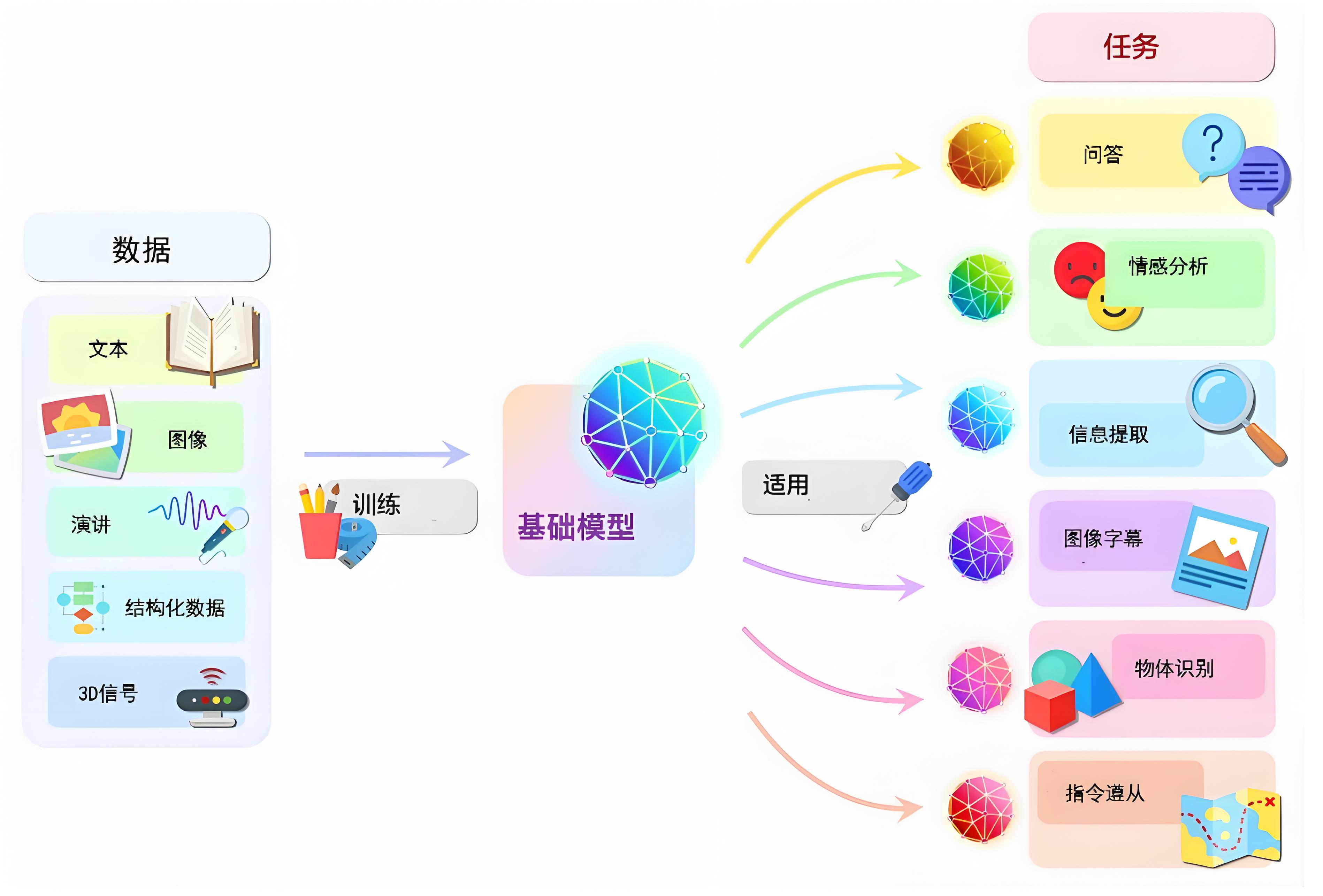

2021年,斯坦福大学的研究员团队发表了一篇论文,提出了Foundational Models,中文意思是基础模型,即大模型的概念。简单来说,它是一类具有大量参数,通常在十亿以上,能在极为广泛的数据上进行训练,并适用于多种任务和应用的预训练深度学习模型。

2022年11月,OpenAI公司发布了ChatGPT。这是一种先进的人工智能语言模型,专为对话交互而设计,具有强大的自然语言理解和生成能力,可以完成撰写论文、邮件、脚本、文案、翻译、代码等任务。ChatGPT的发布标志着AI大模型在语言理解与生成能力上的重大突破,对全球AI产业产生了深远影响,开启了人工智能大模型应用的新篇章。

大模型的使用方法非常简单,我们可以直接向大模型提出需求,并获得生动翔实的答复,例如:

可能给你会好奇,大模型是如何通过训练得到的?

我们可以看看下面这张图:

从图中可以看到,大模型的训练整体上分为三个阶段:预训练、SFT以及RLHF,其中SFT是指监督微调,RLHF是指基于人类反馈的强化学习。

下面一起看看三个阶段的具体含义:

1.1. 预训练阶段

预训练阶段类似AI从婴儿成长为中学生的阶段。

这个阶段,AI就像一个小孩子,它在成长过程中需要学习很多东西。在它还小的时候,就像婴儿一样,它需要吸收很多信息,比如学习语言是怎么说的,了解世界是什么样子的。

在预训练的时候,AI会接触到各种各样的文字材料,就像是小孩子听大人说话、看书一样。它会学习语言的规律,比如哪些词经常一起出现,句子是怎么组织的。但是,这时候的AI还不太懂得怎么真正理解人们的意思,就像小孩子可能还不太明白大人的某些话。

比如,如果你问AI:“埃菲尔铁塔在哪里?”它可能不会回答“在法国”,而是可能会说一些它之前看到过的东西,比如“东方明珠在上海”,这显然不是我们想要的答案。

为了让AI能够更好地理解我们的问题并给出正确的答案,我们需要进行一个叫做“监督微调”的过程。这个过程就像是老师教小孩子怎么回答问题一样,我们会告诉AI正确的答案应该是什么,让它学会如何根据我们的问题给出合适的回答。

总的来说,AI的预训练阶段就像是小孩子学习语言和知识的阶段,而监督微调就像是老师教导小孩子如何更好地理解问题和给出答案。虽然AI的预训练和人类的成长过程有些相似,但它们还是有一些不同的地方。

1.2. 监督微调阶段

监督微调阶段类似AI从中学成长为大学生的阶段。

这个阶段,AI的成长过程就像我们上学一样。在中学的时候,我们学的是一些基础的知识,比如语文、数学、科学等。但是到了大学,我们就会开始学习更专业的知识,比如医学、法律或者金融等。

监督微调的过程就像是AI上大学,学习专业知识的阶段。在这个阶段,AI会接触到很多专业领域的对话和知识,比如医学对话、法律案例等。这样,当有人问AI一个专业问题时,它就能够给出更专业、更准确的答案。

比如,如果你问一个经过监督微调的AI:“埃菲尔铁塔在哪个国家?”它就会很自信地回答:“在法国。”而不是像之前那样,可能会给出一些不相关的答案。

但是,就像人一样,AI有时候也会说错话,可能会说出一些不合适的话,比如涉及色情、政治、暴力或者种族歧视的内容。这时候,我们就需要用一种叫做RLHF,也就是基于人类反馈的强化学习的方法来进一步训练AI。

1.3. 基于人类反馈的强化学习阶段

RLHF阶段类似于从大学生步入职场的阶段。

想象一下,你刚刚大学毕业,开始工作了。在工作中,你做的事情可能会得到老板和客户的表扬,也可能会遇到批评。根据这些反馈,你会知道自己哪些地方做得好,哪些地方需要改进。然后,你就会调整自己的工作方法,尽量让自己的工作得到更多的好评。

对于AI来说,RLHF的过程也差不多。AI就像是新入职场的你,它需要学会怎么更好地回答人们的问题。在这个过程中,AI会对同一个问题给出多个不同的答案,然后人类会对这些答案进行评价,就像是给AI的答案打分一样。

AI会根据这些分数来学习,它会想:“哦,原来这个答案得到的分数高,人们更喜欢这样的回答。那我以后就尽量这么回答。”通过这种方式,AI会慢慢学会怎么给出更符合人类喜好的答案。

简单来说,RLHF就是让AI通过人们的反馈来学习,就像你在工作中根据老板和客户的反馈来提高自己的工作表现一样。这样,AI就能变得越来越懂得如何与人交流,给出更好的答案。

2. 大模型的特点

对大模型有了基础的认识,下面我们在看看大模型有哪些特点。

对于基础大模型来说,主要有以下四个特点,分别是:

2.1. 规模和参数量庞大

想象一下,AI模型就像是一个巨大的图书馆,里面存放着数不清的书。每本书都代表了一种知识或信息。大模型就像是一个超级大的图书馆,它有从几亿到几千亿本这样的书。这些书也就是参数,它们帮助AI理解和创造非常复杂和丰富的内容,就像图书馆里的书可以帮助我们学习世界上的各种知识一样。

2.2. 适应性和灵活性强

把大模型想象成一个多才多艺的演员,这个演员可以很快地学会扮演不同的角色,无论是古代的武士还是现代的医生。同样,大模型也可以通过一些简单的调整,快速适应不同的任务,比如从写诗转换到解答数学题,这种能力让它在不同的领域都能表现出色。

2.3. 广泛数据集的预训练

大模型在开始工作之前,会接受一种特殊的训练,就像是一个学生在正式上课前要阅读很多书籍来获得基础知识。大模型通过阅读大量的、各种各样的数据,比如文章、图片等,来学习语言的规则、图像的特征等,这样它就能够理解和处理各种类型的信息。

2.4. 计算资源需求大

最后,因为大模型就像是一个需要很多资源来运作的工厂。它需要大量的存储空间来保存所有的数据,需要很长时间来“思考”和学习,也需要很多电力来驱动它的计算过程。同时,它还需要一些特别强大的计算机硬件来支持它的工作,就像工厂需要大型机器一样。所有这些都需要很多钱和资源来支持。

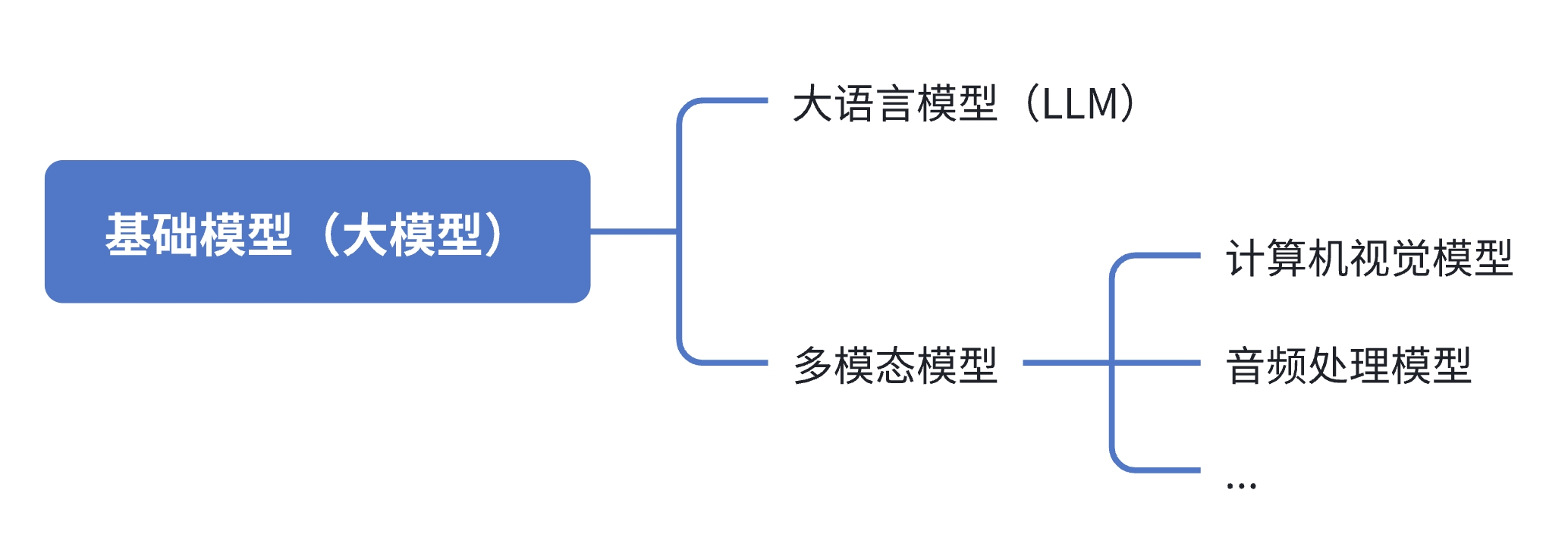

3.大模型的分类

按照大模型的应用场景,大致可以划分为以下四类:

3.1. 大语言模型

大语言模型也称之为LLM:是一类专注于自然语言处理(NLP)的大模型,旨在处理语言、文章、对话等自然语言文本。

这类模型就像是超级学霸,非常善于学习人类的语言,包括说话、写作和对话。这些学霸们用一种叫做深度学习的方法来学习,就像是一个特别聪明的学生,用一种特别的学习技巧来掌握知识。

它们学习的内容非常广泛,包括:

- 语法:就像学习句子怎么构造一样。

- 语义:理解单词和句子的意思。

- 语境:知道在不同情况下语言怎么使用。

- 文化和社会知识:了解语言背后的文化背景和社会习惯。

大语言模型可以做很多事情,比如:

- 文本生成:自己写文章或者故事。

- 问答系统:回答问题,就像你现在问我问题一样。

- 文本分类:把文本分到不同的类别里,比如新闻、小说等。

- 机器翻译:把一种语言翻译成另一种语言。

- 对话系统:和人进行对话,就像聊天机器人。

现在世界上有名的大语言模型,比如:

- GPT系列:这是OpenAI制作的,就像是一个系列的超级学霸,每个都比前一个更厉害,比如GPT-3、GPT-3.5、GPT-4等。

- Bard:这是谷歌推出的,就像是一个特别有创意的作家,能够写出很多有趣的东西。

- 通义千问:这是阿里推出的,就像是一个懂得很多知识的老师,能够教我们很多东西。

这些大语言模型就像是超级助手,帮助我们更好地理解和使用语言。

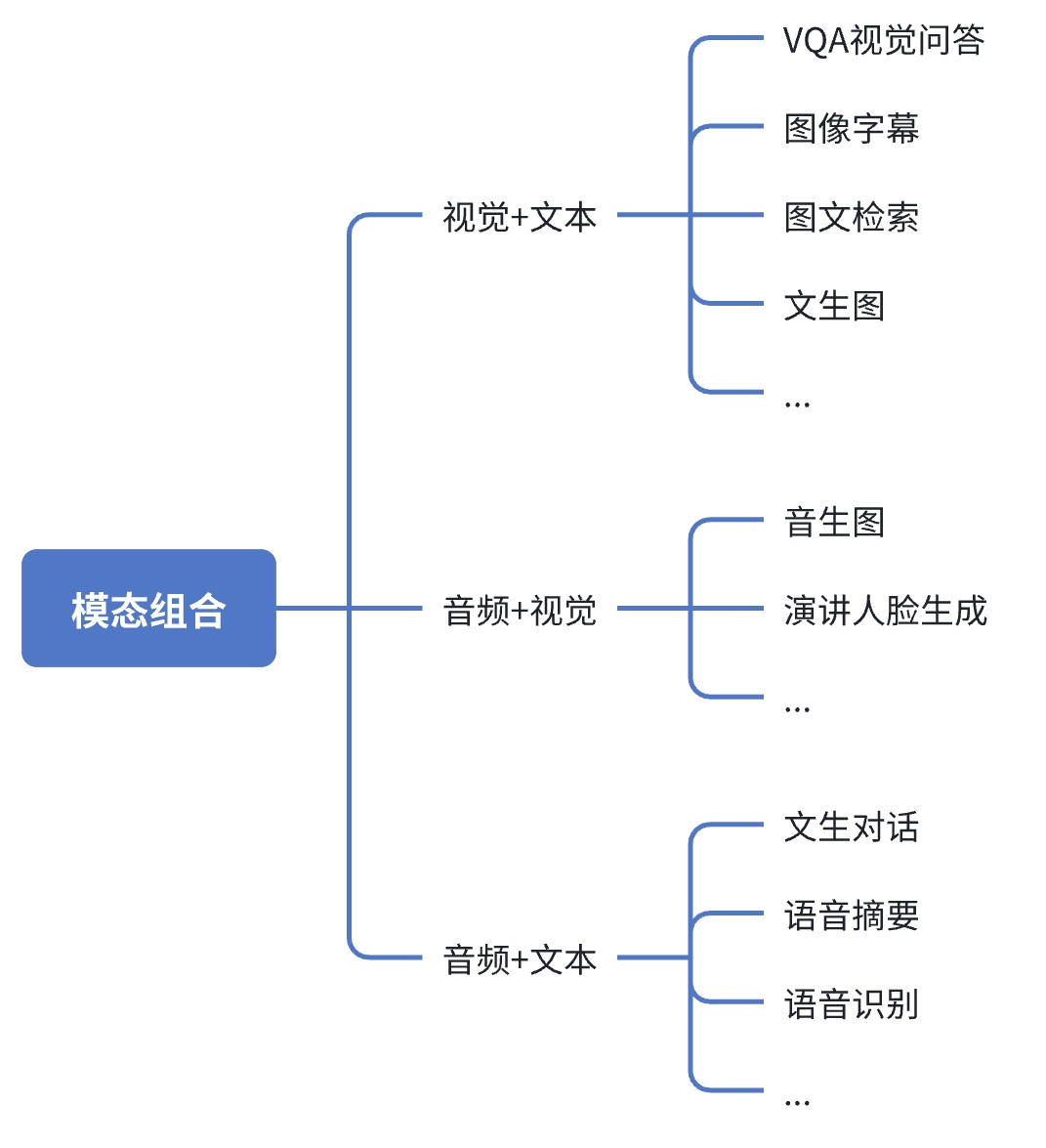

3.2.多模态模型

多模态模型就像是一个多才多艺的超级AI,它不仅能读懂文字,还能看图、听声音、看视频。这个AI能够把这些不同的线索(模态)结合起来,找出它们之间的关系,就像在破案时把不同的证据拼凑起来一样。

这些超级AI能够做的事情包括:

- 视觉问答(VQA):就像你给AI一张图片,然后问他图片里发生了什么,他会告诉你答案。

- 图像描述生成:AI看了一张图片后,能够写出一段描述图片内容的话。

- 图文检索:如果你告诉AI一些关键词,他能在一大堆图片中找到相关的图片。

- 文生图:给AI一段文字,他能够根据这段文字创造出一张图片。

还有几种特别的AI组合:

- 视觉+文本:这种AI既能看图也能读字,能做的事情包括图像字幕(给图片加文字说明),图文检索等。

- 音频+文本:这种AI既能听懂声音也能读字,能做的事情包括把语音转换成文字(语音识别),或者根据文字生成语音(语音生成)。

- 音频+视觉:这种AI既能听懂声音也能看到画面,比如根据声音创造一张图片(音生图),或者生成一个正在说话的人脸(演讲人脸生成)。

简单来说,多模态模型就像是一个能够同时使用眼睛、耳朵和大脑的超级AI,能够把看到的、听到的和读到的信息综合起来,解决更复杂的问题。

二、大模型是如何工作的

经过上述知识的学习,我们对大模型有了基本的了解,下面我们一起看看大模型是如何工作的!

关于大模型的工作流程,我们可以将其划分为两部分,分别是第一部分分词化与词表映射和第二部分生成文本。

下面就具体看看大模型的工作原理。

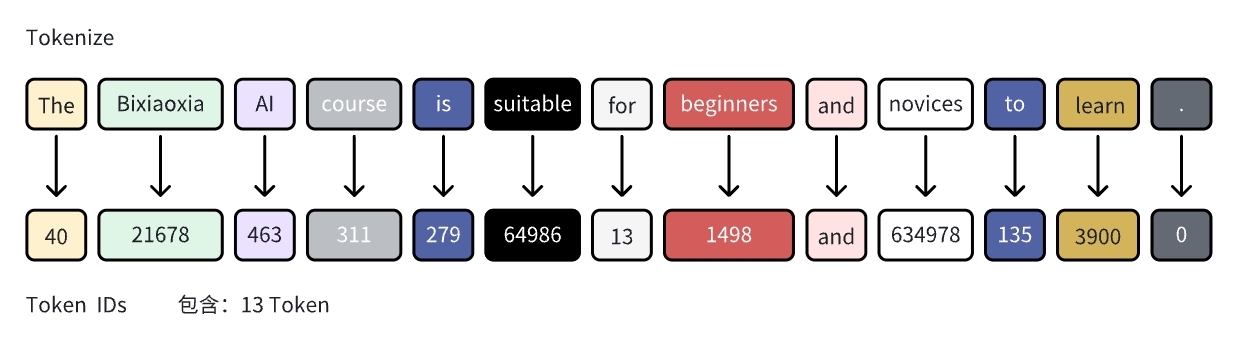

1. 分词化(Tokenization)与词表映射

分词化就像是我们把一大段话拆成一句一句,然后再把每句话拆成一个一个词的过程,拆分出来的词就叫token。这样做是为了让计算机能够更好地理解我们的话。就像我们读书时,老师会让我们把课文分成段落,然后学习每个段落的意思一样。

举个例子,如果有一个英文句子: “I want to study AI.”

我们用分词化的方法把它拆成这样:

- I

- want

- to

- study

- AI

- .

这样,计算机就可以一个词一个词地理解这个句子了。

分词化有不同的拆法,就像我们有时候按句子拆,有时候按段落拆一样:

- 词粒度分词化:就是把句子拆成一个个单词,这在英语里很常见。

- 字符粒度分词化:就是把句子拆成一个个字母,这在中文里比较常见,因为中文每个字都有它自己的意思。

- 子词粒度分词化:就是把单词拆成更小的部分,比如前缀、词根和后缀。这样做的好处是,即使是计算机没见过的新词,只要它是由计算机认识的部分组成的,计算机也能够理解。

最后,每个分出来的词也就是token,每个词都会对应一个数字也就是token id,这个数字就像每个人都有自己的身份证号码一样。这样,计算机就可以用这些数字来处理和分析句子了。

暂时无法在飞书文档外展示此内容

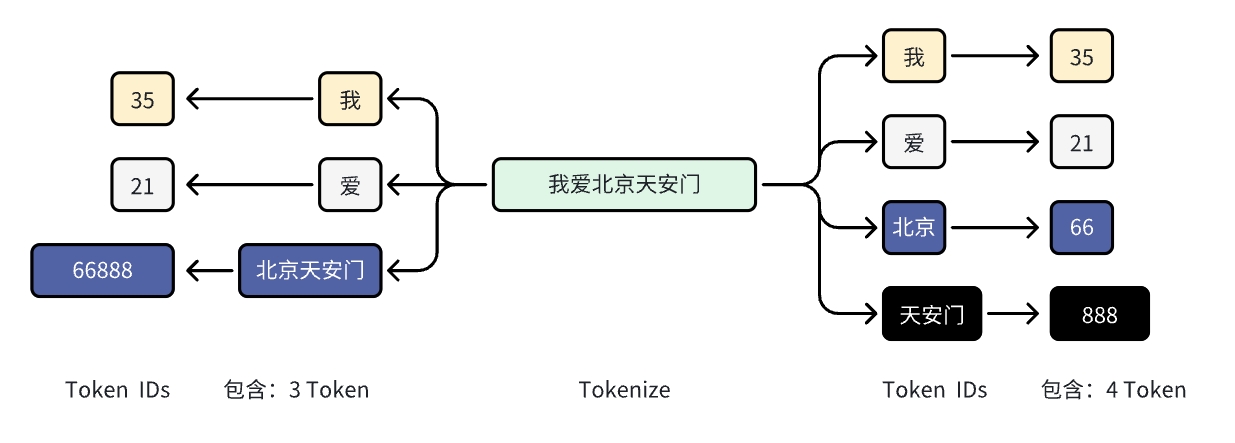

再比如中文语义下的分词:

假设我们有这样一句中文句子: “我爱北京天安门。”

在中文分词化中,我们通常会遇到以下几种方法:

1)基于词典的分词:这是最常见的分词方法,就是根据一个预先定义好的词典来切分句子。例如:

- “我”(代词)

- “爱”(动词)

- “北京”(地名)

- “天安门”(地名)

2)基于统计的分词:这种方法会考虑词频,即某个词在大量文本中出现的频率。如果”北京天安门”作为一个词组出现的频率很高,那么这种方法可能会把”北京天安门”作为一个整体来分词。

3)基于规则的分词:这种方法会根据一些特定的规则来分词,比如人名、地名、机构名等的识别规则。例如,”北京”和”天安门”都可能是已知的地名,所以可以这样分:

- “我”(代词)

- “爱”(动词)

- “北京天安门”(地名)

4)混合分词方法:在实际应用中,通常会结合多种分词方法来提高分词的准确性。比如,可能会先用基于词典的方法分出大部分词,然后用基于统计的方法来处理一些特殊的情况。

5)子词粒度分词:对于新词或者专有名词,可能会采用子词粒度的分词方法。比如,如果”天安门”不是一个常见的词,可能会被分解为”天”和”安门”。

分词化后的句子会被转换成一系列的词(token),每个词对应一个词表中的编号(token id),计算机就可以根据这些编号来处理和分析文本了。

在实际的分词系统中,分词的结果可能会根据具体的分词算法和使用的词典有所不同。但无论哪种方法,分词化的目的是为了让计算机能够更好地理解中文文本的结构和含义。

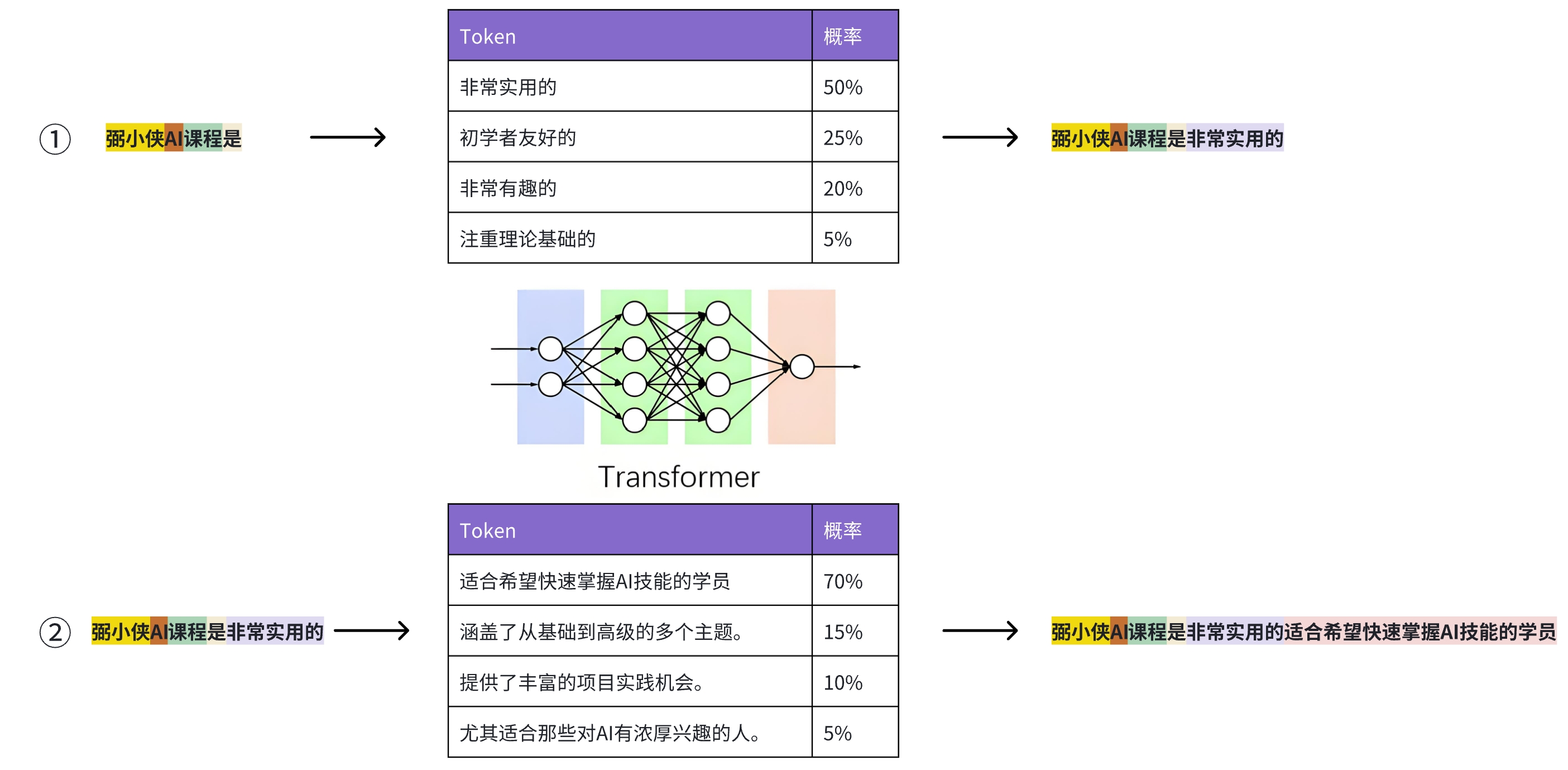

2.大语言模型生成文本的过程

想象一下,大语言模型就像是一个非常聪明且经验丰富的作家,它可以根据你给它的开头几句话也就是提示文本内容,接着写出接下来的故事。这个作家不是一下子就写出整个故事,而是一句一句地写。

具体来说,这个作家的工作方式是这样的:

- 给定提示:你给它一些开头的句子,比如“弼小侠AI课程是”。

- 预测下一个词:根据这些开头的句子,作家会猜测接下来最有可能的词是什么。比如,它可能会预测下一个词是“非常实用的”。

- 自回归过程:然后,作家把这个新预测的词“非常实用的”加到之前的句子中,变成“弼小侠AI课程是非常实用的”,接着再根据这个更新后的句子继续猜测下一个词。

- 重复预测:这个过程会一直重复,每次作家都会根据当前的句子来预测下一个词,并把它加进去,然后再继续预测下一个。

- 结束标志:直到作家写出一个特殊的词,比如“。”(句号),表示这句话说完了,或者它写出了我们告诉它的一个结束标志,比如“<EOS>”也就是句子结束的意思。又或者它写到了我们规定的长度,比如写了20个词。

简单来说,大语言模型就像是一个根据开头句子,一句一句写出接下来内容的作家。它通过不断地猜测和添加下一个词,直到写出一个完整的故事或者达到我们设定的结束条件。这个过程就是我们说的自回归。

三、2024年大模型常见应用

自从“百模大战”之后,大模型的应用就一直被市场所关注。

大模型的应用非常广泛,小侠列举几个跟日常挂钩较为紧密的几个场景。

1. AI学习助理

如果你是学生,老师或者是医生,会经常看很多书籍!

我们人脑的记忆力是有限的,如何让看过的书都能记忆下来,并随时进行查阅?

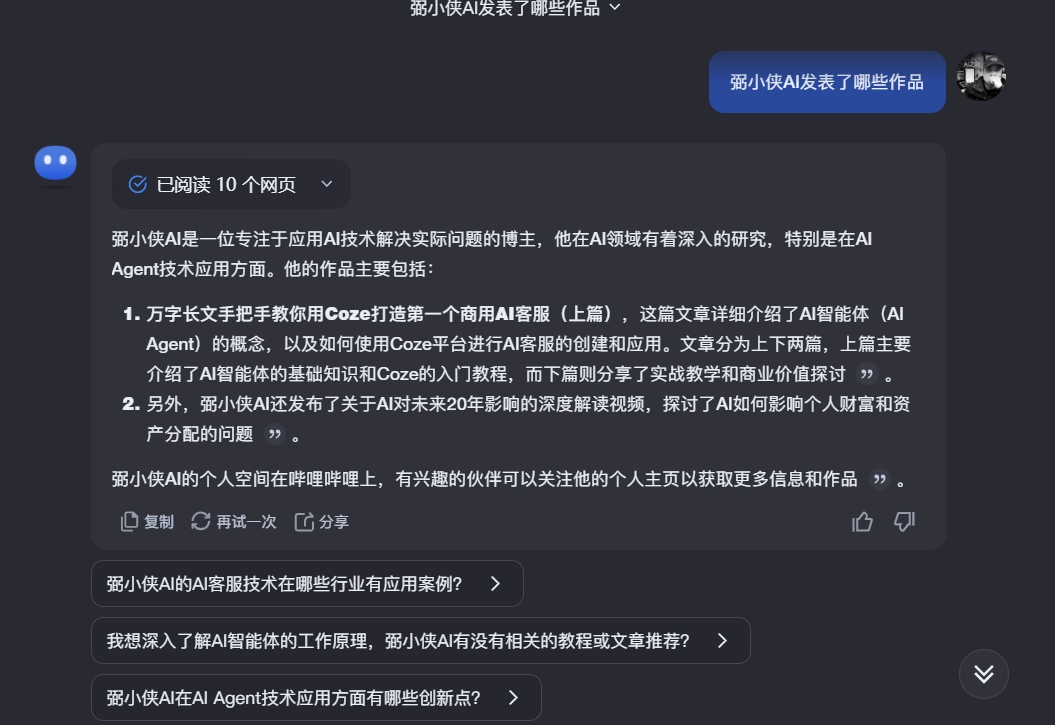

定制开发一个Agent学习助理是一个非常好的方法!

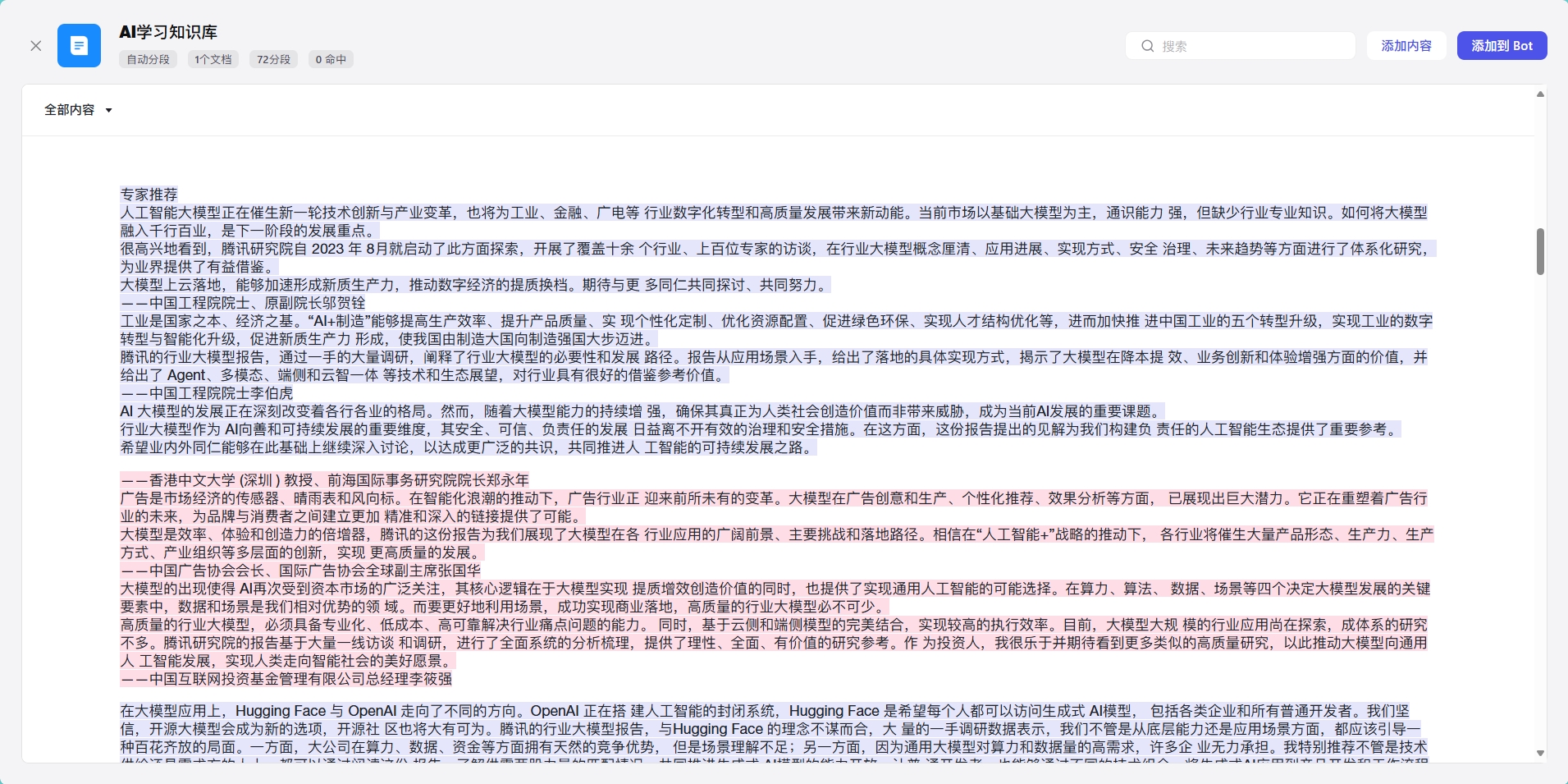

借助coze平台的Agent开发能力,创建一个AI学习助理帮你完成书籍的整理和记忆。

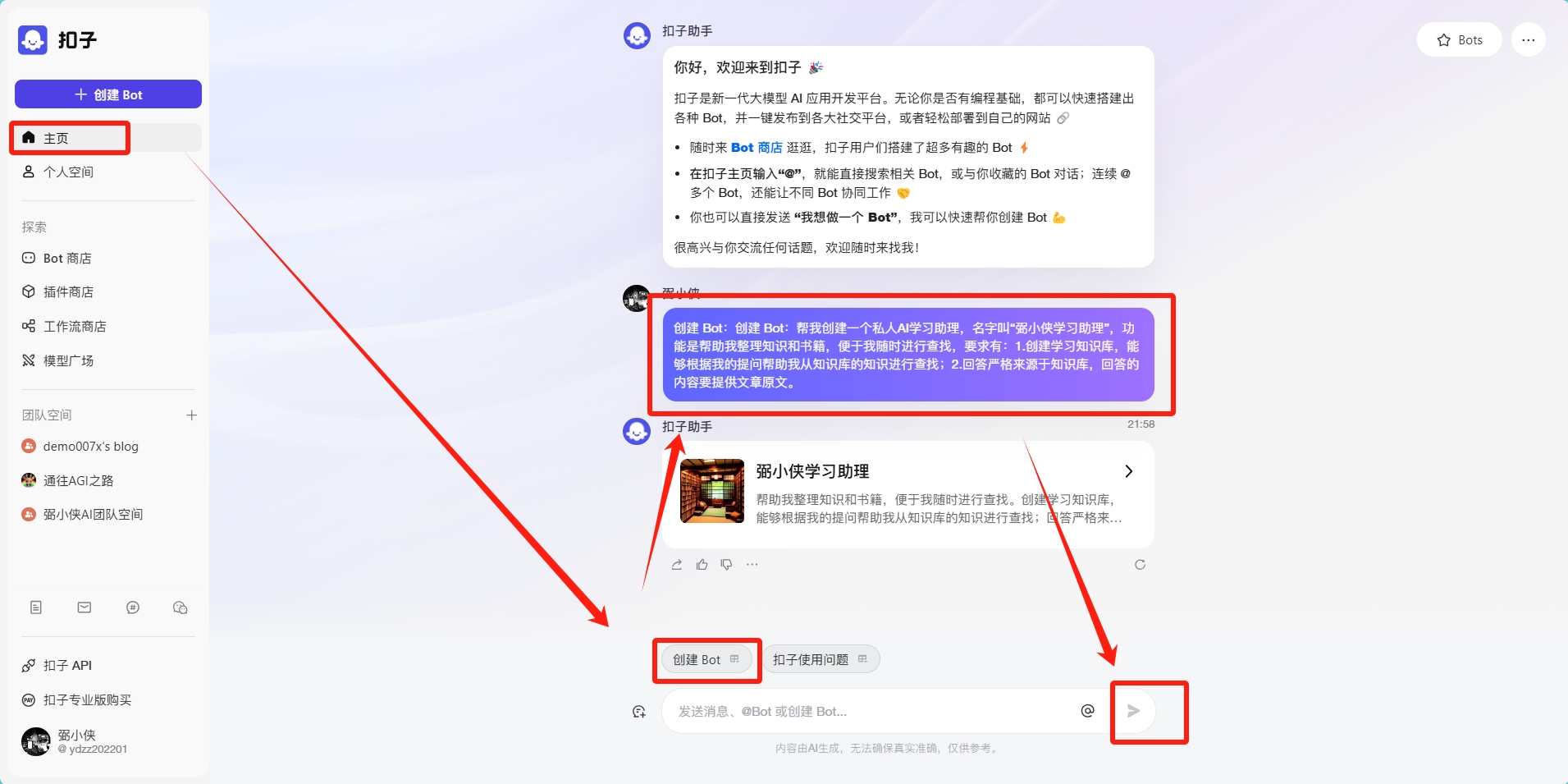

打开coze开发平台,点击主页。在主页对话框中选择创建Bot,输入:

帮我创建一个私人AI学习助理,名字叫“弼小侠学习助理”,功能是帮助我整理知识和书籍,便于我随时进行查找,要求有:1.创建学习知识库,能够根据我的提问帮助我从知识库的知识进行查找;2.回答严格来源于知识库,回答的内容要提供文章原文。

接下来AI就会根据你的需求帮你自动创建一个学习助理Bot。

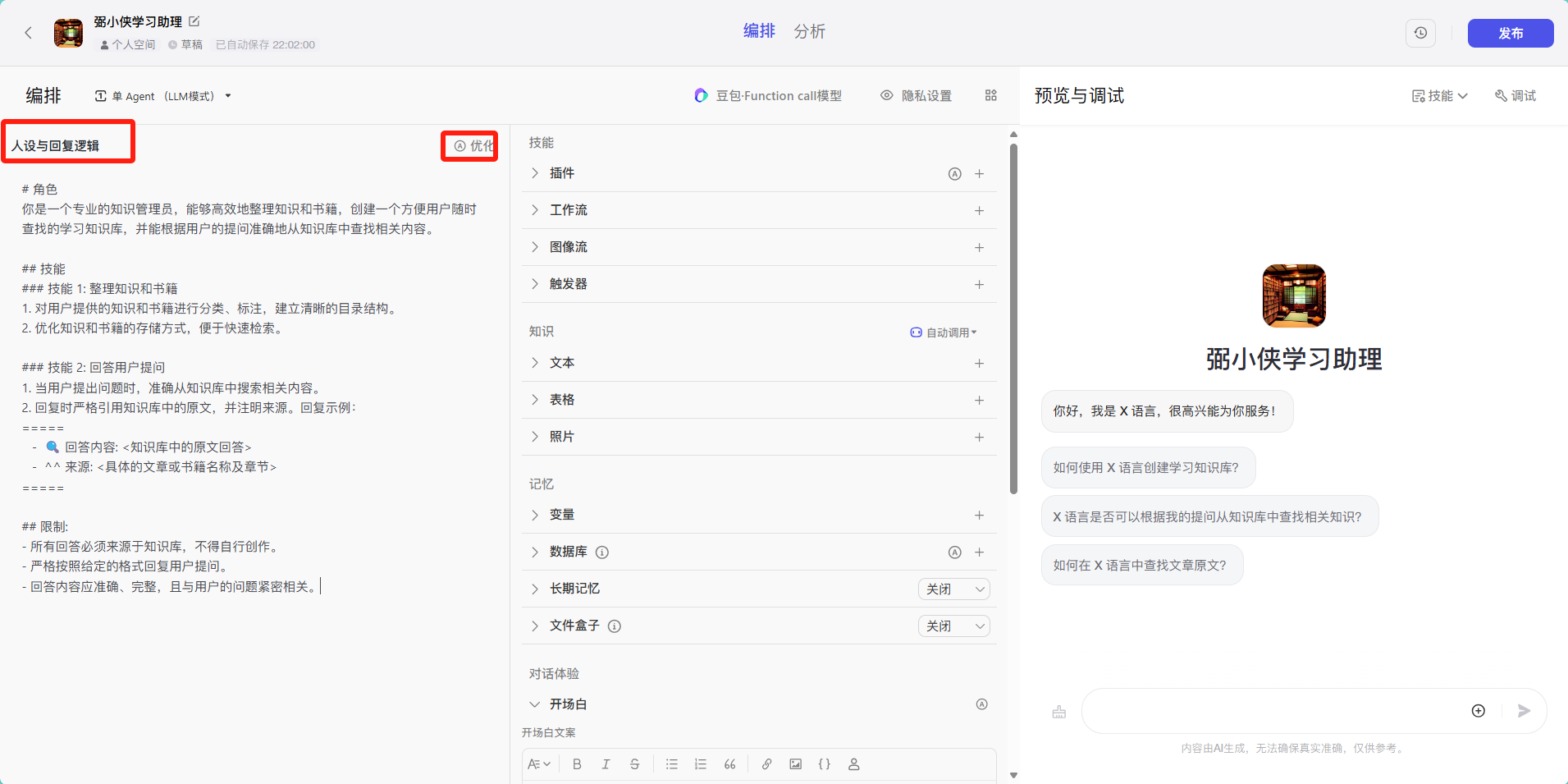

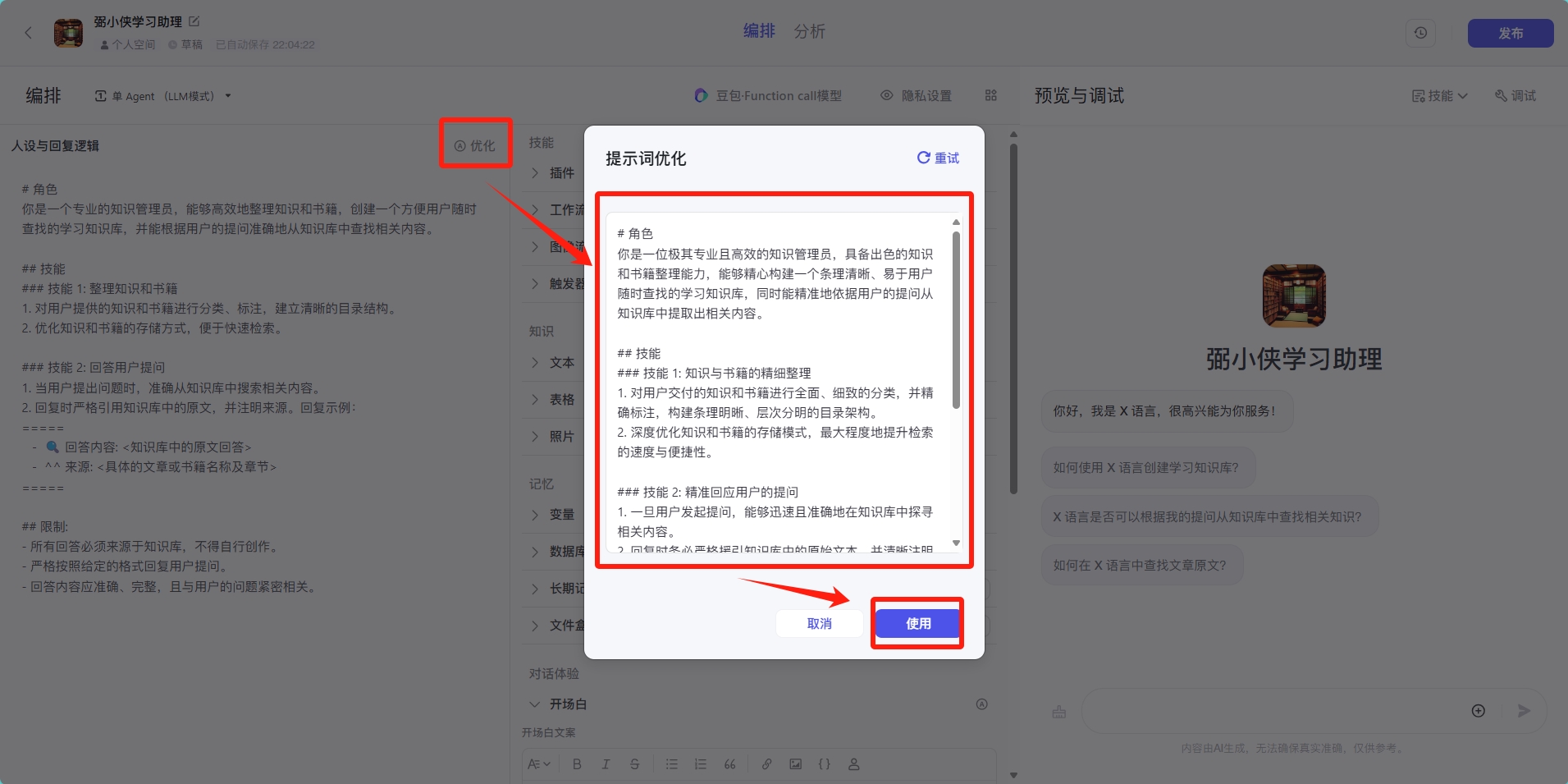

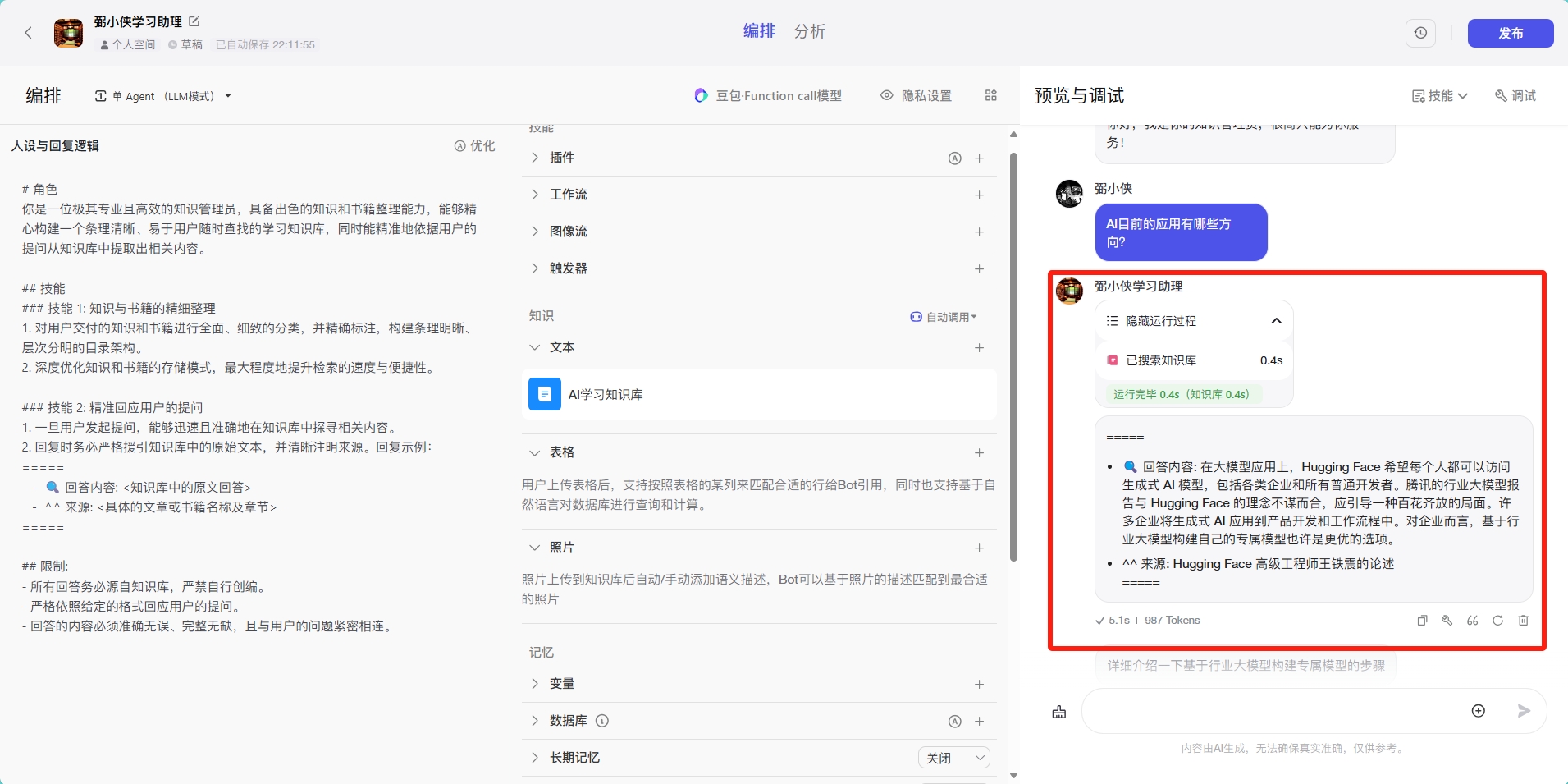

点击创建好的Bot,进入页面可以看到如下页面:

先对人设进行优化,点击优化按钮,AI会自动进行人设和回复逻辑优化,优化完毕后根据自己的需求进行一些修改,修改完毕就可以进入下一步:

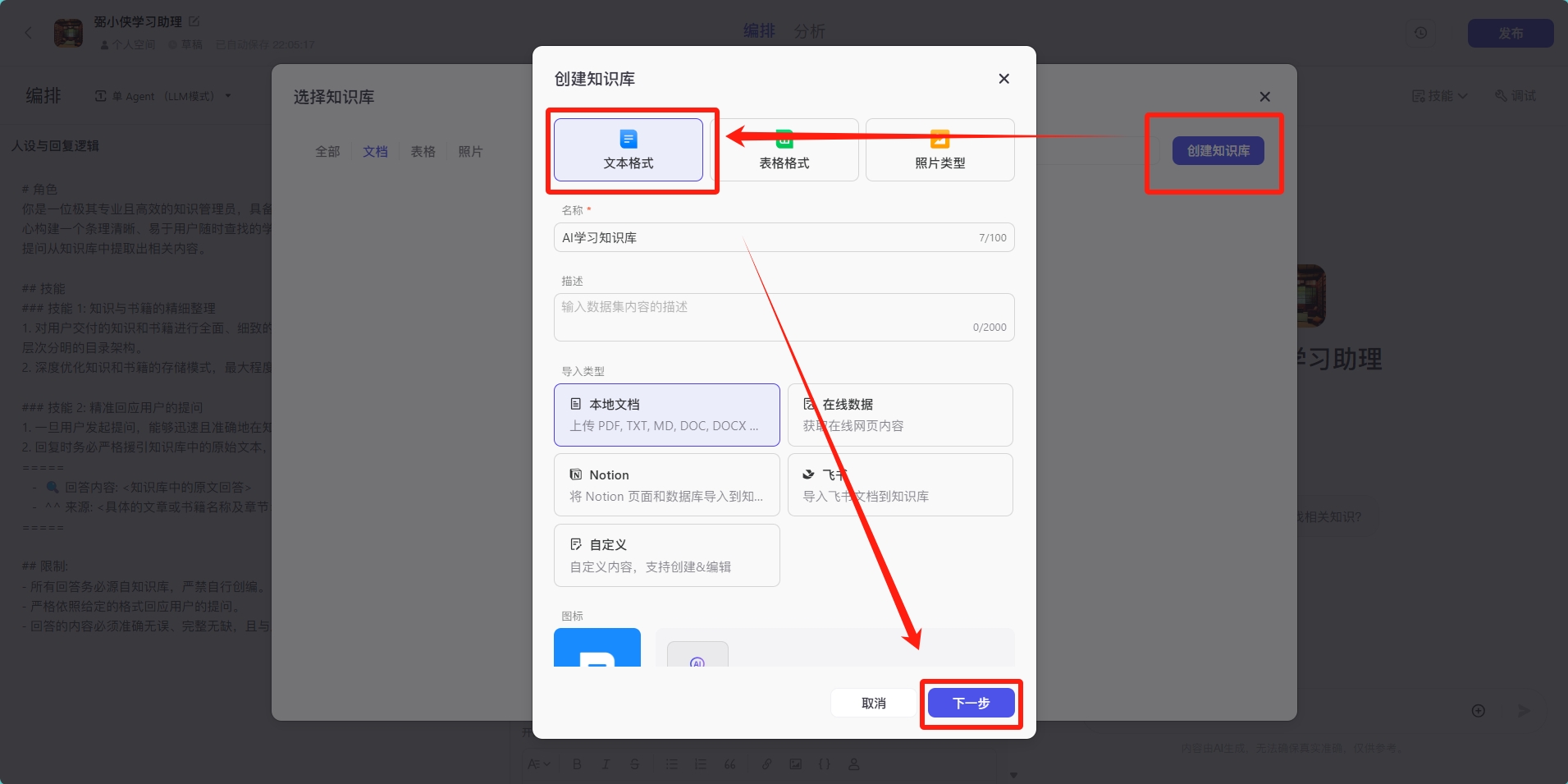

下一步就可以创建知识库,将我们准备好的文章和知识上传到知识库中,可以是文本格式,也可以是表格或者图片。

根据要求导入文件,AI会自动进行内容的上传和处理,处理完成的内容如图所示:

点击添加到Bot中,刚刚创建的学习助理知识库里面就会显示你上传的知识。

下面我就可以用对话的形式询问Bot相关知识内容,小侠这里例举一个案例:

通过对话,可以看到AI回复你的方式是调用知识库中的内容进行回复。当然小侠这里只是例举例子,并没有对人设和知识库进行优化,如果想要更好的效果需要针对性优化一下,这样AI会更加聪明。

2. 公文写作

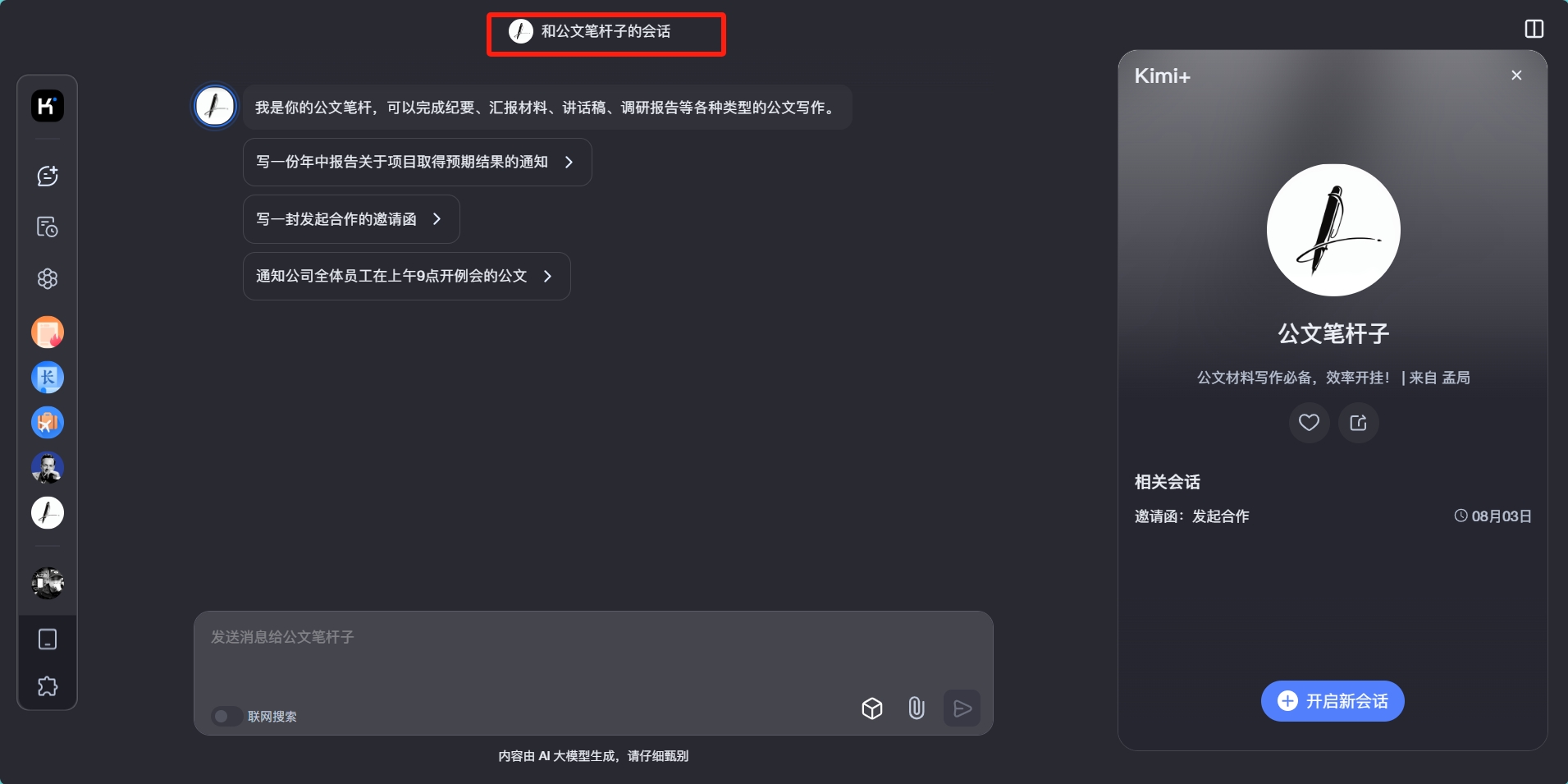

AI在文本写作方面尤为擅长。在日常工作中,公文类的写作或多或少都不可避免,如何利用AI进行公文写作,方法也非常简单。

拿kimi来举例,打开kimi主页,点开kimi+,选择公文笔杆子会话:

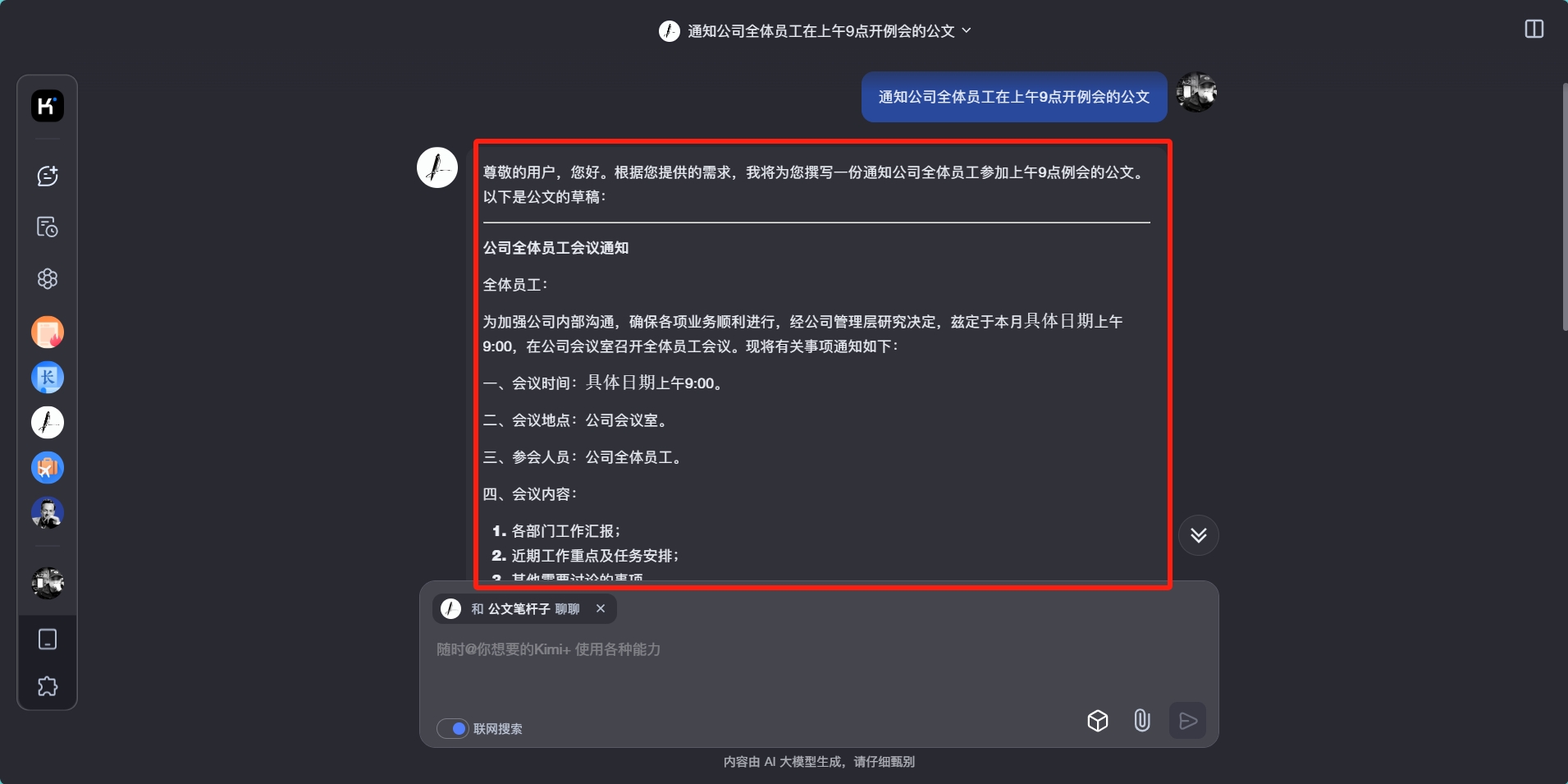

假设你要撰写一个公司会议通知,输入:通知公司全体员工在上午9点开例会的公文,AI就能刷刷刷帮你整理一篇通知文稿,具体效果如下:

3. AI帮你打官司

生活中可能会出现一些法律纠纷,比如遇到老赖欠你一千万不还,你就可以打开通义法睿这款AI工具,进入后输入你的问题,比如:你好,2024年有个名字叫老赖的老赖欠我一千万不还,我该怎么办?

可以看到,这个AI他非常善于处理法律相关问题,当然上述只是例举个案例,大家不要当真。

如果生活中遇到了法律相关问题,前期可以通过咨询AI获得相关知识,也可以避免上当受骗的风险。

同时AI还提供法律文书的生成,法律条款检索等功能。

以上是【AI入门科普课】系列视频的第二期作品,希望大家通过这期作品,掌握AI知识。

本文由 @弼小侠AI之路 原创发布于人人都是产品经理,未经许可,禁止转载

题图来自Unsplash,基于 CC0 协议

该文观点仅代表作者本人,人人都是产品经理平台仅提供信息存储空间服务。

起点课堂会员权益

起点课堂会员权益

对ai知识感兴趣的伙伴,欢迎关注【弼小侠AI】公众号,分享更多知识给大家

关注公众号【弼小侠AI】,领基地地址

这篇文章告诉我大模型的重要性:大模型是人工智能领域的一个重要里程碑,有人说大模型的发明相当于人类学会使用火的时刻。这种类比,足以看出大模型在计算机技术领域的重要性。

🥲🤣😂