让AI精准写营销软文的顶级技巧,提示词优化方法,火速学习

如何充分利用大语言模型的潜力,特别是在预算有限的情况下,成为一个值得探讨的话题。本文将深入介绍提示词技巧的重要性和实用方法,最大化AI的价值。

如果你不想花一分钱,让AI给你写高质量文章,那么下面的内容一定会让你兴奋起来。

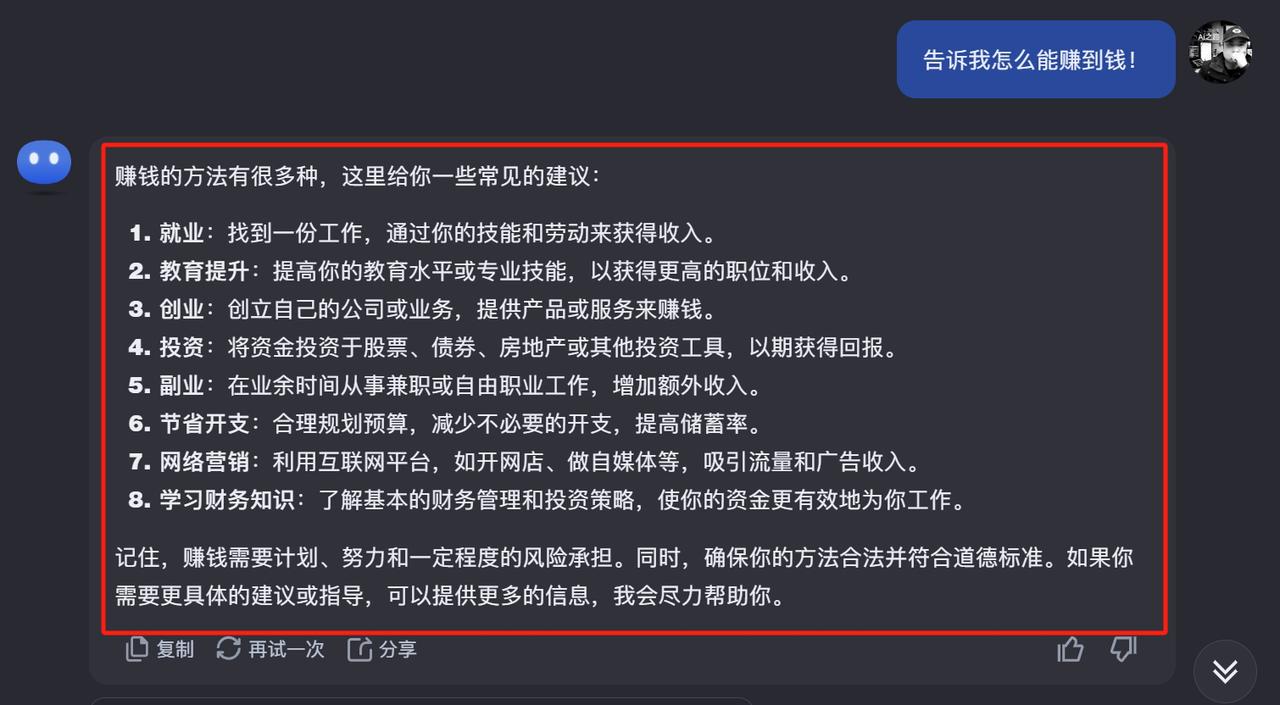

你是不是遇到过这样的情况?

请你告诉我怎么能赚到钱!

AI的回答:

1.就业:找到一份工作,通过你的技能和劳动来获得收入。

2.教育提升:提高你的教育水平或专业技能,以获得更高的职位和收入。

3.创业:创立自己的公司或业务,提供产品或服务来赚钱。

等等这些答案!

是不是看起来回答了!

但是实际上,这些答案对你来说一点用处都没有!

其实原因并不是AI无用!而是你没有掌握正确向AI提问的方法!

想象一下,你正在给一个同事指派一个工作任务,如果只给了他一句话来描述这个需求,他的任务完成效果可能很难达到你的预期。

但如果你提供了明确的目标、建议的思考方向和执行策略等等,更多参考信息,他更有可能以高标准完成任务。

使用大语言模型也一样,你的提问方式决定了大语言模型的回答质量。

不过现在你不用担心了,因为本期作品,小侠会带着大家学习优质提示词技巧的知识,这些知识的掌握,能够让你的AI给你更加高质量的答案。

欢迎回到弼小侠AI,一个专注于AI商业化应用研究的AI知识博主,如果你对我的作品感兴趣,记得点赞加关注,感谢您的支持。

本期视频作为【AI入门科普课】第三期作品,学习之后你将收获:

1.了解什么是提示词和提示词工程!

2.获得更高质量的提示词的方法和实用技巧!

视频全篇干货!伙伴们记得提前收藏加关注,避免后续找不到!

一、什么是提示词和提示词工程

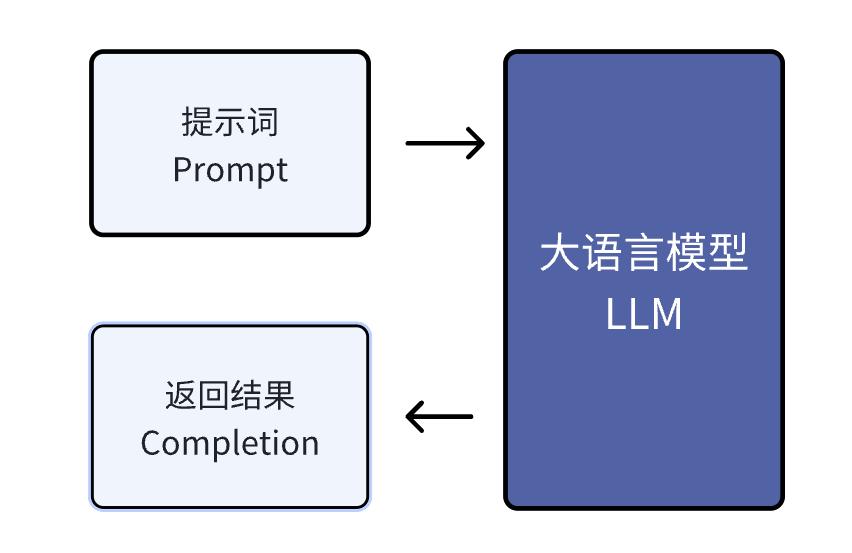

提示词,英文名叫Prompt。

是用户发送给大语言模型的问题、指令或请求,用来明确地告诉模型用户想要解决的问题或完成的任务,是大语言模型理解用户需求并据此生成相关、准确回答或内容的基础。

对于大语言模型来说,提示词就是用户输入给大语言模型的文本信息。

通俗点就是你向AI输入的内容,可以是问题,也可以是要求。

下面先看一个简单的例子:

假设你问AI:

评价一下最近刚上映的电影!

这个提问就是提示词。

AI接收到你的问题后回复:

我无法完成这项任务,因为我目前无法访问实时数据或外部信息,包括最近上映的电影评价。如果您能提供具体的电影名称,我可以尝试根据我最后更新时的知识库提供一般性的电影分析或讨论电影评价的角度。

可以看出,AI的回复并不是你需要的答案!

出现这种问题原因是什么?

上面这个例子中,导致大语言模型无法顺利完成任务的原因是我们没有能够让AI理解到底要评价哪部电影。

尽管大语言模型经过了海量数据的预训练,并获得了理解和生成文本的能力。但不同于人类交流时,能够通过语气、非语言线索和背景知识来理解对方的意图。

大语言模型仅能够根据输入的文本提示进行操作,如果文本的信息不足以让他理解你的意图,AI将没办法正确回答你的问题。

接着这个案例,我们对提示词进行一些优化:

比如提问:

请结合《猩球崛起》整个系列评价最近刚刚上映的电影《猩球崛起:新世界》

AI回答:

《猩球崛起:新世界》作为《星球崛起》系列的最新篇章,延续了这一科幻经典IP的传奇,尽管它……

在角色刻画上,《猩球崛起:新世界》似乎得到了积极的反馈,尤其是对于反派和配角的描绘……

对于老粉丝而言,这部电影可能没有提供必须观看的新鲜理由,但对于新加入的观众……

总体而言,《猩球崛起:新世界》在保持系列精髓的同时,尝试了某种程度的软重启,为新老观众都提供了值得一看的科幻体验。虽然可能在创新性上有所欠缺,但它在情感深度、视觉震撼以及对未来叙事线索的铺设上都交出了满意的答卷。

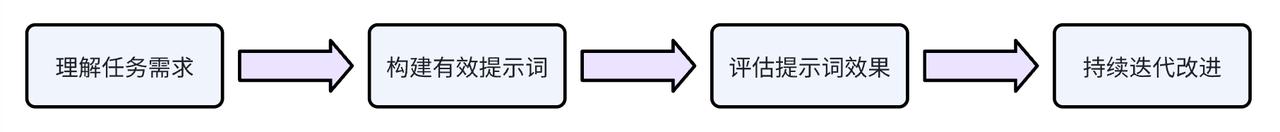

通过对比可以发现,经过优化的提示词更符合我们对结果的预期。精心设计和优化后的提示词,使大语言模型输出的结果更符合用户预期,这一过程就称之为“提示词工程,英文名:Prompt Engineering”。

这个过程包括以下关键步骤:

1.理解任务需求;

2.构建有效提示词;

3.评估提示词效果;

4.持续迭代改进;

通过上述4个步骤,优化后的提示词,将对AI对问题的处理能力大大提高。

插个题外话!基于AI的蓬勃发展,提示词工程师也随着AI的兴起孕育而生,有些企业开设了提示词工程师的岗位需求,伙伴们可以通过学习掌握提示词的方法和技巧,获得入职的机会。

回到正题,通过上述内容可以看出,提示词的有效性会直接影响大语言模型的输出质量。接下来我们可以一起来学习构建有效提示词的技巧。

二、提示词技巧

纸上得来终觉浅,绝知此事要躬行。学习这期内容,希望伙伴们能够在课后访问AI进行对话,做到边学边实践,效果会更好!

技巧1:直接提问法

直接提问,也称为零样本提示(Zero-Shot Prompting),即不给大语言模型提供案例,完全依靠AI自身的理解和处理能力完成任务。前文给的提示词例子,都属于直接提问。

目前大部分开源和商用的大语言模型已经经过了大量的训练和指令调试,能够很好的理解并响应用户的直接提问。

这种方法适用于目标明确、问题简单、答案确定且唯一的场景。

直接提问时,伙伴们可以遵循以下原则:

- 简洁:尽量用最简短的方式表达问题。过于冗长的问题可能包含多余的信息,导致模型理解错误或答非所问。

- 具体:避免抽象的问题,确保问题是具体的,不含糊。

- 详细上下文:如果问题涉及特定上下文或背景信息,要提供足够的详情以帮助模型理解,即使是直接提问也不例外。

- 避免歧义:如果一个词或短语可能有多重含义,要么明确其含义,要么重新表述以消除歧义。

- 逻辑清晰:提问题时,应该逻辑连贯,避免出现逻辑上的混淆或矛盾,这样才能促使模型提供有意义的回答。

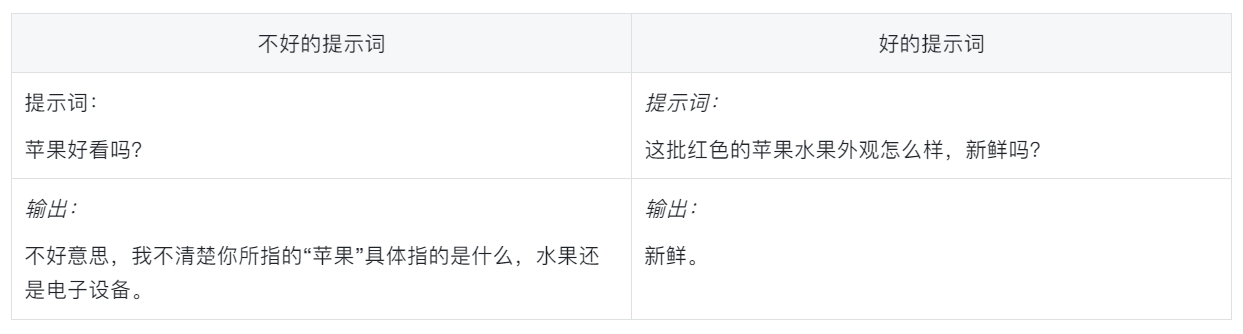

为了大家更好的理解,小侠例举以下提示词例子,大家对比答案就能感受到不同提示词对结果的影响。

不好的提示词,比如:苹果好看吗?

AI回答:不好意思,我不清楚你所指的“苹果”具体指的是什么,水果还是电子设备。

这个提示词并没有明确对“苹果”进行明确描述,因此导致AI无法理解苹果的真实含义。

好的提示词,比如:这批红色的苹果水果外观怎么样,新鲜吗?

AI回答:新鲜。

通过上述案例对比,可以看到表达清晰度对结果的影响还是很大的。

然而,直接提问效果在很大程度上取决于所使用模型的理解能力和泛化能力。

AI无法很好地处理复杂、模糊或多义性的问题,当需要较深入的背景知识或分析时,可能无法准确了解用户的真正意图。

我们可以尝试在提示词中增加示例样本、分配角色、提示写作风格、输出格式或构建思维链和思维树拆解复杂任务等方式来弥补AI能力上的不足。

技巧2:增加提示

在提示词中提供少量提示,通常几个或几十个具有标签的示例,也称为少样本提示(Few-Shot Prompting),用来帮助大模型更好地理解任务要求,从而获得更高质量的答案。比如:

- 让大模型跟随我们所要求的规范、格式、概念、文本结构和语气进行回答。

- 又或者提供进一步推理的参考,比如让大模型学会数学运算或按照示例方式进行逻辑推理。

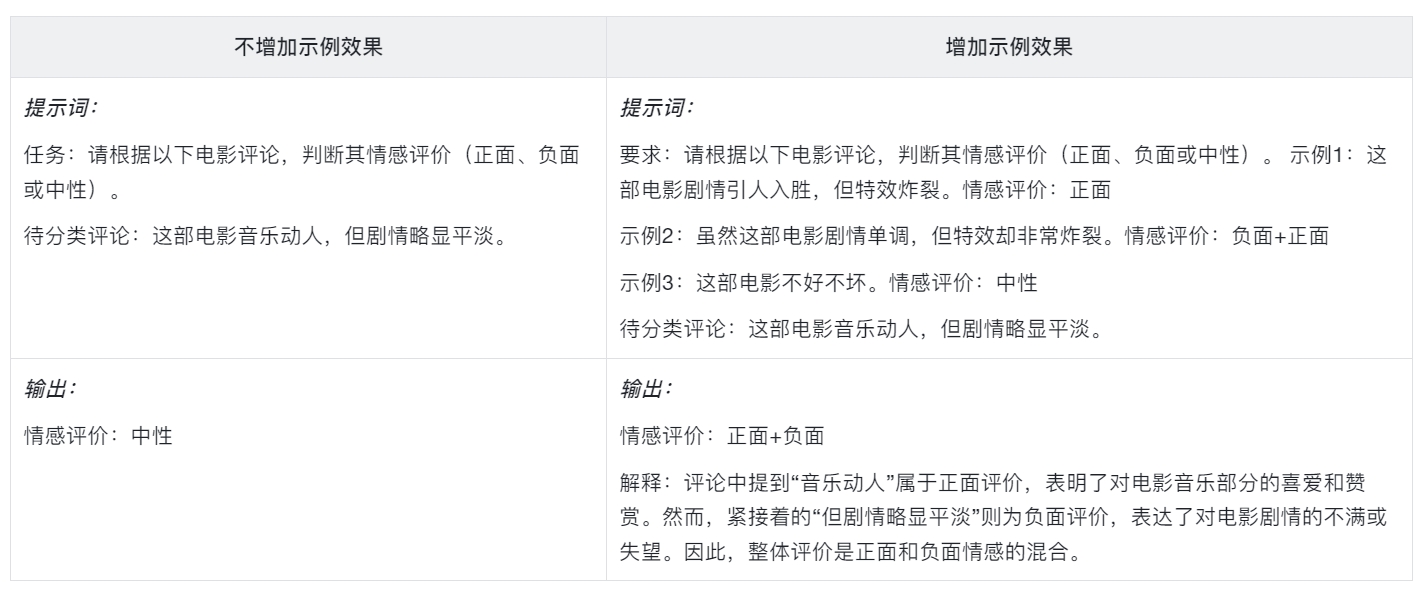

下面,小侠就例举提示词中增加示例和不增加示例的方式询问大模型,看看大模型分别给出的答案有什么差别:

不增加示例的效果,比如:请根据以下电影评论,判断其情感属于正面、负面或中性中的哪一类。

以下是电影评论内容:这部电影音乐动人,但剧情略显平淡,请你根据这个内容进行评价。

AI回答:中性!

虽然AI对评论进行了判断,但是并没有给出相关理由和解释,因此这个判断参考价值不高!

同样,我们采用增加示例的方式进行提问,看看AI的回答。

比如:请根据以下电影评论,判断其情感属于正面、负面或中性中的哪一类。 以下是我提供的示例参考。

- 示例1:这部电影剧情引人入胜,但特效炸裂。情感评价:正面

- 示例2:虽然这部电影剧情单调,但特效却非常炸裂。情感评价:负面+正面

- 示例3:这部电影不好不坏。情感评价:中性

以下是电影评论内容:这部电影音乐动人,但剧情略显平淡,请你根据这个内容进行评价。

AI回答:

情感评价为正面+负面。

AI给出的解释是:评论中提到“音乐动人”属于正面评价,表明了对电影音乐部分的喜爱和赞赏。然而,紧接着的“但剧情略显平淡”则为负面评价,表达了对电影剧情的不满或失望。因此,整体评价是正面和负面情感的混合。

很显然,增加了示例后,AI能够学习示例中的回复技巧,并进行模仿,这种回答质量会更高!同时更有利于我们判断AI的回答是否正确。

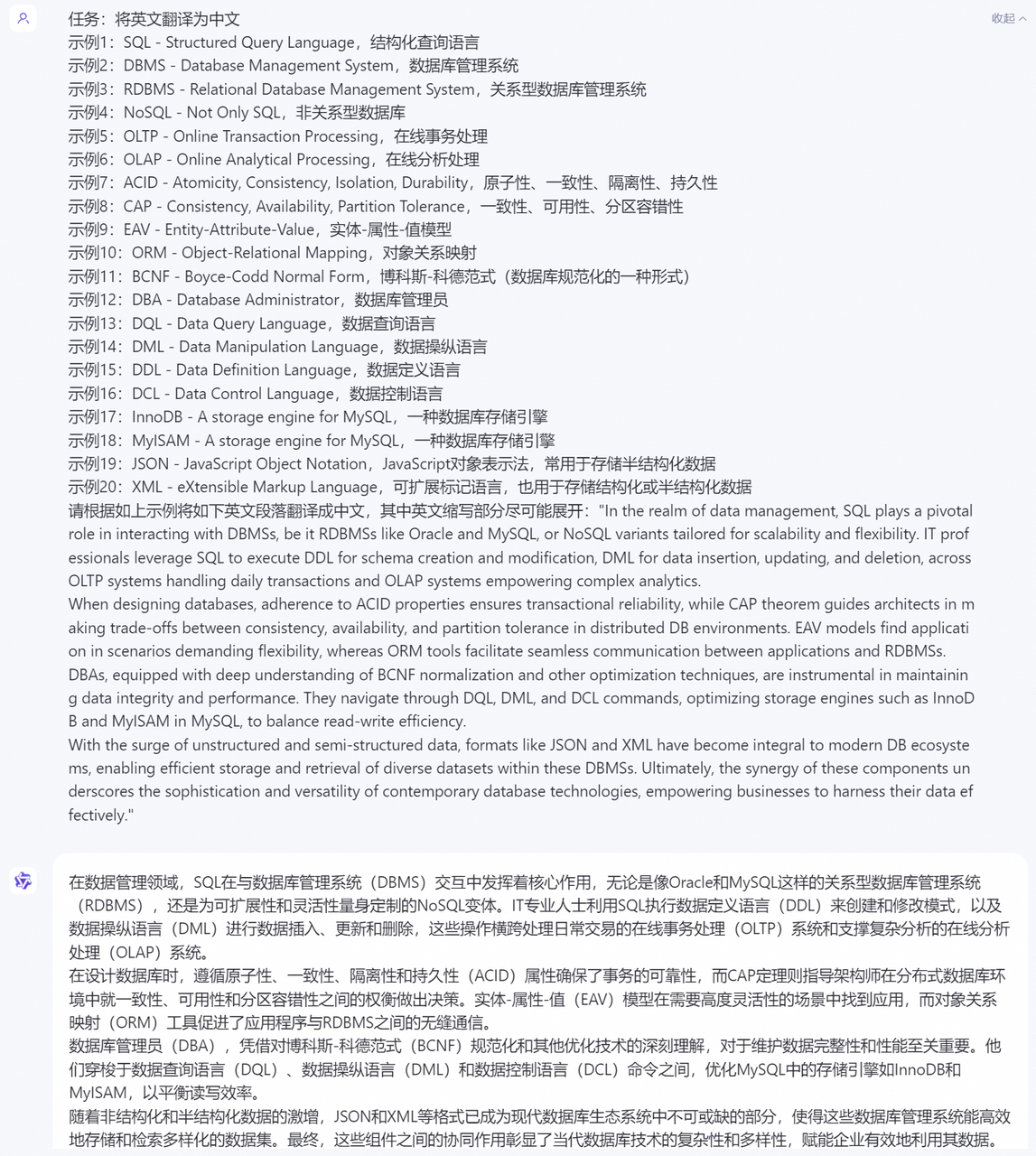

另外在日常工作中,让AI帮忙翻译是常有的事,但是很多专业性文档的翻译,会涉及大量的专属名词或者缩写!

在这种情况下,让AI进行翻译工作,我们就需要提供一些缩写翻译示例给AI,然后让AI根据示例进行翻译,这样能够极大提高翻译的准确性和质量,如图所示:

当然,上述案例只适合文本量较少的翻译工作,如果是非常专业且数量庞大的专业性翻译,上述方法显然AI是不能完成这项翻译工作!

这时,我们可以让大语言模型接入专业的术语库,也就是把涉及到的专业词汇整理成知识库,让AI能够检索知识库里面的专业知识,这样就能增强大语言模型的能力,这种方式也称之为“检索增强生成”,简称RAG,这方面的知识,小侠后面会跟大家单独分享。

另外很多企业想要训练私有AI客服,搭建了Agent后发现,回复的质量并不高!主要原因就是没有做RAG优化,因此想要搭建一个高质量的AI客服,RAG是必须懂的知识。

回到正题,给AI提供的示例的质量和数量会直接影响AI回答的结果,增加示例时可参考以下技巧:

- 精选代表性样本:选择具有代表性的示例,覆盖任务的各种情况和边缘案例,确保模型能从有限的数据中学习到任务的核心特征。

- 保证示例的多样性:尽可能覆盖任务的各种角度和情景,包括正常情况和特殊边缘案例,确保模型能从有限的数据中学习到任务的核心特征。

- 使用相似的格式和结构:使模型能够清晰识别输入与输出的关系。

- 让大语言模型生成示例:实践时,我们还可以先让 LLM 按照提示生成一些示例,再进行筛选或人工调整,以提高示例质量和针对性。

看到这里的伙伴,有没有一种想法!

怎么这么复杂!还不如自己干!搞个AI要花这么多心思!

有同样想法的伙伴可以评论区回复“麻烦”两个字!

其实大家思考一个问题!假设你是企业老板,你想招聘一个销售人员,人员到岗之后,你第一件事是要做什么?

让他直接联系客户还是先岗前培训?

当然是需要先岗前培训!

其实用AI替代部分员工的工作,AI在上岗前也是需要进行岗前培训,只有通过培训后的AI才能满足相关工作!

培训确实会花费比较多的时间和精力,但是相比真人员工,AI上岗后,你要花费的心思就小很多了。

这其实就是AI在实际业务中的价值,如果你还是觉得麻烦!那当小侠什么都没说!

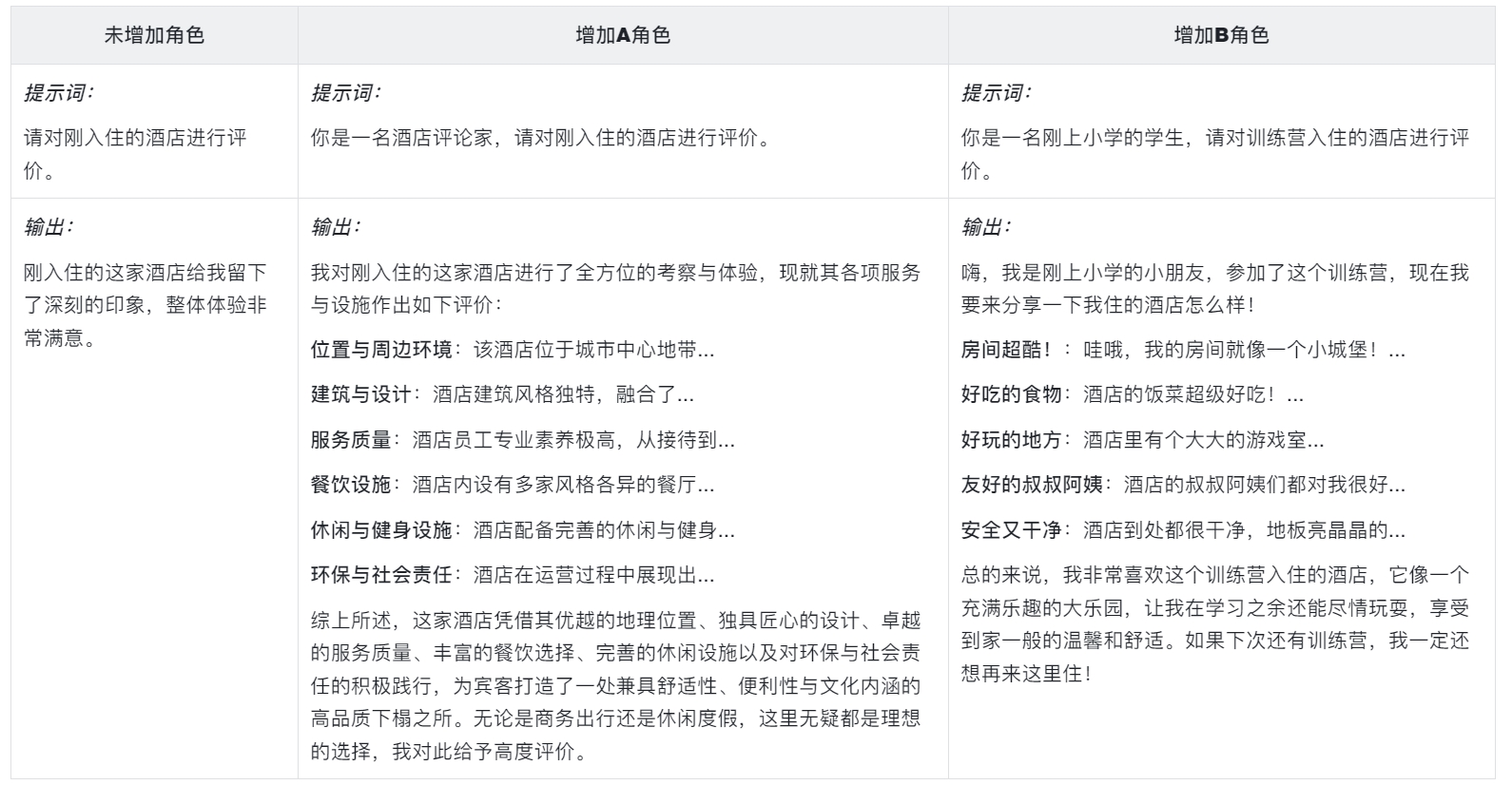

技巧3:分配角色

赋予模型一个具体的角色或身份,比如告诉AI“假设你是一名经验丰富的短视频专家”,通过角色设定,引导模型在特定角色视角下回答问题,这种方式非常常见!大家一定要掌握。

下面一起看看分配角色适用哪些场景:

- 需要专业知识或特定视角的问题解答。例如,模拟老师、医生、律师等回答相关领域的问题。

- 模拟特定人物或角色的语言风格。例如,模仿某个著名人物,例如历史人物或文学角色,让AI模仿他们的语言风格生成文本时需要用到。

- 进行角色扮演游戏或创作时。在创意写作或角色扮演游戏中扮演指定的角色,让AI与用户进行互动。

- 在特定行业内进行决策模拟。例如让AI模拟一个管理咨询师,帮助分析商业案例或提供商业建议。

以上几点,都是需要用到角色分配的场景。

下面,小侠列举几个不同风格角色的AI,让他对同一个酒店评论进行评价,一起看看不同角色在回复的时候风格的区别:

通过表中示例可以看出,不同角色的AI在回答同一个问题时,语气、风格、态度都有所不同,看过上一期【AI入门科普课】的伙伴应该知道!

AI在前期训练时,研发人员会给AI投喂不同专业的数据让其学习,如果使用的AI之前学习过相关角色的数据,当我们给AI赋予相应角色时,AI就能很好的模拟特定角色的风格和表达方式。

一般来说,通用大模型学习的知识都会比较全面,所以平时大家用AI的时候,让AI模仿任何角色他都能很好的模仿出来!当然,如果你选定的角色比较独特,也不排除AI在之前的训练数据中没有的角色风格,最后的结果就是模仿的效果并不理想。

另外使用过不同企业推出的大模型的伙伴,应该都感觉到不同企业的大模型,风格和能力会有所区别,这也是由于训练数据质量和数量差距导致的结果。

根据上述分配角色技巧的案例,下面小侠针对角色分配的方法给出以下技巧:

1)明确角色身份与特性

- 确定角色的基本属性,如年龄、性别、职业、性格、技能、价值观等。

- 赋予角色相关领域的专业知识或特殊背景,如专家、学者、历史人物、虚构角色等。

2)设定角色目标与动机

- 为角色设定对话的目标,如寻求信息、说服他人、解决问题、分享观点等。

- 揭示角色的内在动机,如个人利益、道德信念、情感需求等,有助于塑造角色的真实性和深度。

3)设定角色语言风格:

- 根据角色性格、教育水平、文化背景等设定其语言习惯、用词选择、句式结构、口头禅等。

- 规定角色在对话中的情绪状态,如冷静理智、激动愤怒、悲伤失落、幽默风趣等,影响其表达方式。

4)设定角色规则约束:

规定角色在对话中的行为约束,如不能人身攻击、保持礼貌尊重、遵守讨论主题等。

5)动态调整角色设定:

- 随着对话深入,适时调整角色设定以适应新的情景和话题,如角色态度转变、关系演变、目标更新等。

- 向模型反馈角色表现,如偏离设定、缺乏个性、对话僵化等,及时修正角色设定并引导模型调整。

本文由 @弼小侠AI之路 原创发布于人人都是产品经理,未经许可,禁止转载

题图来自Unsplash,基于 CC0 协议

该文观点仅代表作者本人,人人都是产品经理平台仅提供信息存储空间服务。

起点课堂会员权益

起点课堂会员权益

对ai知识感兴趣的伙伴,欢迎关注【弼小侠AI】公众号,分享更多知识给大家

那如果想让AI写营销软文的话也要喂示范的文章吗?试了一下总感觉纯靠提示词写不到位

更高质量需要用到一些技巧和配合,比如模型微调方面的知识