OpenAI发布最新模型o1应用场景和对大语言模型产品的7点启发

OpenAI 最新推出的 GPT-o1 模型,以其卓越的推理能力和安全性,为人工智能领域带来了新的发展机遇。本文深入探讨了 GPT-o1 的命名由来、安全性优势、适用的新场景,以及它在 AIGC 领域的七点启发。

OpenAI新模型为何命名为GPT-o1?

像人类一样在说话前花更多时间思考问题。通过训练OpenAI-o1学会了优化思维过程,尝试不同的策略,并能识别自己的错误。在国际数学奥林匹克(IMO)资格考试中,GPT-4o 仅正确解决了 13% 的问题,而o1推理模型的得分为 83%。它们的编程能力也在竞赛中得到评估,达到了 Codeforces 比赛的 89% 分位。

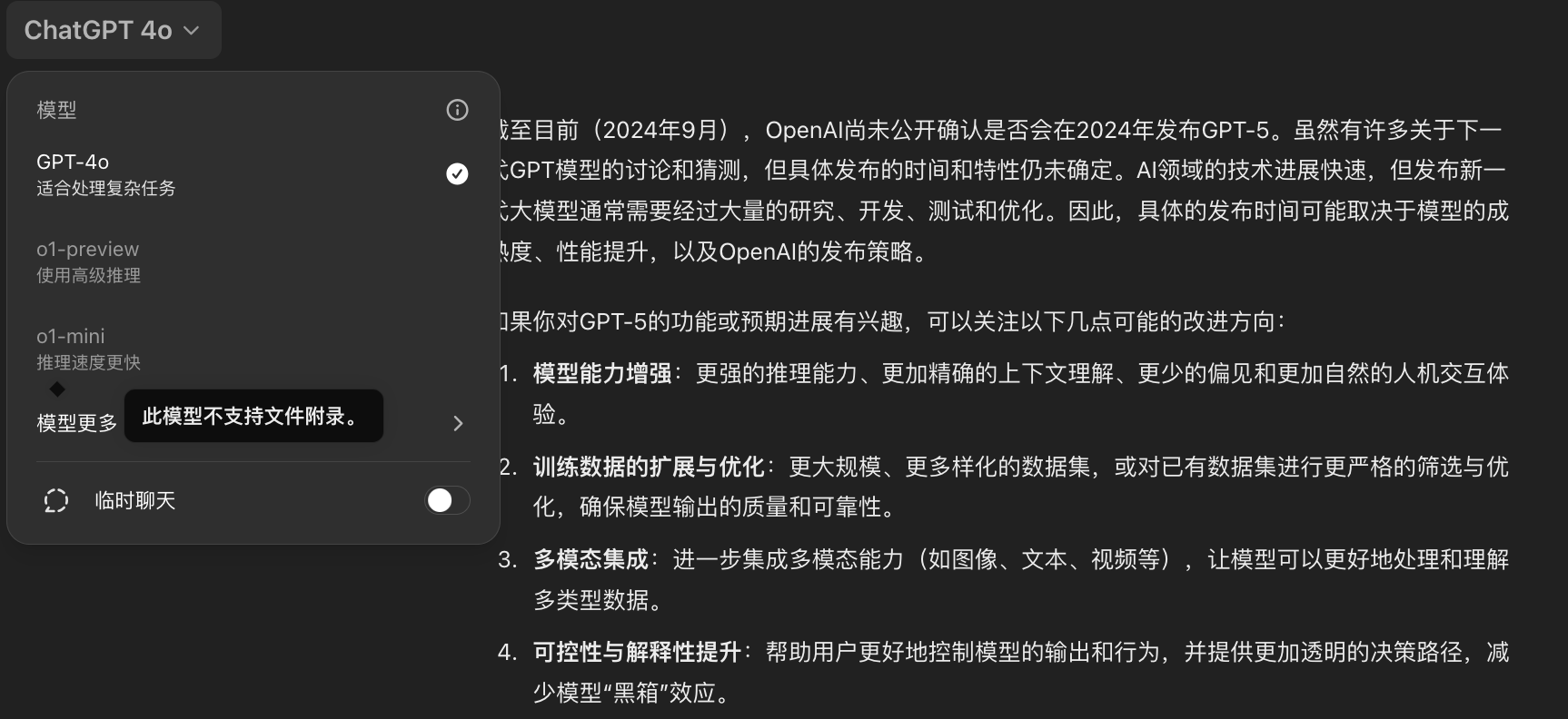

o1尚未具备许多让 ChatGPT 实用的功能,例如浏览网页获取信息、上传文件和图像。在许多常见情况下,GPT-4o 在近期内将更具能力。

但对于复杂的推理任务,这是一项重大进展,代表了人工智能能力的新水平。鉴于此,将计数器重置为1,并将这个系列命名为 OpenAI o1。

安全性

在开发这些新模型的过程中,o1提出了一种新的安全训练方法,利用模型的推理能力使其遵循安全和一致性指南。

通过在上下文中推理安全规则,模型能够更有效地应用这些规则。

衡量安全性的一种方式是测试模型在用户试图绕过其安全规则时(称为“越狱”)能多大程度上继续遵守安全规则。在最难的越狱测试之一中,GPT-4o 的得分为 22(在 0-100 的评分标准上),而 o1-preview 模型得分为 84。

适用新场景

在处理科学、编程、数学等领域中的复杂问题,这些增强的推理能力特别有用。

例如,o1 可以被医疗研究人员用来标注细胞测序数据,被物理学家用来生成量子光学所需的复杂数学公式,并可供各领域的开发者用于构建和执行多步骤的工作流程。

OpenAI o1-mini

o1系列在准确生成和调试复杂代码方面表现出色。为了为开发者提供更高效的解决方案,发布了 OpenAI o1-mini,这是一款速度更快、成本更低的推理模型,尤其在编程方面非常有效。作为一款较小的模型,o1-mini 比 o1-preview 便宜 80%,使其成为在需要推理但不需要广泛世界知识的应用中,一款强大且具有成本效益的模型。

一、如何使用 OpenAI o1

从今天开始,ChatGPT Plus 和 Team 用户将能够在 ChatGPT 中访问 o1 模型。用户可以在模型选择器中手动选择 o1-preview 和 o1-mini 两个版本。上线时,o1-preview 每周的消息限制为 30 条,o1-mini 的限制为 50 条。并使 ChatGPT 能够根据给定的提示自动选择合适的模型。

综上我们终于看到了推理阶段扩展范式的普及和生产部署。

二、o1 带给我们AIGC领域的启发

在预训练上的Scalling law到底有没有失效?

启发一:Scalling law 失效还是有效?

Scalling law 是缩放定律是物理量之间的关系,其中所有物理量都以幂次形式出现,持续的投放更多的算力卡在模型预训练输出结果上大模型的精度会幂次方提升吗?

目前OpenAI给出的答案是NO 1

如Sutton在《Bitter Lesson》中所说,只有两种技术可以随着计算资源的增加而无限扩展:”学习”和”搜索”。

目前OpenAI o1选择了搜索,既推理。

启发二:推理不是模型越大越好

推理不需要一个庞大的模型来进行。

因为许多参数都是为了记忆事实,从而在类似问答比赛(Trivia QA)等基准测试中表现良好。

实际上,可以将推理从知识中分离出来,也就是通过一个小型的“推理核心”来调用像浏览器、代码验证器这样的工具。

这可能会减少预训练所需的计算量。

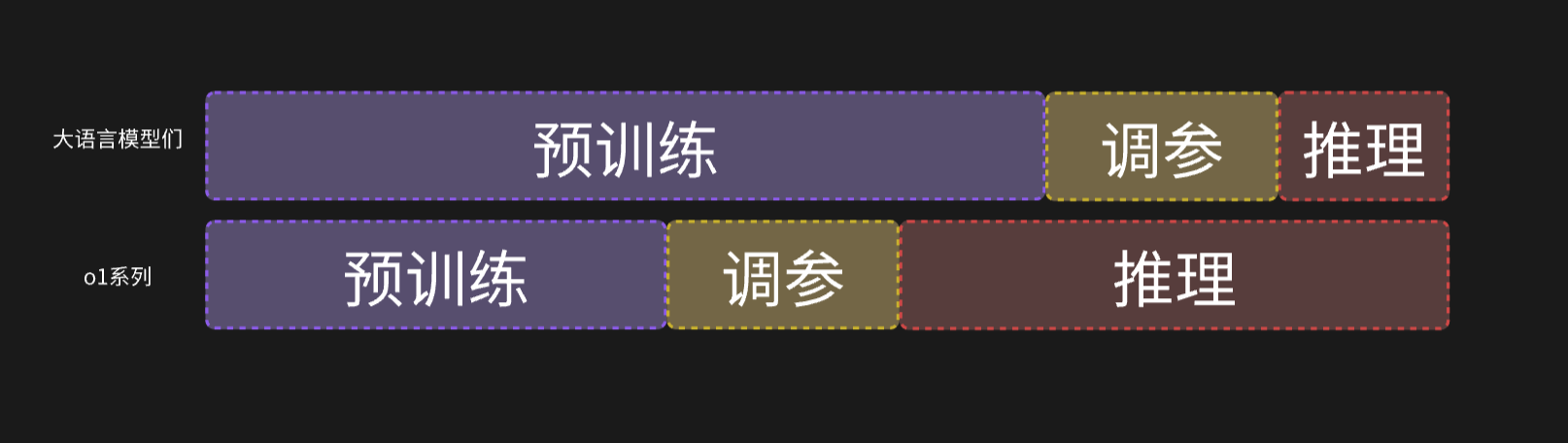

启发三:大量算力可以从预训练和调整参数到推理服务中

大型语言模型(LLMs)本质上是基于文本的模拟器。

通过在模拟器中展开多种可能的策略和场景,模型最终会收敛到优质的解决方案。

这一过程是一个已经被充分研究过的问题,比如AlphaGo的蒙特卡洛树搜索(MCTS)。

注解:蒙特卡洛树搜索(Monte Carlo Tree Search, MCTS) 是一种基于随机模拟的搜索算法,主要用于解决需要进行决策和推理的复杂问题,如棋类游戏(例如围棋、国际象棋等)。MCTS通过模拟游戏中的不同可能走法,逐步构建和优化决策树,从而在复杂的状态空间中找到最优策略。

启发四:扩展业务推理算力比扩招模型参数算力更高效

业界永远比学界领先一步实践,上个月,Arxiv上相隔一周发表了两篇论文:

- 《大型语言猴子:通过重复采样扩展推理计算》。Brown 等人发现,DeepSeek-Coder 在 SWE-Bench 上的表现从一次采样的 15.9% 提升到 250 次采样的 56%,超过了 Sonnet-3.5。

- 《在测试时计算扩展比扩展模型参数更有效》。Snell 等人发现,PaLM 2-S 在 MATH 测试中通过测试时搜索击败了大 14 倍的模型。

将 o1 产品化远比达到学界基准困难得多。在实际推理问题中,如何决定何时停止搜索?奖励函数是什么?成功标准是什么?何时在循环中调用像代码解释器这样的工具?如何考虑这些 CPU 过程的计算成本?他们的研究报告中并没有详细分享这些内容。

启发五:未来LLMs数据数量和数据质量比算力更有价值

MCTS搜索主要由四个步骤组成:

- 选择(Selection):从根节点(即当前局面)出发,根据某种策略(如 UCB1 算法)选择一个节点,沿着树的路径向下搜索,直到找到尚未完全展开的节点(即有子节点尚未探索的节点)。

- 扩展(Expansion):如果所选的节点有可以展开的子节点,那么会从中随机选择一个未被探索的子节点进行扩展,即将该节点加入到决策树中。

- 模拟(Simulation):从新扩展的节点开始,通过随机走法模拟出游戏的结果,直到游戏结束。这一步可以被视为对该节点后续发展的一次模拟评估。

- 回溯更新(Backpropagation):将模拟的结果从扩展的节点向上反馈,更新沿途经过的所有节点的统计数据,如胜率或价值。通过反复执行这些步骤,树中的不同节点逐渐得到越来越多的评估数据,帮助系统做出更好的决策。

构建搜索轨迹包含正负奖励的训练数据集的意义和价值可能比堆10000张卡有意义。

启发六:o1的应用场景

o1模型的应用场景,其实它并不适合所有情况。o1的链式推理更适合那些需要层层推导的任务,因为它擅长把问题拆解成多个步骤,逐步推理出结果。

类似CoT, ToT。

但问题是,有些题目本身并不需要那么复杂的推理过程,反而需要更直接的解法,这时候o1反而显得有点“用力过猛”。你让它处理一个不太复杂的问题,它可能会过度拆解,导致不必要的时间和算力浪费。这样一来,它的慢速反应和高计算成本就成了劣势。

而像需要嵌入奖励模型(reward model)的场景,o1就更能发挥优势。它通过反复推理和采样找到最优解,而奖励模型可以帮助它评估每个步骤的正确性,最终优化出一个更合适的答案。因此,o1特别适合那些需要多层次决策和精确推理的复杂场景,而并非所有问题都适合用它来解决。

启发七:LLMs创业不要在OpenAI炮火的覆盖边界里

这次o1会轰炸掉一批用LLMs做编程的项目、做医疗数据标注的项目

做LLM-agent优化大语言模型的幻觉问题的智能体也被轰炸了。

做大语言模型领域的创业产品,首先不要做OpenAI炮火覆盖范围内的,但是可以做很多OpenAI 10年内覆盖不到的产品!

专栏作家

连诗路AI产品,公众号:AI产品有思路。人人都是产品经理专栏作家,《产品进化论:AI+时代产品经理的思维方法》一书作者,前阿里产品专家,希望与创业者多多交流。

本文原创发布于人人都是产品经理。未经许可,禁止转载。

题图来自 Pixabay,基于CC0协议

该文观点仅代表作者本人,人人都是产品经理平台仅提供信息存储空间服务。

- 目前还没评论,等你发挥!

起点课堂会员权益

起点课堂会员权益