一文详解:车载人机交互

编辑导语:若想做好车载交互,你需要了解用户在座舱内可能发生的应用场景,进而针对这些实际场景,找准用户的真正需求,搭建相应的设计策略。本篇文章里,作者就车载人机交互设计做了全面拆解,一起来看一下吧。

一、座舱交互的目标

在了解座舱交互的前提,我还是讲万能公式:用户+场景+需求。

在座舱需要产生交互的两端是:人+车。

在座舱需要产生交互的场景是:娱乐场景、养护场景、休息场景、出勤场景,接送孩子场景,情侣恋爱场景,车内聚会场景,车辆出借场景,长途出行场景,自动驾驶场景,共享租赁场景,车外交互场景,智能家居互联场景等,都在我们与汽车的粘性范围之内,都需要交互设计师深度挖掘。

在座舱需要产生交互的需求是:对车机发出操作指令。

所以在做交互设计的时候,【最短路径】是交互设计考虑的第一步!根据三秒原则,触达的目标路径一定要短,才能够保证安全性和处理效率。

二、座舱人机交互的方式

随着科技发展和车主的期望,车内外的信息和功能越来越多,作为HMI设计师的任务就是让车主减少注意力资源占用,减少驾驶分神,所以交互方式由此产生阶段性变化:物理旋钮/按键——数字触屏——语音控制——多模态交互。

多模态交互的方式现有最常见的有触控、语音、手势。但在车载系统的设计中,这些交互方式必须紧扣实际场景下的交互方式与用户需求来设计。

1. 物理旋钮/按钮

从战斗机演变过来的传统物理旋钮,在用户按下功能键的一触即达,不是触控能产生的快感。而且物理旋钮比触控调节要省时安全得多,比如调节空调温度,物理旋钮可以给驾驶者一个调节刻度的触感,方便调节,这是触控所做不到的,而且触控调剂明显交互成本会增加。影响安全驾驶。

2. 触控

触控一种是通过按键控制;一种是通过触屏控制。都是通过不断的触控功能按钮行程锻炼肌肉记忆,现在的趋势越来越趋向重触屏、轻按钮,这样不仅系统迭代成本小,功能可以动态分布。但是对于一些精准调节的功能还是按键控制好一些。

3. 语音交互

语音交互被认为是车内场景下最自然的交互方式,基本会有三个场景:快速控制车辆场景;连接一切场景;主动服务场景。

语音控制的前景主要在于两个因素,一个是可以把除了界面以外的利用起来,一个可以与HMI自由交谈,二是最小化HMI手动操作产生的干扰,增加安全性。

语音交互作为新一代的交互模式,通俗的讲,就是用人类最自然的语言(开口说话)给机器下达指令,达成自己的目的的过程,这一过程包括三个环节:能听、会说、懂你。

4. 手势

手势交互是对语音交互、触控交互的很好补充,能够让车主通过简单的手势和语音就能完成车内的交互任务,也是能够增加交互趣味性、表达情感、传达情绪的另一个自然交互方式。

常用的手势:单指滑动(上下左右)、双指滑动(左右)、双指点击等。

HMI的交互手势不同于移动端。HMI的交互不仅用手指去操作,还有考虑用户会高频地使用手腕,因此横向的滑动和点击可以高频。屏幕是固定在车上的,要规避掉一些不方便的手势。比如双指往上滑动就很不方便,向上推不灵活,也有阻力。

5. 生物识别

移动端的人脸识别技术已经有了飞速的发展。现在开始逐渐被汽车引用。人脸识别作为有很强的自身个体差异性,人脸特征成为了验证身份的最佳依据。

目前车内配备语音识别、面部识别、指纹识别、掌纹识别、虹膜识别、视网膜识别、体形识别、打字节奏、步态识别等。

功能:

- 健康方面:检测驾驶者开车时的身体状况(如心率、血压、疲劳程度、血液酒精含量、可能出现的癫痫发作等),为司机、乘客以及公众安全带来更高的保障。

- 安全方面:指纹传感器、视网膜扫描和语音/面部识别技术取代传统车钥匙,用于访问和启动车辆。

科普:常见的生物特征识别包括:视网膜识别、虹膜识别、步态识别、静脉识别、人脸识别等。与其他识别方法相比,人脸识别具有直接、友好、方便的特点,使用者使用时无任何心理障碍,从而得到了广泛的研究与应用。近几年,人脸识别技术被引入汽车,逐渐成为智能汽车的标准配置。

三、交互开眼

开眼给大家分成了两部分,第一部分是国内头部“蔚小理”。

1. 国内头部智能座舱

1)蔚来

蔚来的语音是科大讯飞提供的底层技术支持。配合交互机器人NOMI的表情设计、消除了人机对话冰冷生硬。据说NOMI的表情有48种。全车搭载了4个麦克风,可以调节单独的座椅和空调。但是语音通用能力一般,很多应用不支持语音搜索。但亮点在于支持车窗,天窗等的程度控制。以及可以在多媒体上进行多伦的交互。

2)理想

在理想同学2.2版本中,可以四个麦克风同时控制互不影响。不同人的同一指令可以直接复制“我也要”就可以获得同样的设定。20秒连续对话。应用上基本都是所见即所说,可支持车辆中心、蓝牙电话、喜马拉雅、QQ音乐。

- https://v.autohome.com.cn/v-2159708.html

- https://www.pingwest.com/a/249451

3)小鹏

Xmart OS v2.1.0 版本更新中新增的“全场景语音”功能,在当时就让我觉得非常惊艳。车内分成的是双音区但是通过语音可交互的基本都是所见即可说。小鹏连续对话不固定时长,只要有对话就一直出于唤醒的状态。甚至氛围灯颜色的调节,指令倒数第几个都可以做到。

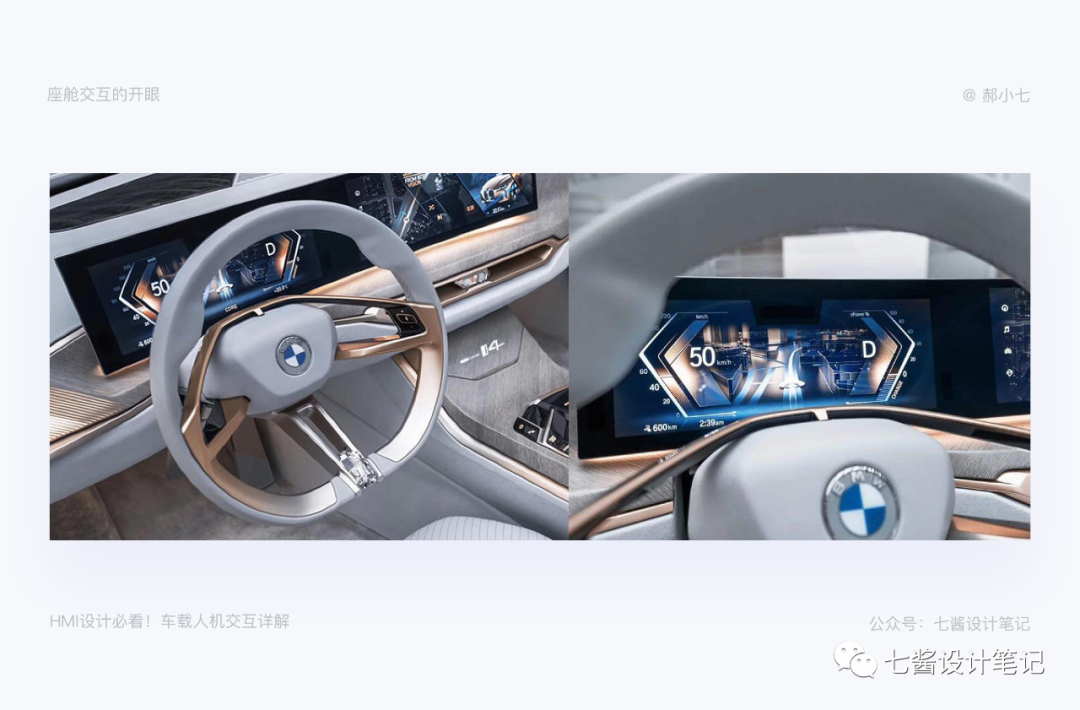

2. 前瞻智能座舱

1)BMW i4

交互搭建:语音+手势+智能表面座椅+物理按键+ARHUD。

2)奔驰EQS

梅赛德斯-EQ之夜:“电”亮美好未来-20210418_哔哩哔哩_bilibili:https://www.bilibili.com/video/BV1u54y1j7pX?share_source=copy_web

交互搭建:语音+手势+生物识别+ ARHUD。

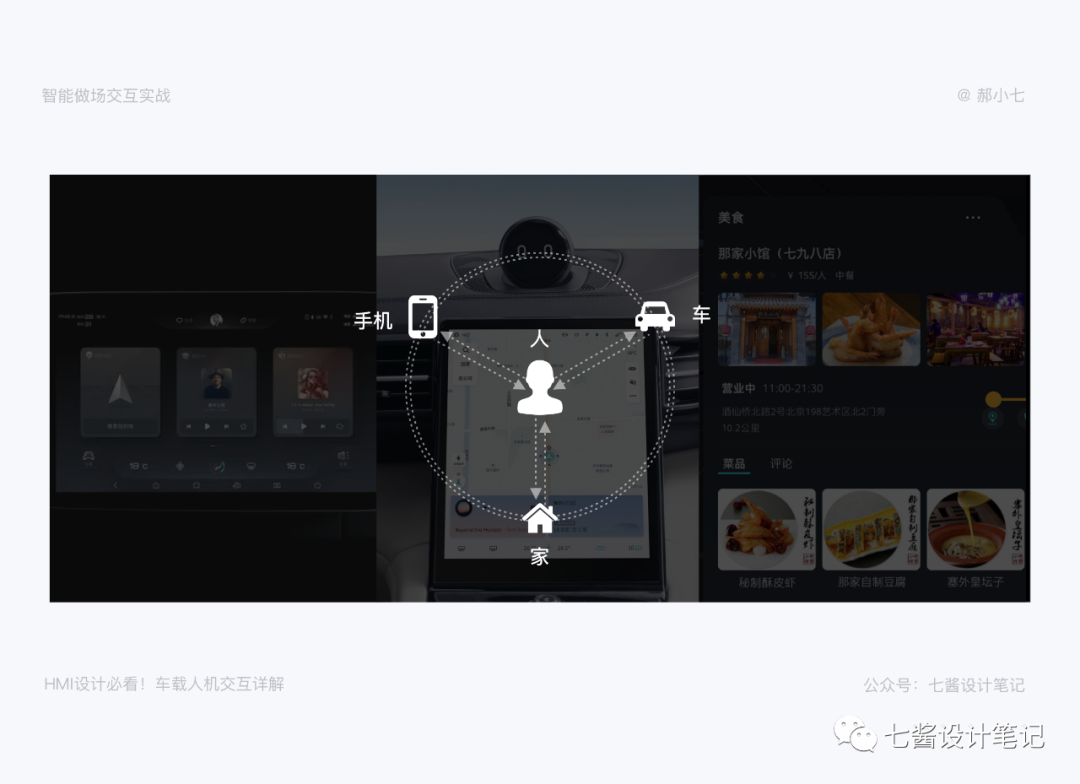

四、智能座舱交互实战

上篇《一篇带你读懂车载设计》中提到了交互的设计基本原则。所以我们直接主流座舱里的几个主要交互实战原理,但不会太深,因为下一篇我会主要说下语音交互。

1. 触控交互

1)物理按键

早期的中控台的屏幕只是显示收音机的一些信息,绝大部分的面积都是容纳超多的物理交互按键,这些按键基本都是靠触觉的交互来实现人机沟通的。

这种物理按键要考虑人体工程学,用不同的触觉方式,如按压,如轻触,如旋转,并以不同的触觉方式来划分好固定的区域,尽可能地让驾驶者熟悉后,就能够盲操这些交互按键。其中的部分常用按键会集成到多功能方向盘上,以便驾驶者在驾驶中也能便捷操控。

然后随着智能交互的发展,中控大屏的出现,物理交互按键开始逐渐减少。而中控大屏则占据着越来越大,越来越重要的位置。

一直到中控台的物理按键减到了近乎没有的程度,这个时候已经驾乘人员已经无法靠触觉来进行人机交互了(因为屏幕信息是变化的,按键也是虚拟的,且触碰起来千篇一律,没有手感可言),而这个阶段就逐渐转成了视觉的交互,人们不在通过触觉来进行人机沟通,而是主要通过视觉来进行操控。

也就是说你不能光摸了,靠手感(触觉)来辨别物理按键了。而是要看着(视觉)来进行操控。

实际视觉为主的沟通是符合人的认知规律的。根据某研究报告,人类获取外界信息的渠道有83%是来自视觉,其他的如听觉11%,嗅觉3.5%,触觉1.5%,味觉1%。

但是如果纯靠视觉来进行智能座舱的人机交互,人们还是会绝对诸多不便。尤其在驾驶期间,人的视觉注意力的90%都必须要投入到对路况的观察中去,不大可能把视线长期投入到屏幕上面,和智能座舱进行交互。

2)手势交互

你以为2021年特斯拉Model S引开创了汽车大屏时代,其实1986年,美国通用集团旗下品牌别克汽车,在Riviera在车上搭载第一块可触控的中控屏幕,远远早于特斯拉。

除了上篇说的手势交互的规则,说到手势咱们一般想到的就是触摸大屏,这次分享给大家一个物理按键与手势结合不错的案例。这次主要以ID.4为例,ID.4运用的大量的触摸式交互方式,对于直接换成大屏我觉得还是很友好的。比如交互方式有点触、滑动、双指触控,按压触控反馈等这些在方向盘或者中控底部的按钮进行触控。

3)知识延展

除了触控的交互还有非触控手势,比如在宝马高端车型上有了很多悬空手势操作,比如在空中食指画圈,就可以调节音量之类的。

2. 语音交互

VUI(Voice User Interface)语音界面设计,语音交互的好处就是可以传达情感、但交互准确性确实不如硬交互,但理想ONE全球首辆在车内放置四个全向数字麦克风。语音交互的重视程度可想而知。我之后会单写一篇设计语音交互的文章,这篇先让大家了解语音交互。

1)语音交互的原理:

自然语音的理解——语音识别——语音转化语音。

2)语音交互需要的场景

语音控制的场景应用有两个因素,一个是取代没有在屏幕展示的功能,可以与HMI自由交谈,二是最大限度地减少HMI手动操作产生的干扰,从而提高安全性。

① 功能场景

我们车内的场景是什么样呢?

一是当你下班回家,希望在开车过程中快速控制车辆、查询信息、空调、座椅等。当你长途旅行时中途查询服务区和加油站,以及行程规划。二是用语音链接一切。车里的音乐、副屏娱乐都可以快速唤起。所以我们需要做的就是快速控制车辆-链接一切+主动响应。

A. 快速控制车辆

基本功能包括调节车内氛围灯,调节音量,调节车内空调温度,调整车窗,调整后视镜,快速控制车辆的本意就是帮助驾驶者更快的掌控车辆,减少注意力的分散,增加安全驾驶系数。

在远途时语音交互作为实现功能的一个入口,系统会理解驾驶员的语音指令,提供智能导航。除了被动的接受任务,还可以提供目的地推荐和行程规划的附加服务。因为系统通过整合餐厅,商场,服务区,再用算法为驾驶者千人千面提供服务方案。

在这个场景下用户的基本需求就是搜索路线,期望需求是可以同时汇报前方的服务站,兴奋需求可能就是在搜索目的地时可提供的智能化的地点推荐。所以在我们设计语音交互的时候要结合业务产品定位,达到预期需求。

B. 车辆和驾驶者监控

在实时的驾驶过程中,可以随时与询问车辆性能和车辆状态,比如胎压、水箱的温度、冷却剂和机油。实时的信息询问可以帮助驾驶者提前处理信息,当然到警戒临界点的时候也要实时提醒。

除了对内监控当然也要对外监控,生物识别和语音监控的混合监控可以监控驾驶者的情绪。在适当的时候提醒驾驶者打起精神,以避免交通事故的发生。以及行驶长时间的疲劳语音提醒。

C. 在多媒体娱乐方面

开车场景,播放音乐和广播是最高频的操作和需求。我们出了提供除了简单的播放,暂停和切换歌曲等功能外,还有一些收藏、登录账号、打开播放历史、切换播放顺序,以及直播互动更多的个性化的功能等待开发。

3)语音交互设计流程

我们先来阶段科普下语音交互设计的流程,因为基本语音交互都是外接第三方,但是作为HMI设计师,也要了解整个语音交互的设计流程,这样才可以作为设计语音形象的依据,能让那个IP更好的贴合使用场景。

基本现在VUI的设计流程,和我们日常设计需求的流程相似,首先分析使用场景——创建用户画像和用户旅程图——设计听觉IP——编辑脚本——梳理指令逻辑和交互——建立插槽库——交付走查。

4)脚本设计

语音设备需要以一种自然对话的方式进行感知、认知以及输出自然语言,在VUI设计过程中需要遵循识别前(声音信号识别与优化) ——识别中(声音信号的理解)——识别后(信息反馈及播报)。所以整个语音交互设计下来,核心是信息的接受和设计。

① 脚本清晰简洁高效

语音指令断句和语气会让驾驶者理解成本增加。以及明确肯定的问题也是防止用户纠结的原则。

脚本的文案和UX设计的微文案有相似的逻辑,清晰的文案可以帮助用户更好做出下一步的指令判断,比如“登录有误,请重新登录”用户会认为自己的操作失误导致没有登录成功,可以优化成“当前系统未更新,请更新后再登录”

简洁的考核指标就是是否能在正常的语速下不换气一句话读完。

人们获取信息高效的方式往往是短时间记忆一个精简的信息。比如“导航去天安门,全程14公里,预计需要30分钟”。用户其实记忆最深刻的就是30分钟,所以不光要精简信息,还要把重要信息放到后面。

② 符合生活,轮流交谈

鼓励用户自然的表达同时机器也要给出自然的反馈,让对话更加自然有以下方法。在交流的语境中用户说话会省略一些表达,所以也要支持理解代词和省略的表达,“今天天气怎么样”+“明天呢?”

在语音对话过程中,除了要像两个人对话一样,还需要语音助手需要对用户的回答进行引导和判断,以及提供方案。比如用户说“今天天气挺好的”可以回答“今天天气气温11度到26度,多云转晴现在晴,需要打开空调吗?”引导用户做出指令。

③ 容纳错误

语音交互中必须要允许有容错机制,基本容错也是分场景处理的,一是没听清,这时会让用户再说一遍,二是听清了但是不具备处理问题的能力,三是识别成错误信息,这是再次确认即可。

3. 人脸识别

A. 凯迪拉克XT4的解锁系统

通用旗下首款全面应用车联网创新“云服务”的车型:凯迪拉克人机互联网系统,它的人脸识别智能身份解锁系统堪称黑科技。

可以触摸B柱的按键,就能激活汽车,B柱的液晶屏会进行人脸扫描识别。就会解锁成功汽车,你就能发动汽车。

为了方便你的亲戚朋友使用这辆车,这套人脸识别系统还能添加多个用户账户,可以实现多账号解锁使用,不仅要采集脸部数据,还要收集相关指纹,增加安全性。

B. 拜腾K-Byte Concept:双重保险识别系统

它推出的首款SUV车型K-Byte Concept就以科技型配置主打市场,让这辆车科技化变成一个亮点。

最具有科技水平的还要数那一套面部识别系统,它是把解锁和启动集为一体,它也是把脸部识别区域设计在B柱上。

1)人脸识别的原理

座舱内部的人脸识别主要涉及三个部分:人脸检测、人脸鉴别、人脸确认。随着整个互联网信息生物化,很多平台都录入面容信息,车机作为万物互联的一个点,而且随着更多移动端的使用场景移到车内,账户登录,身份认证需要在车内进行。

2)使用场景

- 行驶前:上车校验车主信息、登录应用ID。

- 行驶中:人脸识别是行驶中闭眼疲劳的主要工作场景,以及打电话提醒、没有目视前、打哈欠。

单纯的交互会让驾驶者更加不方便,比如只有语音,很容易产生误指令、单纯的触控会让驾驶员满足不了三秒原则,语音、手势、视觉等多个交互方式融合才能,才能让智能系统能够更准确、方便、安全地在各种场景和驾乘人员进行沟通。

参考链接

《车载人脸识别系统到了哪种程度?不怕坏人用照片偷车吗?》:https://www.sohu.com/a/256296919_116215

#专栏作家#

郝小七,微信公众号:七酱设计笔记,人人都是产品经理专栏作家。蜻蜓FM高级UI设计师,5年工作经验。专注于体验设计,欢迎各位同学一起交流。

本文原创发布于人人都是产品经理,未经作者许可,禁止转载。

题图来自Unsplash,基于 CC0 协议。

起点课堂会员权益

起点课堂会员权益

错字连篇,毫无框架逻辑,凑字数来的。