AR 交互设计 的 beta“信息素”推荐

AR是在真实环境中增添或者移除由计算机实时生成的可以交互的虚拟物体或信息,下面这篇文章是笔者整理分享的关于交互设计的相关内容,想要了解的同学可以进来看看哦!

随自己从事AR设计以来,我深刻且实际的体验到AR设计不再是“那块儿屏幕”的设计,做AR设计要考虑的方面是多维的,总结以下几个重要的点:

- 人因(人所处的物理世界的环境、光线、声音、以及人本身的状态等)。

- 眼镜的硬件(波导技术、成像方式、成像亮度、光机、FOV、性能能耗等)。

- 需求合理性(眼镜不再是二维终端的需求思维,在与产品需求讨论的过程中始终伴随着一思路:不合理的需求会让AR眼镜的交互变得愚蠢异常)。

问:那到底是什么AR呢?

知乎答:AR即增强现实(Augment Reality)是一种实时计算摄像机影像的位置及角度并结合图像、视频、3D模型技术,经计算机生成的三维模型、音乐、内容等虚拟信息应用到现实世界,两者信息互补,将虚拟世界和现实世界融合的。

简单来说是让电子设备读懂真实世界,并在真实世界的基础上叠加虚拟世界,从而实现增强现实的效果,为用户提供一个虚实融合沉浸式的体验。主要的应用场景包含文旅行业、商业空间、智慧零售、教育、工业等场景。

我定义成:它是一种需要你的大脑计算画面信息的一种新的界面呈现方式。

那AR设计又是什么呢?我觉得AR设计一门要求综合性思维非常强的一个设计工作,因为它的发生的体感是在二维的平面上,显示的体感却是在三维上,所以我把AR设计定义成:展示在三维世界的二维画面。

要做AR设计首先要清楚以下基本的概念。

一、光波导技术

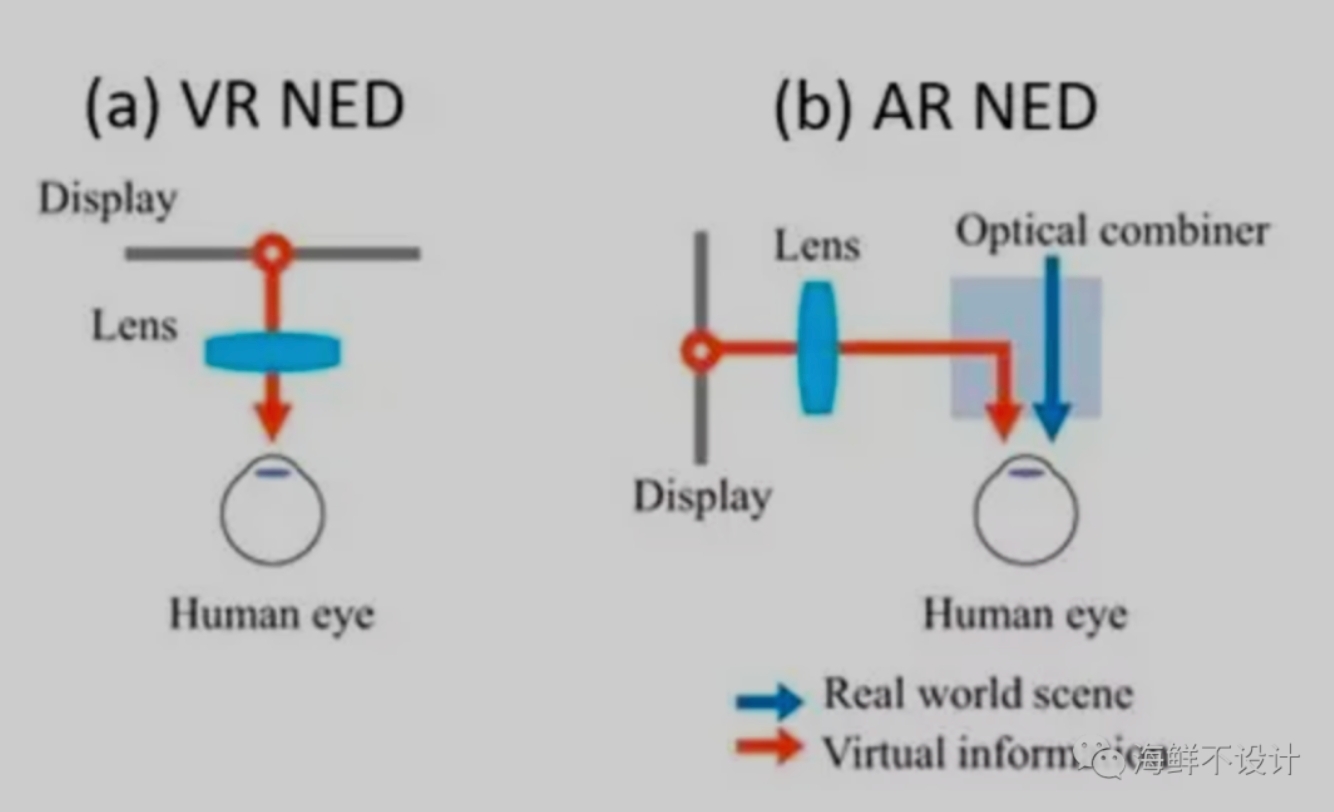

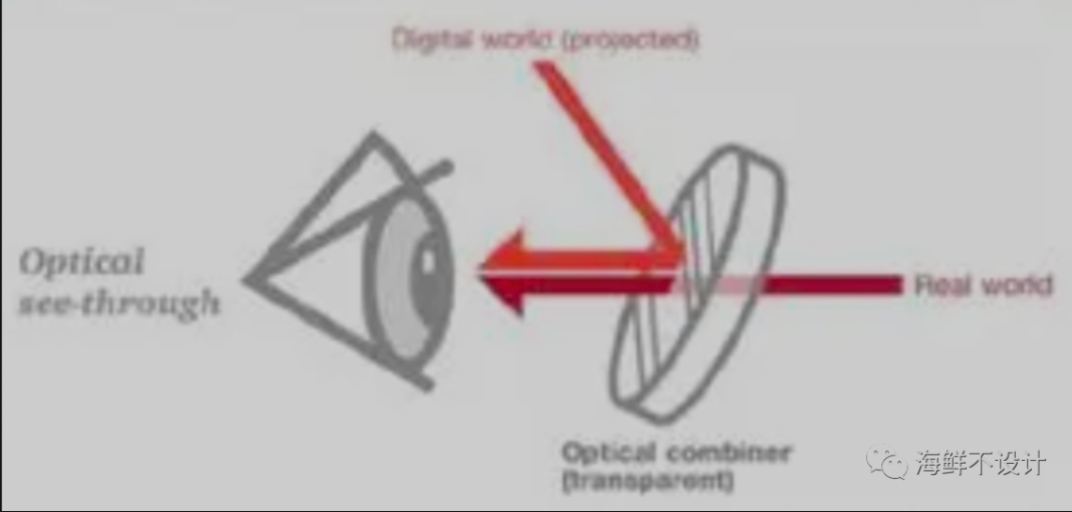

主流的一共分为两类:几何光波导(阵列光波导)和衍射光波导,它们是消费级AR眼镜目前最优的解决方案。AR眼镜需要透视(see-through),既要看到真实的外部世界,也要看到虚拟信息,所以成像系统不能挡在视线前方。这就需要多加一个或一组光学组合器(optical combiner),通过“层叠”的形式,将虚拟信息和真实场景融为一体,互相补充,互相“增强”。

图 1. (a) 虚拟现实(VR)近眼显示系统的示意图; (b) 增强现实(AR)近眼显示系统的示意图。

NED:近眼显示(Near-eye display,简称NED)关于几何光波导和衍射光波导,我们设计需要关注的深度,我觉得只要知道优缺点即可,并不需要下探到很深的技术结构层面(如果你个人比较感兴趣,可以去网站上去搜索,这里就不展开了)。

几何光波导:“几何光波导”的概念最先由以色列公司Lumus提出并一直致力于优化迭代,至今差不多快二十年了。

缺点:

- 透光效率比传统光学系统偏低。

- 工艺流程复杂,良品率低,常见有背景黑色条纹,亮度不均匀。

- 在息屏的情况下,镜片上会有有一排竖条纹(即镜面阵列),可能会遮挡一部分外部视线,也影响 AR眼镜的美观。

- 成本较高。以此为代表的是 影目和珑景、Rokid Vision。

优点:图像质量、颜色和对比度可以有较高的显示水准。

衍射光波导:衍射光波导技术与几何光波导相比主要优势在于光栅在设计和生产上的灵活性,不论是利用传统半导体微纳米制造生产工艺的表面浮雕光栅,还是利用全息干涉技术制成的体光栅,都是在玻璃基底平面上加镀一层薄膜然后加工,不需要像几何光波导中的玻璃切片和粘合工艺,可量产性和良率要高很多。另外,利用转折光栅或者二维光栅可以实现二维扩瞳,使得动眼框在鼻梁方向也能覆盖更多不同脸型的人群,给人体工程学设计和优化用户体验留了更大的容差空间。由于衍射波导在Y方向上也实现了扩瞳,使得光机在Y方向的尺寸也比几何光波导的光机减小了。

优点:

- 良品率高、可以覆盖更多不同脸型的人群,给工业设计预留了更多空间。

- 支持二维扩瞳目前AR圈中对衍射波导推崇的一个原因在于其可以实现二维出瞳扩展。所谓二维出瞳扩展可以认为是在牺牲光效的代价之下,将光学系统的光阑(可以理解为相机的光圈)在水平和垂直方向上复制多次来扩大系统所能容纳的视场角,并扩大眼动范围。如果将系统的总光学扩展量想象成一股水流,进行一维和二维出瞳扩展就类似于在花洒的不同档位间切换,并无物理本质上的提升。

缺点:

- 光源的肉眼可见性、图像彩虹问题、画质模糊,光效只有1%、能耗高

- 体积较大;以此为代表的是:vision pro、hololens、magicleapone、Rokid Glass 2

二:DOF

业界一般分成 3DOF 和 6DOF

3DOF即3自由度,只有旋转坐标,没有位移坐标,只能以设定好的虚拟头部为中心点,一切观察的基点都源于头部的视角,就像是固定在电线杆上的摄像头,可以任意旋转,但无法上下左右前后位移离开电线杆。

因此在3DOF VR设备中,玩家只能看却摸不着,所以3DOF VR设备,主要用于观影体验。

6DOF:6DOF即6自由度,在3DOF基础上再增加“上下、前后、左右”等3个位置相关的自由度。头部从3DOF只能检测到头部转动姿态到6DOF可以检测伸头缩头等姿态,而且还可以检测身体移动上下前后左右位移的变化。所以6DOF更加符合人体体验,更具沉浸感。

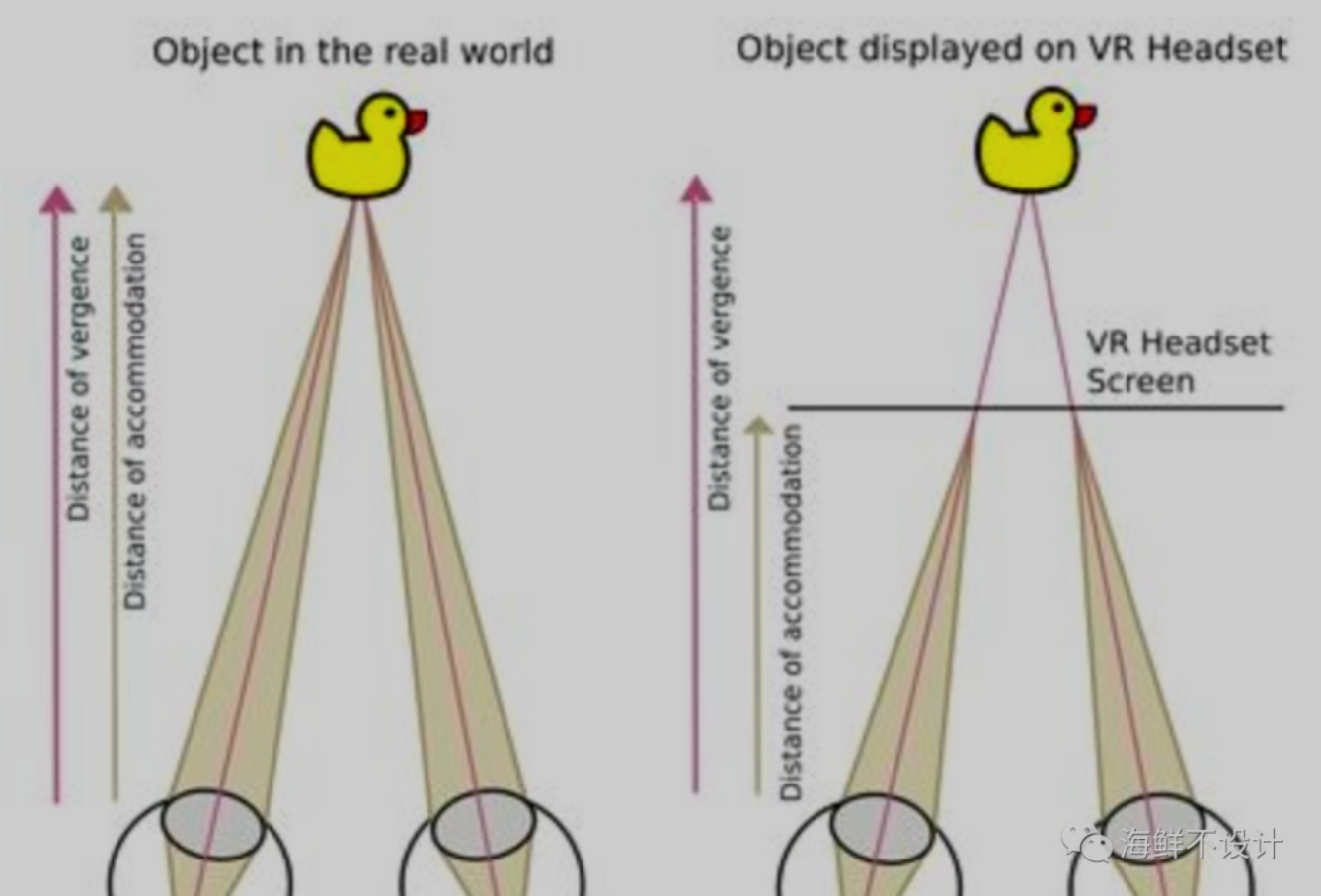

三:辐辏调节

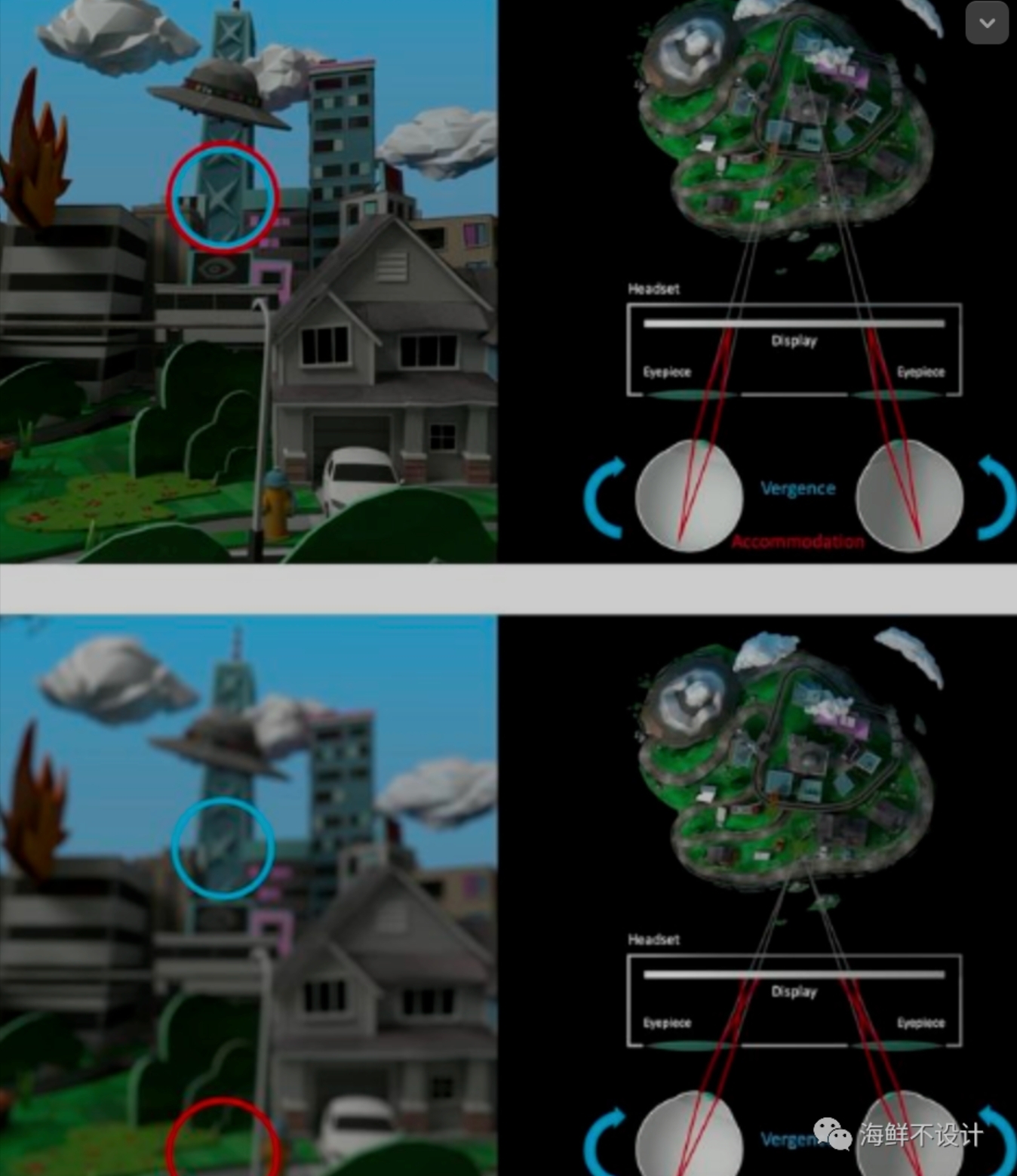

在自然视觉中,调节和会聚常常一起工作,会聚的程度会影响眼睛晶状体的调节,反之亦然,从而保证灵活而强大的视力。当我们观察远处物体时,眼球的晶状体会放松,视线平行以保持远距离的聚焦状态。但观察近处物体时,眼睛会收缩晶状体调整焦距,让视线聚焦到物体上。如果大脑接收到眼睛调节和会聚之间的线索不匹配时,就会发生辐辏调节冲突(Vergence-accommodation conflict,以下简称 VAC ),对眼睛造成压力。

在 VR 中情况有所不同。3D 图像总是显示在眼前固定距离的屏幕上,为了获得清晰的图像,眼球晶状体聚焦的距离一直不变——调节固定。当你看向不同距离的物体时,仍然需要旋转眼球让视线汇聚到不同深度的物体上——会聚(辐辏角度)不断变化。如果用户想看清一个焦距小于屏幕的虚拟物体,就要增加会聚角度。这时调节视线方向和调节晶状体焦点之间不匹配,打破了原本大脑里自然的对应关系,冲突(VAC )也就出现了。

四、人类瞳距与画布

- 正常男性瞳距大约为61mm,女性约为58mm,

- 一般停留在3-5m左右,用户在看的时候比较合适

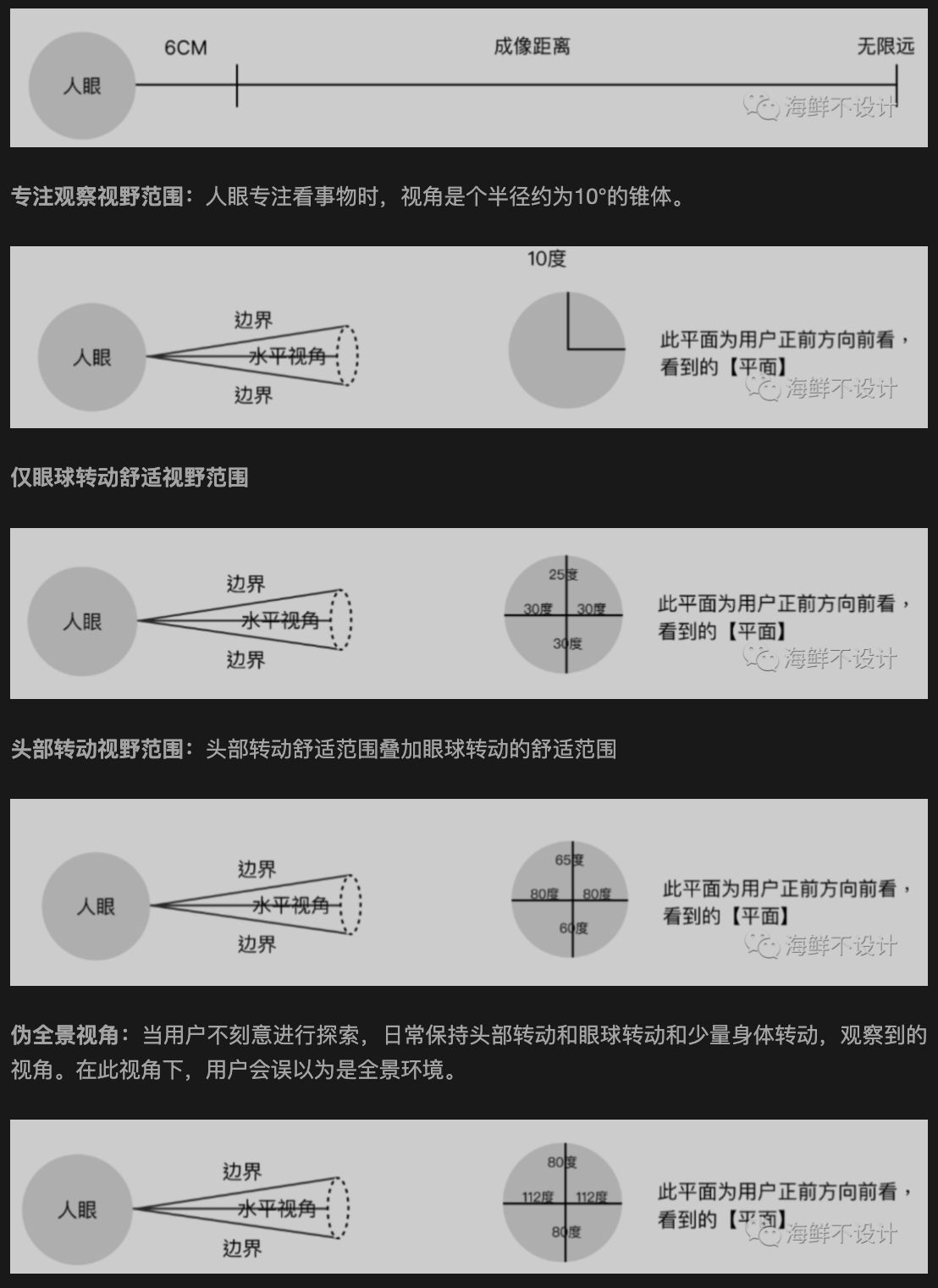

- 人类视觉:人类视觉跟随用户的视角,他的舒适可视角度会有不同

人眼成像距离:学术上,人眼可以聚焦看清最近6cm,最远无限远的图像

五、透视技术 See-Through

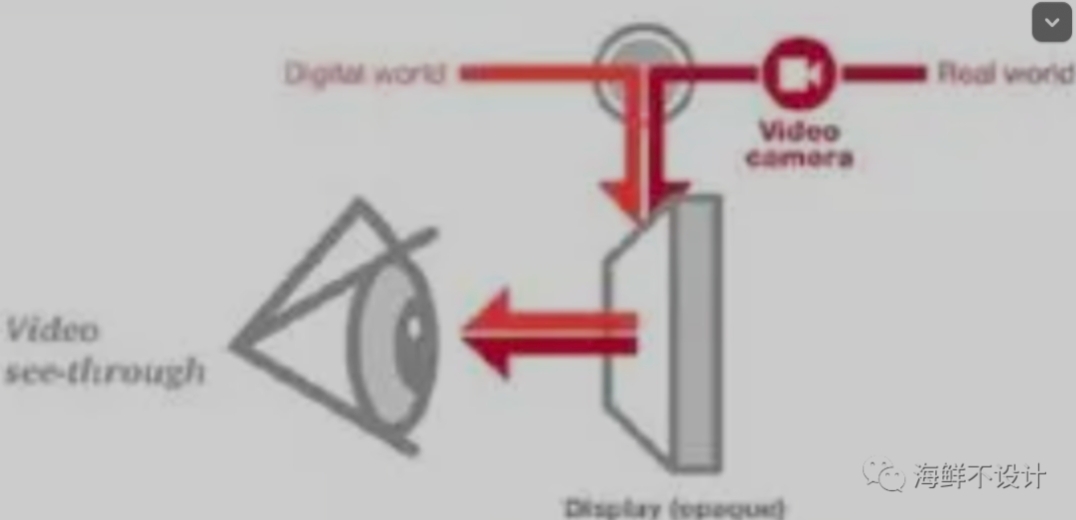

透视方式一般分成 2 种:光学透视,英文全称为Optical See-Through,简称OST,视频透视,英文全称为Video See-Through,简称VST。

OST:其体感可以理解为戴了一个光学镜片去看外部世界,外部世界的光线直接通过眼镜片进入到眼睛当中。真实世界是通过放置在用户眼前的半透明光学合成器看到的。光学合成器也被用来将计算机生成的图像反射到用户的眼睛里,从而将真实世界和虚拟世界结合起来。

VST:就像拿着手机照相,外部的世界通过摄像头显示在手机屏幕上,通过手机屏幕看到外部世界。真实世界是通过相机捕捉到实时视图,然后与计算机图像技术结合在一起,将相机捕捉到的“真实世界”与计算机生成的“虚拟图像”叠加后,共同呈现在不透明的显示器上,达到类似透明的效果。

以上就是我认为交互设计师要知道的 AR 的一些基础信息。

专栏作家

海鲜不设计,公众号:海鲜不设计,人人都是产品经理专栏作家。关注AR 、社交和电商领域,擅长数据分析、需求分析及赋能业务。

本文原创发布于人人都是产品经理,未经作者许可,禁止转载。

题图来自 Unsplash,基于 CC0 协议

该文观点仅代表作者本人,人人都是产品经理平台仅提供信息存储空间服务。

- 目前还没评论,等你发挥!

起点课堂会员权益

起点课堂会员权益

产品经理专业技能指的是:需求分析、数据分析、竞品分析、商业分析、行业分析、产品设计、版本管理、用户调研等。

产品经理专业技能指的是:需求分析、数据分析、竞品分析、商业分析、行业分析、产品设计、版本管理、用户调研等。