如何分析A/B实验结果

互联网行业中,数据驱动的决策模式已成为主流。但在实际操作中,如何确保数据的有效性及其对增长的直接影响呢?本文将通过一个系统化的步骤框架,指导如何通过A/B测试精确地驱动业务增长。

01 分析和应用实验结果的重要性

分析和应用实验结果是增长实验流程中的最后一步,但却是至关重要的环节。

这一步骤直接决定了整个增长实验是否成功,以及能否为业务增长带来真正的价值。

分析和应用实验结果的主要目的有三个方面:

第一,给出一个系统性的框架来分析实验结果,确保分析过程的严谨性和全面性;

第二,得出可信的结论,判断实验是否成功以及成败的原因;

第三,最大化实验的影响,将成功实验的洞察应用到产品优化的方方面面。

只有做到这三点,才能真正发挥增长实验的价值,推动业务的快速增长。

02 评估结果可信性

评估结果可信性是分析和应用实验结果的第一步,在对实验结果进行分析之前,我们必须先评估结果的可信性。

这是整个分析过程的基础,如果实验结果本身就存在问题,缺乏可信性,那么无论后续如何分析都可能得出错误的结论,从而影响决策的正确性。

因此评估可信性是分析和应用实验结果的第一步,也是极其重要的一步。

1. 评估方式

评估结果可信性的核心标准是统计显著性。

所谓统计显著,就是指实验组和对照组的差异是由实际因素导致的,而不是由于随机误差等偶然因素导致的。

只有达到统计显著的结果,才能被认为是可信的,才能作为下一步分析的依据。

否则,我们就有可能对偶然现象做出过度解读,得出错误结论。

上一篇文章已经详细阐述如何计算统计显著性,本文就不再赘述了。

2. 评估结果可信性的常见坑

在评估结果可信性的过程中,我们需要避免一些常见的误区和陷阱,否则可能会对实验结论产生偏差。

(1) 实验跑的时间不够长,导致结果出问题

a. 实验刚上线就分析早期指标,过早下结论

一个常见的坑就是实验刚刚开始没多久,我们就迫不及待地去看那些早期指标数据。

由于实验初期样本量还很小,数据的波动性会非常大,很容易产生误导。如果这时候掉以轻心,就可能会对阶段性的优势或劣势做出错误判断。

因此我们一定要忍住,等到数据累积到一定程度,结果相对稳定了再下定论。

b. 实验结束过早,只包含高频用户,没收集足够样本

另一个坑是实验停得太早。有些实验可能在达到统计显著后就被急忙叫停了,但由于时间还不够长,覆盖的用户还不够全面,导致只有一些高频用户的数据被纳入实验,缺少了中低频用户的反馈。

这样的结果是片面的,无法代表整体用户的真实反应。这一点在一些长周期的决策指标上尤为重要,比如月留存率等。举两个例子:

第一个例子是 Airbnb 的搜索价格过滤器的测试,把搜索页上的价格过滤器上限从 300 美金调大到了 1000 美金,想知道这样的变化是不是能让预定数增加?

实验流量非常大,7天之后发现新版本提升显著,但是继续运行 30 天后却发现最终和对照组差别不大。

这在统计学上其实有一个名称叫做新奇效应,也叫做均值回归。

在增长实验的早期,很多时候用户会因为新奇去关注新的改动,但是过一段时间可能就消失了。

这也提示我们在进行增长实验的时候,千万不要用最早期的指标来下结论,而是要耐心的让它跑够时间,达到统计显著,甚至再多跑一段时间,帮助我们能够最终确认实验的结果。

第二个例子是某健身APP,它对课程选择页面进行了 AB 测试。

这个健身 APP 有三类用户,高频率的用户是每天都来,大概占30%;

中频率的用户是每周至少来一次,大概占50%;

低频率的用户大概每两周来至少一次,占整个用户的20%;

由于这个产品的用户量也很大,仅仅跑了3天,这个实验结果就达到了统计显著,就得出结论说新版本更好。

但是真的是这样吗?大家可以想象一下,如果实验只跑了 3 天的话:

首先,在实验里包含的绝大部分是高频用户,大部分的中频用户和低频用户可能还没有进入实验。

其次,没有考虑到周中和周末这个可能对用户行为产生影响的因素,所以这个实验犯的错误就是以偏概全。

所以我们在进行 AB 测试增长实验的时候,要仔细地衡量跑实验的时间,尽量让所有的用户都有机会能够进入到这个实验里,而不仅仅是根据一小部分用户的行为得出结论。

(2) 实验设置不合理,导致结果不可信

a.中途更改实验设置

有时候实验跑到一半,我们会心痒痒,想要修改一些实验设置,比如调整流量分配比例等。

但这样做会导致前后数据缺乏一致性和连贯性,从而失去了可比性。

所以一旦实验开始,任何设置就都不应该再修改了。

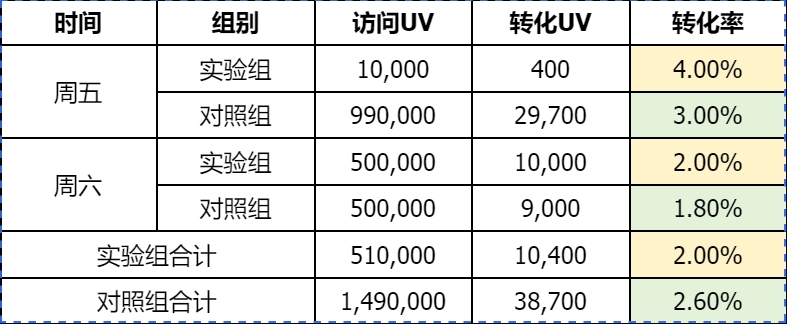

同样举一个例子,微软的员工在做实验的时候就犯过一个错误:

周五的时候他们给测试中的一个版本分配了 1% 的流量,周六的时候又把流量增加到了50%,虽然在周五和周六这两天单独来看,新版本的转化率都比原版本高,但是当数据被汇总的时候,新版本的转化率反而变低了。

所以如果微软的工作人员按照这个结果来作出结论的话,就会做出一个错误的结论。

这在统计学上也有一个名词叫做辛普森悖论——某个条件下的两组数据分别讨论的时候是一个结果,但是合起来的时候却发生了相反的结论。

因此大家在做增长实验 AB 测试的时候,开始实验之后不要去更改实验的设置,流量的分配,否则就可能对实验结果产生影响。

b. 同时跑多个实验,互相干扰

如果同一时间在同一流程中同时进行多个实验,就可能出现交叉污染,不同实验相互影响。

比如同时在注册流程的不同步骤各做一个实验,就可能导致用户分流出现问题。

因此在实验的规划和执行中,要合理安排实验时间和页面,避免各个实验”打架”。

c. 实验版本与设计不同

有时候我们会发现,开发上线的实验版本与产品设计稿存在出入,或者开发自作主张修改了一些设计,这就会导致实验结果出现偏差。

因此除了前期要做好设计评审,在实验开发过程中也要及时复核,确保严格按照设计方案执行。

(3) 无法有效分析结果或得出错误结论

a. 实验设计不完善,没设置好指标或只关注单一指标

实验设计阶段考虑得不全面,没有设置好评估指标体系,或者只盯着某一个单一指标,就可能导致我们对实验的整体效果评估不准,得出片面的结论。

因此前期一定要认真设计指标,确保关键指标和辅助指标全面覆盖。

b. 人为因素干扰实验,如大促销等

有时候我们会在一些特殊时间段进行实验,比如电商大促期间测试优化注册流程。

但节假日大促会给实验数据带来极大的偶然性,用户行为与平时相比会出现很大波动。

因此我们要尽量避开这些特殊时段,选择相对稳定的时间区间来做实验,这样得出的结论才更有说服力。

c. 做实验的人员有偏好,选择性看结果

我们每个人或多或少都会带有主观偏好。在分析数据的时候,难免会更多地关注那些支持自己观点的数据,而忽视那些相悖的数据。

这种有意无意的选择性偏差,可能会扭曲我们对数据的客观判断,使得分析结果失真。

因此我们在做实验分析时,一定要秉持客观中立的原则,用开放的心态看待每一个细节,不预设立场。

03 分析实验结果

1. 分析实验结果概述

在确认了实验结果具有统计显著性,可以作为有效数据之后,我们就进入到了分析实验结果的环节。

分析实验结果是整个实验分析与应用流程中的第二步,它为最终的决策应用奠定了直接基础。

这一步的主要任务,就是要搞清楚实验最后是成功了还是失败了,如果失败了,原因出在哪里。

只有解决了这两个问题,我们才能为后续的实验迭代或者产品化决策提供有价值的依据。

2. 主要回答实验是否成功,若失败原因何在

判断实验是否成功,是分析环节的首要任务。

如果实验组表现出了显著的正向优势,达到了我们预期的效果,那么就可以初步判定实验是成功的。

如果没有达到预期,或者出现了负面影响,那么我们就要判定实验是失败的。

对于失败的实验,我们还要进一步分析原因。是对用户行为的预判出现了偏差?是实验素材或者体验存在问题?还是实验效果只在某些特定人群中显现,而总体效果被稀释了?

只有找出症结所在,才能为失败的实验”把脉问诊”,指导后续的优化方向。

增长实验的核心在于通过数据验证假设,实现产品的优化和业务的增长。

3. 要全面衡量三类实验指标

(1) 核心指标:最关键,看是否按预期提升

要客观评估一个实验的效果,仅看某一个指标是不够的,我们要建立起一套全面的指标评估体系。其中最关键的是核心指标,它直接反映了本次实验的主要目标。

如果核心指标出现了显著提升,达到了我们的预期,那么就说明实验是有效的。如果没有变化,或者出现了下降,那么就说明实验是失败的,我们需要反思优化思路是否有问题。

(2) 辅助指标:看变化是否符合预期,与核心指标趋势是否一致

除了核心指标,我们还需要观察一些辅助指标的变化情况。这些指标虽然不是直接的优化目标,但它们能够帮助我们更好地解释核心指标的变化原因。

比如我们在做一个提升直播间购买转化率的实验,核心指标是”购买转化率”,而”直播间平均停留时长”就可以作为一个辅助指标。

如果我们发现实验组的购买转化率提升了,同时平均停留时长也有所增加,那就说明我们的优化措施提升了用户的观看兴趣和参与度,从而间接带动了购买的发生。

但如果停留时长不升反降,购买转化率却上涨了,这就有悖常理,我们就要重点排查数据异常的原因。

所以通过观察辅助指标与核心指标的一致性,可以帮助我们完善对实验机理的洞察。

(3) 反向指标:看是否有明显负面影响,影响是否可接受

任何一项优化,都可能带来一些负面影响。提升购买转化率的同时,可能会带来客单价的下降;改进了推荐算法,可能会导致用户刷屏时间变长。

因此我们在实验分析时,除了看正向指标,也要观测反向指标。通过反向指标的量化分析,我们可以直观地评估实验的负面效应。

如果发现负面影响显著且超出了预期,那就需要谨慎考虑实验是否值得继续。但有时为了核心指标的提升,一些可控范围内的负面影响,也是可以接受和容忍的。

关键是要对不同指标进行权衡,协调兼顾,避免顾此失彼。

4. 可考虑短期和长期两种观测周期

(1) 短期观测:实验达到统计显著即可得出结论

大多数情况下,当一个实验达到了预设的统计显著性要求,并且积累了足够的样本量后,我们就可以得出可靠的结论了。

这适用于那些优化效果比较直接、立竿见影的实验项目。比如一个Banner的文案优化实验,当各组的点击量达到显著性差异时,我们就可以判定优胜版本了。

这种短期即可见效的指标,通常观察周期在1-2周左右。

(2) 长期观测:实验停止后还需观察一段时间,监测对重要指标的影响

但对于一些重点优化项目,尤其是涉及到产品核心体验、影响用户长期价值的项目,我们在实验期结束后,还需要对其进行长期的跟踪监测。

比如优化App的启动速度,短期内各项指标表现都不错。但我们还需要持续观察一段时间,看看用户的次日留存、周留存等长期指标是否真的因为启动速度的提升而获得了改善。

又比如上线了一个新功能,短期数据显示活跃有所提升。但还要观察一段时间,看看提升是否只是新鲜感导致的昙花一现,还是真的激发了用户的内在需求。

像Pinterest 这样一个图片流的网站,它在进行新用户激活实验的时候,至少都要等 28 天的时间观察用户的次月留存率,才会最终做出结论。

这就是长期观测的重要性。它能帮我们洞察优化效果的”延迟性”影响,全面评估价值。

5. 实验结果有四种状态

(1) 指标大幅提升+统计显著:实验组获胜,改进方向正确

这是最理想的一种实验结果。它表明我们的优化思路是正确的,实验版本的体验明显好于对照组,能够显著提升关键指标。

当出现这种结果时,我们就要果断地采纳实验版本,并思考如何进一步放大它的效果。

(2) 指标小幅提升+统计显著:实验组获胜,但提升空间不大

这种结果表明我们的优化思路虽然是对的,但提升幅度有限。各种原因都可能导致这一点,比如优化空间本身就不大,或者投入产出比不够好等。

在这种情况下,我们要权衡实验方案的优先级。如果还有其他潜力更大的优化方向,我们可能就要先去做那些”大头”,而把这个实验方案暂时搁置。

当然,积小胜为大胜,日拱一卒也能成就千里长城。关键要把握投入产出的平衡。

(3) 指标下降+统计显著:对照组获胜,改进方向错误

如果实验组不仅没有带来正向提升,还出现了显著下降,说明我们的优化思路可能存在问题,改进的方向可能是错误的。

这时一定不要灰心,因为每一次失败都代表了一个排除项。要客观地分析,究竟是需求假设有误,还是体验实现不到位,然后总结教训,调整优化方向。

相比那些毫无波澜的实验,有明显负向作用的实验其实更有价值,它们能给我们更多启发。

(4) 无统计显著差异:对照组获胜,改动的元素可能是无关紧要的

还有一种常见的实验结果,就是实验组和对照组之间没有统计显著的差异。两组数据太过接近,没有明显的差异性。

这通常表明,此次改动的细节可能是一些无关痛痒的点,并不足以对用户体验或者行为产生实质影响。

基于这个认知,后续设计优化方案时,就要把精力聚焦在那些真正的关键点和痛点上,去做一些动作更大、影响更深的改进,而非在细枝末节上纠缠。

6. 分析实验失败的原因

(1) 细分漏斗,找出与假设不一致的环节

实验失败并不可怕,可怕的是不去分析失败的原因。

例如某APP对注册流程进行了 A/B 测试,结果发现对照组转化率是27%,实验组是23%,以为旧版本获胜。

但运营人员进一步的分析,按照平台进行拆解,发现在移动端是对照组的表现更好,而在桌面端其实是实验组的表现更好,所以在不同的平台上,实验结果是不一致的。

针对这一洞察,运营人员就在想是不是实验组的设计对于移动端不够友好?

细查之后就发现实验组的页面太长了,导致在手机上,最主要的这个按钮下一步被推到了第二屏,用户需要滑动才能够看到。

解决此问题后继续进行实验,结果实验组的转化率有了大幅度的提升,在各个平台上都比对照组的表现更好。

(2) 对实验结果分群,看不同用户群体表现是否一致

除了漏斗纵向拆解,我们还可以进行用户横向划分。用户并非铁板一块,不同属性的用户群体,对同一个改动的反应可能大不一样。

比如尝试了一个大幅简化购物流程的优化,但整体转化率并没有提升。这时我们可以用RFM模型把用户分层,看看不同价值层级的用户表现如何。

可能会发现,尽管总体指标没变化,但新用户的转化率提升了,而老用户的转化率却下降了。

这就提示我们,简化购物流程可能更有利于新用户的引导和教育,但可能影响了老用户的购物效率。

(3) 直接与用户做定性访谈,观察反馈

除了定量分析,定性反馈也必不可少。尤其是对于一些偏重体验和感受的改动,我们很难通过数据完全说明问题。这时候,与用户直接对话就很重要了。

通过访谈或者问卷,我们可以直接听取用户对新旧两个版本的主观感受。他们的困惑、不适和抱怨,往往能带给我们意想不到的启发。

(4) 通过后续实验验证新的假设

实验失败,往往意味着我们原有的优化假设可能有问题,但同时也可能激发我们产生一个新的想法。这时候,最科学的做法就是用实验的方法,去严谨地验证我们的新假设。

例如某电商网站,依靠卖某种商品作为主要的营收来源,而这个商品在网站上品类的入口本来是放在右上角,运营人员下把它改到左上角,因为觉得这样更醒目,但是没想到做了这个变化之后,这个商品的点击率下降了非常的多。

同样它通过新老用户分解发现其实问题都出在老用户身上,因为老用户习惯了原来的位置,找不到了之后就没法点击了,所以他进行了后续的实验,提前给老用户通知,然后引导他们去点击这个新的位置,结果在新的版本里面,老用户的这个商品的点击率也上升了。

实验是一个探索的过程,每多迭代一次,我们对真相的认知就更进一步。

04 决定实验下一步

1. 决定实验下一步是流程的第三步

当我们分析完实验数据,得出了实验成败的结论,并找到了背后的原因后,就要基于这些洞见来决定实验的下一步走向了。

这是我们实验分析与应用流程中的第三步,直接关系到价值的最终变现,意义重大。

2. 主要回答是否产品化应用、是否放弃实验、是否继续迭代优化

实验后的决策无非三种走向:

如果实验非常成功,就要考虑尽快把优化方案应用到全部产品中,扩大价值;

如果实验失败,可以直接放弃这个优化想法,把资源投入到其他项目中;

如果实验结果不尽如人意,但我们又有了新的优化思路,那就需要进一步细化假设,继续实验迭代。

选择哪一种方向,取决于实验的效果、投入产出比、优先级排序等多重因素。

3. 实验完成后的下一步选择

(1) 实验成功,产品化应用并最大化影响

一个成功的实验项目,下一步就是要推广应用,把效果扩大化。但我们不能简单地就直接全量上线新方案,而是要通过小规模滚动发布逐步产品化。

成熟的产品迭代流程中,都有一个灰度发布的环节。我们先在5%的流量上做小规模测试,没问题后扩大到10%、20%,最后再逐步扩大到全部用户。这个过程就是产品化应用的”小步快跑”策略。它可以帮助我们及早发现问题,及时止损。

(2) 实验失败,选择放弃并清理实验代码

对于一个失败的实验,果断放弃是一种智慧。一个早早失败的项目,能够帮助我们及时止损,把资源释放出来做更有价值的事情。

但在放弃实验时,我们也要注意做好实验现场的”清理”工作。实验的相关代码分支、配置项等,都要及时归档或删除,避免沉淀下来成为历史包袱。

同时,我们还要把实验的得失总结记录下来,供后人借鉴。

(3) 实验结果不理想但有新想法,选择继续迭代优化

有时实验的结果不尽如人意,短期指标没能达成预期,但我们从失败中获得了新的洞察,激发了更多灵感。

这时我们大可不必轻言放弃,而是要集中团队的智慧,头脑风暴,积极寻求新的突破口。

也许,看似失败的尝试,最后酝酿成了一个非常成功的优化方案。”失之东隅,收之桑榆”,这就是持续实验迭代的意义所在。

4. 放大成功实验的影响的三种方式

(1) 乘胜追击:针对该点做更多实验,进一步提升指标

一鼓作气,再而衰,三而竭。当我们在某个优化点取得突破后,就要趁热打铁,在这个方向上做更多文章。

比如我们发现,在商品详情页增加一个价格对比模块,可以显著提升下单转化。那接下来我们就可以细化这个对比的内容和形式,去测试不同的竞品选取方式、不同的页面布局等,看看还有没有进一步提升的可能。

集中资源,快速迭代,把价值潜力全部榨取出来。

(2) 举一反三:把洞察用到产品其他地方

任何一次实验,其价值都不应局限于当下的某个场景。一个实验的背后,往往蕴藏着对人性和用户行为的更广泛洞察。

比如前面提到的商品详情页价格对比,我们从中得到的启示是,用户在购买决策时,其实非常在意”货比三家”,希望看到更多参照。

那这个认知,其实可以被应用到其他的场景中,来指导更多的优化。比如在分类列表页,是不是也可以提供同类产品的价格区间作为对比?在订单结算页,是不是也可以给出”月销量Top10商品”的价格作为参考?

好的洞察,用到哪里都不嫌多。把洞察和心得用到产品渠道的其他地方,就是举一反三了。

(3) 调整实验方向:根据结果重排其他实验优先级

基于实验结果,我们要反思自己的实验计划和假设。也许,一些之前并没有排在最优先的实验构想,现在看来是大有可为的。那我们就要及时调整实验的优先级队列,让资源向最有希望的方向倾斜。

比如我们原本计划先做一个界面美化的项目,但最新的实验数据告诉我们,用户最关注的其实是商品的品类丰富度。那我们应该改变策略,先把主要精力投入到丰富商品库存上来。

05 做好实验结果记录

1. 将实验结果、心得、后续计划都记录在实验报告中

一个完整的实验报告,不仅要呈现实验的结果数据,还要包含实验心得和后续计划。实验数据是客观的事实,但解读数据需要主观的智慧。

将我们对数据的洞察、对成败原因的思考都记录下来,能够让实验报告更具价值。

同时,每一个实验都应该是一个起点而非终点。我们要基于实验的结论,规划后续的迭代计划或者决策建议,把价值落到实处。

2. 好的实验记录习惯对后续实验有指导意义,避免重复测试

养成好的实验记录习惯,能让我们的实验经验得以传承和复用。一个团队做的实验越多,积累的报告和数据也就越丰富。

每做一个新实验前,都能先回顾以往的相关实验,借鉴前人的经验教训,就可以避免走很多弯路。尤其是团队新人更迭时,详实的历史实验报告可以帮助新人快速上手,也避免了重复测试浪费资源。

3. 积累的实验报告可作为新人培训工具

实验报告不仅是一份”死”的文档,更是一份”活”的教材。它记录了一个产品、一个团队在不同阶段的优化思路和实践案例,是产品优化智慧的结晶。

通过组织新人学习这些案例,我们可以帮助他们快速建立起产品优化的思维模型,理解实验的基本逻辑。

同时,历史上那些经典的实验项目,也可以成为内部分享交流的素材,帮助团队成员互相启发,集思广益。

06 总结

1. 增长实验的五个流程步骤

(1) 产生实验想法

找到优化点,提出假设,是一切实验的起点。好的想法可以来自用户反馈、行业对标、数据分析等各个渠道。关键是要建立”实验思维”,时刻保持敏感和好奇。

(2) 实验设计

将所有实验想法,根据 ICE模型进行排列优先级,确定先做哪个实验之后,就要把它”翻译”成一个严谨的实验方案。确定对照组和实验组的选择逻辑、指标体系的设计、实验周期和流量规模的选取等,都需要专业的实验设计能力。

(3) 完成实验PRD文档

实验设计拍板后,就要形成一份标准的实验需求文档(PRD)。这份PRD要让研发同学清晰地知道,应该给哪些用户显示什么样的内容,后端埋点要如何上报数据等。同时也要为实验上线后的数据解读提供依据。

(4) 实验上线积累数据

万事俱备,就等实验的”首飞”了。在实验上线后,我们要密切关注实验系统和数据反馈,确保实验流量和数据监测正常。

然后就是静待数据积累到一定量级,满足我们下一步分析的需要。

(5) 分析和应用实验结果

数据揭开了实验的”答案”,但也提出了新的”问题”。我们要客观地分析实验效果,洞察数据背后的原因。

更要思考如何把实验的价值最大化,去指导产品决策、营销策略乃至公司战略。

2. 增长实验是件困难的事,成功并不容易

寻求增长,本就是一条充满荆棘的道路。九曲回肠,百转千回。每一个实验,都凝结了产品和运营同学的智慧与心血。

但我们必须正视,绝大多数实验的结果,其实都不如人意。有数据显示,超过70%的AB实验,其实验组并没有取得优于对照组的效果。优秀的实验设计者,一年能做出两三个有价值的优化,就已经是业内翘楚了。

最后,实验思维告诉我们,世界上本没有失败,只有迭代。每一次实验,不管结果如何,都应该被视为一次学习的机会。

即便是一次失败的尝试,也往往能引发我们进一步探索的兴趣,让我们对产品、对用户有了全新的认知。

正如LinkedIn的创始人雷德•霍夫曼所说:”要么成功,要么学习”。实验不是为了验证我们是对的,而是为了发现真相。

本文由 @小黑哥 原创发布于人人都是产品经理,未经许可,禁止转载

题图来自 Unsplash,基于 CC0 协议

该文观点仅代表作者本人,人人都是产品经理平台仅提供信息存储空间服务。

- 目前还没评论,等你发挥!

起点课堂会员权益

起点课堂会员权益